III.Wczesne eksploracje: lata 50. i 60. XX wieku

Jeśli maszyny mają stać się inteligentne, muszą przynajmniej być w stanie robić rzeczy związane z myśleniem, które mogą zrobić ludzie. Pierwsze kroki w poszukiwaniu sztucznej inteligencji polegały na zidentyfikowaniu niektórych konkretnych zadań, które według nich wymagają inteligencji, i znalezieniu sposobu na pozyskanie maszyn do ich wykonania. Rozwiązywanie zagadek, granie w szachy i warcaby, dowodzenie twierdzeń, odpowiadanie na proste pytania i klasyfikowanie obrazów wizualnych były jednymi z problemów, z którymi zmagali się pierwsi pionierzy w latach 50. i 60. XX wieku. Chociaż większość z nich to problemy w stylu laboratoryjnym, czasami nazywane "zabawkami", niektóre rzeczywiste problemy o znaczeniu komercyjnym, takie jak automatyczny odczyt wysoce stylizowanych znaków magnetycznych na brzegu, atakowano również kontrole i tłumaczenia językowe. (O ile mi wiadomo, Seymour Papert był pierwszym, który użył zdania "problem z zabawkami". "Podczas warsztatów AI z 1967 r., w Atenach w stanie Georgia, wyróżniał między problemami tau lub "zabawkami ", problemami rho lub rzeczywistymi, oraz problemy theta lub "teorii" w sztucznej inteligencji. To rozróżnienie wciąż dobrze nam służy. W tej części opiszę niektóre z pierwszych rzeczywistych prób budowy inteligentnych maszyn. Niektóre z nich zostały omówione lub zgłoszone na konferencje i sympozja - czyniąc te spotkania ważnymi kamieniami milowymi w narodzinach AI. Zrobię również wszystko, aby wyjaśnić podstawy działania niektórych z tych wczesnych programów AI. Dość dramatyczne sukcesy w tym okresie pomogły stworzyć solidną podstawę dla kolejnych badania sztucznej inteligencji. Niektórzy badacze byli zaintrygowani (można powiedzieć, że zostali schwytani) metodami, których używali, poświęcając się bardziej na poprawie mocy i ogólności wybranych technik niż na zastosowaniu ich do zadań, które według nich wymagają . Co więcej, ponieważ niektórzy badacze byli tak samo zainteresowani wyjaśnieniem, w jaki sposób mózg rozwiązuje problemy, jak przy pozyskiwaniu do tego maszyn, opracowywane metody były często proponowane jako wkład w teorie na temat ludzkich procesów umysłowych. W ten sposób badania w psychologii poznawczej i badania nad sztuczną inteligencją stały się ze sobą ściśle powiązane.

Spotkania

We wrześniu 1948 r. W California Institute of Technology (Caltech) w Pasadenie w Kalifornii odbyła się interdyscyplinarna konferencja na temat tego, jak układ nerwowy kontroluje zachowanie i jak mózg można porównać do komputera. Nazywało się to Sympozjum Hixona na temat mechanizmów mózgowych w zachowaniu. Uczestniczyło w nich kilku luminarzy i wygłaszało referaty, w tym Warren McCulloch, John von Neumann i Karl Lashley (1890 -1958), wybitny psycholog. Lashley wygłosił coś, co według niektórych było najważniejszą przemową na sympozjum. Zarzucił behawioryzmowi jego statyczny obraz funkcji mózgu i twierdził, że aby wyjaśnić ludzkie możliwości planowania i języka, psychologowie musieliby zacząć rozważać dynamiczne, hierarchiczne struktury. Wystąpienie Lashleya położyło podwaliny pod to, co stałoby się kognitywistyką. Pojawienie się sztucznej inteligencji jako pełnego pola badań zbiegło się (i zostało zapoczątkowane) przez trzy ważne spotkania - jedno w 1955 r., jedno w 1956 r. I jedno w 1958 r. W 1955 r. Odbyła się "Sesja na temat uczenia się maszyn" zorganizowane w połączeniu z Western Joint Computer Conference 1955 w Los Angeles. W 1956 r. W Dartmouth College zwołano "Summer Research Project on Artiial Intelligence". W 1958 r. Sympozjum na temat "Mechanizacji procesów myślowych" sponsorowało Narodowe Laboratorium Fizyczne w Wielkiej Brytanii.

Sesja na temat uczenia się maszyn

Cztery ważne artykuły zostały zaprezentowane w Los Angeles w 1955 roku. We wstępie swojego przemówienia do tej sesji Willis Ware napisał:

"Dokumenty te nie sugerują, że przyszłe maszyny uczące się powinny być zbudowane zgodnie z ogólnym cyfrowym urządzeniem komputerowym; jest raczej tak, że cyfrowy system komputerowy oferuje wygodne i wysoce elastyczne narzędzie do badania zachowania modeli. Ta grupa dokumentów sugeruje kierunki ulepszeń dla przyszłych konstruktorów maszyn, których celem jest wykorzystanie cyfrowych maszyn obliczeniowych do tej konkretnej techniki modelowej. Szybkość operacji musi być wielokrotnie zwiększana; jednoczesne działanie w wielu trybach równoległych jest silnie wskazane; wielkość losowego dostępu pamięć masowa musi przeskakiwać o kilka rzędów wielkości; potrzebne są nowe typy urządzeń wejściowych. Dzięki takim postępom i technikom omówionym w tych dokumentach istnieje znaczna obietnica, że systemy mogą zostać zbudowane w stosunkowo bliskiej przyszłości, co będzie imitować znaczną część aktywność mózgu i układu nerwowego "

Na szczęście poczyniliśmy znaczne postępy w zakresie produktów znajdujących się na liście "wskazówek dotyczących ulepszeń" Ware'a. Szybkość działania wzrosła wielokrotnie, w wielu systemach AI wykorzystywana jest praca równoległa, pamięć o dostępie swobodnym skoczyła o kilka rzędów wielkości i dostępnych jest wiele nowych typów urządzeń wejściowych. Być może konieczne będą dalsze usprawnienia. Pierwszy artykuł sesji, autorstwa Wesleya Clarka i Belmonta Farleya z Lincoln Laboratory MIT, opisał niektóre eksperymenty z rozpoznawaniem wzorców na sieciach elementów podobnych do neuronów. Zmotywowani propozycją Hebba, aby zespoły neuronów mogły się uczyć i dostosowywać poprzez dostosowanie siły ich wzajemnych połączeń, eksperymentatorzy próbowali różnych schematów dostosowywania siły połączeń w swoich sieciach, które zwykle były symulowane na komputerach. Niektórzy chcieli tylko zobaczyć, co mogą zrobić te sieci, podczas gdy inni, tacy jak Clark i Farley, byli zainteresowani konkretnymi aplikacjami, takimi jak rozpoznawanie wzorców. Ku przerażeniu neurofizjologów, którzy skarżyli się na nadmierne obciążenie, sieci te nazwano sieciami neuronowymi. Clark i Farley doszli do wniosku, że "surowe, ale użyteczne właściwości uogólniające posiadają nawet losowo połączone sieci opisanego typu" .Kolejna para artykułów, jedna autorstwa Geralda P. Dinneena (1924-), a druga Olivera Selfridge'a (1926-), obaj z Lincoln Laboratory firmy MIT przedstawiły inne podejście do rozpoznawania wzorów. W artykule Dinneen opisa; techniki obliczeniowe przetwarzania obrazów. Obrazy zostały przedstawione komputerowi jako prostokątny zestaw wartości intensywności odpowiadających różnym odcieniom szarości na obrazie. Dinneen był pionierem zastosowanie metod filtrowania w celu usunięcia przypadkowych kawałków hałasu, pogrubienia linii i krawędzi. Rozpoczął pracę od:

"W ciągu ostatnich miesięcy podczas serii spotkań po lunchu i lunchu grupa nas w laboratorium zastanawiała się nad problemami w tym obszarze. Nasze odczucie, niemal jednogłośnie, było takie, że istnieje potrzeba praktycznego działania, wybrania prawdziwego problemu na żywo i zajęcia się nim ".

Tekst Selfridge'a był kawałkiem towarzyszącym artykułowi Dinneen. Operując na "oczyszczonych" obrazach (jak na przykład program Dinneen), Selfridge opisał techniki podświetlania "cech" na tych obrazach, a następnie klasyfikowania ich na podstawie cech. Na przykład narożniki obrazu, o których wiadomo, że są kwadratem lub trójkątem, są podświetlone, a następnie zliczana jest liczba narożników w celu ustalenia, czy obraz jest kwadratem czy trójkątem. Selfridge powiedział, że "ostatecznie mamy nadzieję rozpoznać inne rodzaje cech, takie jak krzywizna, zestawienie pojedynczych punktów (tj. Ich względne położenie i odległości) i tak dalej".

Metody zapoczątkowane przez Selfridge'a i Dinneena mają fundamentalne znaczenie dla większości późniejszych prac nad umożliwieniem maszynom "widzenia". Ich praca jest tym bardziej niezwykła, gdy weźmie się pod uwagę, że wykonano ją na komputerze, Lincoln Laboratory "Memory Test Computer", który dziś można by uznać za niezwykle prymitywny. [Komputer testowy pamięci (MTC) jako pierwszy użył modułów pamięci o swobodnym dostępie z rdzeniem ferrytowym opracowanych przez Jaya Forrestera. Został zaprojektowany i zbudowany przez Kena Olsena w 1953 roku w Digital Equipment Corporation (DEC). MTC był pierwszym komputerem do symulacji działania sieci neuronowych (tych Clarka i Farleya). Kolejny artykuł dotyczył programowania komputera do gry w szachy. Został napisany przez Allena Newella, wówczas badacza z Rand Corporation w Santa Monica. Dzięki biograficznemu szkicowi Newella napisanemu przez jego kolegę, Herb'a Simona z Carnegie Mellon University, wiemy coś o motywacji Newella i tym, jak zainteresował się tym problemem:

"We wrześniu 1954 roku Allen wziął udział w seminarium w RAND, w którym Oliver Selfridge z Lincoln Laboratory opisał działający program komputerowy, który nauczył się rozpoznawać litery i inne wzory. Słuchając Selfridge'a charakteryzującego jego raczej prymitywny, ale działający system, Allen doświadczył tego, o czym zawsze mówił jako jego "doświadczenie konwersji". "Od razu stało się dla niego jasne", że można zbudować inteligentne systemy adaptacyjne, które były znacznie bardziej złożone niż cokolwiek jeszcze. o przetwarzaniu informacji w organizacjach, o cybernetyki i propozycjach programów szachowych dodano teraz konkretną demonstrację wykonalności komputerowej symulacji złożonych procesów. W tym czasie zaangażował się w zrozumienie ludzkiej nauki i myślenia poprzez symulację ".

Simon podsumowuje artykuł Newella na temat szachów:

"[Przedstawił] wymyślny projekt programu komputerowego do gry w szachy w humanoidalny sposób, obejmujący pojęcia celów, poziomy aspiracji do zakończenia poszukiwań, satysfakcję z" wystarczająco dobrych "ruchów, wielowymiarowe funkcje oceny, generowanie subceli do realizacji celów, i coś w rodzaju najlepszego pierwszego wyszukiwania. Informacje o tablicy miały być wyrażone symbolicznie w języku przypominającym rachunek predykatów. Projekt nigdy nie został wdrożony, ale później zapożyczono z niego pomysły do wykorzystania w NSS [Newell, Shaw i Simon] program szachowy w 1958 r. "

Newell zasugerował, że jego cele wykraczają poza szachy. W swoim artykule napisał: "Zatem celem tego wysiłku jest zaprogramowanie obecnego komputera do nauki dobrej gry w szachy. Jest to sposób na lepsze zrozumienie rodzajów komputerów, mechanizmów i programów niezbędnych do obsługi ultraskomplikowanych problemów ". Proponowane techniki Newella można uznać za jego pierwszą próbę uzyskania dowodów na to, co on i Simon nazwali później hipotezą fizycznego systemu symboli. Walter Pitts, komentator tej sesji, zakończył ją mówiąc: "Jednak, podczas gdy panowie Farley, Clark, Selfridge i Dinneen naśladują układ nerwowy, pan Newell woli naśladować hierarchię pierwotnych przyczyn, zwanych tradycyjnie umysłem. Ostatecznie dojdzie do tego samego, bez wątpienia… " Aby dojść do tego samego, "te dwa podejścia, modelowanie neuronowe i przetwarzanie symboli, należy uznać po prostu za różne poziomy opisu tego, co dzieje się w mózgu. Różne poziomy są odpowiednie do opisywania różnych rodzajów zjawisk mentalnych

Letni projekt Dartmouth

W 1954 roku John McCarthy (1927-) dołączył do Dartmouth College w Hanover, New Hampshire, jako adiunkt matematyki. McCarthy stale interesował się czymś, co nazwano by sztuczną inteligencją. Zostało "uruchomione", mówi, "biorąc udział w Sympozjum Hixon na temat mechanizmów mózgowych w zachowaniu we wrześniu 1948 r., Które odbyło się w Caltech, gdzie zaczynałem pracę magisterską z matematyki". Podczas pobytu w Dartmouth został zaproszony przez Nathaniela Rochestera (1919-2001) do spędzenia lata 1955 r. w dziale badań informacyjnych Rochester w IBM w Poughkeepsie w Nowym Jorku. Rochester był projektantem komputera IBM 701 i brał również udział w badaniach sieci neuronowych. W IBM tego lata McCarthy i Rochester przekonali Claude'a Shannona i Marvina Minsky'ego (1927-), wówczas młodszego adiunkta Harvarda z matematyki i neurologii, aby przyłączyli się do nich, proponując warsztaty, które odbędą się w Dartmouth następnego lata. Shannon, o którym wcześniej wspomniałem, był matematykiem w Bell Telephone Laboratories i już słynął z pracy nad teorią przełączania i teorią informacji statystycznych. McCarthy przejął inicjatywę, pisząc propozycję i organizując coś, co nazwano "Letnim projektem badawczym na temat sztucznej inteligencji". Propozycja została przedłożona Fundacji Rockefellera w sierpniu 1955 r.

Fragmenty wniosku brzmią następująco:

"Proponujemy przeprowadzenie 2-miesięcznego, 10-osobowego badania sztucznej inteligencji latem 1956 r. W Dartmouth College w Hanover, New Hampshire. Badanie ma być przeprowadzone na podstawie przypuszczenia, że każdy aspekt uczenia się lub jakakolwiek inna cecha inteligencji może być w zasadzie tak precyzyjnie opisana, że można stworzyć maszynę do jej symulacji. Zostanie podjęta próba znalezienia sposobu, w jaki maszyny będą używać języka, tworzyć abstrakcje i koncepcje, rozwiązywać rodzaje problemów zarezerwowanych obecnie dla ludzi i poprawiać się. Uważamy, że można dokonać znacznego postępu w zakresie jednego lub więcej z tych problemów, jeśli starannie wybrana grupa naukowców będzie pracować nad tym razem przez lato ".

…

W obecnym celu przyjmuje się, że problemem sztucznej inteligencji jest sprawienie, aby maszyna zachowywała się w sposób, który nazwano by inteligentnym, gdyby tak zachowywał się człowiek ".

Fundacja Rockefellera zapewniła fundusze na to wydarzenie, które odbyło się w ciągu sześciu tygodni lata 1956 r. Okazało się jednak, że jest to bardziej ciągły sześciotygodniowy warsztat niż letnie "studium". Wśród osób biorących udział w warsztatach tego lata, oprócz McCarthy'ego, Minsky'ego, Rochestera i Shannona, byli Arthur Samuel (1901-1990), inżynier w korporacji IBM, który napisał już program gry w warcaby, Oliver Selfridge, Ray Solomonoff z MIT, który był zainteresowany automatyzacją indukcji, Allen Newell i Herbert Simon. Newell i Simon (wraz z innym naukowcem Rand, Cliffem Shawem) opracowali program do dowodzenia twierdzeń w logice symbolicznej. Kolejnym naukowcem IBM był Alex Bernstein, który pracował nad programem szachowym. McCarthy podał kilka powodów, dla których użył terminu "sztuczna inteligencja". Pierwszym było odróżnienie tematyki zaproponowanej na warsztaty w Dartmouth od wcześniejszego tomu zamówionych artykułów, zatytułowanych Automata Studies, współredagowanych przez McCarthy'ego i Shannona, które (ku rozczarowaniu McCarthy'ego) w dużej mierze dotyczyły ezoterycznego i raczej wąskiego przedmiotu matematycznego zwany teorią automatów. Drugi, według McCarthy'ego, polegał na "uniknięciu skojarzenia z" cybernetyką ". Skoncentrowanie się na sprzężeniu analogowym wydawało się mylące i chciałem uniknąć akceptacji Norberta Wienera jako guru lub kłótni z nim. "

Ta nazwa była (i nadal jest) kontrowersyjna. Według doskonałej historii Pameli McCorduck o początkach sztucznej inteligencji, Art Samuel zauważył: "Słowo" sztuczność "sprawia, że myślisz ,że jest w tym coś fałszywego, albo brzmi, jakby to wszystko było sztuczne i nie ma w tym nic prawdziwego. McCorduck mówi dalej, że " Newellowi lub Simonowi spodobało się to zdanie i nazwali je własnym pracując przez lata przy złożonym przetwarzaniu informacji. "Ale większość osób, które zapisały się do pracy w tym nowym polu (w tym ja), używała nazwy" sztuczna inteligencja "i tak nazywa się to dzisiaj. (Później, Newell pogodził się z tą nazwą. Komentując treść pola, stwierdził: "Więc pielęgnuj nazwę sztuczna inteligencja. To dobra nazwa. Jak wszystkie nazwiska naukowców, będzie rosło, aby stać się dokładnie tym, czym jest pole jakie ma na myśli. ") Podejścia i motywacje ludzi na warsztatach różniły się. Rochester przybył na konferencję z doświadczeniem w sieci elementów podobnych do neuronów. Newell i Simon stosowali (a właściwie pomogli stworzyć) podejście do przetwarzania symboli.

Jednym z tematów, o których Shannon chciał pomyśleć (zgodnie z propozycją), było zastosowanie koncepcji teorii informacji w komputerach i modelach mózgu. "(Po warsztatach Shannon odwrócił jednak uwagę od sztucznej inteligencji.) McCarthy napisał że chciał zbudować "sztuczny język, który można zaprogramować w komputerze do rozwiązywania problemów wymagających przypuszczeń i samodzielnego odniesienia. Powinien on odpowiadać językowi angielskiemu w tym sensie, że krótkie angielskie wypowiedzi na dany temat powinny mieć krótkich korespondentów w języku, podobnie jak krótkie argumenty lub przypuszczenia. Mam nadzieję, że spróbuję sformułować język posiadający te właściwości. . . "

Chociaż McCarthy powiedział później, że jego pomysły na ten temat są nadal zbyt "źle sformułowane" do prezentacji na konferencji, nie minęło wiele czasu, zanim przedstawił konkretne propozycje użycia języka logicznego i jego mechanizmów wnioskowania do reprezentowania i rozumowania wiedzy. Chociaż rozprawa doktora Minsky'ego i niektóre z jego późniejszych prac koncentrowały się na sieciach neuronowych, w czasie warsztatów w Dartmouth zaczął zmieniać kierunek. Teraz, jak napisał, chciał rozważyć maszynę, która miałaby tendencję do tworzenia w sobie abstrakcyjnego modelu środowiska, w którym jest umieszczona. Gdyby napotkano problem, mógłby najpierw zbadać rozwiązania w ramach wewnętrznego abstrakcyjnego modelu środowiska, a następnie podjąć próbę eksperymentów zewnętrznych. "Podczas warsztatów Minsky kontynuował prace nad szkicem, który później został opublikowany jako praca podstawowa, "Kroki Ku inteligencji sztucznej. "Jednym z najważniejszych technicznych wkładów ze spotkania w 1956 r. Była praca Newella i Simona nad ich programem" Logic Theorist (LT) "służącym do udowodnienia twierdzeń w logice symbolicznej. LT był konkretnym dowodem na to, że przetwarzanie "struktury symboli "i wykorzystanie tego, co Newell i Simon nazywali "heurystyką" były fundamentem inteligentnego rozwiązywania problemów. Opiszę niektóre z tych pomysłów bardziej szczegółowo w następnej części. Newell i Simon pracowali nad pomysłami na LT dla kilka miesięcy i przekonał się pod koniec 1955 r., że można je wcielić w działający program. Według Edwarda Feigenbauma (1936 -), który odbywał kurs u Herb Simona w Carnegie na początku 1956 r., "To tuż po świętach Bożego Narodzenia - styczeń 1956 r. -kiedy Herb Simon wszedł do klasy i powiedział: "W czasie świąt Allen Newell i ja wynaleźliśmy maszynę myślącą." "To, co wkrótce miało zostać zaprogramowane jako LT, było maszyną myślącą" Simon mówił o niej. Nazywał to tak, bez wątpienia, ponieważ myślał, że tak się stało ,że niektóre z tych samych metod rozwiązywania problemów, z których korzystają ludzie. Simon napisał później: "W czwartek, 15 grudnia. Udało mi się ręcznie zasymulować pierwszy dowód ... Zawsze 15 grudnia 1955 roku obchodziłem urodziny heurystycznego rozwiązywania problemów przez komputer". Zgodnie z autobiografią Simona "Modele mojego życia" LT rozpoczęło się od symulacji ręcznej, wykorzystując swoje dzieci jako elementy komputerowe, jednocześnie pisząc i trzymając karty notatek jako rejestry zawierające zmienne stanu programu. Kolejnym tematem omawianym w Dartmouth był problem udowodnienia twierdzeń w geometrii. (Być może niektórzy czytelnicy przypomną sobie swoje zmagania z dowodami geometrii w liceum). Minsky już myślał o programie do udowodnienia twierdzeń geometrii. McCorduck cytuje go, mówiąc:

"Prawdopodobnie ważnym wydarzeniem w moim rozwoju - i wyjaśnieniem mojej być może zaskakująco przypadkowej akceptacji pracy Newella-Shawa - Simon - było to, że naszkicowałem heurystyczną procedurę poszukiwania maszyny geometrycznej, a następnie byłem w stanie podać ją - naśladuj to na papierze w ciągu około godziny. Pod moją ręką powstał nowy dowód twierdzenia o trójkącie równoramiennym, dowód, który był nowy i elegancki dla uczestników - później odkryliśmy, że dowód był dobrze znany. . ."

W lipcu 2006 r. W Dartmouth odbyła się kolejna konferencja z okazji pięćdziesiątej rocznicy pierwszej konferencji. Kilku założycieli i innych wybitnych badaczy sztucznej inteligencji wzięło udział w ankiecie i dokonało przeglądu tego, co osiągnięto od 1956 r. McCarthy przypomniał, że głównym powodem warsztatów Dartmouth w 1956 r. nie było spełnienie moich oczekiwań, ponieważ AI jest trudniejsze niż się spodziewaliśmy. , warsztaty z 1956 r. są uważane za oficjalny początek poważnej pracy w sztucznej inteligencji, a Minsky, McCarthy, Newell i Simon zostali uznani za "ojców" AI. W bibliotece Baker Library w Dartmouth poświęcono tablicę upamiętniającą początek sztucznej inteligencji jako dyscypliny naukowej.

Mechanizacja procesów myślowych

W listopadzie 1958 r. Sympozjum na temat "Mechanizacji Procesu Myśli "odbyło się w National Physical Laboratory w Teddington, Middlesex, Anglia. Zgodnie z przedmową z konferencji, sympozjum odbyło się" w celu zgromadzenia naukowców badających myślenie sztuczne, rozpoznawanie znaków i wzorów, naukę, mechaniczne tłumaczenie języka, biologia, programowanie automatyczne, planowanie przemysłowe i mechanizacja biurowa. "

Wśród osób, które zaprezentowały referaty na tym sympozjum było wielu, o których już wspomniałem w tej historii. Należą do nich Minsky (wówczas członek personelu w Lincoln Laboratory i na drodze do zostania profesorem matematyki na MIT), McCarthy (wówczas asystent profesora nauk o komunikacji na MIT), Ashby, Selfridge i McCulloch. (John Backus, jeden z twórców komputerowego języka programowania FORTRAN, i Grace Murray Hopper, pionier "programowania automatycznego" również wygłosili referaty.) Obrady tej konferencji zawierają artykuły, które stały się bardzo wpływowe w historii sztucznej inteligencji. Wśród nich wymienię te autorstwa Minsky'ego, McCarthy'ego i Selfridge'a. Artykuł Minsky'ego "Niektóre metody sztucznej inteligencji i programowania heurystycznego" był najnowszą wersją utworu, nad którym pracował tuż przed warsztatami w Dartmouth. W artykule opisano różne metody, które były (i mogłyby być) wykorzystane w programowaniu heurystycznym. Obejmował także metody rozpoznawania wzorców, uczenia się i planowania. Ostateczna wersja, która wkrótce miała zostać opublikowana jako "Kroki w kierunku sztucznej inteligencji", miała stać się obowiązkową lekturą dla nowych rekrutów do pól. Wspomniałem już o nadziei McCarthy'ego na opracowanie języka sztucznej inteligencji dla AI. Podsumował swój artykuł konferencyjny "Programy ze zdrowym rozsądkiem" w następujący sposób:

"W tym artykule omówione zostaną programy do manipulacji w odpowiednim języku formalnym (najprawdopodobniej część rachunku predykatów) typowymi stwierdzeniami instrumentalnymi. Program podstawowy wyciągnie natychmiastowe wnioski z listy przesłanek. Wnioski te będą zdaniami deklaratywnymi lub imperatywnymi. Kiedy wydane zostanie zdanie rozkazujące, program podejmuje odpowiednie działanie. "

W swoim artykule McCarthy zasugerował, że fakty potrzebne programowi AI, który nazwał "przyjmującym porady", może być reprezentowany jako wyrażenie w matematycznym (i przyjaznym dla komputera) języku zwanym "logiką pierwszego rzędu". Na przykład fakty "Jestem przy biurku" i "Moje biurko jest w domu" byłyby reprezentowane jako wyrażenia na (ja, biurko) i na (biurko, dom). Te, wraz z podobnie reprezentowanymi informacjami o tym, jak osiągnąć zmianę lokalizacji (na przykład pieszo i samochodem), mogą być następnie wykorzystane przez proponowanego (ale jeszcze nie zaprogramowanego) doradcę, aby dowiedzieć się, jak osiągnąć jakiś cel, taki jak będąc na lotnisku. Proces wnioskowania doradcy wytworzyłyby logiczne wyrażenia, które wymagałyby przejścia do samochodu i jazdy na lotnisko. Reprezentowanie faktów w języku logicznym ma kilka zalet. Jak to później ujął McCarthy:

"Wyrażanie informacji w zdaniach deklaratywnych jest o wiele bardziej modułowe niż wyrażanie ich w segmentach programu komputerowego lub w tabelach. Zdania mogą być prawdziwe w znacznie szerszych kontekstach, niż konkretne programy mogą być przydatne. Dostawca faktu nie musi wiele rozumieć na temat jak działa odbiorca lub jak lub czy będzie go używać. Ten sam fakt można wykorzystać do wielu celów, ponieważ logiczne konsekwencje zbiorów faktów mogą być dostępne "

McCarthy rozwinął te pomysły w memorandum towarzyszącym. Jak wspomnę później, niektóre z propozycji McCarthy'ego zostały ostatecznie wdrożone przez absolwenta Stanforda, C. Cordella Greena. Wspomniałem już o pracy Olivera Selfridge'a z rozpoznawaniem wzorów w 1955 roku. Na sympozjum Teddington w 1958 r. Selfridge przedstawił artykuł na temat nowego modelu rozpoznawania wzorców (i prawdopodobnie także innych zadań poznawczych). Nazwał go "Pandemonium", co oznacza miejsce wszystkich demonów. Jego model jest szczególnie interesujący, ponieważ jego komponenty, które Selfridge nazywa "demonami", mogą być tworzone zarówno jako spełniające funkcje komórek nerwowych niższego poziomu, jak i funkcje poznawcze wyższego poziomu (odmiany przetwarzającej symbole). Tak więc Pandemonium może przybierać formę sieci neuronowej, hierarchicznie zorganizowanego zestawu procesorów symboli {wszystkie pracujące równolegle lub jakiejś kombinacji tych form. Jeśli to drugie, model jest prowokującą propozycją połączenia tych dwóch odmiennych podejść do sztucznej inteligencji. We wstępie do swojej pracy Selfridge podkreślił znaczenie obliczeń wykonywanych równolegle:

"Podstawowym motywem naszego modelu jest koncepcja przetwarzania równoległego. Sugeruje się to z dwóch powodów: po pierwsze, często łatwiej jest przetwarzać dane w sposób równoległy i rzeczywiście jest to zwykle bardziej naturalny sposób postępowania to w; a po drugie, łatwiej jest zmodyfikować zespół quasi-niezależnych modułów niż maszyna, której wszystkie części wchodzą w interakcję natychmiastowo i w złożony sposób ".

Selfridge przedstawił kilka sugestii dotyczących tego, jak Pandemonium może się uczyć. Warto opisać niektóre z nich, ponieważ zapowiadają późniejszą pracę w uczeniu maszynowym. Ale najpierw muszę powiedzieć nieco więcej o strukturze Pandemonium. Struktura Pandemonium przypomina schemat organizacyjny firmy. Na najniższym poziomie są pracownicy, których Selfridge nazwał "demonami danych". Są to procesy obliczeniowe, które "patrzą na" dane wejściowe, powiedzmy obraz drukowanej litery lub cyfry. Każdy demon szuka czegoś konkretnego na obrazie, być może poziomego paska; inny może szukać pionowego paska; inny dla łuku koła i tak dalej. Każdy demon "krzyczy" swoimi ustaleniami do zestawu demonów znajdujących się wyżej w organizacji. (Pomyśl o tych demonach na wyższych szczeblach jako menedżerach średniego szczebla). Głośność krzyku demona zależy od tego, jak pewne jest to, że widzi to, czego szuka. Oczywiście Selfridge mówi metaforycznie, kiedy używa określeń takich jak "szuka" i "krzyczy". Wystarczy powiedzieć, że programowanie komputerów nie jest zbyt trudne szukaj "pewnych cech na obrazie. (Selfridge już pokazał, jak można to zrobić w swoim artykule z 1955 r., o którym wspominałem wcześniej). A" krzyk "jest tak naprawdę siłą wyjściową procesu obliczeniowego. Każdy z następnych poziom demonów specjalizuje się w słuchaniu określonej kombinacji krzyku z demonów danych. Na przykład jeden z demonów na tym poziomie może zostać dostrojony, aby nasłuchiwać okrzyków danych demon 3, demon danych 11 i demon danych 22. Jeśli okaże się, że te konkretne demony krzyczą głośno, odpowiada własnym krzykiem demonom o jeden poziom wyżej w hierarchii i tak dalej. Tuż poniżej najwyższego poziomu organizacji znajdują się tak zwane przez Selfridge "demony poznawcze". Podobnie jak na innych poziomach, słuchają one określonych kombinacji okrzyków demonów na niższym poziomie i odpowiadają własnymi okrzykami na ostatecznego "demona decyzyjnego" na górze - ogólnego bossa. W zależności od tego, co słyszy od swojego "personelu", demon decyzji ostatecznie ogłasza, co uważa za tożsamość obrazu {być może litera "A" lub litera "R" lub cokolwiek innego. Rzeczywisty projekt demona zależy od tego, jakie zadanie ma wykonać Pandemonium. Ale nawet bez sprecyzowania, co ma zrobić każdy demon, Selfridge przedstawił bardzo interesujące propozycje dotyczące tego, jak Pandemonium może nauczyć się osiągać lepsze wyniki we wszystkim, co powinno robić. Jedna z jego propozycji dotyczyła wyposażenia każdego demona w coś, co stanowiło "megafon", przez który wydał swój okrzyk. Poziom głośności megafonu można regulować. (Pandemonium Selfridge'a jest nieco bardziej skomplikowane niż wersja, którą opisuję. W jego wersji każdy demon używa różnych kanałów do komunikowania się z każdym z różnych demonów powyżej. Głośność krzyku dochodzącego do każdego kanału jest indywidualnie dostosowywana przez naukę mechanizm). Demonom nie wolno było jednak ustawiać własnego poziomu głośności. Wszystkie poziomy głośności miały zostać ustawione w procesie uczenia się zewnętrznego, który ma na celu poprawę wydajności całego zestawu. Wyobraź sobie, że poziomy głośności są początkowo ustawiane losowo lub według tego, co według projektantów będzie odpowiednie. Następnie urządzenie jest testowane na pewnej próbce danych wejściowych i odnotowywana jest jego ocena wydajności. Powiedzmy, że dostaje wynik 81%. Następnie dokonuje się drobnych korekt poziomów głośności na wszystkie możliwe sposoby, aż do znalezienia zestawu korekt, który najbardziej poprawi wynik, powiedzmy do 83%. Ten szczególny zestaw drobnych korekt jest następnie wprowadzany, a proces jest powtarzany w kółko (być może w przypadku dodatkowych danych), dopóki nie będzie można dokonać dalszej poprawy. (Ponieważ w organizacji może być wiele megafonów, wprowadzanie korekt na wszystkie możliwe sposoby i testowanie każdego z tych sposobów w celu znalezienia wyniku może wydawać się niepraktyczne. Proces może rzeczywiście zająć trochę czasu, ale komputery są szybkie {nawet tym bardziej dzisiaj. Później pokażę, jak to zrobić ,możemy obliczyć, a nie eksperymentalnie, najlepsze poprawki, które należy wprowadzić w sieciach neuronowych zorganizowanych jak Pandemonium.) Jeśli myślimy o wyniku jako wysokości jakiegoś krajobrazu i dostosowaniach jako ruchach nad krajobrazem, proces ten można porównać do wspinaczki wzgórze, zawsze wykonując kroki w kierunku najbardziej stromego wejścia. Gradient wspinaczka (lub metody wspinaczki, jak się je czasami nazywa) są dobrze znane w matematyce. Selfridge miał do powiedzenia na temat niektórych pułapek ich używania:

"Można to opisać jako jeden z problemów treningu, a mianowicie zachęcenie maszyny lub organizmu do wystarczającej ilości stoków, aby niewielkie zmiany. . . spowoduje zauważalną poprawę jego wysokości lub wyniku. Można opisać sytuacje uczenia się, w których większość trudności w zadaniu polega na znalezieniu jakiegokolwiek sposobu poprawy swojego wyniku, na przykład na uczeniu się jazdy na monocyklu, gdzie utrzymanie się przez sekundę trwa dłużej niż poprawa tego sekunda do minuty; i inne, w których łatwo jest zrobić trochę dobrze, a bardzo dobrze, na przykład nauczyć się grać w szachy. Prawdą jest również to, że często głównym szczytem jest płaskowyż, a nie izolowany szczyt."

Selfridge opisał inną metodę uczenia się w Pandemonium. Metodę tę można porównać do zastępowania menedżerów w organizacji, która nie osiąga dobrych wyników. Jak to ujął Selfridge, przy koncepcji naszego demonicznego zgromadzenia zebraliśmy nieco arbitralnie dużą liczbę subdemonów, które naszym zdaniem byłyby przydatne. . . ale nie mamy żadnej pewności, że wybrane przez nas pod-demony są dobre. Wybór subdemonów generuje nowe subdemony do prób i eliminuje te nieefektywne, czyli takie, które niewiele pomagają poprawić wynik. Proces selekcji demonów rozpoczyna się po pewnym czasie działania mechanizmu uczenia się dostosowującego głośność, bez dalszej poprawy wyników. Następnie "wartość" każdego demona jest oceniana przy użyciu, jak sugeruje Selfridge, metody opartej na wyuczonym poziomie głośności ich krzyków. Demony o wysokim poziomie głośności mają duży wpływ na końcowy wynik i dlatego można uznać, że mają dużą wartość. Po pierwsze, demony o niskim poziomie głośności są całkowicie eliminowane. (Ten krok nie może bardzo zaszkodzić wynikowi.) Następnie niektóre demony przechodzą losowo "mutacje "i są ponownie wprowadzane do użytku. Następnie wybrane są niektóre pary godnych demonów i, jak mówi Selfridge," sprzężone " w demony potomków. Precyzyjna metoda koniugacji Selfridge zaproponowana tutaj nie musi nas dotyczyć, ale duchem tego procesu jest wytwarzanie potomstwa, które, jak można się spodziewać, ma użyteczne właściwości rodziców. Potomstwo zostaje następnie oddane do użytku. Teraz cały proces dostosowywania poziomów głośności ocalałych i "ewoluujących" demonów może rozpocząć się od nowa, aby sprawdzić, czy wynik nowego zestawu można jeszcze poprawić.

Rozpoznawanie wzorców

Większość uczestników letniego projektu Dartmouth była zainteresowana naśladowaniem wyższych poziomów ludzkiej myśli. Ich praca polegała na pewnej introspekcji dotyczącej tego, jak ludzie rozwiązują problemy. Jednak wiele naszych zdolności umysłowych wykracza poza naszą zdolność introspekcji. Nie wiemy, jak rozpoznajemy dźwięki mowy, czytamy kursywę, odróżniamy filiżankę od talerza lub identyfikujemy twarze. Robimy te rzeczy automatycznie, nie myśląc o nich. Nie mając wskazówek z introspekcji, wcześni badacze zainteresowani automatyzacją niektórych naszych zdolności percepcyjnych oparli swoją pracę na intuicyjnych pomysłach dotyczących postępowania, na sieci prostych modeli neuronów i na technikach statystycznych. Później pracownicy uzyskali dodatkowe informacje z badań neurofizjologicznych dotyczących widzenia zwierząt. W tej części opiszę pracę z lat 50. i 60. XX wieku nad tzw. rozpoznawaniem wzorców. To zdanie odnosi się do procesu analizy obrazu wejściowego, segmentu mowy, sygnału elektronicznego lub innej próbki danych i zaklasyfikowanie go do jednej z kilku kategorii. Na przykład do rozpoznawania znaków kategorie odpowiadałyby kilkudziesięciu literom alfanumerycznym. Większość prac nad rozpoznawaniem wzorów w tym okresie dotyczyła materiałów dwuwymiarowych, takich jak drukowane strony lub zdjęcia. Można było już skanować obrazy w celu przekształcenia ich w tablice liczb (zwanych później "pikselami"), które następnie mogły być przetwarzane przez programy komputerowe, takie jak Dinneen i Selfridge. Russell Kirsch i współpracownicy z National Bureau of Standards (obecnie Narodowy Instytut Standardów i Technologii) również był jednym z pierwszych pionierów przetwarzania obrazu. W 1957 r. Kirsch zbudował skaner bębnowy i wykorzystał go do zeskanowania zdjęcia swojego trzymiesięcznego syna Waldena. Mówi się, że jest to pierwsza zeskanowana fotografia, mierząca 176 pikseli z boku. Za pomocą swojego skanera eksperymentował z programami do obróbki zdjęć działającymi na komputerze SEAC (Standards Eastern Automatic Computer).

Rozpoznawanie znaków

Wczesne starania o postrzeganie obrazów wizualnych koncentrowały się na rozpoznawaniu znaków alfanumerycznych na dokumentach. Pole to stało się znane jako "optyczne rozpoznawanie znaków". Sympozjum poświęcone informowaniu o postępach w tym temacie odbyło się w Waszyngtonie w styczniu 1962 r. Podsumowując, w tym czasie istniały urządzenia umożliwiające dość dokładne rozpoznawanie czcionek stałych (pisanych na maszynie lub drukowanych) na papierze. Być może stan rzeczy najlepiej wyraził jeden z uczestników sympozjum, J. Rabinow z Rabinow Engineering, który powiedział: "W naszej firmie myślimy, że możemy przeczytać wszystko, co jest drukowane, a nawet niektóre rzeczy, które są napisane. Jedynym haczykiem jest to, ile dolarów trzeba wydać? ". Znaczącym sukcesem w latach 50. był system rozpoznawania atramentu magnetycznego (MICR) opracowany przez naukowców z SRI International (zwany wówczas Stanford Research Institute) do czytania stylizowanych znaków atramentu magnetycznego na dole czeków. MICR był częścią systemu SRI ERMA (Electronic Recording Method of Accounting) służącego do automatyzacji przetwarzania czeków oraz zarządzania rachunkami i zarządzania księgowaniem. Według strony internetowej SRI "W kwietniu 1956 r. Bank of Ameryka ogłosiła, że General Electric Corporation została wybrana do produkcji modeli produkcyjnych ... W 1959 r. General Electric dostarczył pierwsze 32 systemy obliczeniowe ERMA do Bank of America. ERMA służył jako komputer księgowy i system obsługi czeków do 1970 r" . Większość metod rozpoznawania w tym czasie polegała na dopasowaniu znaku (po jego wyizolowaniu na stronie i przekonwertowaniu go na tablicę zer i jedynek) z prototypowymi wersjami znaku zwanymi "szablonami" (również przechowywanymi jako tablice na komputerze) . Jeśli znak pasuje do szablonu dla "A", powiedzmy, wystarczająco lepiej niż inne szablony, dane wejściowe zostały zadeklarowane jako "A." Dokładność rozpoznania uległa pogorszeniu, jeśli znaki wejściowe nie były prezentowane w standardowej orientacji, nie były tej samej czcionki co szablon lub miały niedoskonałości. Artykuły z 1955 r autorstwa Selfridge i Dinneen zaproponowały kilka pomysłów na wyjście poza dopasowywanie szablonów. Praca Olivera Selfridge'a i Ulricha Neissera z 1960 r. posunęła tę pracę dalej. Ten artykuł jest ważny, ponieważ był udaną, wczesną próbą użycia przetwarzania obrazu, ekstrakcji funkcji i wyuczonych wartości prawdopodobieństwa w rozpoznawaniu znaków odręcznie wydrukowanych. Znaki zostały zeskanowane i przedstawione na "siatkówce" 32 x 32 lub tablicy zer i jedynek. Zostały one następnie przetworzone przez różne operacje odnawiania (podobne do tych, o których wspominałem w związku z artykułem Dinneena z 1955 r.) W celu usunięcia przypadkowych kawałków szumu, luk, linii pogrubienia i wzmocnienia krawędzi. "Oczyszczone" obrazy zostały następnie sprawdzone pod kątem występowania "cech" (podobnych do cech, o których wspomniałem w związku z artykułem Selfridgea z 1955 r.). W sumie użyto 28 funkcji -takich jak maksymalna liczba przypadków linia pozioma przecinała obraz, względne długości różnych krawędzi i czy obraz miał "wklęsłość skierowaną na południe". Przywołując system Pandemonium Selfridge′a, możemy myśleć o procesie wykrywania cech jako wykonywanym przez "demony". Na wyższym poziomie hierarchii niż demony cechowe były "demony rozpoznające" - po jednym na każdą literę. (Wersja tego systemu przetestowana przez Worthie Doyle z Lincoln Laboratory została zaprojektowana do rozpoznawania dziesięciu różnych ręcznie drukowanych znaków, a mianowicie: A, E, I, L, M, N, O, R, S i T.) Każde rozpoznanie demon otrzymał jako dane wejściowe od każdego z demonów wykrywających cechy. Ale po pierwsze, dane wejściowe do każdego demona rozpoznającego zostały pomnożone przez wagę, która uwzględniała znaczenie wkładu odpowiedniej cechy w podejmowaniu decyzji. Na przykład, jeśli cecha 17 była ważniejsza niż cecha 22 przy podejmowaniu decyzji, że znakiem wejściowym jest "A", wówczas dane wejściowe do rozpoznającego "A" z cechy 17 byłyby ważone bardziej niż dane wejściowe z cechy. Po tym, jak każdy demon rozpoznania zsumował sumę swoich ważonych danych wejściowych, ostateczny "demon decyzyjny" zdecydował na korzyść tego, że postać ma największą sumę. Wartości wag zostały określone w procesie uczenia się, podczas którego analizowano 330 obrazów "treningowych". Zliczenia zestawiono w tabelach, ile razy wykryto każdą cechę dla każdej innej litery w zestawie szkoleniowym. Te dane statystyczne wykorzystano do oszacowania prawdopodobieństwa wykrycia danej cechy dla każdej litery. Te oszacowania prawdopodobieństwa wykorzystano następnie do ważenia cech sumowanych przez rozpoznające demony. Po szkoleniu system został przetestowany na próbkach ręcznie drukowanych znaków, których jeszcze nie widział. Według Selfridge′a i Neissera: "Ten program sprawia, że tylko około 10 procent mniej jest poprawnych identyfikacji, niż czytelnicy ludzcy robią {na pewno przyzwoitą wydajność."

Sieci neuronowe

Perceptrony

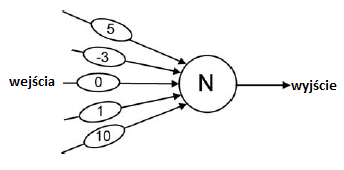

W 1957 r. Frank Rosenblatt (1928-1969, psycholog z Cornell Aeronautical Laboratory w Buffalo w stanie Nowy Jork) rozpoczął pracę nad sieciami neuronowymi w ramach projektu o nazwie PARA (Perceiving and Recognizing Automaton). Motywował go wcześniejsza praca McCullocha. Pitts i Hebb zainteresowali się tymi sieciami, które nazwał perceptronami, jako potencjalnymi modelami ludzkiego uczenia się, poznania i pamięci. Kontynuując na początku lat 60. jako profesor na Cornell University w Ithaca w Nowym Jorku, eksperymentował z wieloma różnych rodzajów perceptronów. Jego praca, bardziej niż Clarka i Farleya oraz innych pionierów sieci neuronowych, była odpowiedzialna za zainicjowanie jednej z głównych alternatyw dla metod przetwarzania symboli w AI, a mianowicie sieci neuronowych. Perceptrony Rosenblatta składały się z McCulloch {Elementy neuronowe w stylu Pittsa, takie jak ten pokazany poniżej

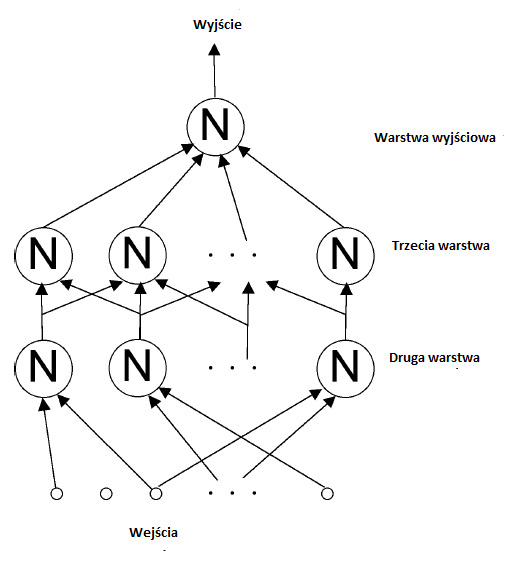

Każdy element miał dane wejściowe (przychodzące od lewej strony w górę), \ wagi "(pokazane przez wybrzuszenia na liniach wejściowych) i jedno wyjście (wychodzące w prawo). Dane wejściowe miały wartości 1 lub 0, i każde wejście zostało pomnożone przez związaną z nim wartość wagi. Element neuronowy obliczył sumę tych ważonych wartości. Na przykład, jeśli wszystkie dane wejściowe do elementu neuronowego na rysunku były równe 1, suma wynosiłaby 13. Gdyby suma była większa niż (lub po prostu równa) "wartość progowa", powiedzmy 7, powiązana z elementem, wówczas dane wyjściowe elementem neuronowym będzie 1, co byłoby w tym przykładzie. W przeciwnym razie wynik wyniósłby 0. Perceptron składa się z sieci tych elementów neuronowych, w których wyjścia jednego elementu są danymi wejściowymi dla innych. (Jest tu analogia do Pandemonium Selfridge'a, w którym demony średniego poziomu otrzymują "krzyki" demony niższego poziomu. Ciężary na liniach wejściowych elementu neuronowego można traktować jako analogiczne do "kontroli siły" zwiększającej lub zmniejszającej siłę w Pandemonium.) Przykładowy perceptron pokazano poniżej.

[Rosenblatt narysował schematy perceptronów w formacie poziomym (styl elektrotechniczny), z wejściami po lewej i wyjściami po prawej. Tutaj używam stylu pionowego ogólnie preferowanego przez informatyków do hierarchii, z najniższym poziomem u dołu i najwyższym u góry. Aby uprościć schemat, wybrzuszenia wagi nie są pokazane.] Chociaż przedstawiony perceptron, z tylko jedną jednostką wyjściową, jest zdolny tylko do dwóch różnych wyjść (1 lub 0), wiele wyjść (zestawy 1 i 0) można uzyskać przez ułożenie dla kilku jednostek wyjściowych.

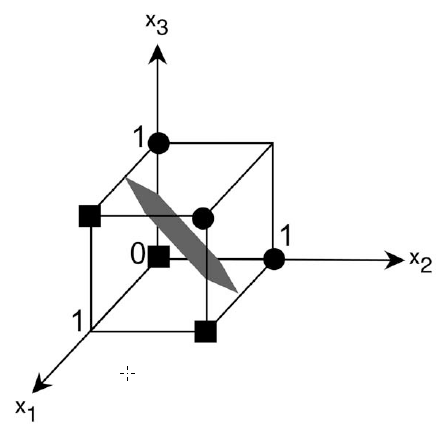

Warstwa wejściowa, pokazana na dole rysunku, była zazwyczaj prostokątnym układem 1 i 0 odpowiadających komórkom zwanym "pikselami" czarno-białego obrazu. Jedną z aplikacji, którymi interesowała się Rosenblatt, było, podobnie jak Selfridge, rozpoznawanie znaków. Użyję prostej algebry i geometrii, aby pokazać, jak elementy neuronowe w sieciach perceptronowych można "szkolić" w celu uzyskania pożądanych wyników. Rozważmy na przykład pojedynczy element neuronowy, którego danymi wejściowymi są wartości x1, x2 i x3 i których powiązanymi wartościami wagowymi są w1, w2 i w3. Gdy suma obliczona przez ten element jest dokładnie równa jego wartości progowej, powiedzmy t, mamy równanie w1x1 + w2x2 + w3x3 = t:

W algebrze takie równanie nazywa się równaniem "liniowym. "Określa granicę liniową, czyli płaszczyznę, w przestrzeni trójwymiarowej. Płaszczyzna oddziela te wartości wejściowe, które spowodowałyby, że element neuronowy miałby wynik 1 z tych, które spowodowałyby, że miałby wynik 0. Pokazuję typową płaską granicę na rysunku

Wejście do elementu neuronowego może być przedstawione jako punkt (to znaczy wektor) w tej trójwymiarowej przestrzeni. Jego współrzędne to wartości x 1 , x 2 i x 3 , z których każda może wynosić 1 lub 0. Gure pokazuje sześć takich punktów, trzy z nich (powiedzmy małe kółka) powodujące, że element ma moc wyjściową 1, a trzy (powiedzmy małe kwadraty) powodujące, że ma moc wyjściową 0. Zmiana wartości progu powoduje, że płaszczyzna poruszać się na boki w kierunku równoległym do siebie. Zmiana wartości ciężarów powoduje obrót płaszczyzny. Tak więc, zmieniając wartości ciężaru, punkty, które kiedyś znajdowały się po jednej stronie płaszczyzny, mogły skończyć się po drugiej stronie. "Szkolenie" odbywa się poprzez wykonanie takich zmian. Będę miał więcej do powiedzenia na temat procedur szkoleniowych. W wymiarach większych niż trzy (co zwykle ma miejsce), liniowa granica nazywana jest "hiperpłaszczyzną". Chociaż nie jest możliwe zwizualizowanie tego, co dzieje się w przestrzeniach o dużych wymiarach, matematycy wciąż mówią o punktach wejściowych w tych przestrzeniach oraz obrotach i ruchach hiperpłaszczyzn w odpowiedzi na zmiany wartości wag i progów. Rosenblatt zdefiniował kilka rodzajów perceptronów. Nazwał ten pokazany na schemacie "czteropowłokowym perceptronem sprzężonym szeregowo". (Rosenblatt liczył dane wejściowe jako pierwszą warstwę.) Nazywano to "sprzężeniem szeregowym", ponieważ moc wyjściowa każdego elementu neuronowego przekazywana była do elementów neuronowych w kolejnej warstwie. W najnowszej terminologii zamiast wyrażenia "sprzężony szeregowo" użyto wyrażenia "informacje zwrotne". Natomiast perceptron "sprzężony krzyżowo" może mieć wyjścia elementów neuronowych w jednej warstwie jako dane wejściowe do elementów neuronalnych w tej samej warstwie. Perceptron sprzężony "krzyżowo" może mieć dane wyjściowe elementów neuronowych w jednej warstwie elementy neuronowe w warstwach o niższych numerach. Rosenblatt pomyślał o swoich perceptronach jako o modelach okablowania części mózgu. Z tego powodu nazwał elementy neuronowe we wszystkich warstwach, ale w warstwie wyjściowej, "jednostkami asocjacji" (A-units), ponieważ zamierzał je modelować asocjacje wykonywane przez sieci neuronów w mózgu. Szczególnie interesujące były badania Rosenblatta to, co nazwał "perceptronem alfa". Składało się z trójwarstwowej sieci sprzężenia zwrotnego z warstwą wejściową, warstwą asocjacyjną i jedną lub więcej jednostkami wyjściowymi. W większości jego eksperymentów dane wejściowe miały wartości 0 lub 1, odpowiadające czarnym lub białym pikselom na obrazie wizualnym przedstawionym na tak zwanej "siatkówce". Każda jednostka A otrzymała dane wejściowe (które nie zostały pomnożone przez wartości masy) z jakiegoś losowo wybranego podzbioru pikseli i wysłała swój wynik , poprzez zestawy regulowanych wag, do końcowych jednostek wyjściowych, których wartości binarne można interpretować jako kod dla kategorii obrazu wejściowego. Próbowano zastosować różne "procedury szkoleniowe" w celu dostosowania wag jednostek wyjściowych perceptronu alfa , W najbardziej dla tych (dla celów rozpoznawania wzorców) wagi prowadzące do jednostek wyjściowych wynosiły korygowane tylko wtedy, gdy jednostki te popełniły błąd w klasyfikacji danych wejściowych. Korekty były takie, aby wymusić na wyjściu prawidłową klasyfikację dla tego konkretnego wejścia. Ta technika, która wkrótce stała się standardem, została nazwana "procedurą korekcji błędów". Rosenblatt z powodzeniem wykorzystał ją w szeregu eksperymentów do szkolenia perceptronów do klasyfikowania sygnałów wizualnych, takich jak znaki alfanumeryczne lub sygnałów akustycznych, takich jak dźwięki mowy. Profesor H. David Block, matematyk Cornell współpracujący z Rosenblattem, był w stanie udowodnić, że procedura korekcji błędów gwarantuje znalezienie hiperpłaszczyzny, która doskonale oddzieli zestaw danych treningowych, gdy taka hiperpłaszczyzna istniała. wykonane za pomocą symulacji komputerowych, Rosenblatt wolał budować wersje sprzętowe swoich perceptronów (symulacje były wczesne na wczesnych komputerach, co wyjaśniało zainteresowanie budowaniem specjalnego sprzętu perceptronowego). MARK I był alfa-perceptronem zbudowanym w Cornell Aeronautical Laboratory pod sponsorowanie Oddziału Systemów Informatycznych Offce of Naval Research i Rome Air Development Center. Zostało to publicznie zademonstrowane 23 czerwca 1960 r. MARK I używał regulatorów głośności (zwanych przez inżynierów elektryków "potencjometrami") do ważenia. Mają one przymocowane do nich małe silniki w celu wykonania regulacji w celu zwiększenia lub zmniejszenia wartości masy.

W 1959 roku Frank Rosenblatt przeniósł swoją pracę perceptronową z Cornell Aeronautical Laboratory w Buffalo w stanie Nowy Jork na Cornell University, gdzie został profesorem psychologii. Wraz z Blockiem i kilkoma studentami Rosenblatt kontynuował eksperymentalne i teoretyczne prace nad perceptronami. Jego książka Principles of Neurodynamics szczegółowo opisuje jego teoretyczne pomysły i wyniki eksperymentów. Ostatni system Rosenblatta, zwany Tobermory, został zbudowany jako urządzenie do rozpoznawania mowy. [Tobermory to imię kota, który nauczył się mówić w The Chronicles of Clovis, grupie opowiadań Saki (H. H. Munro).] Kilka doktorantów studenci, w tym George Nagy, Carl Kessler, R. D. Joseph i inni, ukończyli projekty perceptronowe pod Rosenblattem w Cornell. W ostatnich latach pobytu w Cornell Rosenblatt zajął się badaniem transferu pamięci chemicznej u robaków i innych zwierząt {temat całkowicie usunięty z pracy nad perceptronem. Niestety, Rosenblatt zginął w wypadku podczas żeglugi w zatoce Chesapeake w 1969 roku. Mniej więcej w tym samym czasie co alfa-perceptron Rosenblatta, Woodrow W. (Woody) Bledsoe (1921 {1995) i Iben Browning (1918-1991), dwaj matematycy z Sandia Laboratories w Albuquerque w Nowym Meksyku, również prowadzili badania nad rozpoznawaniem znaków, które wykorzystywały losowe próbki obrazów wejściowych. Eksperymentowali z systemem, który wyświetlał obrazy znaków alfanumerycznych na mozaice 10 x 15 fotokomórek i próbkował stany 75 losowo wybranych par fotokomórek. Wskazując, że pomysł można rozszerzyć na próbkowanie większych grup pikseli, powiedzmy N z nich, nazwali swoją metodę metodą "N-krotki". Wykorzystali wyniki tego próbkowania do podjęcia decyzji o kategorii litery wejściowej

ADALINESY I MADALINES

Niezależnie od Rosenblatt, grupa kierowana przez profesora inżynierii elektrycznej Stanforda Bernarda Widrowa również pracowała nad systemy sieci neuronowych na przełomie lat 50. i 60. XX wieku. Widrow niedawno dołączył do Stanford po ukończeniu doktoratu z teorii sterowania na MIT. Chciał wykorzystać systemy sieci neuronowej do czegoś, co nazwał "kontrolą adaptacyjną". Jedno z urządzeń zbudowanych przez Widrow nazwano "ADALINE "(dla adaptacyjnej sieci liniowej). Był to pojedynczy element neuronowy, którego regulowane ciężary były realizowane przez przełączalne (w ten sposób regulowane) obwody rezystorów. Widow i jeden z jego uczniów, Marcian E. "Ted" Hoff Jr. (który później wynalazł pierwszy mikroprocesor w firmie Intel), opracowali regulowaną wagę, którą nazywali "a" "memistor". Składał się z grafitowego pręta, na którym warstwa miedzi mogła być powlekana i nieplaterowana - zmieniając w ten sposób jej opór elektryczny. Widrow i Hoff opracowali procedurę szkolenia dla ich elementu neuronowego ADALINE, który nazwano algorytmem adaptacyjnym najmniejszych średnich kwadratów Widrowa-Hoffa. Większość eksperymentalnych prac Widrowa została wykonana przy użyciu symulacji na komputerze IBM1620. Ich najbardziej skomplikowany projekt sieci nazwano "MADALINE" (dla wielu ADALINE). Procedurę szkoleniową opracował dla niego w Stanford student William Ridgway.

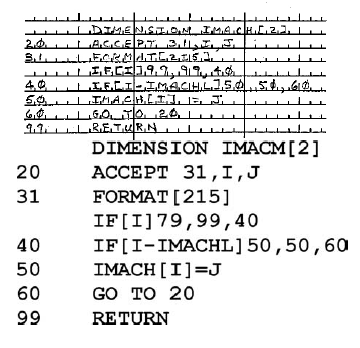

Systemy MINOS w SRI

Sukces Rosenblatta z perceptronami w problemach z rozpoznawaniem wzorców doprowadził do wzmożenia wysiłków badawczych innych osób w celu powielenia i rozszerzenia jego wyników. W latach sześćdziesiątych być może najbardziej znaczące prace w zakresie rozpoznawania wzorców z wykorzystaniem sieci neuronowych zostały wykonane w Stanford Research Institute w Menlo Park w Kalifornii. Tam Charles A. Rosen (1917-2002) kierował laboratorium, które próbowało wytrawić mikroskopijne lampy próżniowe na podłożu półprzewodnikowym. Rosen spekulował, że obwody zawierające te lampy mogą być ostatecznie "podłączone" do wykonywania przydatnych zadań przy użyciu niektórych procedur szkoleniowych opisanych przez Franka Rosenblatta. SRI zatrudniło Rosenblatta jako konsultanta do pomocy w projektowaniu eksploracyjnej sieci neuronowej. Kiedy w 1960 roku przeprowadziłem wywiad na stanowisko w SRI, zespół w laboratorium Rosen pod kierownictwem Alfreda E. (Teda) Brain (1923-2004) właśnie zakończył budowę małej sieci neuronowej o nazwie MINOS. (W mitologii greckiej Minos był królem Krety i synem Zeusa i Europy. Po śmierci Minos był jednym z trzech sędziów w podziemiu). Brain uważał, że symulacje komputerowe sieci neuronowych są zbyt wolne do praktycznych zastosowań, co prowadzi do decyzji o budowie zamiast programowania. (Komputer IBM 1620 używany w tym samym czasie przez grupę Widrowa w Stanford do symulacji sieci neuronowych miał podstawowy cykl maszynowy wynoszący 21 mikrosekund i maksymalnie 60 000 "cyfr "pamięci o swobodnym dostępie.) W celu regulacji ciężarów MINOS zastosował magnetyczny urządzenia zaprojektowane przez Brain. Rosenblatt pozostawał w bliskim kontakcie z SRI, ponieważ był zainteresowany wykorzystaniem tych urządzeń magnetycznych jako zamienników swoich potencjometrów napędzanych silnikiem. Entuzjazm i optymizm Rosen odnośnie potencjału sieci neuronowych pomógł mu dołączyć do SRI. Po moim przybyciu w lipcu 1961 r. dostał szkic książki Rosenblatta do przeczytania. Zespół Brain dopiero zaczynał prace nad budową dużej sieci neuronowej, zwanej MINOS II, kontynuacją mniejszego systemu MINOS. wspierany przede wszystkim przez Korpus Sygnałowy Armii USA w latach 1958-1967. Celem pracy MINOS było "przeprowadzenie badań naukowych i eksperymentalnych badań technik i sprzętu cechy odpowiednie do praktycznego zastosowania w graficznym przetwarzaniu danych dla potrzeb wojskowych. "Głównym celem projektu było automatyczne rozpoznawanie symboli na mapach wojskowych. Podjęto również próby innych zastosowań - takich jak rozpoznawanie pojazdów wojskowych, takich jak czołgi, na zdjęciach lotniczych i rozpoznawanie ręcznie drukowanych znaków - w pierwszym etapie przetwarzania przez MINOS II obraz wejściowy był replikowany 100 razy za pomocą matrycy plastikowej 10 x 10. Każdy z tych identycznych obrazów został następnie przesłany przez własną optyczną maskę wykrywającą cechy, a światło przez maskę zostało wykryte przez fotokomórkę i porównane z progiem. Rezultatem był zestaw 100 wartości binarnych (wyłączone - włączone). Wartości te stanowiły dane wejściowe do zestawu 63 elementów neuronowych ("jednostek A" w terminologii Rosenblatta), każdy o 100 zmiennych wagach magnetycznych. 63 wyjścia binarne z tych elementów neuronowych zostały następnie przetłumaczone na jedną z 64 decyzji dotyczących kategorii oryginalnego obrazu wejściowego. (Zbudowaliśmy 64 równie odległe "punkty" w sześćdziesięciu trójwymiarowych przestrzeniach i przeszkoliliśmy sieć neuronowa, dzięki czemu każdy obraz wejściowy tworzy punkt bliższy własnemu punktowi prototypu niż innemu. Każdy z tych prototypowych punktów był jedną z 64 "sekwencji rejestru przesuwnego o maksymalnej długości" o 63 wymiarach).

W latach 60. grupa sieci neuronowych SRI, zwana wówczas

Grupa Learning Machines badała wiele różnych organizacji sieciowych i procedur szkoleniowych. Ponieważ komputery stały się zarówno bardziej dostępne, jak i potężniejsze, coraz częściej korzystaliśmy z symulacji (w różnych centrach komputerowych) na komputerach Burroughs 220 i 5000 oraz na IBM 709 i 7090. W połowie lat 60. otrzymaliśmy własny edytowany komputer, SDS 910 (SDS 910, opracowany w Scienti c Data Systems, był pierwszym komputerem, w którym zastosowano tranzystory krzemowe). Użyliśmy tego komputera w połączeniu z najnowszą wersją naszego sprzętu sieci neuronowej (teraz z wykorzystaniem zestawu 1024 soczewek wstępnego przetwarzania), połączenie nazwaliśmy MINOS III. Jednym z najbardziej udanych rezultatów w systemie MINOS III było automatyczne rozpoznawanie ręcznie drukowanych znaków na arkuszach kodujących FORTRAN. (W latach 60. programy komputerowe były zwykle pisane ręcznie, a następnie konwertowane na karty dziurkowane przez operatorów uderzeń kluczowych). Pracami tymi kierowali John Munson

(19391972), Peter Hart i Richard Duda. Neuronowa część MINOS III została wykorzystana do stworzenia rankingu możliwych klasyfikacji dla każdej postaci z miarą siły dla każdej postaci. Na przykład, pierwszy znak napotkany w ciągu znaków może zostać rozpoznany przez sieć neuronową jako D o sile 90 i jako O o sile 10. Ale akceptując najbardziej pewną decyzję dla każdego znaku nie może powstać ciąg znaków, który jest prawnym oświadczeniem w języku FORTRAN {wskazując, że co najmniej jedna decyzja była błędna (przy założeniu, że ktokolwiek napisał oświadczenie na arkuszu kodowym napisał oświadczenie prawne). Zaakceptowanie drugiego lub trzeciego najbardziej bezpiecznego wyboru dla niektórych znaków może być wymagane do utworzenia prawidłowego ciągu znaków. Całkowitą stęSenie pełnego ciągu znaków obliczono, dodając stany poszczególnych znaków w ciągu. Następnie potrzebny był sposób uszeregowania tych liczb liczb całkowitych dla każdego z możliwych ciągów wynikających ze wszystkich różnych wyborów dla każdego

znaku. Spośród tego rankingu wszystkich możliwych ciągów system następnie wybrał najbardziej pewny ciąg prawny. Jednak, jak napisał Richard Duda, Problem znalezienia pierwszego, drugiego, trzeciego

najbardziej złożonego ciągu znaków nie jest wcale trywialnym problemem. Kluczem do skutecznego obliczenia rankingu było zastosowanie metody zwanej programowaniem dynamicznym. Ilustracja próbki oryginalnego źródła i ostatecznego wyjścia pokazano poniżej.

Po przeszkoleniu części sieci neuronowej systemu, cały system (który zdecydował się na najbardziej pewny ciąg prawny) był w stanie osiągnąć dokładność rozpoznawania wynoszącą nieco ponad 98% na dużej próbce materiału, który nie był częścią tego, na co szkolono system. Rozpoznawanie odręcznych postaci z takim poziomem dokładności było znaczącym osiągnięciem w latach sześćdziesiątych. Rozszerzając swoje zainteresowania poza sieci neuronowe, Learning Machines Group ostatecznie przekształciło się w Centrum Sztucznej Inteligencji SRI, które do dziś jest wiodącym przedsiębiorstwem badawczym zajmującym się AI.

Metody statystyczne

W latach pięćdziesiątych i sześćdziesiątych istniało kilka zastosowań metod statystycznych do problemów z rozpoznawaniem wzorców. Wiele z tych metod było bardzo podobnych do niektórych technik sieci neuronowych. Przypomnij sobie, że wcześniej wyjaśniłem, jak zdecydować, który z dwóch tonów będzie obecny w głośnym sygnale radiowym. Podobną technikę można zastosować do rozpoznawania wzorów. Do klasyfikowania obrazów (lub innych danych percepcyjnych) zwykle reprezentowano dane wejściowe za pomocą listy wyróżniających "cech", takich jak te używane przez Selfridge'′a i jego współpracowników. Na przykład w rozpoznawaniu znaków alfanumerycznych jedną z pierwszych cech wyodrębniono z obrazu znaku, który ma zostać sklasyfikowany. Zazwyczaj cechy miały wartości liczbowe, takie jak liczba razy, gdy linie o różnych kątach przecinały znak lub długość obwodu najmniejszego koła, które całkowicie otaczało znak. Wybór odpowiednich funkcji był często bardziej sztuką niż nauką, ale miał kluczowe znaczenie dla dobrej wydajności. Potrzebujemy trochę elementarnej notacji matematycznej, aby pomóc opisać te statystycznie zorientowane metody rozpoznawania wzorców. Załóżmy, że lista funkcji wyodrębnionych ze znaku to {f1; f2; … ; fi;… :; fN}. Skrócę tę listę za pomocą pogrubionego symbolu X. Załóżmy, że istnieje k kategorii, C1; C2;… ; Ci; … ; Ck, do którego może należeć znak opisany przez XUżywając reguły Bayesa w sposób podobny do opisanego wcześniej, reguła decyzyjna jest następująca:

Zdecyduj na korzyść tej kategorii, dla której p(X |Ci)p(Ci) jest największe, gdzie p(Ci jest prawdopodobieństwem a priori kategorii Ci i p(p(Cii) to prawdopodobieństwo X dla Ci. Prawdopodobieństwa te można wywnioskować, zbierając dane statystyczne z dużej próbki znaków.

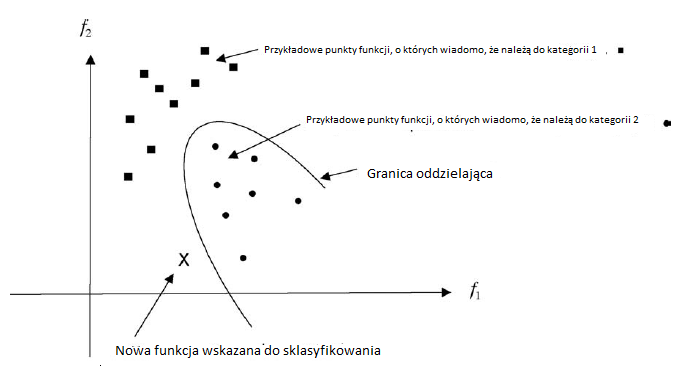

Jak wspomniałem wcześniej, badacze w rozpoznawaniu wzorów często opisują proces decyzyjny w kategoriach geometrii. Wyobrażają sobie, że wartości cech uzyskanych z próbki obrazu można przedstawić jako punkt w przestrzeni wielowymiarowej. Jeśli mamy kilka próbek dla każdej powiedzmy dwóch znanych kategorii danych, możemy reprezentować te próbki jako rozproszenie punktów w przestrzeni. W rozpoznawaniu znaków rozproszenie może wystąpić nie tylko dlatego, że obraz postaci może być hałaśliwy, ale także dlatego, że postacie z tej samej kategorii mogą być rysowane nieco inaczej. Pokazuję dwuwymiarowy przykład z funkcjami f1 i f2 na rysunku.

Na podstawie rozproszenia punktów w każdej kategorii możemy obliczyć oszacowanie prawdopodobieństw potrzebnych do obliczenia prawdopodobieństw. Następnie możemy wykorzystać prawdopodobieństwa i wcześniejsze prawdopodobieństwa do podjęcia decyzji. Pokazuję tutaj granicę, obliczoną na podstawie prawdopodobieństw i wcześniejszych prawdopodobieństw, która dzieli przestrzeń na dwa regiony. W jednym regionie decydujemy się na kategorię 1; z drugiej wybieramy kategorię 2. Pokazuję także nowy punkt funkcji, X, który ma zostać sklasyfikowany. W tym przypadku pozycja X względem granicy narzuca, że klasyfikujemy X jako członka kategorii 1. Istnieją również inne metody klasyfikacji punktów charakterystycznych. Ciekawym przykładem jest metoda \ najbliższego sąsiada. W tym schemacie, wynalezionym przez E. Fixa i JL Hodgesa w 1951,nowy punkt cechy jest przypisany do tej samej kategorii, co ten przykładowy punkt cechy, do którego jest najbliżej. na powyższym rysunku nowy punkt X zostałby sklasyfikowany jako należący do kategorii 2. przy użyciu metody najbliższego sąsiada.

Ważne opracowanie metody najbliższego sąsiada przypisuje nowy punkt do tej samej kategorii co większość k najbliższych punktów. reguła decyzyjna wydaje się prawdopodobna (w przypadku, gdy istnieje wiele, wiele punktów próbnych każdej kategorii), ponieważ istnieje więcej punktów próbnych kategorii Ci bliżej nieznanego punktu, X, niż punkty próbne kategorii Cj jest dowodem, że p(X | Ci) p (Ci) jest większy niż p(X | Cj)) p (Cj) W oparciu o tę ogólną obserwację Thomas Cover i Peter Hart rygorystycznie przeanalizowali skuteczność metod najbliższego sąsiedztwa. Każda technika rozpoznawania wzorców, nawet wykorzystująca sieci neuronowe lub najbliższych sąsiadów, może być uważana za konstruowanie granic oddzielających w wielowymiarowej przestrzeni cech. Inną metodę konstruowania granic przy użyciu "funkcji potencjalnych" zasugerowali rosyjscy naukowcy M. A. Aizerman, E. M. Braverman i L. I. Rozonoer w latach 60. Niektóre ważne wczesne książki na temat stosowania metod statystycznych w rozpoznawaniu wzorców to George Sebestyen, Richard Duda i Peter Hart. Technologia rozpoznawania wzorów pod koniec lat 60. XX wieku została dobrze oceniona przez George'a Nagy'a (który wcześniej był jednym z doktorantów Franka Rosenblatta).

Zastosowania rozpoznawania wzorów w rozpoznaniu lotniczym

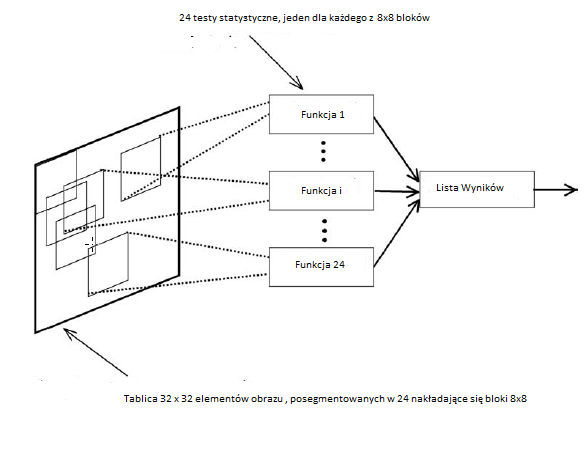

Sieć neuronowa i metody statystyczne rozpoznawania wzorców przyciągnęły wiele uwagi w wielu firmach z branży lotniczej i lotniczej na przełomie lat 50. i 60. XX wieku. Firmy te miały duży budżet na badania i rozwój wynikające z umów z Departamentem Obrony USA. Wiele z nich było szczególnie zainteresowanych problemem zwiadu powietrznego, tj. lokalizacją i identyfikacją "celów" na zdjęciach lotniczych. Wśród firm prowadzących szeroko zakrojone programy badawcze poświęcone temu zagadnieniu i powiązanych z nimi problemami był Dział Aeronutronic Ford Motor Co., Douglas Aircraft Company (jak wtedy było znane), General Dynamics, Lockheed Missiles and Space Division oraz Philco Corporation (Philco został później przejęty przez Forda pod koniec 1961 r.) Wspomnę o niektórych pracach w Philco , Laveen N. Kanal, Neil C. Randall i Thomas Harley pracowali zarówno nad teorią, jak i metodami statystycznego rozpoznawania wzorców. Opracowane przez nich systemy służyły do przeglądania zdjęć lotniczych pod kątem interesujących celów wojskowych, takich jak czołgi. ilustracja jednego z ich systemów pokazano na rysunku

Aparat Philco zeskanował materiał z 9-calowych negatywów zebranych przez samolot rozpoznawczy U2 podczas manewrów czołgów armii amerykańskiej w Fort Drum w Nowym Jorku. Niewielka część zeskanowanego zdjęcia, prawdopodobnie zawierająca czołg M-48 (w standardowej pozycji i rozmiarze), została najpierw przetworzona w celu wzmocnienia krawędzi, a wynik został przedstawiony systemowi wykrywania celu jako układ zer i jedynek. Pierwszy z ich systemów używał tablicy 22 x 12; później używali tablicy 32 x 32, jak pokazano na powyższym rysunku. Tablica została następnie podzielona na 24 nakładające się 8 x 8 "bloków cech". Dane w każdym bloku obiektów są następnie poddawane testowi statystycznemu, aby zdecydować, czy mały obszar obrazu reprezentowany przez ten blok zawiera część zbiornika. Testy statystyczne oparto na "próbce szkoleniowej" 50 obrazów zawierających zbiorniki i 50 próbek terenu niezawierającego zbiorników. Dla każdego bloku cech 8 x 8 opracowano parametry statystyczne z tych próbek w celu ustalenia (liniowej) granicy w sześćdziesięciu - czterowymiarowa przestrzeń, która najlepiej rozróżnia próbki zbiorników od próbek nieczołgowych. Korzystając z tych granic, system został następnie przetestowany na innym zestawie 50 obrazów zawierających zbiorniki i 50 obrazów niezawierających zbiorników. Dla każdego obrazu testowego liczba cech bloki decydujące o "obecności czołgu" zostały obliczone, aby uzyskać końcowy "wynik" liczbowy (np. 21 z 24 bloków zdecydowało, że czołg był obecny). Wynik ten może być następnie wykorzystany do podjęcia decyzji, czy obraz zawiera czołg. Autorzy stwierdzili, że "wyniki eksperymentalne procedury klasyfikacji statystycznej przekroczyły wszelkie oczekiwania". Prawie połowa próbek testowych miała doskonałe wyniki (to znaczy, wszystkie 24 bloki cech prawidłowo rozróżniały zbiornik i zbiornik). Ponadto wszystkie próbki testowe zawierające zbiorniki miały wynik większy lub równy 11, a wszystkie próbki testowe niezawierające zbiorników miały wynik mniejszy lub równy 7. System wczesnego wykrywania zbiorników w Philco został zbudowany z analogowym zespół obwodów - nie zaprogramowany na komputerze. Jak później opracował Thomas Harley, lider projektu tego systemu, ważne jest, aby pamiętać o technologicznym kontekście epoki, w której ta praca została wykonana. Wdrożony przez nas system nie miał wbudowanych możliwości obliczeniowych. Ciężarami liniowej funkcji dyskryminacyjnej były rezystory, które kontrolowały prąd pochodzący z (binarnego) źródła napięcia w elementach rejestru przesuwnego. Prądy te zostały zsumowane i każda cecha została rozpoznana lub nie w zależności od tego, czy suma tych prądów przekroczyła wartość progową. Te decyzje dotyczące funkcji binarnych zostały następnie zsumowane, ponownie w analogowym obwodzie elektrycznym, a nie w komputerze, i ponownie podjęto decyzję [zbiornik lub brak zbiornika] w zależności od tego, czy suma przekroczyła wartość progową

W innym systemie klasyfikacja statystyczna została wdrożona przez program o nazwie MULTINORM, działający na komputerze Philco 2000. W innych eksperymentach Philco zastosował dodatkowe testy statystyczne, aby w większym stopniu obliczyć niektóre bloki cech niż inne przy obliczaniu wyniku końcowego. Kanal powiedział, że te eksperymenty z ważeniem wyników bloków charakterystycznych "przewidywały ideę klasyfikacji maszyny wektorów nośnych (SVM) [...] przy użyciu pierwszej warstwy do identyfikacji próbek szkoleniowych blisko granicy między zbiornikami i innych czołgi."

Oczywiście systemy te miały dość łatwe zadanie. Wszystkie czołgi były w standardowej pozycji i były już odizolowane na zdjęciu. (Autorzy wspominają jednak o tym, w jaki sposób system można dostosować do radzenia sobie z czołgami występującymi w dowolnej pozycji lub orientacji na obrazie. System uważam za interesujący nie tylko ze względu na jego wydajność, ale także ponieważ jest to system warstwowy (podobny do Pandemonium i do alfa-perceptronu) i ponieważ jest to przykład, w którym oryginalny obraz jest podzielony na nakładające się podobrazy, z których każdy jest przetwarzany niezależnie. Jak wspomnę później, nakładające się podobrazy odgrywają znaczącą rolę w niektórych modelach obliczeniowych kory nowej. Niestety raporty Philco zawierające szczegóły tej pracy nie są łatwo dostępne. Co więcej, Philco i niektóre inne grupy zaangażowane w tę pracę zniknęły. Oto, co napisał mi Tom Harley o raportach Philco i o samym Philco:

Większość prac związanych z rozpoznawaniem wzorów wykonanych w Philco w latach 60. XX wieku była sponsorowana przez Departament Obrony, a raporty nie były dostępne do publicznej dystrybucji. Od tego czasu sama firma naprawdę rozpłynęła się w powietrzu. Firma Phil Motor została kupiona przez Ford Motor Company w 1961 r., A do 1966 r. Wyeliminowali laboratoria badawcze Philco, w których pracował Laveen Kanal. Ford próbował przenieść tą małą grupę do rozpoznawania wzorów do Newport Beach w Kalifornii [lokalizacja firmy Aeronutronic Division, której grupa do rozpoznawania wzorów również się później złożyła], a kiedy wszyscy postanowili nie iść, przenieśli ich do działu komunikacji i powiedzieli aby zamknąć nasze projekty rozpoznawania wzorców. Laveen ostatecznie przeszedł na University of Maryland. W późniejszych latach to, co było Philco, zostało sprzedane Loralowi, a większość z nich została później sprzedana Lockheedowi Martinowi.

Podejście do problemów AI związanych z sieciami neuronowymi i technikami statystycznymi nazwano "niesymbolicznymi" w celu zestawienia ich z pracą "przetwarzania symboli" przez osoby zainteresowane udowodnieniem twierdzeń, graniem w gry i rozwiązywaniem problemów . Te niesymboliczne podejścia znalazły zastosowanie głównie w rozpoznawaniu wzorców, przetwarzaniu mowy i widzeniekomputerowe. Warsztaty i konferencje poświęcone szczególnie tym tematom zaczęły się w latach 60. XX wieku. Podgrupa IEEE Computer Society (podkomitet ds. Rozpoznawania wzorców w komitecie ds. Pozyskiwania i przekształcania danych) zorganizowała pierwsze "rozpoznawanie wzorców"

Warsztat ", który odbył się w Puerto Rico w październiku 1966 r. Drugi (w którym uczestniczyłem) odbył się w Delft w Holandii w sierpniu 1968 r. W 1966 r. Ta podgrupa stała się IEEE Computer Society Pattern Analysis and Machine Intelligence (PAMI) ) Komitet techniczny, który nadal organizował konferencje i warsztaty. Tymczasem pod koniec lat 50. i na początku lat 60. ludzie przetwarzający symbole wykonywali swoją pracę głównie na MIT, na Carnegie Mellon University, IBM i na Uniwersytecie Stanforda. przejdź dalej do opisu niektórych z tego, co zrobili.