Strategiczne Programy Komputerowe DARPA

Strategiczny plan obliczeniowy

Na początku lat osiemdziesiątych systemy eksperckie i inne technologie sztucznej inteligencji, takie jak rozumienie obrazu i mowy oraz przetwarzanie języka naturalnego, były bardzo obiecujące. Nastąpił także znaczny postęp w dziedzinie technologii komunikacyjnych, sieci i architektur komputerowych oraz technologii przechowywania i przetwarzania danych. Robert Kahn , który został dyrektorem Działu Technik Informacyjnych DARPA (CETO) w 1979 r., Zaczął myśleć, że DARPA powinna sponsorować duży program badań i rozwoju, który zintegrowałby wysiłki we wszystkich tych obszarach aby stworzyć znacznie potężniejsze systemy komputerowe. Jednocześnie obawiano się, że japoński program FGCS może zagrozić przywództwu USA w technologii komputerowej. Biorąc pod uwagę te czynniki, Kahn zaczął planować program, który nazwano by programem "Strategic Computing" (SC). Kahn był profesorem w MIT i inżynierem w BBN, zanim podjął pracę w IPTO w DARPA jako kierownik programu pod koniec 1972 roku. Tam zainicjował i prowadził program

internetowy DARPA, łącząc Arpanet z Packet Radio i Packet Satellite Nets w celu utworzenia pierwszego wersja dzisiejszego Internetu. On i Vinton Cerf, wówczas w Stanford, współpracowali przy opracowywaniu tego, co miało stać się podstawową architekturą Internetu i jego "Protokołem kontroli transmisji" (TCP). (TCP został później zmodularyzowany i stał się TCP / IP, a IP oznacza Internet Protocol). Cerf dołączył do DARPA w 1976 r. i prowadził program do Internetu do 1982 r. Za swoją pracę Kahn i Cerf dzielili Nagrodę Turinga przyznaną przez Stowarzyszenie Maszyn Komputerowych w 2004 r. . Kahn pomyślał, że sztuczna inteligencja, zwłaszcza systemy eksperckie, może odgrywać ważną rolę w SC. Przypomnijmy, że w połowie lat siedemdziesiątych wsparcie DARPA dla badań nad AI ucierpiało podczas pełnienia funkcji przez George′a Heilmeiera jako dyrektora DARPA. Poważną ofiarą był program rozumienia mowy. Program SC mógłby zrewitalizować badania nad sztuczną inteligencją, ale co ważniejsze, zdaniem Kahna, pomógłby

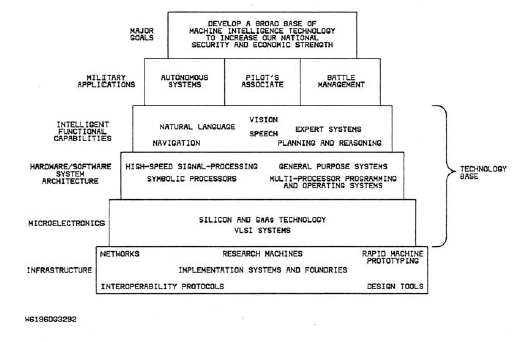

przenieść obiecujące techniki sztucznej inteligencji z laboratoriów uniwersyteckich do rzeczywistych zastosowań. Alex Roland, który napisał dobrze przyjętą książkę o historii programu SC, ujął to w ten sposób: Robert Kahn i architekci SC wierzyli w 1983 r. [Po boomie systemów eksperckich], że AI jest gotowa do wykorzystania. Ostatecznie wyprowadziło się z laboratorium do prawdziwego świata. AI stałoby się istotnym składnikiem SC; centralne będą systemy ekspertowe. [Pozwoliliby] pozwolić maszynom "myśleć". Kahn widział program SC jako piramidę powiązanych technologii, które należy opracować. U podstaw były technologie wspomagające, takie jak urządzenia do szybkiego projektowania i wdrażania potrzebnego sprzętu. Ponad tym znajdowały się technologie sprzętowe i programowe, z widoczną sztuczną inteligencją. Wszystko to łączyłoby się w określonych systemach wojskowych, takich jak pojazdy robotów i pomoce do zarządzania bitwą. Jedną z (wielu) wersji tej piramidy pokazano

Program SC wspierałby, koordynował i zarządzał badaniami i rozwój wszystkich technologii w piramidzie. Miał stać się programem wartym miliardy dolarów - największym programem badań i rozwoju komputerowego, jaki do tej pory podjął rząd USA. Szefem Kahna był Robert Cooper, który został dyrektorem DARPA w lipcu 1981 r. Cooper był entuzjastycznie nastawiony do pomysłów Kahna na program SC, choć różnił się od Kahna strategią badawczą i sposobem opisu programu. Jak napisał Alex Roland, Kahn powiedział, że zbuduj bazę technologiczną i wydarzy się coś miłego. Cooper powiedział, że skupi się na współpracowniku pilota, a baza technologiczna podąży za nim. Jednym z paradygmatów jest pchnięcie technologii, a drugie przyciągnięcie technologii. Jednym jest bańka w górę, a druga spływa w dół. . . . Napięcie między nimi podkreślało SC przez większą część swojej historii. Ze względu na swoją wielkość program SC musiałby być "sprzedawany" tym komisjom kongresowym nadzorującym budżet DARPA. Cooper wiedział, że podkreślenie (rzeczywiście obiecujące) konkretnych zastosowań wojskowych było sposobem sprzedaży Kongresu. Miał rację, jeśli chodzi o przekonanie Kongresu, ale ostatecznie technologia nie działała tak dobrze. Jednym z czynników pomagających przekonać Kongres o potrzebie programu SC był japoński program FGCS. Według Rolanda Kongres był bardziej ćwiczony przez program piątej generacji Japonii niż administracja Reagana czy społeczność komputerowa [w tym Kahn i Cooper]. "Publikacja książki o japońskim projekcie Edwarda Feigenbauma i Pameli McCorduck miała wpływ na wzmocnienie te obawy. We wstępie do swojej książki pytali: "Czy podejmiemy [to kluczowe wyzwanie]? Jeśli nie, możemy powierzyć naszemu narodowi rolę pierwszego reindustrialnego społeczeństwa rolnego". Ostrzegli ponadto, że :

… nasz narodowy interes własny, nie wspominając o naszym bezpieczeństwie ekonomicznym, nie pozwala nam [zignorować japońskiego projektu]. Przetwarzanie informacji to w Stanach Zjednoczonych przemysł o wartości 88 miliardów dolarów rocznie, a jego utrata byłaby katastrofalna. Niewypłacalność tego amerykańskiego przemysłu, który od dziesięcioleci kieruje światem, byłaby śmiertelną raną gospodarczą. . . . Zaawansowana technologia zwykle wygrywa wojnę {bez względu na to, czy wojna jest wojenna, przedsiębiorcza czy kulturowa. W czerwcu 1983 r. Feigenbaum zeznał przed Izbą ds. Nauki, Przestrzeni Kosmicznej i Technologii. Według Rolanda powiedział komitetowi: "era maszyn rozumujących jest nieunikniona ... Jest to oczywiste przeznaczenie komputera."

Kahna przekonano do poddania się wizji Coopera dotyczącej tego, jak opracować plan. Zostało to ostatecznie napisane w październiku 1983 r. 8,8 mln funduszy na wsparcie SC zostało zatwierdzonych na poziomie 50 mln USD na rozpoczęcie prac w roku 1984. (Jeden Pracownik kongresu zalecił nawet, aby DARPA wydała "znacznie wyższą kwotę".) W ciągu dekady od 1983 r. Do 1993 r. DARPA wydała nieco ponad 1 miliard USD na SC.. Plan przewidywał wsparcie dwóch głównych kierunków, a mianowicie dużych projektów, które budowałyby określone aplikacje i podstawowe badania w celu opracowania "bazy technologicznej", która byłaby potrzebna dla tych aplikacji. Opiszę aspekty każdego z nich w poniższych sekcjach.

Duże projekty

Na początku programu wybrano trzy główne aplikacje. Aby zachęcić wszystkie trzy służby wojskowe do "wpisania się" do programu, w planie wezwano do "Pilot's Associate" (dla sił powietrznych), lotniskowca, "System zarządzania bitwą" (dla Marynarki Wojennej) i " Autonomiczny pojazd lądowy "(dla wojska). Jednak, aby zachęcić do wspólnego wsparcia wszystkich tych usług, w planie ostrzegano, że [na przykład] może okazać się lepszym rozwiązaniem niż realizacja autonomicznego pojazdu podwodnego zamiast pojazdu lądowego, a system zarządzania bitwą dla walki lądowej może okazać się bardziej odpowiednie niż dla aplikacji Naval. Jak napisał Mark Stek w swojej doskonałej recenzji i ocenie programu, "… .DARPA mówi służbom, że dane tych aplikacji można w dowolnym momencie zmienić, więc lepiej kupić plan wahole". Rzeczywiście, dodatkowe zastosowania, takie jak "autonomiczny pojazd powietrzny" do wystrzeliwania inteligentnych bomb za liniami wroga, podjęto później.

Współpracownik pilota

Program Pilot's Associate (PA), rozpoczęty w lutym 1986 r., Miał na celu opracowanie interaktywnego systemu komputerowego, który miałby pomóc dowódcy samolotu bojowego. Interakcja z systemem odbywałaby się za pomocą graficznego interfejsu użytkownika, rozpoznawania głosu (zdolnego do pracy w hałaśliwych i stresujących warunkach) oraz syntezy mowy. Przygotowywałby i korygował plany misji, doradzał pilotowi o celach, oceniał zagrożenia, pomagał pilotowi w unikaniu pocisków przechwytujących (automatycznie uruchamiając samolot na wypadek, gdyby musiał manewrować tak szybko, że pilot może stracić przytomność), i podjąć ponad rutynowymi zadaniami. Oprócz danych wejściowych pilota system uzyskiwałby informacje z pomocy nawigacyjnych i kilku czujników. Porady i decyzje byłyby oparte na kilku współpracujących systemach ekspertowych, systemach automatycznego planowania i systemach wykonywania planów. Wśród technicznych możliwości planu strategicznego DARPA z 1983 r przewiduje się, że do 1989 r. uda się osiągnąć 10 000 reguł, systemy eksperckie w czasie rzeczywistym, animowane wyświetlacze ze 108 wielokątami na sekundę, 200 słów, niezależne od głośników rozpoznawanie mowy w środowiskach o wysokim poziomie hałasu i system wyjściowy mowy o mocy 1000 słownictwo słowne. Oczywiście wymagany byłby również sprzęt kompaktowy i odpowiedni do samolotów. Program był zarządzany przez Avionics Laboratory w Wright-Patterson Air Force Base w Dayton, Ohio (późniejsza część Air Force Research Laboratory). Po wstępnych badaniach (w których uczestniczyło pięciu wykonawców) zespoły kierowane przez Lockheed Aeronautical Systems ( później część Lockheed Martin Corporation) i McDonnell Douglas (późniejsza część Boeinga) otrzymali kontrakty na prace trwające od 1986 r. do połowy 1992 r. Jak stało się standardem w projektach zarządzanych przez DARPA, konieczne było przedstawienie demonstracji roboczych. Według zestawu stron internetowych (ostatnio zaktualizowanych w 2004 r.) Opisujących projekt, program Lockheed otrzymał nagrodę American Institute of Aeronautics and Astronautics (AIAA) Digital Electronics Award ".

W uznaniu za wybitne osiągnięcie

najnowocześniejsza sztuczna inteligencja i systemy wspomagania decyzji w złożonym, szybko zmieniającym się świecie walki powietrznej. Ta sama strona twierdziła również, że:

"Technicznie, do 1991 roku, PA była najbardziej zaawansowanym, działającym, inteligentnym systemem czasu rzeczywistego swoich czasów i pozostaje niedościgniona w świat. [W Lockheed] z powodzeniem zintegrowaliśmy 6 systemów eksperckich działających w czasie rzeczywistym w realistycznym (niektórzy twierdzą, że zbyt realistycznym) symulatorze bojowym. Wiedza zaimplementowana w każdym elemencie tego systemu była realistyczna, doświadczenie bojowe, które w sposób oczywisty można było zastosować w dzisiejszych operacjach samolotów bojowych."

Pomimo udanych demonstracji Departament Obrony nie kontynuował bezpośrednio instalacji tej technologii w samolotach bojowych. Jak to ujęła jedna ze stron internetowych: "[…] wykonawcom PA pozostawiono wprowadzenie technologii na rynek". Jednym ze spadków programu Associate Pilota był system, który został opracowany do użytku w śmigłowcach wojskowych, Associate Pilot Rotorcraft. Możliwe zastosowanie aplikacji do zarządzania ruchem lotniczym nigdy się nie urzeczywistniło, mimo że "wyniki [badań NASA] były wystarczające, aby pokazać, że technologia PA mogłaby umożliwić swobodną walkę w kontynentalnej i trans-oceanicznej przestrzeni powietrznej, z ogromnymi oszczędnościami kosztów operacyjnych dla linii lotniczych i infrastruktury kontroli ruchu lotniczego, a jednocześnie oferując dodatkowy poziom bezpieczeństwa. "

Systemy zarządzania bitwą

W 1984 r. DARPA rozpoczęła finansowanie programu zarządzania bitwą Fleet Command Center (FCCBMP). Firma o nazwie Analytics była wykonawcą inżynierii dla FCCBMP. Zapewniał wsparcie zarządzania programem, testowanie i zarządzanie konfiguracją. W artykule z 1990 roku, opisującym i oceniającym program, Rin Saunders, inżynier z Analytics, napisał, że jego celem było stworzenie systemu, który "… pomoże głównemu dowódcy floty amerykańskiej na Pacyfiku (CINCPACFLT) w planowanie i monitorowanie działania prawie 300 statków w regionach Pacyfiku i Oceanu Indyjskiego. "Saunders twierdził, że był to najskuteczniejszy ze strategicznych programów komputerowych we wdrażaniu systemów eksperckich i miał "największą widoczność i udział w społeczności użytkowników". Planowano, że systemy eksperckie będą odgrywać główną rolę w FCCBMP. Plan strategiczny DARPA przewidywał te, które mogłyby przetwarzać 10 000 reguł na sekundę w bardzo złożonych kontekstach działających w czasie rzeczywistym w czasie rzeczywistym. FCCBMP składał się z dwóch głównych systemów eksperckich komunikujących się przez sieć lokalną. Jeden z nich, "Force Experire Requirements Expert System (FRESH)", został zaprojektowany w celu śledzenia bieżących pozycji i stanu gotowości statków we flocie oraz wysyłania alertów, gdy nastąpiły znaczące zmiany. FRESH, opracowany przez Texas Instruments, miał być w stanie zasugerować, co należy zrobić, na przykład i tak kontynuować obecny plan, przyspieszyć naprawy lub wymienić inne statki dla niegotowych. Saunders twierdził, że FRESH zapewnia obecnie codzienne podsumowania alarmów dla dwunastu kodów pracowników CINCPACFLT. Wykazano, że FRESH replikuje osąd eksperta w procesie, w którym pracownicy FRESH i CINCPACFLT otrzymali to samo zadanie nominacyjne do rozwiązania. Pracownicy CINCPACFLT szacują, że FRESH może wykonać w ciągu jednej minuty zadania monitorowania, które poprzednio zajmowały dwie godziny, przynosząc 120-krotną oszczędność czasu. W przypadku zadania polegającego na wyznaczeniu zastępcy dla statku niepełnosprawnego oszczędność czasu wynosi od 400 do 1. Inny system ekspercki, "System Ekspertów ds. Oceny Zdolności (CASES), wykorzystał informacje o siłach USA i siłach wroga, aby oszacować, w jaki sposób każdy z nich taryfa w hipotetycznych walkach. Została opracowana przez BBN. Według Saundersa CASES został wykorzystany do oceny obszarów operacyjnych sił bojowych przewoźników; oceny strategii zatrudnienia okrętów podwodnych ataku; oszacowania efektu inwigilacji przed D-dniem i wczesnego przypisania SSN do wroga ścieranie okrętów podwodnych oraz zapewnianie wglądu w koszty i korzyści różnych strategii uderzeń w związku ze zmianami szacowanej zdolności wroga i pogody. Oba systemy ekspertowe w szerokim zakresie wykorzystywały rozumienie języka naturalnego i zdolności generowania. Zostały one hostowane na maszynach Symbolics Lisp i napisane przy użyciu komercyjnych powłok systemu eksperckiego. Symulacje bitew w CASES przeprowadzono na równoległym procesorze Encore. Ostateczne prototypy FRESH i CASES zostały dostarczone do CINCPACFLT w 990 roku. Ale kiedy faza prototypu została zakończona i zakończyło się finansowanie DARPA, marynarka wojenna postanowiła nie kontynuować tych systemów. Saunders, obecnie dyrektor techniczny w Computer Sciences Corporation, przedstawił mi kilka wspomnień na temat FCCBMP. Kontrastują one nieco z tym, co napisał w 1990 roku. W notatkach e-mailowych napisał mi, że cele FCCBMP były przesadą w stosunku do najnowocześniejszych rozwiązań w latach 80.

…

"[Decyzja] Marynarki Wojennej byłą , aby odłożyć na półkę FRESH, ponieważ nie było ważnego powodu, aby ją zatrzymać. Powielało to osąd ekspertów planistów floty w ciągu kilku godzin, a nie dni. Ale planiści nie chcieli przejść na emeryturę, a w wojnie morskiej dni są wystarczająco dobre. Jeśli chodzi o CASES, Flota chętnie posiadała narzędzia do symulacji. Ale celem jest zorganizowanie symulacji w inteligentny sposób, aby ocenić scenariusze "co, jeśli", nigdy nie powstały."M

…

"Uważam, że w DARPA / ISTO rosło uznanie, że programy badawcze technologii FRESH i CASES nie były najlepiej spełniane w zmiennych środowiskach operacyjnych. … Kongres naciskał również na DARPA, by przekierował fundusze na wojnę przeciw okrętom podwodnym, co było wówczas gorącym tematem. Relacje między DARPA a marynarką wojenną były zawsze napięte w pobliżu punktu krytycznego. Marynarka wojenna nieustannie walczyła z DARPA o kontrolę nad pro, zarówno ze względu na siebie, jak i odrodzenie programu, aby zapewnić większy zwrot w krótkim okresie. W końcu wszyscy uznali, że czas się spakować i iść do domu"

Pojazdy autonomiczne

Trzecim ważnym projektem aplikacji finansowanym w ramach programu SC DARPA był projekt "Autonomous Land Vehicle" (ALV) rozpoczęty w sierpniu 1984 r. Martin Marietta (później po połączeniu z Lockheed i Lockheed Martin) został wybrany na integratora projektu i sfinansował go w wysokości 10,6 mln USD na okres czterdziestu dwóch miesięcy. SRI, Carnegie Mellon University, University of Maryland, Hughes Research Laboratories, Advanced Decision Systems i Environmental Research Institute of Michigan (ERIM) zapewniły komponenty i pomoc badawczą. Laboratorium topograficzne inżynierii armii amerykańskiej pomogło w koordynacji prac. Cele projektu były zgodne z dalekosiężną strategiczną wizją armii polegającą na stosowaniu autonomicznych pojazdów w logistyce i zaopatrzeniu, w działaniach poszukiwawczo-ratowniczych, a nawet w walce. Wiele informacji o projekcie ALV można znaleźć w artykule Douglasa W. Gage′a. Zamiast sparafrazować jego podsumowanie, zacytuję je bezpośrednio: "ALV został zbudowany na ośmio-kołowym, napędzanym hydrostatycznie pojeździe terenowym o standardowej produkcji, zdolnym do osiągania prędkości do 45 km / h na autostradzie i do 18 km / h na nierównym terenie. ALV może przewozić sześć pełnych szafek z urządzeniami elektronicznymi w klimatyzowanym, bezpyłowym komforcie, zapewniając moc z APU o mocy 12 kW. Początkowy zestaw czujników składał się z kolorowej kamery wideo i skanera laserowego z Environmental Research Institute of Michigan (ERIM), które zwracały obraz w zakresie 64 na 256 pikseli w odstępach 1-2 sekundowych. Moduły przetwarzania danych wideo i zakresu wytworzyły informacje na temat drogi, które posłużyły do wygenerowania modelu sceny przed nami. Rozumowanie na wyższym poziomie zostało przeprowadzone przez moduły poszukiwacza bramki i nawigatora, które następnie przekazały pożądaną ścieżkę do modułu pilotującego, który faktycznie kierował pojazdem."

ALV miał być prekursorem pojazdów wojskowych, które mogły poruszać się bezkierunkowo po drogach i po nierównym terenie za pomocą komputerowych programów wizyjnych do informowania ich o ich otoczeniu i programach planowania oraz systemach eksperckich do kontrolowania ich tras. Musieliby unikać takich zagrożeń, jak inne pojazdy, skały, drzewa, rowy, przeszkody wodne oraz stromy lub błotnisty teren. Musieliby także umieć rozpoznawać punkty orientacyjne i inne znaczące przedmioty w ich bezpośrednim otoczeniu. Miały być całkowicie niezależne od wszystkich obliczeń wykonywanych na pokładzie. Strategiczny plan komputerowy DARPA określił pewne szczególne etapy dla ALV. W 1985 r. Miała odbyć się demonstracja "podążania drogą", podczas której ALV miał nawigować po wyznaczonej trasie 20 km z prędkością do 10 km / godz. Do 1986 r. Miała odbyć się "demonstracja omijania przeszkód" przy użyciu " stałych, wielościennych przedmiotów rozmieszczonych w odległości nie mniejszej niż 100 m od siebie i wielkości znacznie mniejszy niż szerokość drogi". W latach 1990 i 1991 miała odbyć się "demonstracja mieszanej drogi i otwartego terenu" z prędkościami do 90 km / h na drogach z innymi pojazdami. Według raportu National Research Council oceniającego postępy w pojazdach bezzałogowych, "ALV wykonał 1 km przejazd w 1985 r. pPrzy średniej prędkości 3 km / h. Ten wzrost wzrósł do 10 km / h przy 4 km trawersie w 1986. W 1987 r. ALV osiągnął prędkość maksymalną 20 km / h ... i użył skanera laserowego, aby ominąć przeszkody na drodze. " Ten sam raport jest kontynuowany od sierpnia 1987 r. ALV wykonał pierwszy autonomiczny trawers przełajowy w oparciu o dane z czujników. Podczas tego i kolejnych prób trwających około roku ALV pokonywał różne rodzaje izolowanych pozytywnych przeszkód na trawersach o długości kilku kilometrów. Teren miał strome zbocza (niektóre powyżej 15 stopni), wąwozy i wąwozy, duże dęby zarośnięte, zarośla i wychodnie skalne. Niektóre przeszkody stworzono na potrzeby eksperymentów. Najmniejsze przeszkody, które można było niezawodnie wykryć, miały wysokość od 2 stóp do 3 stóp. Czasami pojazd zbliżał się i wykrywał członków zespołu oraz manewr, aby ich unieważnić. Pojazd osiągnął prędkość od 3,5 do 5 km / h i wykonał około 75 procent trawersów. Wizja ALV stanowiła najtrudniejsze wyzwanie. Rozpoznanie skał, drzew, dróg i rowów doprowadziłoby do zaawansowania technologicznego zarówno algorytmów wizji komputerowej, jak i prędkości przetwarzania komputera w latach 80. Według Rolanda "DARPA oszacował, że system wizji ALV wymagałby 10-100 miliardów instrukcji na sekundę, w porównaniu ze wskaźnikiem w 983 wynoszącym zaledwie 30 - 40 milionów. " Szacuje się, że postrzeganie bezzałogowych pojazdów w czasie ALV stanowi około 85% całkowitego obciążenia obliczeniowego. Komentując wydajność systemu wizyjnego ALV, napisał Roland:

"System wizyjny okazał się bardzo wrażliwy na warunki otoczenia - jakość światła, położenie słońca, cienie i tak dalej. System działał inaczej z miesiąca na miesiąc, z dnia na dzień, a nawet z testu na test. Czasami może dokładnie zlokalizować krawędź drogi, a czasem nie. System niezawodnie odróżniał nawierzchnię drogi od brudu na barkach, ale został oszukany przez brud, który został wyśledzony na jezdni przez ciężkie pojazdy manewrujące wokół ALV. Jesienią słońce, teraz niżej na niebie, odbijało się doskonale od miriad polerowanych kamieni w samym asfalcie, wytwarzając błyszczące odbicia, które dezorientowały pojazd. Cienie z drzew stwarzały problemy, podobnie jak asfaltowe łaty z częstych napraw dróg koniecznych z powodu trudnej pogody w Kolorado i ciągłego walenia ośmiotonowego pojazdu."

DARPA anulowało program ALV w kwietniu 1988 r., Ale zainteresowanie autonomicznymi pojazdami utrzymywało się w laboratoriach badawczych, przemyśle i innych agencjach rządowych. Wśród programów wspieranych przez Departament Obrony w latach 90. znalazły się DEMO-I dla pojazdów obsługiwanych przez teleobiektyw i DEMO-II dla pojazdów autonomicznych. Ponownie, dywizja lotnicza Martina Marietty została wybrana na generalnego wykonawcę integracji. Wśród podwykonawców dostarczających podsystemy były CMU, Hughes Research Laboratories, Advanced Decision Systems, SRI, Teleos, JPL oraz uniwersytety Massachusetts i Michigan. Pojazdem wybranym do pokazów był HMMWV (skrót od High-Mobility Multipurpose Wheeled Vehicle, wyraźny humvee). W połowie lat dziewięćdziesiątych przeprowadzono serię demonstracji. Uniwersytet Cegielni Mellon opracował szereg ważnych bezzałogowych pojazdów, w tym "Terragator" i serię "Navlabs". (Później będę miał więcej do powiedzenia na temat Navlabów.) Chociaż program ALV mógł nie osiągnąć wszystkich swoich celów, można powiedzieć, że zapoczątkował erę pojazdów autonomicznych. Z każdym rokiem stają się one coraz bardziej wszechstronne i "autonomiczne".

Baza technologii AI

Mimo że głównym celem programu SC był wspomniany właśnie zestaw aplikacji, pomyślna realizacja tych aplikacji wymagała postępu w technologii, od której były zależne. Według poglądu Roberta Coopera na SC, aplikacje te "pociągnęłyby" technologię widzenia, robotyki, systemów eksperckich, rozpoznawania mowy i przetwarzania języka naturalnego. Oprócz głównych kontraktów na aplikacje, kilka zostało dopuszczonych do technologii rozwój. Oczywiście, twórcy technologii mieli być ściśle powiązani z aplikacjami, które je ciągnęły.

Wizja komputera

Ron Ohlander i (później) Robert Simpson Jr. byli menedżerami programów w DARPA IPTO odpowiedzialnymi za badania nad AI podczas dni SC. Kontynuując prace rozpoczęte wcześniej w zakresie "rozumienia obrazu", DARPA skoncentrowała się na czterech głównych obszarach wizji komputerowej, a mianowicie na modelowaniu i rozpoznawaniu obrazu, dynamicznej analizie sceny i ruchu, opartym na wizji omijaniu przeszkód i planowaniu ścieżki oraz wdrażaniu algorytmów widzenia przy użyciu równoległego architektury obliczeniowe. Chuck Thorpe, Takeo Kanade i inni z CMU skoncentrowali się szczególnie na systemach wizyjnych potrzebnych ALV. Inne ważne badania z zakresu wizji komputerowej wspierające przetwarzanie strategiczne przeprowadzono na uniwersytecie Maryland pod kierunkiem Azriela Rosenfelda, na University of Massachusetts pod kierunkiem Alana Hansona i Edwarda Risemana, w SRI pod kierunkiem Martina Fischlera oraz w laboratoriach przemysłowych. Oprócz zastosowań w robotyce, komputerowa technologia widzenia znajduje zastosowania w kartografii i interpretacji zdjęć. Jednym z wczesnych systemów foto-rozpoznania był SCORPIUS (skrót odStrategic Computing Object-Directed Reconnaissance Parallel-Processing Image-Understanding System) finansowany przez CIA i opracowany w Hughes Research Labs. Miał on wyświetlać zdjęcia lotnicze i satelitarne w celu wykrycia statków, budynków, samolotów i innych interesujących obiektów. Według Martina Fischlera z SRI, projekt pogrążył się w problemach infrastrukturalnych związanych z koniecznością korzystania z nowego komputera do przetwarzania równoległego ("Butter Fly Multiprocessor") opracowywanego w BBN. Późniejsze projekty foto-rozpoznawcze, kontynuowane po programie SC, odniosły większy sukces. Jednym z takich projektów był RADIUS (akronim od Research and Development for Image Understanding Systems) finansowany wspólnie przez DARPA i CIA. Systemy przetwarzania obrazu opracowane w SRI w ramach projektu RADIUS mogą nakładać teksturę terenu na trójwymiarowe modele części ziemi (umożliwiając na przykład symulację "przelotu" doliny Yosemite). Można je również wykorzystać do zlokalizowania budynków i innych obiektów na fotografiach, pomagając w ten sposób ludzkiemu tłumaczowi zdjęć.

Rozpoznawanie mowy i przetwarzanie języka naturalnego

Projekt pilotażowy Associate i projekty zarządzania bitwą zależały od zdolności systemów komputerowych do rozumienia ustnych żądań lub poleceń. Rozpoznawanie mowy było potrzebne Współpracownikowi Pilota, a projekty zarządzania bitwą wymagały zarówno rozpoznawania mowy, jak i rozumienia tekstu. W związku z tym DARPA sfinansowało kilka podstawowych projektów badawczych w celu udoskonalenia tych technologii. Przypomnijmy, że DARPA przerwał program badań nad rozumieniem mowy w 1976 r., ale kontynuowanie postępu w tej dziedzinie, zwłaszcza w CMU, MIT i IBM, uzasadniło jego wznowienie. Firma Texas Instruments zintegrowała pracę z ośmiu projektów badawczych dotyczących rozpoznawania mowy dla projektu Pilot's Associate. CMU zintegrowało pracę z dziewięciu projektów dla projektów Battle Management. Według Rolanda, pod koniec programu SC, systemy rozpoznawania mowy "mogły rozpoznać 10 000 słów języka naturalnego, którymi posługuje się każdy w środowisku o umiarkowanym hałasie w tle i niskim obciążeniu głośnika". Później, w CMU, Kai-Fu Lee i inni opracowali niezależny od głośników system rozpoznawania mowy SPHINX pod wsparciem DARPA. SPHINX wykorzystał HMM (ukryte modele Markowa) i informacje statystyczne o prawdopodobieństwie ciągów słów w celu ułatwienia rozpoznania. Prace nad rozpoznawaniem mowy trwają w kilku przemysłowych i uniwersyteckich laboratoriach badawczych. W CMU, żeby wymienić tylko jeden przykład, w ramach projektu SPHINX zgromadzono "zestaw dość dojrzałych [open source], światowej klasy komponentów mowy, które zapewniają podstawowy poziom technologii każdemu zainteresowanemu w tworzeniu aplikacji wykorzystujących mowę". Jednak strona internetowa projektu SourceForge ostrzega, że "... SPHINX nie jest produktem końcowym. Osoby z pewnym poziomem wiedzy specjalistycznej mogą osiągnąć świetne wyniki dzięki dostępnym tutaj wersjom SPHINX, ale naiwny użytkownik z pewnością będzie potrzebował dalszej pomocy. Innymi słowy, dostępne tutaj oprogramowanie nie jest przeznaczone dla użytkowników bez doświadczenia w mowie, ale dla użytkowników zaawansowanych ". Postęp w szybkości komputera i pamięci doprowadził do powstania kilku wysokiej jakości, dostępnych w czasie rzeczywistym, dostępnych na rynku systemów rozpoznawania mowy o umiarkowanych kosztach . Program SC sponsorował także podstawowe prace badawcze dotyczące rozumienia tekstu w ramach tego, co DARPA nazwał systemami nowej generacji. "Siedmiu wykonawców otrzymało nagrody DARPA w 1984. BBN Laboratories, USC / Information Sciences Institute, University of Pennsylvania i University of Massachusetts pracowały nad interfejsem w języku naturalnym, które mogłyby odpowiadać na wpisywane zapytania: New York University, Systems Development Corporation (później stała się częścią Unisys) i SRI International pracowały nad zrozumieniem tekstu o dowolnej formie z wiadomości wojskowych. BBN i USC - ISI koordynowały prace na interfejsach opartych początkowo na systemie IRUS BBN, który później przekształcił się w JANUS. New York University, i SDC koordynowały prace nad zrozumieniem tekstu i opracowaniem systemów PROTEUS i PUNDIT. Według Rolanda wyniki tej pracy były najbardziej obiecujące, ponownie przekraczając kamienie milowe określone w pierwotnym planie SC.…wskaźniki pierwotnego planu [zostały] przekroczone pod względem poziomu błędu i [w] wielkości słowników. "Roland kontynuuje opracowywanie: … System IRUS BBN, z zasobami 4500 słów i 1200 koncepcje domenowe otrzymały pozytywną odpowiedź w 1986 roku zainstalowany na stanowisku pomiarowym Programu zarządzania bitwą. W 1987 BBN IRUS stał się JANUS, systemem zaprojektowanym do zrozumienia niejasnych i mylących zapytań. JANUS został z powodzeniem zademonstrowany w programie zarządzania bitwą powietrzno-lądową jesienią 1987 r. Tymczasem w 1986 r. Pierwsza wersja systemu PROTEUS z powodzeniem przetworzyła raporty o wypadkach morskich (CASREPS) dotyczące awarii sprzętu

Systemy eksperckie

Ponieważ systemy ekspertowe wydawały się tak obiecujące na przełomie lat 70. i 80. ubiegłego wieku, miały one odegrać ważną rolę w programie Strategic Computing. Miały być agentami rozumującymi, które nadadzą "inteligencję" aplikacjom SC. Ronald Ohlander, menedżer programu DARPA ds. Inteligentnych systemów, szukał wykonawców badań systemów eksperckich w 1984 r. Spośród pięćdziesięciu propozycji złożonych w DARPA, Ohlander zalecił sfinansowanie sześciu z nich. Siódma została ostatecznie dodana do tej listy. Jak podaje Roland, Stanford będzie pracował nad nowymi architekturami systemów eksperckich, BBN będzie pracował nad problemem uzyskania potrzebnych rozwiązań wiedzy na temat systemów eksperckich, Ohio State University pracował nad metodami systemów eksperckich w celu wyjaśnienia swoich wniosków, a University of Massachusetts i General Electric pracowały nad technikami wnioskowania z niepewnymi informacjami. Pozostali wykonawcy to firmy rozpoczynające działalność - obie założone przez Edwarda Feigenbauma i innych badaczy ze Stanford. Jeden z nich, IntelliCorp (pierwotnie założony jako IntelliGenetics), zbudował już zainspirowaną EMYCIN powłoką systemową eksperta o nazwie KEE (akronim od Knowledge Engineering Environment). IntelliCorp zaproponował rozszerzenie KEE poprzez uaktualnienie kilku funkcji, w tym możliwość zachowania spójności bazy wiedzy w miarę dodawania lub usuwania nowej wiedzy, zdolność do racjonalnego wnioskowania, nawet jeśli nie są uzasadnione konkretnymi informacjami w bazie wiedzy oraz możliwość tworzenia planów i harmonogramów. Miałby także udogodnienia do pozyskiwania wiedzy, budowy interfejsu użytkownika i hierarchicznych opisów obiektów. IntelliCorp uzyskał kontrakt DARPA w 1984 r. Za 1 286 781,44 USD. KEE ostatecznie przekształciło się w system o nazwie OPUS. Druga firma rozpoczynająca działalność, Teknowledge, Inc., zaproponowała zbudowanie zestawu narzędzi eksperckich o nazwie ABE, który będzie wykorzystywany do budowy systemów eksperckich. ABE miało być zupełnie nowe, a więc dla DARPA było to trochę ryzykowne, ale firma miała wielu ekspertów AI zarówno w zakresie płac, jak i konsultantów. Firma Teknowledge otrzymała kontrakt DARPA na 1 823 260 USD, aby dotrzymać swoich obietnic. Zarówno KEE, jak i ABE były wykorzystywane przez wykonawców aplikacji SC, ale żadne z nich nie zapewniło inteligencji pierwotnie oczekiwanej od systemów eksperckich. Ale te oczekiwania były prawdopodobnie nierealne. W swojej ocenie systemów opartych na wiedzy (KBS) z 1994 r. Frederick Hayes-Roth i Neil Jacobstein, dwaj pionierzy w aplikacjach systemowych ekspertów, napisali "… chociaż obecna generacja technologii eksperckich i KBS nie miała nadziei na stworzenie solidnej i ogólnej inteligencji podobnej do człowieka, wielu ludzi było rozczarowanych, że tak nie było." Mimo to Hayes-Roth i Jacobstein stwierdzili, co następuje: "KBS były niezwykle skuteczne w ciągu ostatniej dekady doświadczenia przemysłowego {często zapewniając wzrost wielkości, szybkości lub wydajności o rząd wielkości. Dotarły one do każdej większej instytucji, od firm z listy Fortune 500, po małe przedsiębiorcze przedsiębiorstwa, służby wojskowe, agencje rządowe, służby zdrowia i instytucje edukacyjne. Aplikacje KBS można teraz znaleźć praktycznie w każdym ludzkim przedsięwzięciu, od muzyki po medycynę" .DART, skrót od Dynamic Analysis and Replanning Tool, był KBS, którego korzenie można przypisać badaniom AI podczas programu SC. Opracowany w BBN pomógł zaplanować przepływ sprzętu i personelu z Europy do Arabii Saudyjskiej podczas wojny w Zatoce Perskiej w 1990 roku. W rzeczywistości Victor Reis, ówczesny dyrektor DARPA, jest cytowany jako twierdzący: "Aplikacja chedulowania DART spłaciła wszystkie DARPA 30 lat inwestycji w AI w ciągu kilku miesięcy

Ocena

Co można powiedzieć o całym programie SC? Został skrytykowany zarówno przez tych, którzy sądzili, że może osiągnąć swoje cele militarne, jak i przez tych, którzy zarzucili, że tego nie uczynił. Wśród tych pierwszych specjaliści ds. Komputerowych odpowiedzialni społecznie (CPSR) mieli kilka obaw, o których mowa w jednym z ich biuletynów:

1. SCI [Strategic Computing Initiative] obiecuje określone nowe systemy uzbrojenia; pojazdy autonomiczne, takie jak czołgi robotów; "towarzysz" pilota bojowego; oraz "system zarządzania bitwą" grupy lotniskowców. Nasze obawy dotyczą propozycji komputerowych ,że badania będą oceniane na podstawie ich znaczenia dla tych konkretnych zastosowań, a nie na podstawie ogólnej wiedzy naukowej.

2. SCI promuje użycie "inteligencji" maszynowej do kontrolowania działania złożonych systemów wojskowych w nieprzewidzianych okolicznościach. Obawiamy się, że szczególnie przy wysokich stawkach sytuacje skrajnej niepewności są właśnie niewłaściwym środowiskiem dla zastosowania sztucznej inteligencji.

3. SCI promuje wojskowe zastosowanie technologii komputerowej jako rozwiązania postrzeganych problemów w obronie. Obawiamy się, że zamiast zwiększać nasze bezpieczeństwo, wcześniejsze próby osiągnięcia przewagi w nowej technologii zbrojeniowej podsyciły wyścig zbrojeń, którego nie można było przewidzieć. Ten ostatni problem jest najpoważniejszy. W ostatecznej analizie nie wierzymy, że droga do bezpieczeństwa narodowego polega na wyższości wojskowej, ani że wyższości można osiągnąć za pomocą komputerów.

Większość komentatorów wątpi, aby program SC osiągnął swój cel wprowadzając nową technologię AI do aplikacji SC. Rozwijanie rodzajów możliwości przewidzianych przez aplikacje SC wymagało wynalazków AI, a atmosfera potrzebna do wynalazków nie sprzyja ściśle zaprogramowanym pokazom kamieni milowych. Zamiast tego, jak komentuje Roland, "aplikacje wprowadziły ad-hoc, gotowe rozwiązania gotowe do spełnienia terminów demonstracyjnych". Co więcej, systemy prezentacyjne, a mianowicie ALV, Associate Pilota i te do zarządzania bitwą, nie zostały natychmiast "zakupione" przez ich oczekiwanych klientów wojskowych. Mimo to systemy te były prekursorami podobnych, mających znacznie wyższy poziom wydajności. Hojne wsparcie SC dla bazy AI "technologii "ogólnie ożywiło badania nad AI, mimo że badania nie przyniosły oczekiwanych rezultatów zintegrowanch z aplikacjami SC. Po krótkim zmniejszeniu pod koniec programu SC badania nad sztuczną inteligencją stale rozwijały się zarówno na uniwersytetach, jak iw przemyśle i nadal wytwarzają ważne nowe możliwości. Oprócz problemu łączenia wynalazku z zastosowaniem, program SC cierpiał z powodu problemów instytucjonalnych i redukcji budżetu. Często dochodziło do tarć między ludźmi DARPA a klientami wojskowymi. Ponadto wiele osób, które planowały program SC, w tym Kahn i Cooper, opuściło DARPA do końca 1985 r. Wiosną 1986 r. DARPA połączyła swoje Biuro Technik Przetwarzania Informacji z Biurem Inżynierii Aplikacji i przemianowała je na Technologię Systemów Informacyjnych Biuro (ISTO). Sukcesja dyrektorów ISTO przetrwała i pomogła wywołać wahania budżetu. Jacob Schwartz, który był sceptycznie nastawiony do niektórych podejść do sztucznej inteligencji, został dyrektorem ISTO we wrześniu 1987 r. Szybko anulował niektóre programy AI i nie odnowił innych. Następnie w 1991 roku ISTO podzieliło się na SISTO (Biuro Technologii i Inteligentnych Systemów Technologicznych) i CSTO (Biuro Technologii Systemów Komputerowych), skutecznie kończąc próby powiązania podstawowych badań z aplikacjami. Program SC stopniowo znikał z widoku. Według Rolanda nigdy nie wspomniano o tym w publicznych dokumentach ani raportach po 1989 r. Znikł on z budżetu DARPA w 1993 r. I ostatecznie został zastąpiony innymi programami, w tym jednym dla High Performance Computing (HPC). Mimo że sam program zniknął, jego osiągnięcia, podobnie jak innych projektów nowej generacji, były liczne. Postępy dokonane w latach 80. ustanowiły sztuczną inteligencję jako technologię, która była w stanie przyjąć szeroką gamę rzeczywistych światowe zastosowania. Jak opiszę w następnym rozdziale, w latach 80. i 90. wynaleziono wiele nowych technologii sztucznej inteligencji, a niektóre z nich przynajmniej zostały pobudzone przez projekty nowej generacji. Jednak zanim kontynuowałem moją z grubsza chronologiczną historię, Przejdę na chwilę do dyskusji, aby omówić kontrowersje, które kłębiły się na uboczu i w obrębie samego pola.