Języki naturalne i sceny naturalne

Widzieliśmy ważną rolę danych i technik uczenia maszynowego w destylacji i wykorzystaniu tych danych. Jeśli jeden pojedynczy temat zaczął ostatnio łączyć kilka różnych podejść do sztucznej inteligencji, od logicznych reprezentacji i rozumowania w Cyc, po decyzje i oszacowania przez sieci neuronowe, jest to ich zależność od ogromnych ilości danych. Wyjście poza problemy z zabawkami i proste łamigłówki w świecie rzeczywistym problemy wymagają rzeczywistych danych. Tu zbadamy, w jaki sposób najnowsze systemy przetwarzania języka naturalnego i wizji komputerowej wykorzystują dane reprezentatywne dla danych wejściowych, z którymi muszą sobie radzić.

Przetwarzanie języka naturalnego

Rosnące zapotrzebowanie na systemy potrafiące radzić sobie z językami pisanymi i mówionymi, wraz z nowymi osiągnięciami technicznymi, dużymi bazami danych i zwiększoną mocą obliczeniową, doprowadziły do ulepszenia systemów do wykonywania takich zadań, jak podsumowywanie fragmentów tekstu, odpowiadanie na zapytania, i tłumaczenia języków. W tej sekcji opiszę niektóre zmiany techniczne w NLP w ciągu ostatnich dwóch lub trzech dekad. Choć są imponujące, nie pozwoliły nam jeszcze uświadomić sobie nadziei Terry′ego Winograda w 1971 r., że "Porozmawiamy z [systemami komputerowymi], tak jak rozmawiamy z asystentem naukowym, bibliotekarzem lub sekretarką, i przeprowadzą nasze polecenia i przekaż nam informacje, o które prosimy ". Wiele osób twierdzi, że problemem związanym z realizacją takich systemów jest "kompletna sztuczna inteligencja", w tym sensie, że muszą one być na ogół tak inteligentne jak ludzie, być w stanie rozumować i rozwiązywać problemy, a ludzie robią te rzeczy. W każdym razie jest prawdopodobne, że takie systemy, gdy je mamy, będą wykorzystywać część lub całość technologii

Gramatyki i algorytmy parsowania

Wcześniej opisano niektóre podstawowe idee teorii językoznawstwa. Na przykład wspomniano, że zdania można analizować pod kątem ich struktury składniowej przy użyciu gramatyk bezkontekstowych (CFG). Wspomniano również o bardziej złożonych gramatykach, takich jak gramatyki skończonych klauzul (DCG), gramatyki systemowe, gramatyki sieci przejściowej i DIAGRAM. Systemy wykorzystujące gramatykę do analizy zdań w języku naturalnym muszą używać algorytmów parsowania do wyszukiwania wśród kandydujących "drzew parsujących" w celu znalezienia jednego lub więcej niż jednego zdania wejściowego. W przypadku realistycznych gramatyk, które "akceptują" te ciągi słów, które uważamy za legalne zdania i odrzucają te ciągi, które uważamy za nonsensy, często zdarza się, że istnieje wiele możliwych analiz, z których każda ma inne znaczenie. Wybór jednego z "najlepszych" drzew parsowania spośród nich wszystkich następnie zależy od analiz semantycznych i pragmatycznych, które uwzględniają kontekst, w którym występuje zdanie, i zdrową wiedzę świata. Jako humorystyczny przykład tego, jak można wpaść w kłopoty, nie biorąc pod uwagę zdrowego rozsądku, Daniel Jurafsky i James Martin cytują zdanie z filmu Animal Crackers z 1930 r .: Groucho Marks mówi: "Pewnego ranka zastrzeliłem słonia w mojej piżamie Nie wiem, jak dostał się do mojej piżamy." Prace nad przetwarzaniem języka naturalnego trwają w celu poznania nowych i bardziej złożonych gramatyk, algorytmów parsowania i technik przetwarzania semantycznego. Nowsze gramatyki potrafią skuteczniej radzić sobie z większymi podzbiorami języka angielskiego, a wiele z nich obsługuje języki inne niż angielski. Niektóre przykłady to leksykalne gramatyki funkcjonalne (LFG), gramatyki przylegające do drzew (TAG), gramatyki zależności, gramatyki struktury fraz kierowanych głowami (HPSG) 4, gramatyka rządowa i wiążąca oraz gramatyki kategorialne. Wprowadzono również wiele ulepszeń w algorytmach parsowania. W przypadku użycia z realistycznymi gramatykami pierwsze wyszukiwanie szerokości (metodą "od dołu do góry" lub "z góry na dół") szybko wyczerpuje miejsce do przechowywania. Głębokość cofania - pierwsze wyszukiwanie, choć bardziej oszczędne w stosunku do pamięci, wiąże się z ryzykiem, że trzeba będzie wykonać większość z wyszukiwania, jeśli wyszukiwanie ma problemy i musi cofnąć się do wcześniejszych części zdania. Aby uniknąć konieczności ponownej analizy części zdania po rozwinięciu, opracowano parsery wykorzystujące wykresy i inne konstrukcje, w których można przechowywać, w celu ewentualnego ponownego użycia, już obliczone parsy segmentów zdań. Martin Kay opracował pierwszy parser wykresów. Inne parsery wykorzystujące struktury podobne do wykresów to parser Earleya (opracowany przez Jaya Earleya) i algorytm Cocke {Younger - Kasami (CYK). Nowoczesne parsery używają jednej lub drugiej wersji programowania dynamicznego, techniki o której wspomniałem wcześniej. Umożliwia zapisywanie wyników pośrednich. Wymieniam te przykłady gramatyk i parserów, nie próbując opisów (które są dość techniczne), aby zilustrować zakres i głębię aktywności w tych aspektach NLP. Badania i aplikacje w zakresie przetwarzania języka naturalnego przyniosły znaczne korzyści dzięki posiadaniu dużych plików tekstowych. Takie pliki zawierają miliony zdań i istnieją w wielu językach. Obejmują artykuły w gazetach, teksty literackie i inne materiały. Duże pliki zdań nazywane są ciałami (liczba mnoga korpusu, co oznacza ciało). Zdania z tych plików mogą być analizowane i opatrzone adnotacjami przez ludzi, czasami wspomagane algorytmami parsowania, a analizy mogą być przechowywane wraz z powiązanymi zdaniami w strukturach zwanych "bankami drzew". Wybitnymi przykładami są te opracowane na University of Pennsylvania, zwane "Penn Treebanks". Banki drzew wraz z ich adnotacjami mogą być użyte do wywołania silniejszych gramatyk obejmujących zawarte w nich zdania. Jak zwykle, im większy jest bank drzew, tym lepsza jest indukowana gramatyka. W tym procesie wykorzystywane są techniki uczenia maszynowego oparte na statystykach, co prowadzi mnie do następnego tematu

Statystyczny NLP

A. Bezkontekstowe reguły z prawdopodobieństwami

Jak wspomniałem wcześniej, gramatyka powinna rozróżniać zdania, które są akceptowane w języku, od zdań, które nie są. Ale, jak zauważają Christopher Manning i Hinrich Schze, "po prostu nie jest możliwe dokładne i pełne scharakteryzowanie dobrze sformułowanych wypowiedzi, które czynią je czysto od wszystkich innych sekwencji słów, które są uważane za wypowiedzi źle sformułowane. Jest tak, ponieważ ludzie zawsze rozciągają i naginają "reguły", aby zaspokoić swoje potrzeby komunikacyjne ". Fakt ten został zauważony dość wcześnie w nauce języka. W swojej książce z 1921 roku lingwista i antropolog Edward Sapir napisał: "Niestety lub na szczęście żaden język nie jest spójny tyranicznie. Wszystkie gramatyki przeciekają". Sapir miał oczywiście na myśli, że każda gramatyka, bez względu na to, jak złożona, zaakceptuje niektóre zdania, których ludzie nie mogą zaakceptować, i odrzuci niektóre, które ludzie będą akceptować. Eugene Charniak, jeden z pierwszych badaczy AI, który rozpoznał tę trudność, zaproponował, aby analizy składniowe były kwalifikowane przez prawdopodobieństwa. Niektóre zdania są "prawdopodobnie" ok, a niektóre prawdopodobnie nie, a pomiędzy nimi są wszystkie gradacje. Bezpośrednią zaletą takiego podejścia jest to, że prawdopodobieństwo analizy może zostać użyte do wyboru spośród alternatywnych analiz dla dwuznacznych zdań. Rozważmy na przykład dwa alternatywne sposoby odczytania zdania w stylu Groucho "John zastrzelił słonie w piżamie":

• John (będąc w piżamie) strzelał do słoni

• John strzelał do słoni (które były w piżamie).

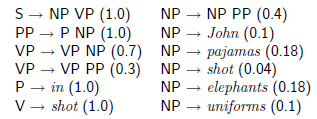

Każda z tych interpretacji zdania ma inne drzewo analizy. Czy istnieje sposób, aby uznać jeden z nich za bardziej prawdopodobny od drugiego? W 1969 r. teoretyk automatów Taylor L. Booth zaproponował odmianę gramatyk bezkontekstowych, która przypisuje prawdopodobieństwa regułom stosowanym do definiowania gramatyki. Takie gramatyki nazywane są "probabilistycznymi gramatykami bezkontekstowymi" (PCFG). Wykorzystam następującą bardzo prostą (i dość niekompletną) gramatykę, aby zilustrować ten pomysł:

Liczba w nawiasach następujących po regule reprezentuje prawdopodobieństwo tej reguły. Tak więc, na przykład, zgodnie z tą gramatyką, prawdopodobieństwo wynosi 0,18, że fraza rzeczownikowa w zdaniu jest słowem "słonie". Ponieważ fraza rzeczownikowa musi być czymś, suma wszystkich prawdopodobieństw rzeczownikowych wynosi 1,0

B. Prawdopodobieństwa parsowania drzew

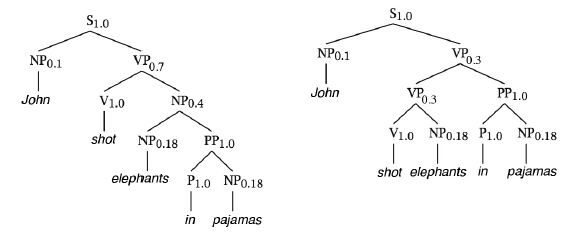

Zakładając, że prawdopodobieństwa tych reguł są niezależne (bardzo niewłaściwe założenie dla realistycznych gramatyk), możemy obliczyć prawdopodobieństwo parsowania drzewa, biorąc iloczyn prawdopodobieństwa wszystkich reguł zastosowanych w drzewie. Dwa drzewa parsowania dla tego zdania pokazano na rysunku

Ta po prawej, w której to John jest w piżamie podczas strzelania, wydaje się być bardziej odpowiednia w większości ustawień innych niż, być może, bajki. Liczby indeksujące każdy termin gramatyczny w drzewach są prawdopodobieństwami odpowiednich reguł. Drzewo analizy po lewej stronie ma prawdopodobieństwo

Prob lewy = 1: 0 x 0: 1 x 0: 7 x 1: 0 x 0: 4 x 0:18 x 1: 0 x 1: 0 0:18 = 0: 0009072:

Drzewo analizy po prawej stronie ma prawdopodobieństwo

Prob prawy = 1: 0 x 0: 1 x 0: 3 x 0: 7 x 1: 0 x 0:18 x 1: 0 x 1: 0 x 0:18 = 0: 0006804:

Preferowany byłby zatem ten po lewej. (Cóż, nie chciałbym mówić o strzelaniu do słoni. Miałem na myśli słonie z kreskówek, które miały na sobie piżamę.) Innym ważnym aspektem PCFG jest to, że można je wykorzystać do przewidywania ogólnego prawdopodobieństwa zdania. To znaczy, jak prawdopodobne jest zdanie: "John zastrzelił słonie w piżamie"? Możemy obliczyć to prawdopodobieństwo, po prostu dodając prawdopodobieństwa wszystkich możliwych parów tego zdania. W tym przypadku dodajemy dwa prawdopodobieństwa, aby uzyskać 0: 0015876. Prawdopodobieństwa w tym przykładzie zostały opracowane wyłącznie w celach ilustracyjnych i nie należy ich traktować poważnie. Bardziej realistyczne wartości prawdopodobieństwa byłyby oparte na znacznie większej gramatyce i korpusie zdań, co prowadzi do następnego tematu.

C. Nauka PCFG

Jak uzyskać wartości prawdopodobieństwa reguł w PCFG? W szczególności, w jaki sposób można uzyskać wartości, które odpowiednio modelują rzeczywiste zdania? Bank drzew z adnotacjami zapewnia sposób uzyskania wartości odpowiednich dla zdań w banku drzew, ponieważ każde z jego zdań ma powiązane drzewo analizy. Drzewa parsowania używają reguł w całej formie l → r, gdzie l jest lewą stroną reguły (np. VP), a r jest prawą stroną reguły (np. VP NP). Aby uzyskać wartość prawdopodobieństwa dla reguły l → r, zliczamy, ile razy ta sama reguła występuje w banku drzew i dzielimy tę liczbę przez liczbę wystąpień l. Tak otrzymany PCFG można następnie wykorzystać aby analizować nowe zdania. PCFG można również wygenerować bez banku drzew, jeśli ma się zwykły (nieprobabilistyczny) bez kontekstowy analizator składni, który można zastosować do zbioru zdań. Jednak w odróżnieniu od banku drzew, każde zdanie w korpusie będzie miało wiele parsów, a niektóre z nich zawierają wiele. Jak licząc występowanie reguł, w jaki sposób możemy uniknąć przeważania reguł w tych zdaniach wieloma parsami? Oto metoda, która wydaje się działać dobrze:

1. Przekształć oryginalny CGF w PCGF z jednakowymi prawdopodobieństwami reguł.

2. Analizuj zdania za pomocą tego PCFG, obliczając prawdopodobieństwo dla każdej niejednoznacznej analizy.

3. Policz reguły w każdym parsowaniu dla każdego zdania i zważ liczbę według prawdopodobieństwa tego parsowania.

4. Użyj tych ważonych liczb do obliczenia nowych prawdopodobieństw dla reguł, a tym samym nowego PCFG.

5. Powtarzaj ten proces, aż prawdopodobieństwo reguły przestanie się zmieniać (co ostatecznie nastąpi).

Ta procedura jest wersją algorytmu często używanego w uczeniu maszynowym, zwanym algorytmem Expectation Maximization (EM). Aby uwzględnić bezkontekstowe aspekty struktury zdania i dla szczegółowej informacji o konkretnych słowach, praktyczne aplikacje zwykle wykorzystują PCFG, które zostały rozszerzone na różne sposoby. Opracowano kilka parserów dla wersji PCFG. Nie mogę się oprzeć wspominaniu o jednym opartym na algorytmie wyszukiwania A*. Przedstawiając to, Dan Klein i Christopher D. Manning napisali :

"Średnio długie wyroki banku drzew Penn, nasze najbardziej szczegółowe oszacowanie [do zastosowania jako funkcja heurystyczna] zmniejsza sumę liczb przetworzonych krawędzi [przy użyciu wyszukiwania A] do mniej niż 3% wymagane przez wyczerpujące parsowanie i prostsze oszacowanie, które wymaga mniej niż minutę wstępnego obliczenia, zmniejsza pracę do mniej niż 5%."

Opracowano kilka innych statystycznych metod analizy zdań. Wymienię tylko kilka z nich. Rens Bod i współpracownicy z Uniwersytetu w Amsterdamie opracowali technikę, którą nazywają "analizą danych zorientowaną na dane" (DOP), która opiera się na idei, że "percepcja i produkcja języka ludzkiego działa raczej w oparciu o konkretne doświadczenia językowe niż abstrakcyjne reguły gramatyczne ". Metody statystyczne poprawiły także gramatyczne funkcje leksykalne (LFG), zarówno przy użyciu pomysłów DOP, jak i dzięki pracy Josefa van Genabitha i jego grupy z Dublin City University nad nauką gramatyki LFG na podstawie adnotowanych danych banku drzew. Wreszcie Ron Kaplan i jego grupa w komercyjnej firmie zajmującej się wyszukiwaniem języków naturalnych, Powerset (obecnie część firmy Microsoft), próbują nauczyć się przypisywać porządki prawdopodobieństwa do wielu drzew parsowania zdania, które są tworzone przez analizator składni ręcznie ( zamiast wyuczonej) gramatyki. Inne zastosowania statystyk w przetwarzaniu języka naturalnego obejmują wykorzystywanie danych o tym, jak często pewne kombinacje słów występują w różnych źródłach tekstu. Takie kombinacje nazywane są "n-gramami". Na przykład sekwencja dwóch słów, na przykład "właśnie teraz", to 2-gram, a sekwencja pięciu słów, na przykład "odłóż na półkę", to 5-gram. Używając hasła "nie ma danych takich jak więcej danych" ,Google przeanalizował na przykład zbiór bilionów słów z publicznych stron internetowych, aby opublikować "liczby dla wszystkich 1 176 470 663 pięcioznakowych sekwencji, które pojawiają się co najmniej 40 razy".

Podsumowując wpływ zastosowania metod statystycznych w NLP Manning i Schutze napisali: "Istotnie, większość entuzjazmu w zakresie metod statystycznych w przetwarzaniu języka naturalnego wynika z tego, że ludzie widzą perspektywę metod statystycznych zapewniających praktyczne rozwiązania rzeczywistych problemów, które wymykały się przy użyciu tradycyjne metody NLP ". Wspominają nawet o niektórych możliwych nowych nazwach dla eld, takich jak "Technologia językowa" lub "Inżynieria językowa" zamiast NLP

Widzenie komputerowe

Omówim kilka reprezentatywnych próbek najnowszych prac w dziedzinie widzenia komputerowego, z których większość opiera się na podstawowych technikach przetwarzania obrazu opisanych wcześniej. W rzeczywistości ten dług z poprzedniej pracy jest uznawany przez większość badaczy, tak jak w następującym fragmencie ostatniego artykułu: Warto zauważyć, że wiele z tych, które są uważane za nowoczesne pomysły w widzeniu komputerowym - deskryptory regionu i granic, superpiksele, łącząc dół-górę i odgórne przetwarzanie, formułowanie bayesowskie, wybór funkcji itp. -były znane czteryy dekady temu! … Wydaje się jednak, że pierwsi pionierzy po prostu wyprzedzili swój czas. Nie mieli wyboru, musieli polegać na heurystyce, ponieważ brakowało im dużych ilości danych i zasobów obliczeniowych, aby poznać relacje rządzące strukturą naszego świata wizualnego. Postęp metod uczenia się w ostatnim dziesięcioleciu daje nową nadzieję na pełne zrozumienie scen. Teraz mamy potrzebne dane i zasoby obliczeniowe. Poza tym wizja komputerowa skorzystała na wkładach kilku innych osób, w tym optyki, matematyki, grafiki komputerowej, elektrotechniki, fizyki, neuronauki i statystyki. Wszystkie te dyscypliny nadal dostarczają pomysłów i technik, ale jedna z nich zaczęła dominować, a mianowicie uczenie maszynowe. Niektóre osoby rozróżniają "widzenie komputerowe" i "widzenie maszynowe" - łącząc widzenie komputerowe głównie z robotyką i wykorzystując widzenie maszynowe do wyłącznie tej aplikacji i wielu innych. Ponieważ ostatecznie chcemy, aby roboty były zaangażowane w większość tych aplikacji, nie sądzę, aby to rozróżnienie było bardzo przydatne, dlatego nadal będę odnosić się do całego pola jako do widzenia komputerowego. Kolejne rozróżnienie polega na tym, co z jednej strony nazywa się "wizją analizy sceny" i "wizją celową (lub aktywną)". Podejście oparte na analizie sceny kierowało wieloma badaniami dotyczącymi widzenia od najwcześniejszych dni. Ten pogląd utrzymywał, że celem widzenia komputerowego było przekształcenie dwuwymiarowego obrazu w opis trójwymiarowej sceny. Na przykład system wizyjny dla MIT "Copy Demo" skonstruował trójwymiarowy model układu klocków zabawek. Natomiast niektórzy badacze zwrócili uwagę, że celem widzenia było dostarczenie tylko i wyłącznie tych konkretnych informacji potrzebnych do sterowania silnikiem. Widzimy to podejście zastosowane na przykład w różnych procedurach widzenia używanych przez Shakeya. Zamiast skonstruować kompletny model swojego świata wizualnego, Shakey użył widzenia, aby przekazać mu informacje potrzebne do prowadzenia działań motorycznych i planowania. Ten rodzaj widzenia celowego "jest zwykle mniej wymagający od obliczeniowych wyników obliczeniowych, niż byłaby pełna analiza sceny. Ludzie, którzy badają wizualne procesy zwierząt (w tym ludzi), również spierali się o te dwa podejścia. David Marr, który był zainteresowany modelowaniem człowieka procesy wizualne opowiadały się za podejściem do analizy sceny. Jednak ludzie, którzy analizowali percepcję wzrokową u żaby, zauważyli, że jej system wizualny został zorganizowany bardziej celowo, na przykład w celu łapania owadów. Neurobiolog komputerowy Terrence Sejnowski (ten sam Sejnowski, który pracował nad NETtalk) i koledzy opisują dowody biologiczne i psychologiczne, że wizja człowieka jest celowa, a nie rekonstrukcyjna, a którą nazywają "czystym widzeniem". Do czego służy widzenie? Czy naprawdę konieczna jest idealna wewnętrzna rekreacja trójwymiarowego świata? Biologiczne i obliczeniowe odpowiedzi na te pytania prowadzą do koncepcji widzenie zupełnie inna niż czyste widzenie. Interaktywne widzenie, jak nakreślono [w tym artykule], obejmuje widzenie z innymi układami sensorycznymi jako partnerami pomagającymi w kierowaniu działaniami. Kiedy patrzę na wiele komputerowych systemów wizyjnych wyprodukowanych w ciągu ostatnich dwudziestu lat, widzę oba rodzaje. Istnieją systemy, które są skuteczne w prowadzeniu pojazdów autonomicznych po drogach (zwracając uwagę tylko na jezdnię i inne pojazdy na drodze, nie analizując ani nawet nie wiedząc o domach po drodze, które - choć mogą znajdować się na miejscu - są nieistotne do zadania prowadzenia pojazdu. Istnieją również systemy analizujące zdjęcia lub konstruujące trójwymiarowe modele budynków i innych obiektów w nich zawartych. Ponadto istnieją systemy, które mają aspekty obu podejść

Odzyskiwanie informacji o powierzchni i głębokości

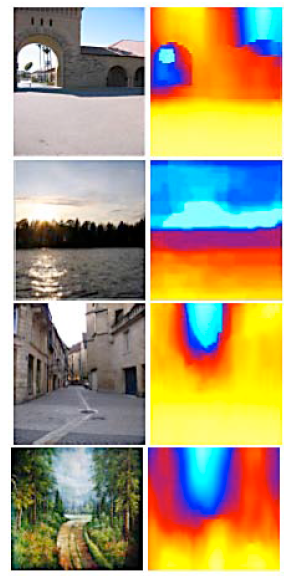

Derek Hoiem, Alexei Efros i Martial Hebert z Robotics Institute na Carnegie Mellon University opracowali program, który był w stanie sklasyfikować segmenty jednego obrazu jako należące do powierzchni różnego typu i orientacji. Chociaż te klasyfikacje nie stanowią trójwymiarowego modelu sceny, która dała początek obrazowi, dają one informacje o ważnych właściwościach fizycznych sceny, podobnie jak robi to szkic Davida Marra 2 1/2-D. Na przykład takie informacje, które mogą być przydatne dla robota, który musi nawigować i rozpoznawać obiekty w scenie. W ich pracy wykorzystano zdjęcia obiektów na wolnym powietrzu, takich jak "lasy, miasta, drogi, plaże, jeziora itp." wykonano w różnych warunkach "(śnieżny, słoneczny, pochmurny, zmierzch)". Ich program podzielił regiony obrazu na jedną z trzech głównych kategorii powierzchni: "wsparcie", "pionowe" lub "niebo". Jak autorzy określają te kategorie: "Powierzchnie podparcia są w przybliżeniu równoległe do podłoża i mogą potencjalnie podpierać solidny obiekt. Przykłady obejmują nawierzchnie dróg, trawniki, ścieżki gruntu, jeziora i blaty stołu. Powierzchnie pionowe są zbyt twardymi powierzchniami do wspierania obiektu, takiego jak ściany, skały, krawężniki, ludzie, drzewa lub krowy. Niebo to po prostu obszar obrazu odpowiadający otwartemu powietrzu i chmurom." Aby uzasadnić tę klasyfikację, autorzy podkreślają, że w 300 obrazach zebranych za pomocą wyszukiwania obrazów Google "ponad 97% pikseli należy do poziomych (pomocniczych), prawie pionowych powierzchni lub nieba" (ustalonych przez człowieka) obrazów). Program dodatkowo zaklasyfikował każdą pionową powierzchnię do jednej z następujących podklas: "płaskie powierzchnie zwrócone w stronę" lewej "," środkowej "lub" prawej " przeglądarki oraz powierzchnie niepłaskie, które są albo" porowate ", albo" stałe ". " Płaskie powierzchnie obejmują ściany budynków, ściany klifu i inne powierzchnie pionowe, które są w przybliżeniu płaskie. Porowate powierzchnie to te, które nie mają stałej ciągłej powierzchni. Liście drzew, krzewy, przewody telefoniczne i ogrodzenia ogniw są przykładami porowatych powierzchni. Powierzchnie pełne to niepłaskie powierzchnie pionowe, które mają stałą ciągłą powierzchnię, w tym samochody, ludzi, piłki plażowe i pnie drzew ".

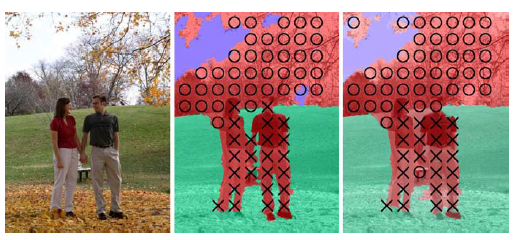

Ich program nauczył się tworzyć te klasyfikacje (i podklasy) za pomocą zestawu szkoleniowego zawierającego 300 obrazów Google. Grupy sąsiadujących pikseli na każdym obrazie szkoleniowym w tym zestawie zostały złożone w prawie jednolite regiony, zwane "superpikselami", na podstawie podobieństwa kolorów i intensywności. Następnie każdemu superpikselowi (nużąco!) Ręcznie przypisywano klasyfikację i podklasę. Suprpiksele zostały następnie pogrupowane w większe regiony zwane segmentami, które odziedziczyły po nich klasyfikacje składowe superpikseli. Odtąd matematyka staje się bardziej złożona, ale w gruncie rzeczy proces uczenia się skonstruował drzewo decyzyjne, które może odpowiednio pasować do ręcznie sklasyfikowanych regionów na obrazach zestawu treningowego. Wyuczone drzewo decyzyjne można następnie wykorzystać do klasyfikacji regionów dowolnych obrazów. Węzły drzewa decyzyjnego były oparte na cechach pikseli i segmentów obejmujących lokalizację, kolor, teksturę i perspektywę, z których wszystkie można było obliczyć przy użyciu wcześniej wynalezionych technik. Chociaż nie są w pełni reprezentatywne dla ogólnych wyników, obrazy na ryc. 30.3 wskazują, jak dobrze ich program przetrwał. Na zdjęciach poniżej, zielony oznacza powierzchnię podparcia, czerwony oznacza powierzchnię pionową, a niebieski oznacza niebo. Podklasy powierzchni pionowych są oznaczone strzałkami w lewo dla płaszczyzn skierowanych w lewo, strzałkami w górę dla płaszczyzn skierowanych do środka i strzałkami w prawo dla płaszczyzn skierowanych w prawo, "O" dla powierzchni porowatych i "X" dla powierzchni stałych.

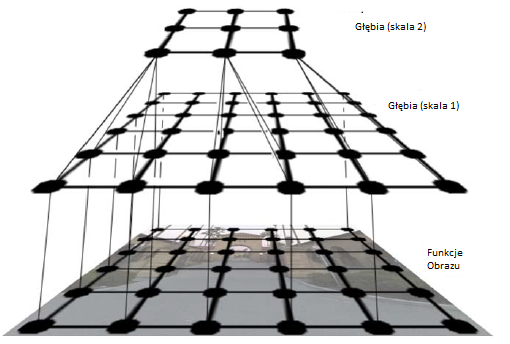

Profesor ze Stanford Andrew Ng i jego uczniowie poszli dalej w wyodrębnianiue rzeczywistych informacji o głębokości i informacji o strukturze sceny z obrazów monokularowych. Informacje o głębokości "prawdy gruntu" dla zestawu obrazów treningowych są najpierw gromadzone przez trójwymiarowy skaner laserowy. Algorytm uczenia się próbuje dopasować swoje szacunki głębokości do głębokości rzeczywistej przy użyciu kilku funkcji obrazu, takich jak zmiany tekstury, gradienty tekstury, kolor i informacje o okluzji. Ponieważ informacje o głębokości bliskich obiektów są rejestrowane w większych skalach niż w przypadku odległych obiektów, operacje są wyodrębniane w wielu skalach obrazu. Proces uczenia trenuje hierarchiczną, wieloskalową losową sieć Markowa do reprezentowania zależności między głębią łatki obrazu a głębią sąsiednich łat. Rysunek poniżej jest skróconą ilustracją dwóch z trzech poziomów takiej sieci.

Rysunek poniżej pokazuje niektóre obrazy pobrane z Internetu wraz z powiązanymi "mapami głębi" (o różnych głębokościach wskazanymi przez różne kolory) przewidywanymi przez ich system. Ashutosh Saxena i Andrew Ng nadal doskonalą te techniki.

Śledzenie ruchomych obiektów

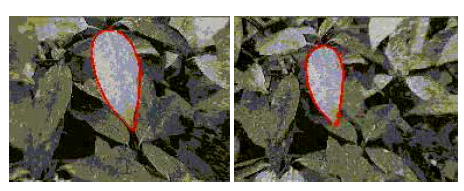

Jeśli systemy wizyjne mają działać na naturalnych scenach w prawdziwym świecie, jedną z rzeczy, z którymi będą musieli sobie poradzić, są ruchome obiekty. Kilku badaczy pracowało nad problemem wizualnego śledzenia obiektów, a niektóre z najwcześniejszych prac pochodzą z końca lat siedemdziesiątych. Jednym z przykładów, które wykorzystam do wyjaśnienia niektórych zastosowanych metod, są prace Michaela Isarda i Andrew Blake′a na uniwersytecie w Oxfordzie. Opracowali algorytm o nazwie CONDENSATION (do propagacji gęstości warunkowej) do śledzenia poruszających się obiektów. Algorytm jest w stanie "śledzić kontury i cechy obiektów pierwszego planu, zamodelowanych jako krzywe, gdy poruszają się w znacznym bałaganie, i wykonywać to z prędkością klatek wideo lub w ich pobliżu. Oto, w skrócie, jak ich system działa na jednym z ich kilku przykładów - filmie liścia na krzaku wiejącym na wietrze na tle podobnych liści. Rozpoczyna się od początkowej klatki filmu, w której dany liść interesujący jest rysowany ręcznie krzywa jak w lewej części rysunku

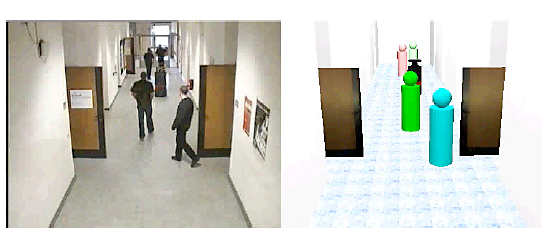

Śledzenie konturu liścia podczas ruchu wymaga wiedzy o dynamice liścia. To znaczy, biorąc pod uwagę jego pozycję i kształt na obrazie w jednym momencie, jaką pozycję i kształt może mieć w następnym momencie? A w kolejnych chwilach? My nie jesteśmy pewni, ale możemy użyć dynamicznych sieci bayesowskich (DBN), odpowiednio zmodyfikowanych w celu użycia ciągłych rozkładów prawdopodobieństwa zamiast rozkładów prawdopodobieństwa względem zmiennych dyskretnych, aby dokonać oszacowań. Wymagane prawdopodobieństwa są szacowane na podstawie procesu uczenia się i są one stopniowo określane przez obserwację liścia podczas jego ruchu. Jednak, aby to zaobserwować, musimy to wyśledzić, a to wymaga znajomości prawdopodobieństwa - problemu "jaja kurzego i jaja", z którym Isard i Blake byli w stanie sobie poradzić. W miarę upływu czasu prawdopodobieństwo położenia i kształtu liścia na obrazie rozprasza się, powodując coraz większą niepewność co do konturu liścia. Ale robimy obserwacje {przyjmując nowy obraz za każdym razem. Obserwacje te, jako że same w sobie są nieprecyzyjne, dostarczają również prawdopodobieństwa (przy użyciu reguły Bayesa) dotyczące położenia i kształtu liścia. Te ostatnie prawdopodobieństwa pomagają wyostrzyć di przy użyciu tych o dynamice liścia {do tego stopnia, że można dokonać dość dokładnych oszacowań. Na przykład, w dwudziestu krokach później (0: 5 s), system zgaduje na zarysie pokazanym po prawej stronie rysunku powyżej. Isard i Blake używają szeregu skomplikowanych technologii, aby to wszystko osiągnąć. Jednym z problemów jest to, jak reprezentować funkcje prawdopodobieństwa dla dynamiki liścia i jak przenosić tę reprezentację z jednego kroku czasowego na drugi. Przyjęli technikę zwaną "filtrowaniem cząstek", która reprezentuje prawdopodobieństwo krzywej zarysu przez duży zestaw ważonych próbek, zwanych cząsteczkami, konturów. Na każdym etapie grupa cząstek jest przenoszona do następnego etapu, a cała partia jest reprezentowana jako funkcja prawdopodobieństwa. Filtrowanie cząstek jest intensywnie wykorzystywane do przetwarzania obrazu i innych problemów z percepcją. Użyłem pracy Isarda {Blake'a do zilustrowania śledzenia obiektów, ale jest wiele innych projektów. Dieter Fox i współpracownicy z University of Washington Robotics i State Estimation Lab używali filtrowania cząstek w wielu zastosowaniach. Imponującą prezentacją jest film pokazujący jednoczesne śledzenie zmieniającej się liczby osób za pomocą dalmierzy laserowych z ruchomym robotem. Typowy zrzut ekranu pokazano poniżej

Zdjęcie po lewej stronie (nieużywane przez robota; jest tylko dla nas) pokazuje rzeczywiste położenie ludzi i robota. Zdjęcie po prawej pokazuje obliczone lokalizacje ludzi i robota, reprezentowane przez obiekty graficzne. Ta aplikacja wykorzystuje rozszerzenie do filtrowania cząstek, które autorzy nazywają "opartymi na próbach wspólnymi probabilistycznymi powiązaniami danych. Grupa kierowana przez Ernsta D. Dickmannsa w Institut fur Systemdynamik und Flugmechanik na Universit at der Bundeswehr w Monachium w Niemczech pracuje nad systemami wizyjnymi i sterującymi dla samochodów bez kierowców od późnych lat siedemdziesiątych. Ich dynamiczne systemy wizyjne są w stanie wykrywać i śledzić sąsiednie pojazdy za pomocą przestrzenno-czasowych modeli ruchu wyrzutowego, co nazywają podejściem "4-D". Być może są pierwszą grupą, która korzysta z filtrowania Kalmana do śledzenia obiektów wizualnych. ich praca została nazwana pierwszym znaczącym zastosowaniem wizji komputerowej w świecie rzeczywistym ". Zainstalowane w różnych pojazdach Mercedes-Benz, ich systemy wizji i kontroli były w stanie jechać autonomicznie na duże odległości, zmieniając biegi i wyprzedzając wolniejsze pojazdy. W 1995 roku ich pojazd VaMP (Mercedes-Benz 500 SEL) przejechał 1758 km z Monachium do Odense w Danii i z powrotem z prędkością przekraczającą 175 km / h. Około 95% przejazdu odbyło się w pełni autonomicznie, w sumie 400 manewrów zmiany pasa. Niektóre dodatkowe szczegóły na temat ich autonomicznych pojazdów i projektów wizyjnych można znaleźć w książce Dickmanna na temat "Dynamic Vision". Kosmos nie pozwala na opisanie kilku innych projektów śledzenia obiektów, ale wspomnę jeszcze o dwóch. Jitendra Malik kieruje grupą wizji na Uniwersytecie Kalifornijskim w Berkeley, gdzie przeprowadzono badania nad śledzeniem obiektów (wraz z innymi pracami nad wizją) W grupie wizji na Uniwersytecie w Leeds w Wielkiej Brytanii prace nad śledzeniem piłkarzy i samochodów. Innym celem w Leeds jest poprawa dokładności śledzenia obiektów poprzez rozumowanie o "podstawowych ograniczeniach przestrzenno-czasowej ciągłości obiektów

Modele hierarchiczne

Jeden z potencjalnie najbardziej obiecujących rozwiązań w dziedzinie widzenia komputerowego (a może nawet całej sztucznej inteligencji) dotyczy modeli hierarchicznych. Istnieją różne wersje tych modeli i różne sposoby ich budowy, ale jeśli odstąpimy wystarczająco od szczegółów, mają one podobne struktury i funkcje. Po pierwsze, nieprzetworzone piksele są agregowane przestrzennie (a w niektórych systemach czasowo), aby utworzyć grupy wyższego poziomu. Te grupy mogą tworzyć małe krawędzie lub narożniki lub inne prymitywne komponenty odpowiednie dla rodzajów przetwarzanych obrazów. Na kolejnym poziomie hierarchii grupy pierwszego poziomu są ponownie agregowane do nieco wyższego poziomu i tak dalej, dopóki, powiedzmy, rozpoznawalne obiekty na obrazie nie będą reprezentowane na najwyższym poziomie. Wiele pomysłów używanych w tych systemach nawiązuje do niektórych cech wcześniejszych systemów (takich jak Pandemonium, Neocognitron, architektury tablic, systemy rozpoznawania mowy i sieci rekurencyjne PDP), ale wiele nowszych systemów łączy i rozszerza te funkcje na różne sposoby to nie indywidualny wcześniejszy system. W szczególności pozwól mi wspomnieć o następujących kwestiach:

1. Agregacje na różnych poziomach są poznawane przy użyciu ogromnych zestawów danych - nieprzeznaczonych ręcznie. W niektórych systemach uczenie się jest "bez nadzoru" {polegające na ciągłości wyglądu obiektu w czasowym strumieniu obrazów w celu dostarczenia informacji o tożsamościach obiektów.

2. Występowania agregacji na każdym poziomie są równoważone prawdopodobieństwami za pomocą probabilistycznych modeli graficznych (takich jak pola losowe Markowa) zapewniających główne mechanizmy reprezentacyjne i obliczeniowe.

3. Prawdopodobieństwa agregacji na jednym poziomie mogą wpływać nie tylko na prawdopodobieństwa agregacji na wyższych poziomach, ale także na prawdopodobieństwa agregacji na tym samym i na niższych poziomach. To znaczy, w przeciwieństwie do Pandemonium i sieci neuronowych ze sprzężeniem zwrotnym, w tych nowszych systemach istnieją połączenia "wsteczne" od wyższych poziomów do niższych poziomów. Te zacofane połączenia pozwalają systemom przewidywać, co prawdopodobnie było na scenie, nawet jeśli mogło być zasłonięte lub nieobecne na obrazie.

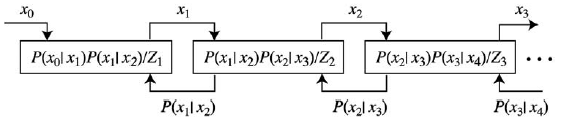

Kilku naukowców było zaangażowanych w rozwój modeli hierarchicznych. Niektóre motywowane są głównie próbami modelowania mechanizmów przechowywania i wnioskowania w korze wzrokowej ludzi i naczelnych. Mimo to ich modele są jednak dość interesujące dla ludzi AI, łącząc w tym czasie spostrzeżenia i dowody z neuronauki z dość skomplikowanym aparatem obliczeniowym - w tym hierarchicznymi modelami graficznymi i technikami statystycznego próbkowania. Inni używają modeli hierarchicznych i zaawansowanych metod obliczeniowych, nie zwracając szczególnej uwagi na ich biologię i wiarygodność budowy silniejszych systemów wizyjnych. Tai Sing Lee i Davida Mumford , proponuja hierarchię przetwarzania warstw kory wzrokowej , które można modelować jak poniżej

W modelu Lee-Mumforda (opartym częściowo na teorii wzoru , pracy Ulfa Grenander), obserwacje "od dołu do góry" przychodzące z lewej strony są zintegrowane z hipotezami "z góry na dół" sformułowanymi po prawej stronie. Na diagramie pomyśl o x0 jako reprezentującym reprezentację obrazu jako tablicę pikseli. Pomyśl o x1 jako bardziej abstrakcyjnej reprezentacji obrazu, powiedzmy w kategoriach funkcji takich jak krótkie segmenty linii. Gdy przechodzimy o jeden krok w prawo, obliczenia dają jeszcze bardziej abstrakcyjną reprezentację, x 2, która następnie służy jako hipoteza o x1. Wzory w ramkach (których nie będę tutaj próbował wyjaśnić) i łączące je strzałki mają na celu pokazanie, że na każdym poziomie prawdopodobieństwo reprezentacji, x i, zależy zarówno od na x i-1 (uważany za wejście) oraz na x i + 1 (uważany za hipotezę na temat xi). Lee i Mumford opisują ten proces sprzężenia zwrotnego {sprzężenie zwrotne w

następujący sposób: Wejście sprzężenia zwrotnego napędza generowanie hipotez, a sprzężenie zwrotne z wyższych obszarów wnioskowania zapewnia priorytetom kształtowanie wnioskowania na wcześniejszych poziomach. Ani komunikaty przekazujące, ani komunikaty zwrotne nie są statyczne: jak trwa interpretacja obrazu, nowe interpretacje wysokiego poziomu pojawiają się, które informują o nowych priorytetach, a gdy pojawi się interpretacja niskiego poziomu, komunikat przekazywania jest modyfikowany. Takie hierarchiczne wnioskowanie bayesowskie może przebiegać równolegle w wielu obszarach … [z] kolejnymi obszarami korowymi w wizualnej hierarchii [ograniczającymi] wzajemne wnioskowanie w małych pętlach szybko i stale w miarę ewolucji interpretacji. Można mieć nadzieję, że taki system jako całość szybko zbiegnie się w spójną interpretację sceny wizualnej obejmującej wszystkie źródła informacji niskiego i wysokiego poziomu; ale są problemy…Jednym z "problemów" jest to, że ponieważ żaden z poziomów nie może być

całkowicie pewien swojej interpretacji, może istnieć wiele interpretacji globalnych o wysokim prawdopodobieństwie. Lee i Mumford sugerują rozwiązanie oparte na innych trwających prac AI, a mianowicie "nie przeskakiwanie do wniosku" na żadnym poziomie, ale umożliwienie kilku interpretacjom o wysokim prawdopodobieństwie "pozostania przy życiu", dopóki jedna ogólna interpretacja dla całego łańcucha nie okaże się najbardziej prawdopodobna. (Możesz sobie przypomnieć, że dwa systemy Barrowa i Tenenbauma, a mianowicie MSYS i tego, który korzystał z wewnętrznych obrazów, próbował to zrobić już w latach 70.). Aby zrealizować swój pomysł, Lee i Mumford sugerują zastosowanie filtrowania cząstek, które, jak już wspomniałem, wykorzystuje zestaw ważonych próbek reprezentujących rozkład prawdopodobieństwa w odniesieniu do interpretacji na każdym poziomie tego rozkładu, których należy nauczyć się z doświadczenia, oraz wzory łączące poziomy, system może ustalić najbardziej prawdopodobną interpretację na każdym poziomie.

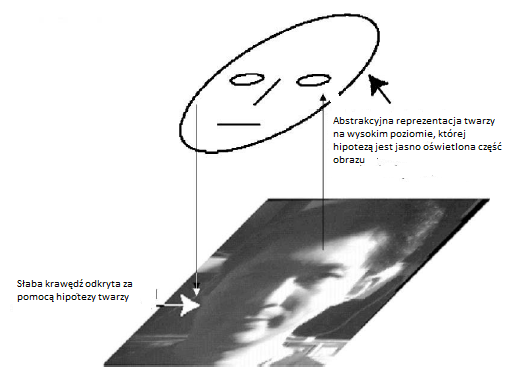

Chociaż Lee i Mumford sugerują pomysły wdrożeniowe dla swoich obliczeń prawdopodobieństwa, takie jak użycie losowości Markowa starsi, nie wdrożyli swojego modelu. Jak wyjaśniają, nie zaproponowaliśmy symulacji towarzyszącej naszej propozycji, częściowo dlatego, że należy jeszcze opracować wiele szczegółów, a częściowo dlatego, że wybór modelu jest wciąż nieograniczony, a każda konkretna symulacja zapewnia jedynie słabe wsparcie dla wysokiego poziomu hipoteza taka jak nasza. Przytaczają jednak dowody neurofizjologiczne i psychofizyczne potwierdzające ich model. Korzystają z ilustracji na, aby wyjaśnić, w jaki sposób modele podobne do nich mogą działać w celu poprawy przetwarzania obrazów wizualnych.

Jasno oświetlona część obrazu sugeruje, że może to być twarz. Ta hipoteza z kolei powoduje, że przetwarzanie obrazu na niższym poziomie jest bardziej wrażliwe na występowanie słabej krawędzi twarzy {umożliwiając jej wykrycie. (Ludzie mogą powiedzieć: "O tak, teraz widzę tę krawędź.")

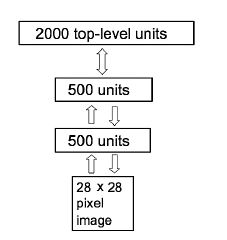

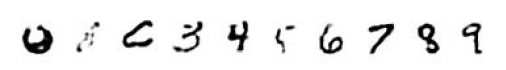

Geoffey E. Hinton, Simon Osindero i Yee-Whye Teh opracowali (raczej złożone) strategie uczenia się bez nadzoru dla innego hierarchicznego modelu zwanego siecią głębokiej wiary. Przeprowadzili eksperymenty z wersją pokazaną poniżej

Ogólna struktura jest warstwową siecią neuronową, z najwyższym poziomem składającym się z 2000 jednostek, z dwukierunkowymi połączeniami z jednostkami na poziomie poniżej. Trening sieci przebiega od dołu krok po kroku, poziom po poziomie. Kiedy każdy poziom jest trenowany, jego wagi są "zamrożone", a jego wyniki są wykorzystywane jako dane wejściowe do szkolenia następnego wyższego poziomu i tak dalej. Ta tak zwana chciwa metoda szkolenia skutkuje dobrym hierarchicznym modelem dystrybucji widzianych obrazów. Autorzy opisują również eksperymenty, w których dziesięć jednostek decyzyjnych jest dodawanych na szczyt wcześniej wyuczonej sieci hierarchicznej. Jednostki decyzyjne są następnie szkolone w zakresie rozróżniania odręcznych cyfr, z których każda ma postać obrazu 28 x 28 pikseli. Do szkolenia wykorzystano dużą, standardową bazę cyfr, a drugą dużą do testów. Wyniki przewyższyły bardziej konwencjonalne techniki. Aby zobaczyć, co "najwyższy poziom wyszkolonej pracy sieciowej" ma na myśli, "strzałki skierowane w dół służą do generowania obrazów na dolnym poziomie na podstawie kodowania etykiet wprowadzonego na najwyższym poziomie. Trochę przykładów tych wygenerowanych obrazów pokazano poniżej

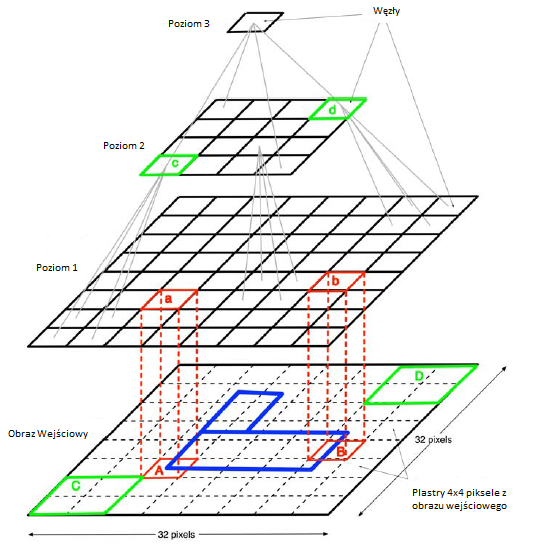

Jeff Hawkins (, projektant oryginalnego Palm Pilot, sugeruje, że kora nowa jest hierarchiczną pamięcią czasową, której warstwy (od dołu do góry) przechowują coraz bardziej abstrakcyjne reprezentacje sensorycznych sekwencji wejściowych i których funkcją (od góry do dołu) jest dokonywanie coraz bardziej szczegółowych prognoz przyszłych doświadczeń. Twierdzi, że kora wzrokowa uczy się w sposób nienadzorowany, poddając się sekwencji obrazów w czasie. Ponieważ widzimy obrazy, które pojawiają się w sposób ciągły w czasie, muszą istnieć odcinki, w których każdy obraz tego samego obiektu porusza się po naszym polu widzenia - choć pojawia się w różnych tłumaczeniach, skalach i orientacjach. Ta identyczność zapewnia ukryte oznaczenie, które jest wykorzystywane w reprezentacjach edukacyjnych na wszystkich poziomach hierarchii. Ponadto, jak twierdzi Hawkins, pamięć hierarchiczna i jej procedury uczenia się są wykorzystywane nie tylko do wprowadzania wzrokowego, ale także do innych modalności sensorycznych. Na najwyższych poziomach hierarchii te osobne modalności łączą się, aby dać zintegrowany model naszego świata sensorycznego oparty na wzroku, dotyku i słuchu - model, którego używamy do przewidywania tego, co może się dziać dalej. Na podstawie tych pomysłów on i Dileep George, doktorat z Stanford. opracował model sieci, który nazywają "Hierarchiczną pamięcią czasową" (HTM). "W swojej rozprawie George zaimplementował wersję tego modelu zilustrowaną jak tu:

Dolny poziom to tablica pikseli 32 x 32, na której prezentowana jest sekwencja obrazów. Poziom 1 składa się z tablicy 8 x 8 węzłów sieciowych, przy czym każdy węzeł odbiera dane wejściowe z łaty 4 x 4 pikseli obrazu wejściowego. Na przykład, węzeł "a" odbiera dane wejściowe ze swojego "pola odbiorczego", a mianowicie łatka pikselowa oznaczona "A", a węzeł "b" odbiera dane wejściowe z pola pikselowego oznaczona "B." Poziom 2 to tablica 4 x 4 węzłów, przy czym każdy węzeł odbiera dane wejściowe z zestawu 2 x 2 węzłów poziomu 1. Ten rodzaj konfiguracji trwa do pojedynczego węzła na poziomie 3. Węzeł ten ma rozpoznawać etykiety klas lub kategorie obrazów wejściowych. Węzły w każdej warstwie są przeszkolone do rozpoznawania często występujących sekwencji w polu odbiorczym w warstwie poniżej. Na przykład węzeł poziomu 1 oznaczony "a" na rysunku jest przeszkolony do przedstawiania prawdopodobieństw często występujących sekwencji grup pikseli w swoim polu odbiorczym "A." Jedną z takich sekwencji o wysokim prawdopodobieństwie mogą być na przykład małe rogi przesuwające się w prawo. Węzły na poziomie 2 są z kolei wyszkolone do reprezentowania prawdopodobieństwa często występujących sekwencji o wysokim prawdopodobieństwie w ich polach odbiorczych na poziomie 1 i tak dalej. Szkolenie obejmuje prezentowanie filmów jako obrazów wejściowych i przechodzi z poziomu na poziom wyżej w hierarchii. Po treningu prawdopodobieństwa sekwencji reprezentowanych na każdym poziomie są uwarunkowane informacją zwrotną z góry. Na przykład, jeśli prezentowany jest film, w którym niewielki róg przesuwa się od lewej do prawej w miejscu piksela oznaczonym "A", a jeśli taki mały róg poruszał się w ten sposób często podczas treningu, to węzeł "a"na poziomie 1 przewidziałby, że będzie kontynuował swój ruch. Gdy podążamy w górę hierarchii poziomów, każdy węzeł odbiera dane wejściowe, choć pośrednio, z coraz większych segmentów obrazu. Wreszcie węzeł na górze (poziom 3 na schemacie) reprezentuje rozkład prawdopodobieństwa między kategoriami obrazów, które widziała sieć. Kiedy sieć działa w "trybie rozpoznawania" (po treningu) najwyższy węzeł identyfikuje się najbardziej prawdopodobna kategoria obrazu na siatkówce. Sieć była w stanie nauczyć się rozpoznawać różne proste obrazy wykorzystywane przez George′a w pracy doktorskiej. George kontynuuje pracę w Numenta, firmie założonej przez Hawkins w celu rozwoju tego rodzaju sieci. Chociaż modele opisane do tej pory zostały opracowane do zadań percepcyjnych, mogą, z pewnym dopracowaniem, służyć jako podstawa ogólnych schematów architektonicznych dla inteligentnych agentów. (Patrz następny rozdział.) Aby to zrobić, opracowania musiałyby obejmować między innymi postanowienia dotyczące planowania i wykonywania działań zgodnie z ich istniejącymi przepisami dotyczącymi postrzegania. Oczywiście, jeśli te modele są w ogóle istotne dla tego, w jaki sposób kora nowa mogże działać (jak twierdzą ich zwolennicy), wtedy będą musieli być w stanie zrobić więcej tego, co robi kora nowa, w tym planować i wykonywać działania. W każdym razie badania modeli korowych stanowią drogę do współpracy między badaczami AI i neuronaukami. Jak zauważa Thomas Dean, który zbudował probabilistyczne modele kory nowej: "Dostępność modeli w skali kory ułatwi nie tylko nasze rozumienie mózgu, ale umożliwi naukowcom połączenie wniosków wyciągniętych z biologii z najnowszymi osiągnięciami techniki uczenia maszynowego do projektowania systemów hybrydowych, które łączą najlepsze biologiczne i tradycyjne podejścia komputerowe ". Kosmos nie pozwala mi opisać pracy kilku innych wybitnych badaczy wizji, którzy opracowali modele hierarchiczne, ale krótko wspomnę tylko o kilku innych. Tomaso Poggio i współpracownicy z McGovern Institute for Brain Research na MIT stosują matematyczne i statystyczne mechanizmy uczenia się, aby pomóc modelować, w jaki sposób mózg uczy się rozpoznawać obiekty wzrokowe. Jednym z obszarów ich zastosowania było rozpoznawanie twarzy. Yann LeCun z Computational and Biological Learning Laboratory w Courant Institute of Mathematical Sciences, New York University, bada to, co nazywa "głębokimi architekturami", a mianowicie "złożonymi z wielu warstw nadających się do szkolenia modułów nieliniowych". Nacisk kładziony jest na jego grupę to "modele oparte na energii" (EBM), które są modelami graficznymi, w których pojęcie związane z energią fizyczną jest powiązane ze zmiennymi (zamiast zwykłych prawdopodobieństw)

Gramatyki obrazu

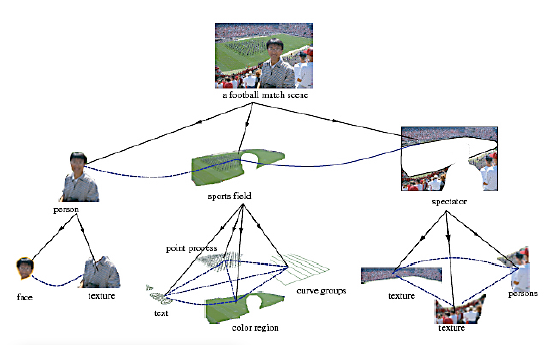

Ze względu na skuteczne wykorzystanie gramatyki i analiz składniowych w przetwarzaniu języka naturalnego nie jest zaskakujące, że będą próby zastosowania podobnych pomysłów do przetwarzania zdjęć i obrazów. W rzeczywistości, w wywiadzie cytowano Russella Kirscha, który powiedział: "do 1957 roku zaintrygowało mnie to, co lingwiści potrafili zrobić z gramatyką na komputerach… Więc zapytałem, co wydaje mi się oczywistym pytaniem: czy mógłbyś zrobić to samo ze zdjęciami? "Kirsch i jego żona Joan opracowali gramatykę do analizy (i tworzenia) zdjęć. Według wspomnianego wywiadu używali gramatyki w programie komputerowym, który mógł" tworzyć linie i wzory w stylu [artysty Richarda Diebenkorna]. Kiedy go skończono, Kirsches pokazał wygenerowany obraz samemu artyście, który zgodził się, że wygląda uderzająco podobnie do czegoś, co mógłby namalować. W rzeczywistości symulacja komputerowa była prawie identyczna do tego, który Diebenkorn już namalował. " Inne prace nad "gramatykami obrazkowymi" wykonał profesor Azriel Rosenfeld i jego grupa z University of Maryland". Song-Chun Zhu (1969 {), który kieruje UCLA Center for Image and Vision Science, zastosował różnorodne techniki statystyczne i fizyki do problemów z widzeniem. On i koledzy opracowali "stochastyczną gramatykę obrazów", które można wykorzystać do rozłożenia obrazów na części składowe. (Metoda dekompozycji realizuje niektóre z pomysłów opisanych w części 30.2.3 w pracy Lee i Mumforda). Rysunek poniżej pokazuje przykład dekompozycji obrazu, przedstawionego jako drzewo analizy.

Prace nad wizją komputerową poczyniły niesamowity postęp w ciągu ostatnich kilku lat i są ważną częścią wielu aplikacji, w tym wykrywania zdarzeń (takich jak wykroczenia drogowe), obrazowania medycznego, śledzenia obiektów (takich jak twarze, piesi i pojazdy), protez wzrokowych , wyszukiwanie obiektów na fotografiach, kontrola zapasów w magazynach, nawigacja i mapowanie pojazdów robotów, rozpoznawanie znaków i pisma ręcznego, systemy ostrzegania przed niebezpieczeństwem, kontrola procesu, kontrola płytek drukowanych, klasyfikacja owoców i warzyw, mapowanie topograficzne, badania lasu, rozpoznawanie i identyfikacja twarzy w tłum, wyszukiwanie obrazów w Internecie, kompresja obrazów i kontrola upraw rolnych. Czytelnicy, którzy chcieliby dowiedzieć się więcej, znajdą bogactwo materiałów w podręcznikach, publikacjach z zakresu wizji komputerowej oraz w Internecie.