Przetwarzanie Języka Naturalnego

Poza rozpoznawaniem wzorów pojedynczych znaków alfanumerycznych, niezależnie od tego, czy są one czcionką stałą czy odręcznie, leży problem zrozumienia ciągów znaków tworzących słowa, zdania lub większe zespoły tekstu w "naturalnym" języku, takim jak angielski. Aby odróżnić języki takie jak angielski od języków używanych przez komputery, te pierwsze są zwykle nazywane "językami naturalnymi". W sztucznej inteligencji "rozumienie" danych wejściowych w języku naturalnym zwykle oznacza albo konwersję do pewnego rodzaju modelu pamięci (takiego jak ten używany przez Rafaela w jego systemie SIR lub sieć semantyczna wykorzystywana przez Quilliana) lub wywołanie pewnych działań odpowiednich dla wejście. Języki naturalne są mówione i pisane. A ponieważ dźwięki mowy nie są tak dobrze podzielone na segmenty, jak znaki drukowane na stronie, rozumienie mowy przedstawia dodatkowe trudności. Odwrotnością rozumienia języka naturalnego jest generowanie języka naturalnego - zarówno w mowie, jak i piśmie. Tłumaczenie z jednego języka na inny dotyczy zarówno zrozumienia, jak i generacji. Podobnie jest z kontynuowaniem rozmowy. Wszystkie te problemy (rozumienie, generowanie, tłumaczenie i konwersacja) należą do ogólnej nazwy "przetwarzanie języka naturalnego" (czasami w skrócie NLP).

Poziomy językowe

Lingwiści i inni uczący się języka rozpoznają kilka poziomów, na których można analizować język. Poziomy te można ułożyć w pewnego rodzaju hierarchię, zaczynając od tych, które dotyczą najbardziej podstawowych składników języka (dźwięków i części słów) i przechodząc w górę do poziomów zajmujących się sekwencjami zdań. Jeśli mowa jest o mowie, istnieją poziomy fonetyki (dźwięki językowe) i fonologii (organizacja dźwięków w słowa). Zarówno w mowie, jak i tekście, morfologia zajmuje się sposobem łączenia całych słów z mniejszych części. Na przykład "chodzenie" składa się z "chodzenia" plus "-ing". Następnie składnia dotyczy struktury zdań i gramatyki. Próbuje opisać zasady, według których ciąg słów w określonym języku może być oznaczony gramatycznie lub nie. Na przykład ciąg "John uderzył piłkę" jest gramatyczny, ale ciąg "piłka uderzył Jana" nie. Wraz ze słownikowymi definicjami słów najważniejsza jest składnia dla zrozumienia znaczenia zdania. Na przykład zdanie "Jan widział człowieka z teleskopem" ma dwa różne znaczenia w zależności od struktury składniowej (to znaczy, w zależności od tego, czy "za pomocą teleskopu" odnosi się do "człowieka", który miał teleskop, czy do "zobaczył "). Jednak sama gramatyka nie wystarcza do określenia znaczenia. Na przykład zdanie "Bezbarwne zielone pomysły śpią wściekle" może być uważane za gramatyczne, ale jest to nonsensowny. Poziom semantyki pomaga określić znaczenie (lub bezsensowność) zdania poprzez zastosowanie analiz logicznych. Na przykład poprzez analizę semantyczną "idea" nie może być jednocześnie "bezbarwny" i "zielony". Następnie pojawia się poziom pragmatyki, który uwzględnia kontekst zdania, aby określić znaczenie. Na przykład "John poszedł do banku" miałby inne znaczenie w zdaniu o shing streamie niż w zdaniu o handlu. Pragmatyka zajmuje się znaczeniami w kontekście konkretnych sytuacji. Jeden z tych poziomów, a mianowicie składnia, był przedmiotem wielu wczesnych badań i nadal jest ważnym aspektem NLP. W 1957 r. Lingwista amerykański Noam Chomsky opublikował przełomową książkę zatytułowaną "Struktury syntaktyczne", w której zaproponował zestawy reguł gramatycznych, które można by wykorzystać do generowania "legalnych" zdań w języku. Te same zasady można również zastosować do analizy ciągu słów w celu ustalenia, czy utworzyły one prawny wyrok w danym języku. Zilustruję sposób przeprowadzania tej analizy przy użyciu tego, co Chomsky nazwał gramatyką struktury fraz (PSG). Proces ten jest bardzo podobny do tego, w jaki sposób wszyscy powtarzaliśmy zdania w szkole podstawowej. Gramatyki definiuje się, określając zasady zastępowania słów w łańcuchu symbolami odpowiadającymi kategoriom składniowym, takim jak rzeczownik, czasownik lub przymiotnik. Gramatyki mają również zasady zastępowania ciągów tych symboli składniowych dodatkowymi symbolami. Aby zilustrować te idee, użyję bardzo prostej gramatyki, dostosowanej do jednego z przykładów Chomsky'ego. Ta gramatyka ma tylko trzy kategorie składniowe: określnik, rzeczownik i czasownik. Te trzy elementy są wystarczające do analizy ciągów, takich jak "człowiek uderzył piłkę". Jedna z zasad w tej ilustracyjnej gramatyce mówi, że możemy zastąpić jedno ze słów "the" lub "a" symbolem "DET" (dla określenia Lingwiści piszą tę zasadę w następujący sposób:

the | a → DET

(Symbol | służy do wskazania, że którekolwiek z otaczających go słów można zastąpić składniowym symbolem po prawej stronie strzałki.) Oto kilka innych zasad, napisanych w tym samym formacie:

man | ball | John → N.

(Słowa "man", "ball" i "John" można zastąpić symbolem "N "dla rzeczownika.)

hit | took | throw → V.

(Słowa "hit, "took" i "throw "można zastąpić symbolem "V "dla czasownika.)

DET N → NP

(Ciąg symboli "DET "i " N" można zastąpić symbolem "NP "dla frazy rzeczownik.)

V NP. → VP

(Ciąg symboli "V "i "NP" można zastąpić symbolem "VP "dla frazy czasownika).

NP VP → S.

(Ciąg symboli "NP "i "VP" można zastąpić symbolem "S "za zdanie.)

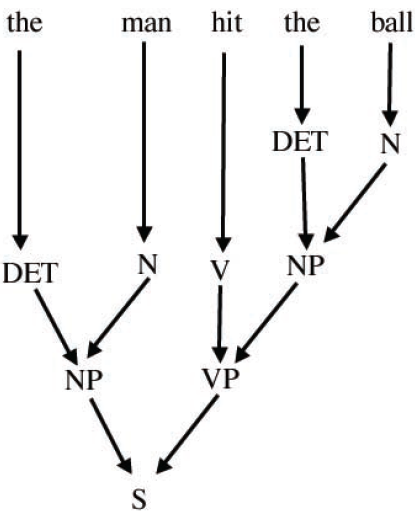

Symbole takie jak "S, "DET," "NP, i tak dalej nazywane są "nieterminalnymi" symbolami języka określonego przez gramatykę, podczas gdy słowa słownictwa takie jak "ball, "john" i "throw "są symbolami "terminala" języka. Możemy zastosować te reguły do łańcucha "człowiek uderzył piłkę", aby przekształcić go w "S." Mówi się, że każdy łańcuch, który można zmienić w "S "w ten sposób bądź gramatyczny {prawny wyrok w języku określonym przez tę bardzo prostą gramatykę. Jednym ze sposobów zilustrowania aplikacji reguł, zwanych drzewem analizy, jest pokazane na poniżej

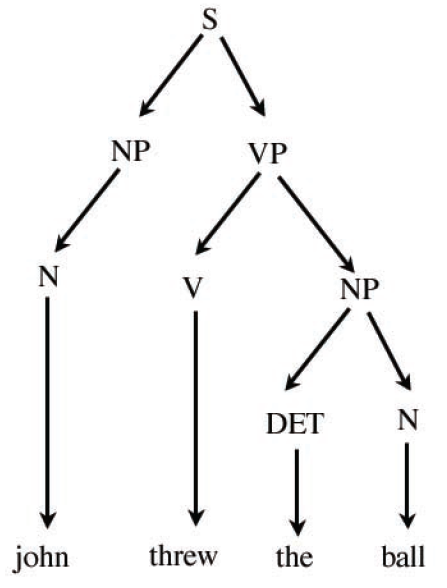

Ten przykład został oparty na małym zestawie kategorii składniowych i zasady zastępowania, aby zilustrować główne pomysły dotyczące analizy składniowej. Aby gramatyka była nieco bardziej realistyczna, musielibyśmy uwzględnić symbole i reguły zastępcze dla przymiotników, przysłówków, przyimków i tak dalej. I oczywiście musielibyśmy uwzględnić o wiele więcej słów słownych. Gramatyki nazywane są gramatykami bezkontekstowymi (CFG), jeśli wszystkie ich reguły mają tylko jeden nieterminalny symbol po prawej stronie strzałki. Nazywa się to tak, ponieważ gdy reguły są używane w odwrotnej kolejności (zamiast generować, a nie analizować zdania gramatyczne), sposób, w jaki symbol nieterminalny jest zastąpiony nie zależy od obecności jakichkolwiek innych symboli. PSG są pozbawione kontekstu. Schemat poniższy pokazuje, jak reguły naszej prostej gramatyki można wykorzystać do generowania zdań. W tym przypadku zaczyna się od symbolu zdania, a mianowicie "S" i generuje zdanie "John rzucił piłkę."

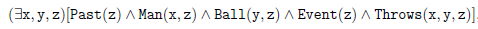

Ta prosta gramatyka z pewnością nie może wygenerować wszystkich zdań, które, jak twierdzimy, że jest legalny lub akceptowalny. Generuje także zdania, których normalnie nie chcielibyśmy zaakceptować, na przykład: "John rzucił piłkę". Książka Chomsky′ego prezentuje znacznie bardziej złożone gramatyki, a później powstały dość skomplikowane gramatyki. Na początku lat 60. XX wieku zakodowano kilka gramatyk w programach komputerowych, które potrafią parsować próbki tekstu w języku angielskim. Niemniej jednak nawet najbardziej złożone gramatyki nie mogą czysto rozróżniać zdania, które uznalibyśmy za poprawne gramatycznie, od tych, których byśmy nie zaakceptowali. Sposób, w jaki zdanie jest analizowane przez gramatykę, może determinować jego znaczenie, dlatego ważną częścią przetwarzania języka naturalnego jest użycie reguł gramatyki w celu znalezienia akceptowalnych drzew parsowania zdań. Znalezienie drzewa analizy wymaga wyszukiwania - na kilka różnych sposobów, w jakie nieterminalne symbole, zaczynające się na "S", można zastąpić za pomocą reguł gramatycznych, próbując dopasować zdanie docelowe lub na kilka różnych sposobów słowa w zdaniu docelowym można zastąpić nieterminalnymi symbolami w celu uzyskania symbolu "S." Pierwsze z tych wyszukiwań nosi nazwę "z góry na dół" (od "S" do zdania); drugie nazywa się "z dołu do góry" (od zdania do "S"). Często (jeśli nie zwykle) zdarza się, że z uwagi na gramatykę zdania mogą mieć więcej niż jedno drzewo analizy, każde o innym znaczeniu. Na przykład "mężczyzna uderzył piłkę w parku" może mieć drzewo parsowania, w którym "w parku" jest częścią frazy czasownika wraz z "uderzeniem" lub parsowanie drzewa, w którym "w parku" jest częścią fraza rzeczownikowa wraz z "piłką". Co więcej, jak już wspomniałem, niektóre fragmenty zdań mogą być bez znaczenia. Na przykład, zgodnie z moją prostą gramatyką, "piłka rzuciła człowieka" to zdanie legalne, ale prawdopodobnie bez znaczenia. Decyzja o tym, które drzewo analizy jest odpowiednie, jest częścią procesu decydowania o znaczeniu i jest zadaniem dla semantyki (a być może nawet poziom pragmatyki). Pod koniec lat pięćdziesiątych i przez większość lat sześćdziesiątych i później analiza syntaktyczna była bardziej rozwinięta niż semantyka. Analiza semantyczna zwykle polega na użyciu drzewa parsowania do kierowania transformacją zdania wejściowego w wyrażenie w jakiejś studni -de ned "język reprezentujący znaczenie" lub program, który odpowiednio reaguje na zdanie wejściowe. Na przykład "mężczyzna rzucił piłkę" może zostać przekształcony w wyrażenie logiczne, takie jak

które można zinterpretować jako "istnieją x, y i z , tak że z jest zdarzeniem, które miało miejsce w przeszłości, x jest mężczyzną w tym zdarzeniu, y jest piłką w tym zdarzeniu, a x rzuca y w tym zdarzeniu .Analiza semantyczna może również przekształcić zdanie "mężczyzna rzucił piłkę" w program, który w pewien sposób symuluje rzucanie piłką w przeszłości.

Tłumaczenie maszynowe

Niektóre z pierwszych prób wykorzystania komputerów do wykonywania więcej niż zwykłych obliczeń numerycznych polegały na automatycznym tłumaczeniu zdań z jednego języka na zdania z drugiego. Słowniki słowne mogą być przechowywane w pamięci komputera (na taśmach lub na perforowanych kartach) i mogą być użyte do znalezienia angielskich odpowiedników dla obcych słów. Uważano, że wybranie odpowiedniego odpowiednika dla każdego obcego słowa w zdaniu, wraz z niewielką ilością analizy składniowej, może zostać wykorzystane do przetłumaczenia zdania na obcy język (na przykład z rosyjskiego) na angielski. Raportując o nowym komputerze opracowywanym przez zespół prowadzony przez Harry′ego D. Huskeya w National Bureau of Standards (obecnie nazywanym National Institute of Standards and Technology), New York Times poinformował 31 maja 1949 r :

"rodzaj maszyny obliczeniowej "elektryczny mózg", zdolnej nie tylko do wykonywania skomplikowanych problemów matematycznych, ale nawet do tłumaczenia języków obcych, jest w trakcie budowy w Bureau of Standards Laboratory w University of California's Institute of Numerical Analysis. Maszyna nie będzie w polu tłumaczenia ,nie została podjęta, naukowcy pracujący nad nią twierdzą, że byłoby całkiem możliwe, aby obejmowała ona 60 000 słów z Webster Collegiate Dictionary z odpowiednikami dla każdego słowa w aż trzech językach obcych. urządzenie może wykonać tłumaczenie, napisał reporter "Timesa", gdy obce słowo do tłumaczenia jest wprowadzane do maszyny w formie elektro symbol matematyczny na taśmie lub karcie, urządzenie przejdzie przez swoją "pamięć ", a jeśli uzna ten symbol za rekord, automatycznie wyemituje z góry określony odpowiednik -angielskie słowo.…"

Wprawdzie będzie to prymitywne tłumaczenie słowo w słowo, pozbawione składni, ale mimo to będzie niezwykle cenne, projektanci twierdzą, że do takich celów, jak tłumaczenia zagranicznych prac technicznych przez naukowców, w których słownictwo jest znacznie większym problemem niż składnia. Maszyna w rzeczywistości nie wykonała żadnych tłumaczeń - pomysł zrobienia tego był nadal tylko możliwością przewidzianą przez Huskey′a. Ale nawet nienaukowcy mogliby sobie wyobrazić trudności. Artykuł wstępny w "New York Times" następnego dnia dobrze przedstawił problem:

"mamy wątpliwości co do dokładności każdego tłumaczenia. Jak maszyna decyduje, czy francuskie słowo "pont" ma być tłumaczone jako "most" lub "pokład", czy wiedzieć, że "operacja" w języku niemieckim oznacza operację chirurgiczną? Wszystko, co maszyna może zrobić, to uprościć zadanie wyszukiwania słów w słowniku i ustawiania ich angielskich odpowiedników na taśmie, tak aby tłumacz wciąż musiał oprawić odpowiednie zdania i nadać słowom znaczenie kontekstowe."

W liście do Norberta Wienera z 1947 r. Warren Weaver, matematyk i administrator nauki, wspomniał o możliwości wykorzystania komputerów cyfrowych do tłumaczenia dokumentów między naturalnymi ludzkimi językami. Wiener wątpił w tę możliwość. W odpowiedzi dla Weavera Wiener napisał:

"Szczerze mówiąc, obawiam się, że granice słów w różnych językach są zbyt niejasne, a konotacje emocjonalne i międzynarodowe są zbyt rozległe, aby jakikolwiek quasi-mechaniczny schemat tłumaczenia był bardzo obiecujący".

Niemniej jednak do lipca 1949 r. Weaver opracował swoje pomysły w memorandum zatytułowanym "Tłumaczenie", które przesłał kilku kolegom. Weaver rozpoczął swoją notatkę od stwierdzenia, co następuje:

"Nie trzeba nic więcej robić niż wspomnieć o oczywistym fakcie, że różnorodność języków utrudnia kulturową wymianę między ludami ziemi i stanowi poważny czynnik odstraszający od międzynarodowego zrozumienia. Niniejsze memorandum, zakładające ważność i znaczenie tego faktu, zawiera kilka uwag i sugestii dotyczących możliwości wniesienia przynajmniej częściowego rozwiązania problemu tłumaczenia na całym świecie za pomocą komputerów elektronicznych o dużej pojemności, elastyczności i prędkość."

Według redaktorów opublikowanego tomu, w którym memorandum zostało przedrukowane,

"kiedy wysłał go do około 200 swoich znajomych w różnych krajach, była to dosłownie pierwsza sugestia, że większość kiedykolwiek widziała, że tłumaczenie języka za pomocą technik komputerowych jest możliwe. "

Dokumentowi Weavera często przypisuje się zainicjowanie pola tłumaczenia maszynowego (często w skrócie MT). W czerwcu 1952 r. W MIT Yehoshua Bar-Hillel, izraelski logik, który był wówczas w Laboratorium Badawczym ds. Elektroniki MIT, zorganizował pierwszą konferencję poświęconą tłumaczeniu maszynowemu. Początkowo optymistycznie nastawiony do możliwości, Bar-Hillel doszedł do wniosku, że pełne automatyczne tłumaczenie jest niemożliwe. W styczniu 1954 r. W głównej siedzibie IBM World przy 57th Street i Madison Avenue w Nowym Jorku zademonstrowano automatyczne tłumaczenie próbek rosyjskiego tekstu na angielski. Demonstracja, przy użyciu małego słownictwa i ograniczonej gramatyki, była wynikiem współpracy między IBM a Georgetown University. Projektem kierowali Cuthbert Hurd, dyrektor Departamentu Nauk Stosowanych w IBM i Lonon Dostert z Georgetown. Według komunikatu prasowego IBM 10 z 8 stycznia 1954 r. rosyjski został po raz pierwszy przetłumaczony na angielski przez "mózg". Krótkie wypowiedzi na temat polityki, prawa, matematyki, chemii, metalurgii, komunikacji i spraw wojskowych zostały przekazane w języku rosyjskim przez lingwistów z Georgetown University Institute of Languages and Linguistics do słynnego komputera 701 International Business Machines Corporation. A gigantyczny komputer w ciągu kilku sekund przekształcił zdania w czytelny angielski. Dziewczyna, która nie rozumiała ani słowa języka Sowietów, wyrzuciła rosyjskie wiadomości na kartach IBM. "Mózg" wysłał swoje angielskie tłumaczenia na automatycznej drukarce z zawrotną prędkością dwóch i pół linii na sekundę.

"Mi pyeryedayem mislyi posryedstvom ryechyi", w[pisała dziewczyna.

A 701 odpowiedział:

" Przekazujemy myśli za pomocą Mowa."

Chociaż demonstracja wywołała wiele emocji i doprowadziła do zwiększenia funduszy na badania nad tłumaczeniem, późniejsze prace w terenie były rozczarowujące. Po ocenie pracy MT w opublikowanym raporcie z 1959 r. wśród badaczy, Bar-Hillel przekonał się, że w pełni automatyczne tłumaczenie wysokiej jakości (które nazwał FAHQT) nie było możliwe "nie tylko w niedalekiej przyszłości, ale w ogóle". Jego rozszerzony raport ukazał się w artykule z 1960 r., który cieszył się szerokim rozpowszechnieniem. Jednym z czynników prowadzących Bar-Hillela do jego negatywnych wniosków była widoczna trudność w zapewnieniu komputerom "wiedzy o świecie" potrzebnej do tłumaczenia wysokiej jakości. Zilustrował problem następującą historią:

Mały John szukał swojego pudełka z zabawkami. W końcu go znalazł. Pudełko było w piórze. John był bardzo szczęśliwy. Jak tłumaczyć "Pudełko było we piórze"? Bar-Hillel argumentował, że nawet gdyby istniały tylko dwie definicje "pióra" (przybory do pisania i obudowa, w której bawią się małe dzieci), komputer znający tylko te definicje nie byłby w stanie zdecydować, które znaczenie jest zamierzone. Oprócz znajomości słownictwa i składni komputer tłumaczący musiałby znać "względne rozmiary piór w sensie pisania narzędzia, pudełka z zabawkami i długopisy, w sensie kojców" .Tą wiedzę, jak twierdził Bar-Hillel, nie dysponował komputer elektroniczny. Powiedział, że przekazanie komputerowi takiej encyklopedycznej wiedzy jest" całkowicie chimeryczne i prawie na nic nie zasługuje dalsza dyskusja".

Jak później przyznali później naukowcy, Bar-Hillel miał rację co do tego, że wysoce kompetentne systemy przetwarzania języka naturalnego (a właściwie ogólnie rzecz biorąc, ogólnie wszechstronne systemy sztucznej inteligencji) będą musiały posiadać wiedzę encyklopedyczną. Jednak większość badaczy AI nie zgadza się z nim co do bezcelowości próby przekazania komputerom wymaganej wiedzy encyklopedycznej. Bar-Hillel był znany z tego, że był trochę niemiły w kwestii sztucznej inteligencji. (Komentując artykuł Johna McCarthy′ego "Programy ze zdrowym rozsądkiem" na konferencji w Teddington w 1958 r., Bar-Hillel powiedział: "Artykuł dr McCarthy′ego należy do Journal of Half-Baked Ideas, którego stworzenie niedawno zaproponował dr IJ Good. ")

W kwietniu 1964 r. Narodowa Akademia Nauk utworzyła Komitet Doradczy ds. Automatycznego Przetwarzania Języków (ALPAC), którego przewodniczącym był John R. Pierce z Bell Laboratories, aby "doradzać Departamentowi Obrony, Centralnej Agencji Wywiadowczej oraz National Science Foundation o badaniach i rozwoju w dziedzinie mechanicznego tłumaczenia języków obcych. " Komitet opublikował swój raport w sierpniu 1965 r. I stwierdził między innymi, że "nie ma bezpośredniej ani przewidywalnej perspektywy przydatnego tłumaczenia maszynowego". Zalecili wsparcie dla podstawowej nauce o językoznawstwie i "pomoce" w tłumaczeniu, ale nie w celu dalszego wsparcia w pełni automatycznego tłumaczenia. Raport spowodował radykalne ograniczenie finansowania na dużą skalę badań nad tłumaczeniem maszynowym. Niemniej tłumaczenie maszynowe przetrwało i ostatecznie rozkwitło, co zobaczymy później. Stowarzyszenie Tłumaczeń Maszynowych i Lingwistyki Komputerowej (AMTCL) odbyło swoje pierwsze spotkanie w 1962 r. W 1968 r. Zmieniło nazwę na Stowarzyszenie Lingwistyki Komputerowej (ACL) i stało się międzynarodowym towarzystwem naukowym i zawodowym dla osób pracujących nad problemami związanymi z język naturalny i obliczenia. Wydaje kwartalnik Lingwistyka obliczeniowa oraz sponsoruje konferencje i warsztaty.

Odpowiedzi na pytania

Oprócz pracy nad tłumaczeniem maszynowym badacze zaczęli badać, w jaki sposób zdania w języku naturalnym, takim jak angielski, można wykorzystać do komunikacji z komputerami. Przypomnisz sobie program ELIZA firmy Weizenbaum, który był w stanie zaangażować osobę w rozmowę, mimo że program "nie zrozumiał" niczego o tym, co zostało powiedziane. Wspomniałem już o systemie SIR Rafaela, który mógłby reprezentować przekazane mu informacje, a następnie odpowiadać na pytania. Wspomnę o kilku innych projektach, które mają w tym okresie pochwalić się przetwarzaniem języka naturalnego. Program o nazwie BASEBALL (napisany w IPL-V, specjalnym języku programowania do przetwarzania list opracowanym przez Newella, Shawa i Simona) został opracowany w Lincoln Laboratory pod kierunkiem Berta Greena, profesora psychologii na Carnegie Institute of Technology. Potrafił odpowiedzieć na proste angielskie pytania dotyczące baseballu, korzystając z bazy danych o grach baseballowych rozgrywanych w Ameryce w ciągu jednego roku. Na przykład może odpowiedzieć na pytanie takie jak "Gdzie grali Red Sox 7 lipca?" Pytania musiały mieć szczególnie prostą formę i ograniczać się do słów w słowniku programu. Według autorów Pytania są ograniczone do jednej klauzuli; zakazując struktur z klauzulami zależnymi, analiza składniowa jest znacznie uproszczona. Logiczne połączenia, takie jak i, lub, i nie, są zabronione, podobnie jak konstrukcje sugerujące relacje jak najbardziej i najwyższe. Wreszcie pytania dotyczące kolejnych faktów, takie jak "Czy Red Sox wygrali kiedykolwiek sześć gier z rzędu?" są zakazane. Program działał, przekształcając pytanie w specjalną formę zwaną "listą specyfikacji", wykorzystując zarówno specjalne analizy składniowe, jak i analizy semantyczne. Ta lista byłaby następnie wykorzystana do uzyskania dostępu do bazy danych programu w celu znalezienia odpowiedzi na pytanie. Na przykład pytanie "Gdzie grali Red Sox w dniu 7 lipca? "Zostanie najpierw przekonwertowane na listę:

Miejsce =?

Drużyna = Red Sox

Miesiąc = lipiec

Dzień = 7

Autorzy twierdzili, że ich "ograniczenia były tymczasowymi środkami, które zostaną usunięte w późniejszych wersjach programu" .O ile mi wiadomo, nie było późniejszych wersji programu. (Jak zobaczymy, jak rozwinie się moja historia sztucznej inteligencji, jest kilka przypadków, w których bardzo trudno było usunąć "tymczasowe "ograniczenia.). Inny program w języku naturalnym, SAD SAM, został napisany w IPL-V w 1962 -1963 r. przez Roberta Lindsaya w Carnegie Institute of Technology. Może analizować angielskie zdania na temat relacji rodzinnych i zakodować te relacje w drzewie genealogicznym. Korzystając z drzewa, mógłby następnie odpowiedzieć na angielskie pytania dotyczące związków. Na przykład, jeśli SAD SAM otrzymało zdanie "Joe i Jane są potomstwem Toma, "stworzyłoby strukturę listy drzewa dla pewnej" jednostki rodzinnej ", w której Tom jest ojcem, a Joe i Jane są dziećmi. otrzymał zdanie "Mary jest matką Jane", dodałoby Mary do tej struktury jako żony Toma. Wtedy byłby w stanie odpowiedzieć na pytanie "Kim jest matka Joe?" SAD SAM jest akronimem dla Rzeczoznawców Zdań, Diagrammera i Analiz Semantycznych Maszyny. Część SAD przeanalizowała zdania wejściowe i przekazała je do SAM, który wyodrębnił informacje semantyczne potrzebne do budowy drzew genealogicznych i znalezienia odpowiedzi na pytania. Akceptuj szeroką gamę zdań w podstawowym języku angielskim - system gramatyki i słownictwo około 850 słów określonych przez Charlesa K. Ogdena ,Roberta F. Simmonsa, psychologa i językoznawcy w Systems Development Corporation (SDC) ) w Santa Monica w Kalifornii , miał większe cele dla własnej pracy w przetwarzaniu języka naturalnego. Według strony "In Memoriam" autorstwa Gordona Novaka, jednego z jego doktorów. Marzeniem Simmonsa było to, że można było "rozmawiać z książką", komputer czytał książkę, a następnie użytkownik mógł z nią porozmawiać, zadając pytania, na które należy odpowiedzieć, rozumiejąc książkę . Osiągnięcie tego "marzenia" okazałoby się równie trudne jak sama sztuczna inteligencja. W notatce z 1961 r. o swoim projekcie "Synthex" Simmons opisał, jak powinien zacząć:

Celem tego projektu jest opracowanie metodologii badawczej i pojazdu do projektowania i budowy ogólnego przeznaczenia skomputeryzowany system do syntezy złożonych ludzkich funkcji poznawczych. Pierwotny pojazd, proto-synthex, będzie podstawowym urządzeniem do przetwarzania języka, które odczytuje proste materiały drukowane i odpowiada na proste pytania sformułowane w podstawowym języku angielskim."

W 1965 r. Simmons i Lauren Doyle przeprowadzili eksperymenty z systemem Protosynthex. Według raportu Trudi Bellardo Hahna:

"W systemie załadowano małą prototypową bazę pełnotekstową rozdziałów encyklopedii dziecięcej (Golden Book). Protosynthex mógł odpowiedzieć na proste pytania w języku angielskim z" odpowiedzią ". […] był pionierem w używaniu języka naturalnego do wyszukiwania tekstu ".

W międzyczasie doktor Daniel G. Bobrow , student Marvina Minsky′ego na MIT, napisał zestaw programów, zwanych systemem STUDENT, które mogłyby rozwiązać problemy z algebrą / historią podane w ograniczonym podzbiorze języka angielskiego. Oto przykład problemu, który STUDENT mógłby rozwiązać:

Odległość z Nowego Jorku do Los Angeles wynosi 3000 mil. Jeśli… średnia prędkość samolotu odrzutowego wynosi 600 mil na godzinę oraz czas podróży samolotem z Nowego Jorku do Los Angeles. STUDENT rozwiązał problem, wykorzystując pewne znane zależności dotyczące prędkości i odległości do skonfigurowania i rozwiązania odpowiednich równań. Praca Bobrowa podała kilka innych przykładów problemów, które STUDENT mógł rozwiązać, oraz zastosowanych metod.