Postęp w NLP

Jak wspomniano wcześniej, problemy ze zrozumieniem, generowaniem i tłumaczeniem materiałów w zwykłych językach ludzkich (a nie komputerowych) należą do kategorii przetwarzania języka naturalnego. Podczas fazy "wczesnych eksploracji" badań nad sztuczną inteligencją poczyniono pewne dobre początki dotyczące problemów NLP. W kolejnej fazie, od końca lat sześćdziesiątych do wczesnych lat siedemdziesiątych, na tych fundamentach opracowano nowe prace, co opiszę w tej części książki.

Tłumaczenie maszynowe

W. John Hutchins, który napisał obszernie o historii tłumaczenia maszynowego (MT), nazwał lata 1967-1976 "spokojną dekadą". Brak aktywności w tym okresie wynika częściowo z raportu ALPAC, co, jak już powiedziałem, było pesymistyczne co do perspektyw tłumaczenia maszynowego. Hutchins stwierdził:

"Raport ALPAC był głęboki. Przez ponad dekadę wirtualnie zakończył badania MT w USA, a MT przez wiele lat postrzegano jako całkowitą porażkę. . . . Działalność MT przeniosła się ze Stanów Zjednoczonych na Kanadę i Europę. "

Jednym z wyjątków od tego trwającego dekadę zastoju w Stanach Zjednoczonych było opracowanie programu tłumaczeń Systran (System Translator) autorstwa Petr Toma, komputerowca urodzonego na Węgrzech naukowca i językoznawcę, który pracował nad systemem tłumaczeń rosyjsko-angielskiego w Georgetown W 1968 r. Toma założył firmę o nazwie Latsec, Inc. w La Jolla w Kalifornii, aby kontynuować prace rozwojowe Systran, które rozpoczął wcześniej w Niemczech Siły powietrzne Stanów Zjednoczonych zawarły umowę na opracowanie systemu tłumaczeń z języka rosyjskiego na angielski. Przetestowano go na początku 1969 r. W bazie sił powietrznych Wright-Patterson w Dayton w stanie Ohio, gdzie nadal zapewnia rosyjskie {angielskie tłumaczenia dla Departamentu Technologii Zagranicznych USAF do dziś. "Systran ewoluował jako jeden z głównych automatycznych systemów tłumaczeń. Jest sprzedawany przez Imageforce Corporation w Tampie na Florydzie. Jak dobrze Systran tłumaczy? Wszystko zależy jak chce się mierzyć wydajność. Margaret Boden wymienia dwie miary, a mianowicie "zrozumiałość" i "poprawność". Oba te środki zależą od ludzkiego osądu. Po pierwsze, pytamy: "Czy tłumaczenie można ogólnie zrozumieć?" Po drugie, pytamy: "Czy ludzcy" redaktorzy "muszą zmodyfikować tłumaczenie?" Boden twierdzi, że "w dwuletnim okresie od 1976 do 1978 r. zrozumiałość tłumaczeń generowanych przez Systran wzrosła z 45 do 78 procent dla [wprowadzania tekstu surowego]." Zauważa również, że tłumaczenia ludzkie mają tylko 98 do 99 procent , nie 100 procent. Jeśli chodzi o poprawność, Boden twierdzi, że w 1978 r. "Tylko 64 procent słów pozostało nietkniętych przez post-redaktorów. Mimo to, ludzka post-edycja strony wyników Systran zajęła tylko dwadzieścia minut w połowie lat osiemdziesiątych, podczas gdy normalne ( tłumaczenie w pełni ludzkie) zajęłoby godzinę.

Zrozumienie

Chociaż przełom lat sześćdziesiątych i siedemdziesiątych mógł być "cichą dekadą" w tłumaczeniu maszynowym, był to bardzo aktywny okres dla innych prac NLP. W tych latach badacze zastosowali znacznie silniejsze zdolności syntaktyczne, semantyczne i wnioskowania do problemu zrozumienia języka naturalnego. Typową dla nowego podejścia była obserwacja doktora Terry′ego Winograda, doktora MIT pod koniec lat 60. XX wieku: Jeśli naprawdę chcemy, aby komputery nas rozumiały, musimy dać im możliwość korzystania z większej wiedzy. do gramatyki języka, muszą mieć wszelkiego rodzaju wiedzę na temat, który omawiają, i muszą użyć rozumowania, aby połączyć fakty we właściwy sposób, aby zrozumieć zdanie i odpowiedzieć na nie. Proces rozumienia zdania musi łączyć gramatykę, semantykę i rozumowanie w bardzo intymny sposób, wzywając każdą stronę do pomocy innym.

13.2.1 SHRDLU

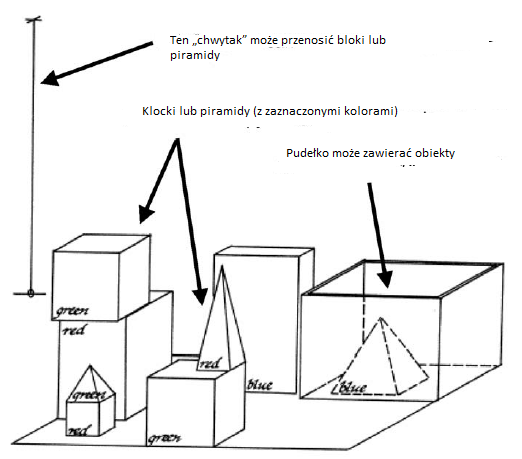

Być może osiągnięciem NLP, które wywołało największe podekscytowanie, był system dialogowy języka naturalnego SHRDLU zaprogramowany przez Terry′ego Winograda dla jego doktoratu. Rozprawa (podu Seymoura Paperta) w MIT SHRDLU była w stanie prowadzić dialog na temat tego, co Winograd nazwał "mikroświatem", światem składającym się z bloków zabawek i "chwytaka" do ich przemieszczania. W przeciwieństwie do świata prawdziwych bloków używanych w poprzednich badaniach MIT i Stanforda, świat bloków Winograda był symulowany na komputerze DEC PDP-10 i oglądany na czarno-białym ekranie graficznym DEC 340, takim jak pokazany poniżej

SHRDLU może otrzymać polecenia wpisane zwykłym angielskim, aby manipulować blokami za pomocą jego chwytaka. Można by również zadawać pytania o stan jego świata. Mógł "zrozumieć" te polecenia i pytania, wykonać żądane manipulacje i zadać użytkownikowi wyjaśnienie pytań w języku angielskim na temat pytań lub poleceń, których nie rozumiał. Przed opisaniem czegoś na temat projektu SHRDLU, spójrzmy na przykład części okna dialogowego. Poniżej dane wejściowe użytkownika są ponumerowane i pokazane małymi literami, a odpowiedź SHRDLU jest pisana wielkimi literami, komentarz Winograda następuje tym samym krojem pisma, a mój w nawiasach normalnym typem:

1. podnieś duży czerwony blok.

Aby podnieść czerwony blok, musisz go usunąć aby odszukać miejsce na zielony i przesuń zielony z dala.

OK

System odpowiada "OK", gdy wykonuje polecenie.

(Nie zawracam sobie głowy pokazaniem, jak wygląda konfiguracja bloku w trakcie dialogu, zakładając, że możesz użyć własnego modelu umysłu "do śledzenia rzeczy". Chwytak trzyma teraz czerwony blok.)

2. chwyć piramidę.

Na scenie są trzy piramidy, więc program nic nie robi.

NIE ZROZUMIEM, CO OZNACZA. PIRAMIDA

3. znajdź blok, który jest wyższy niż ten, który trzymasz i umieść go w pudełku. (Użytkownik najwyraźniej teraz zmienił zdanie na temat chwytania piramid). System musi ustalić, co należy rozumieć przez "jeden" i "to", a także za pomocą dedukcji, aby zdecydować, który blok trzyma.

"IT", PRZYJMUJĘ, ŻE OZNACZASZ BLOK, KTÓRY JEST WYŻSZY NIŻ TEN KTÓRY TRZYMAM.

Wydrukowano, aby nas informować. Ręka musi odłożyć czerwony blok, aby podnieść wyższy niebieski.

OK.

4. co zawiera pudełko?

NIEBIESKI PIRAMIDA I NIEBIESKI BLOK.

5. na czym opiera się piramida?

Wcześniej system odpowiedział "piramidą", mówiąc

"Nie rozumiem, którą piramidę masz na myśli". teraz wie, że musimy mieć na myśli ten, o którym właśnie wspomniano.

PUDEŁKO

To okno dialogowe ilustrujące możliwości SHRDLU jest kontynuowane dla czterdziestu dwóch dodatkowych danych wejściowych i odpowiedzi systemowych. Aby zaangażować się w takie dialogi, SHRDLU potrzebowała "wiedzy. "Musiała wiedzieć o składni używanej części języka angielskiego i musiała wiedzieć, co oznaczają różne słowa i kombinacje słów w kontekście ich użycia. wiedzieć o świecie bloków {jak manipulować blokami i co to znaczy, że obiekt znajduje się w "pudełku". Musiał śledzić okno dialogowe, aby mógł zdecydować, do którego obiektu wspomniano wcześniej słowo takie jak "to", o którym mowa. Cała ta potrzebna wiedza była reprezentowana w programach LISP lub "procedurach", jak je nazywał Winograd. Wiedza na temat składni była reprezentowana jako zbiór procedur opartych na zasadach "gramatyki systemowej". Wiedza o znaczeniu słów w kontekście była reprezentowana w procedurach, które mogłyby odnosić się do słownika znaczeń słów, do innych części zdania, w którym użyto tego słowa, oraz do dyskursu. Wiedza na temat świata bloków była reprezentowana na dwa sposoby: istniał model, który podawał lokalizacje wszystkich obiektów oraz istniały procedury, które mogą wnioskować o przewidywanych efektach (w modelu) manipulacji przez chwytak na różnych obiektach. Procedury przemieszczania obiektów zawierały informacje zarówno o warunkach wstępnych, jak i o skutkach tych manipulacji. Procedury te zostały zakodowane w wersji języka PLANNER firmy Hewitt, która, jak wspomniano wcześniej, była w pewnym stopniu podobna do operatorów STRIPS. Zastosowano dodatkowe procedury w języku PLANNER dla innych rodzajów wnioskowania potrzebnych przez system. Reguły logiczne zostały wyrażone jako programy, które były w stanie dokonywać zarówno dedukcji do przodu, jak i do tyłu. Procesy SHRDLU do rozumienia języka można podzielić na trzy części, a mianowicie składnię, semantykę i wnioskowanie, ale jest to nieco wprowadzające w błąd, ponieważ wzajemne oddziaływanie tych części było kluczową cechą systemu. Jak stwierdził Winograd:

"Ponieważ każdy kawałek wiedzy może być procedurą, może on przywołać dowolną inną wiedzę dowolnego rodzaju". Na przykład Winograd napisał: "Gdy wyszukuje każdy kawałek struktury syntaktycznej, sprawdza jego semantyczny interpretacji, najpierw, aby sprawdzić, czy jest to prawdopodobne, a następnie (jeśli to możliwe), aby sprawdzić, czy jest to zgodne ze znajomością systemu przez świat, zarówno konkretną, jak i ogólną."

Proceduralne przedstawienie wiedzy przez Winograd (wraz z językiem Hewitta PLANNER do kodowania takich reprezentacji) można skontrastować z wykorzystaniem przez McCarthy′ego formuł logicznych do deklaratywnego reprezentowania wiedzy. Sukces SHRDLU podsycił debatę wśród badaczy AI na temat zalet i wad tych dwóch strategii reprezentacji wiedzy - proceduralnej kontra deklaratywnej. W rzeczywistości użycie LISP do reprezentowania procedur zaciera to rozróżnienie do pewnego stopnia, ponieważ, jak zauważył Winograd, "LISP pozwala nam traktować programy jako dane, a dane jako programy". Tak więc, chociaż wiedza SHRDLU była reprezentowana proceduralnie, była w stanie włączyć do swoich procedur pewną nową deklaratywną wiedzę (przedstawianą jako zdania angielskie). Wydajność HRDLU była naprawdę imponująca i wzbudziła optymizm wśród niektórych badaczy języka naturalnego odnośnie przyszłego sukcesu. Jednak Winograd wkrótce porzucił tę linię badań na rzecz pracy nad interakcją komputerów i ludzi. Być może dlatego, że miał doświadczenie z pierwszej ręki, ile wiedzy było potrzebne do udanego rozumienia języka w czymś tak prostym, jak świat bloków, dlatego nie chciał dawać komputerom wystarczającej wiedzy, aby powielić pełny zakres ludzkich umiejętności werbalnych. W e-mailu z 2004 roku Winograd umieścił umiejętności SHRDLU w kontekście umiejętności ludzi: istnieją fundamentalne różnice między sposobem działania SHRDLU i jego krewnych, a tym, co dzieje się w naszych mózgach. Nie sądzę, aby obecne badania poczyniły duży postęp w przekraczaniu tej przepaści, a odpowiednia nauka może potrzebować dziesięcioleci lub więcej, aby dojść do punktu, w którym początkowe ambicje stają się realistyczne. W międzyczasie AI zajęła się znacznie bardziej wykonalnymi celami pracy w mniej ambitnych niszach lub akceptowania wyników innych niż ludzkie (jak w tłumaczeniu),

LUNAR

Po powrocie z pierwszego załogowego lądowania na Księżycu astronauci Apollo 11 przynieśli kilka kilogramów księżycowych skał do badań naukowych. Różne dane o tych skałach były przechowywane w bazach danych, do których geologowie i inni naukowcy mieli dostęp. Aby ułatwić wyszukiwanie tych informacji geologom księżycowym, NASA zapytała Williama A. Woodsa, młodego informatyka z BBN, o możliwość zaprojektowania pewnego rodzaju "frontonu" w języku naturalnym, aby zamiast tego można było przeszukiwać bazy danych w języku angielskim w tajemnym kodzie komputerowym. Woods właśnie ukończył doktorat, badania na Harvardzie o systemach odpowiadania na pytania. Sponsorowany przez załogowe centrum kosmiczne NASA, koledzy Woodsa z BBN, Ron Kaplan i Bonnie Webber, opracowali system, który nazwali "LUNAR", odpowiadając na pytania dotyczące skał księżycowych. LUNAR użył obu procesów syntaktycznych i semantycznych przekształcające angielskie pytania w zapytania do bazy danych księżycowej skały. Analizę syntaktyczną przeprowadzono przy użyciu "rozszerzonych sieci przejściowych" (ATN), metodologii opracowanej przez Woodsa podczas jego doktoratu na Harvardzie. Składnik semantyczny, kierowany przez drzewa parsowania pochodzące z ATN, przekształciły zdania angielskie w coś, co Woods nazwał "znaczeniem języka reprezentacji" (MRL). Ten język był językiem logicznym ( jak rachunek predykatów), ale rozszerzony o procedury, które można wykonać. MRL został pierwotnie opracowany przez Woodsa z Harvardu i rozwinięty w BBN. LUNAR był w stanie "zrozumieć" i odpowiedzieć na wiele różnych pytań, w tym na przykład: "Jakie jest średnie stężenie glinu w skałach o wysokiej zawartości alkaliów?" "Ile brekcji zawiera oliwin?" "Co to jest?" (LUNAR uznał, że "odnoszą się" do brekcji wymienionych jako odpowiedzi na ostatnie pytanie.) LUNAR był pierwszy system odpowiadający na pytania służący do publikowania danych dotyczących wyników. Udało mu się odpowiedzieć z powodzeniem na 78% pytań zadanych mu przez geologów podczas drugiej dorocznej konferencji naukowej poświęconej Księżycowi, która odbyła się w Houston w styczniu 1971 r. Podobno 90% byłoby odpowiedzią w stanie z "drobnymi porawkami" do systemu. W przemówieniu LUNAR z czerwca 2006 r. Woods wspomniał o niektórych jego ograniczeniach. Poniższe okno dialogowe ilustruje jedną wadę:

Użytkownik: Co to jest breccia?

LUNAR: S10018.

Użytkownik: Co to jest S10018?

LUNAR: S10018.

Woods powiedział:

"LUNAR po prostu odnajduje odniesienia do wyrażeń odsyłających i podaje ich nazwy. Nie ma modelu celu za pytaniem użytkownika ani różnego rodzaju odpowiedzi dla różnych celów".

Chociaż LUNAR mógł rozpoznać kilka różnych sposobów sformułowania zasadniczo tego samego pytania, Woods stwierdził, że "istnieją inne żądania, które (z powodu ograniczeń w obecnej gramatyce) muszą zostać określone w określony sposób, aby gramatyka je parsowała i tam są inne, które są rozumiane przez interpretatora semantycznego tylko wtedy, gdy są określone w określony sposób. "

Rozszerzone sieci przejściowe

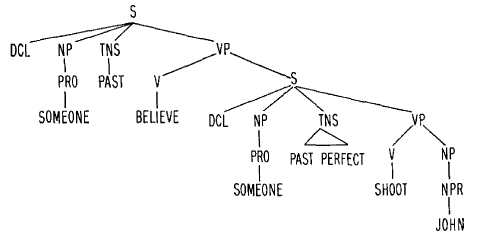

Wiele osób zdało sobie sprawę, że gramatyki bezkontekstowe (takie jak te, które omówiłem wcześniej) były zbyt słabe do większości praktycznych aplikacji do przetwarzania języka naturalnego. Na przykład, gdybyśmy rozszerzyli gramatykę ilustracyjną, tak aby obejmowała (oprócz "rzucania" i "uderzania" i "człowieka") czasowniki teraźniejsze "rzut", "rzuty" i "uderza" i rzeczownik w liczbie mnogiej "mężczyźni", wówczas sznurki "mężczyźni uderzają piłkę" i "człowiek rzuca piłkę" byłyby niewłaściwie przyjęte jako zdania gramatyczne. Aby rozszerzyć gramatykę bezkontekstową, wymagając, że rzeczowniki i czasowniki muszą się zgadzać co do liczby wymagałoby niepraktycznie dużego zbioru zasad. Ponadto uwzględnienie zdań pasywnych, takich jak "piłka została trafiona przez mężczyzn", wymagałoby jeszcze dalszego dopracowania. Najwyraźniej tego rodzaju zdania, które geolodzy mogliby zadać na temat skał księżycowych, wymagały silniejszych gramatyk -takich jak rozbudowane sieci przejściowe, które Woods i inni opracowali. W książce Chomsky'ego z 1957 roku zaproponował hierarchię systemów gramatycznych, których gramatyki bezkontekstowe były tylko jednym przykładem. Jego potężniejsze gramatyki miały "komponent transformacyjny" i były w stanie, na przykład, aby przeanalizować zdanie takie jak "piłka została trafiona przez mężczyznę" i nadać mu taką samą "głęboką strukturę", jak w przypadku zdania "mężczyzna uderzył piłkę". Rozszerzone gramatyki sieci przejściowej mogą również wykonywać tego rodzaju transformacje, ale w sposób bardziej satysfakcjonujący obliczeniowo. Rozszerzona sieć przejściowa jest podobną do mapy strukturą graficzną, w której węzły reprezentują punkty postępu w procesie analizowania, a ścieżki łączące dwa węzły reprezentują kategorie składniowe. Możemy myśleć o analizowaniu zdania jako przemierzaniu ścieżki przez sieć od węzła początkowego (brak postępów) do węzła końcowego (gdzie zdanie zostało pomyślnie przetworzone). Przemierzanie ścieżki buduje strukturę składniową zdania w postaci drzewa parsowania. Analiza zdania polega na odrywaniu słów od lewej do prawej i użyciu ich do wskazania ścieżki w sieci. Analiza syntaktyczna może rozpocząć się od oderwania pojedynczego słowa i wyszukania z leksykonu, czy jest to rzeczownik, określnik, pomocnik (taki jak "robi"), przymiotnik lub inna "końcowa" kategoria składniowa. Lub może zacząć od oderwania grupy słów i sprawdzenia, czy ta grupa była frazą rzeczownikową, frazą czasownikową, frazą przyimkową lub czymś innym. W pierwszym przypadku, w zależności od kategorii pojedynczego słowa, wybralibyśmy ścieżkę odpowiadającą tej kategorii prowadzącej z węzła początkowego. Aby uwzględnić drugi przypadek, istniałyby możliwe ścieżki odpowiadające wyrażeniu rzeczownikowi i innym możliwym kategoriom składniowym wyższego poziomu. Ale jak zdecydowalibyśmy, na przykład, czy możemy podjąć ścieżkę rzeczownikową? Woods i inni zaproponowali odpowiedź, że będą istniały dodatkowe sieci przejściowe odpowiadające tym kategoriom wyższego poziomu. Moglibyśmy obrać ścieżkę rzeczownikową w głównej sieci przejściowej tylko wtedy, gdybyśmy mogli pomyślnie przejść przez sieć rzeczownikową. A ponieważ jedna ścieżka w sieci wyrażeń rzeczownikowych może zaczynać się od wyrażenia przyimkowego, musielibyśmy sprawdzić, czy moglibyśmy podążać tą ścieżką (w sieci wyrażeń rzeczownikowych), pomyślnie przechodząc przez sieć wyrażeń przyimkowych. Proces ten byłby kontynuowany, gdy jedna sieć "dzwoni" do innych sieci w sposób podobny do tego, w jaki program może ponownie uruchomić (lub "wywołać") inne programy, być może rekurencyjnie. Z tego powodu takie sieci są nazywane rekurencyjnymi sieciami przejściowymi. Pierwsze sieci tego rodzaju opracowali James Thorne, Paul Bratley i Hamish Dewar na University of Edinburgh w Szkocji. Później Dan Bobrow i Bruce Fraser zaproponowali system sieci przejściowej . Oba te systemy wykonały również obliczenia pomocnicze podczas przechodzenia przez swoje sieci. Te "rozszerzenia" pozwoliły na zbudowanie "głębokiej struktury" reprezentacji analizowanego zdania. Praca Woodsa nad "rozszerzonymi, rekurencyjnymi sieciami przejściowymi" opierała się na tych ideach i wprowadzała do nich elegancki język definicji sieci. Jako przykład Woods opisał, jak jedna z jego sieci przeanalizowała zdanie "Uważano, że John został zastrzelony". Po wykonaniu wszystkich połączeń do sieci pomocniczych i wszystkich obliczeń pomocniczych uzyskano drzewo analizy przedstawione poniżej

Możemy obserwować dwie rzeczy dotyczące tego drzewa analizy. Najpierw zwróć uwagę na występowanie "PAST" i "PAST PERFECT" jako znaczników czasu. Po drugie, zauważ, że forma oryginalnego zdania z pasywnym głosem została przekształcona w zdanie z aktywnym głosem, używając przypuszczalnego zaimka "Ktoś". Jak zauważa Woods, strukturę można sparafrazować jako "Ktoś uwierzył, że ktoś zastrzelił Johna". Gramatyki sieciowe uzyskują "głęboką strukturę" zdań, przekształcając je następnie w standardową formę.

GUS

Dan Bobrow i Ronald Kaplan, dwaj naukowcy wykonujący pracę NLP w BBN, przeprowadzili się do nowo utworzonego Centrum Badawczego Palo Alto (PARC) w Xerox w połowie lat 70. XX wieku. Jednym z projektów, nad którymi pracowali tam oni i inni badacze, był GUS (akronim Genial Understander System), który miał "angażować sympatycznego i wysoce współpracującego człowieka w angielski dialog, ukierunkowany na konkretny cel w bardzo ograniczonym zakresie dziedzina dyskursu ". Ograniczoną domeną była agencja turystyczna prowadząca "rozmowę z klientem, który chce odbyć prostą podróż powrotną do jednego miasta w Kalifornii". Poniższa transkrypcja rzeczywistego okna dialogowego pokazuje niektóre z jej umiejętności:

GUS: Cześć. Mam na imię GUS. Mogę pomóc Ci zaplanować prostą podróż samolotem. Gdzie chcesz jechać?

(1) Klient: Chcę jechać do San Diego 28 maja.

GUS: O której chcesz wyjść?

(2) Klient: Muszę być w San Diego przed 10 rano.

GUS: Czy chciałbyś P.S.A. czy 102, która przyjeżdża o godz. 9.15?

(3) Klient: jaki jest następny lot?

GUS: Air California 310, który odjeżdża o godz. 8.30 i przyjeżdża o godz. 10.00.

(4) Klient: wezmę pierwszy.

GUS: W czyim imieniu powinienem dokonać rezerwacji?

(5) Klient: Dan Bobrow.

GUS: Zatwierdziłem następującą walkę: P.SA. lot 102 w środę 28 maja z San Jose do San Diego, który odjeżdża o godz. 7.30 i przybywa o godz. 9.15. Kiedy chcesz wrócić?

(6) Klient: w piątek wieczorem.

GUS: Czy chciałbyś lot, który wyjdzie o 19:45?

(7) Klient: Świetnie

GUS: Zatwierdziłem następujący lot: P.S.A. lot 307 w piątek 30 maja z San Diego do San Jose, który wylatuje o 19:45 i przylatuje o 21.30. Dzięki, że zadzwoniłeś. Do widzenia.

Chociaż możliwości systemu były z pewnością ograniczone, GUS był w stanie poradzić sobie z wieloma problemami. Jeden z nich dotyczy tego, co badacze NLP nazywają "rozwiązywaniem anafory", przez co rozumieją obiekty lub zdarzenia, do których odnoszą się różne słowa lub frazy w oknie dialogowym. Kilka przykładów, wpisanych w zdania numerowane w powyższym oknie dialogowym, wymieniono w artykule o GUS. Na przykład w wierszu (3) zapytanie klienta odnosi się do kłótni wspomnianych w wypowiedzi GUS bezpośrednio poprzedzającej. W (4) jest odniesienie do walki wspomnianej wcześniej w rozmowie, [po linii (2)]. Zauważ, że "następna walka" w (3) miała być interpretowana w odniesieniu do kolejności walk w przewodniku linii lotniczych, podczas gdy "pierwsza" w (4) odnosi się do kolejności, w jakiej wspomniane były walki. Kolejne ukryte odniesienie leży u podstaw użycia "piątku" do określenia daty w (6). Rozwiązanie tego odniesienia wymaga skomplikowanego uzasadnienia obejmującego zarówno treść, jak i kontekst rozmowy. Ponieważ 28 maja podano jako datę wyjazdu, klient prawdopodobnie musi być w następny piątek. Z drugiej strony załóżmy, że specyfikacje zostały odwrócone, a piątek podano jako datę wyjazdu w wierszu (1). Byłoby to wtedy najłatwiejsze do zinterpretowania jako odnoszące się do piątku bezpośrednio po rozmowie. GUS był kombinacją kilku komunikujących się podsystemów, a analizator morfologiczny do radzenia sobie ze składnikami słów, analizator składniowy do generowania drzew parsowanych, "uzasadnienie" pozwalające poznać znaczenie i intencje użytkownika oraz generator języka odpowiadający. Kontrolowanie tych komponentów odbywało się za pomocą mechanizmu "porządku obrad". Jak wyjaśniają autorzy, GUS działa w cyklu, w którym analizuje ten program, wybiera następne zadanie do wykonania i robi to. Zasadniczo wykonanie wybranego zadania powoduje, że wpisy dotyczące nowych zadań są tworzone i umieszczane w porządku obrad. Generowanie tekstu wyjściowego można w dowolnym momencie wywołać za pomocą procesów wnioskowania, a dane wejściowe od klienta są obsługiwane za każdym razem, gdy się pojawią. Są miejsca, w których informacje z późniejszego etapu (na przykład dotyczące semantyki) są przekazywane z powrotem do wcześniejszego etapu ( takich jak parser). Proces nadzorczy może zmienić porządek obrad w dowolnym momencie. Składniowy składnik GUS miał "dostęp do głównego słownika zawierającego ponad 3000 rdzeni i prostych idiomów". Analizator składniowy został oparty na systemie opracowanym wcześniej przez Ronalda Kaplana, który wykorzystywał gramatykę sieci przejściowej i został nazwany "Ogólnym procesorem syntaktycznym". Zdania klientów zostały zakodowane w "ramkach" (które są związane z ramkami Minsky′ego, ale bliżej w formie sieci semantycznych). Niektóre ramki opisują sekwencję normalnego dialogu, podczas gdy inne przedstawiają atrybuty daty, planu podróży lub podróżny. Składnik wnioskowania GUS wykorzystał zawartość i strukturę ramek, aby wydedukować, jak najlepiej interpretować zdania klientów .Oprócz anafory w dokumencie wspomniano o kilku innych problemach, z którymi GUS był w stanie poradzić sobie. Ostrzegł jednak również, że "o wiele łatwiej jest ekstrapolować z [przykładowego okna dialogowego] błędne przekonanie, że GUS zawiera rozwiązania znacznie większej liczby problemów niż miało to miejsce". Przykładowe dialogi zarejestrowane między ludzkimi klientami a ludźmi odgrywającymi rolę GUS ujawniły liczne przypadki awarii komputera GUS. Autorzy doszli do wniosku, że jeśli użytkownicy systemów takich jak GUS odstąpią "od zachowania, którego się od nich oczekują w najdrobniejszych szczegółach, lub jeśli pozornie nieznaczne zmiany zostaną wprowadzone do struktury a systemy działałyby tak, jakby miały "rażącą afazję"lub po prostu umarły. Autorzy przyznali, że" sam GUS nie jest bardzo inteligentny, ale ilustruje to, co uważamy za niezbędne elementy [rozumienia języka inteligentnego ] system… [Musi mieć wysokiej jakości analizator składni, komponent uzasadnienia i dobrze ustrukturyzowaną bazę wiedzy. "Kolejne prace nad NLP w PARC i wielu innych miejscach miały na celu ulepszenie wszystkich tych komponentów. Systemy opracowane przez badaczy takich jak Winograd , Woods, Bobrow i ich koledzy byli bardzo imponującymi krokami w kierunku konwersacji z komputerami w języku angielskim, ale wciąż było wiele do zrobienia, zanim systemy rozumienia języka naturalnego będą mogły działać w sposób przewidziany przez Winograda we wstępie do jego doktoratu. rozprawa: wyobraźmy sobie nowy sposób korzystania z komputerów, aby mogli oni przyjmować instrukcje w sposób odpowiadający ich pracy. Porozmawiamy z nimi tak, jak rozmawiamy z asystentem naukowym, bibliotekarzem lub sekretarką, a oni przeprowadzą nasze polecenia i przekaż nam informacje, o które prosimy. Jeśli nasze instrukcje nie będą wystarczająco jasne, poproszą o nie