Japończycy tworzą Stir

Projekt systemów komputerowych piątej generacji

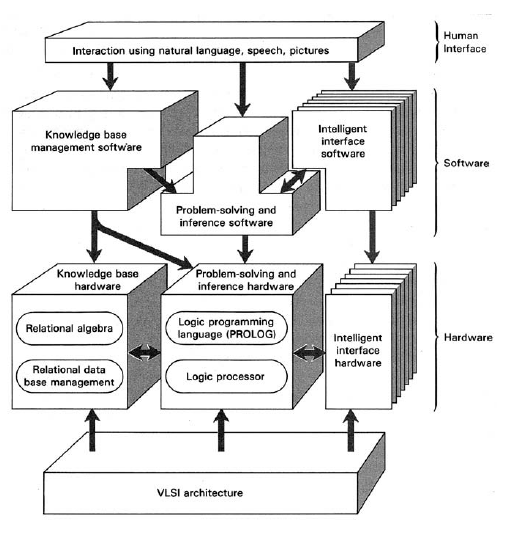

W 1982 r. Japońskie Ministerstwo Handlu Międzynarodowego i Przemysłu (MITI) zainicjowało wspólny projekt rządowy i branżowy w celu opracowania tak zwanych "systemów komputerowych piątej generacji" (FGCS). Jego celem było stworzenie komputerów, które mogłyby przeprowadzać wnioskowania w stylu AI z dużych baz danych i wiedzy oraz komunikować się z ludźmi przy użyciu języka naturalnego. Jak to ujęto w jednym z raportów na temat projektu: "Oczekuje się, że systemy te będą miały zaawansowane możliwości oceny w oparciu o funkcje wnioskowania i bazy wiedzy oraz możliwości realnej interakcji dzięki funkcji inteligentnego interfejsu". Fraza "Piąta generacja" miała podkreślać dramatyczny postęp w stosunku do poprzednich "generacji" technologii komputerowej. Pierwsza generacja, opracowana podczas II wojny światowej i po niej, wykorzystywała lampy próżniowe. Około 1959 r. tranzystory zastąpiły lampy próżniowe - dając początek drugiej generacji -chociaż tranzystory, podobnie jak przed nimi lampy próżniowe, były nadal połączone ze sobą oraz z innymi elementami obwodu za pomocą drutów miedzianych. W latach 60. tranzystory i inne komponenty były wytwarzane na pojedynczych "chipach" płytek krzemowych, a kilka układów scalonych zawierających komputer połączono ze sobą drutami. Komputery wykorzystujące tę tak zwaną technologię integracji na małą skalę (SSI) stanowiły trzecią generację. Pod koniec lat siedemdziesiątych całe mikroprocesory można było umieścić w jednym układzie za pomocą technologii "bardzo dużej integracji" (VLSI) - czwartej generacji. Japońska piątej generacji, oprócz wyrafinowanego oprogramowania, miała obejmować wiele równoległych procesorów wykorzystujących "ultra dużą-skalowaną integrację "(ULSI). MITI planowało opracowanie prototypowej maszyny w formie, którą informatycy zaczęli nazywać "stacją roboczą", która miała składać się z kilku równolegle działających procesorów i mających dostęp do wielu baz danych i wiedzy. PROLOG, język programowania komputera oparty na logika miała być "językiem maszynowym" dla systemu, ponieważ Japończycy uważali, że będzie on odpowiedni do przetwarzania języka naturalnego, rozumowania eksperckiego i innych aplikacji AI, które mieli na myśli. Wykonanie instrukcji PROLOG wymagało wnioskowania logicznego, więc wydajność maszyny miała być mierzona logicznymi wnioskami na sekundę (LIPS). Na początku lat 80. komputery były w stanie wykonać około 100 000 LIPS. Japończycy sądzili, że mogą przyspieszyć to 1000 razy i więcej. Później w projekcie, z powodu trudności z przystosowaniem PROLOGA do współbieżnego działania na wielu procesorach, opracowano nowy język oparty na logice, GHC (dla klauzul strzeżonych rogów), który może działać na wielu jednostki przetwarzania. W celu pracy nad FGCS, MITI powołało specjalny instytut o nazwie "Institute for New Generation Computer Technology" (ICOT). Centrum badawcze, kierowane przez pana Kazuhiro Fuchi , miało przeprowadzić podstawowe badania potrzebne do opracowania prototypowego systemu. Według raportu z pierwszego roku postępu "Centrum badawcze rozpoczęło pracę od czterdziestu najwyższej klasy naukowców z Laboratoriów Elektrotechnicznych (ETL), Nippon Telephone and Telegraph Public Corporation (NTT) oraz ośmiu producentów komputerów". Projekt miał dziesięcioletni plan: trzy lata początkowych badań, cztery lata budowy pośrednich podsystemów i ostatnie trzy lata na ukończenie prototypu. W 1993 r. Projekt przedłużono o dwa lata w celu rozpowszechnienia technologii FGCS. Koichi Furukawa, japoński informatyk, odegrał ważną rolę w decyzji ICOT o użyciu PROLOG-a jako języka podstawowego dla maszyny piątej generacji. Furukawa spędził rok w SRI w latach siedemdziesiątych, gdzie dowiedział się o PROLOGU od Harry'ego Barrowa i innych. Furukawa był pod wrażeniem tego języka i zabrał ze sobą tłumacza Alaina Colmerauera (napisany w FORTRAN) z powrotem do Japonii. Później dołączył do ICOT, ostatecznie zostając zastępcą dyrektora. (Obecnie jest emerytowanym profesorem na Uniwersytecie Keio.) Architektura planowanego systemu piątej generacji jest zilustrowana na rysunku

Różne moduły sprzętowe do obsługi bazy wiedzy, wnioskowania i funkcji interfejsu miały zostać wdrożone przy użyciu zaawansowanej technologii chipowej. Sprzęt byłby kontrolowany za pomocą odpowiednich modułów oprogramowania, a interakcja z systemem odbywałaby się za pomocą mowy, języka naturalnego i obrazów. Według zestawu slajdów Shunichi Uchidy podsumowujących projekt FGCS , jego całkowity dziesięcioletni budżet wynosił 54,2 miliarda U54, czyli około (według kursu z 1990 roku) 380 milionów USD. W tym czasie projekt poczynił postępy w przetwarzaniu równoległym, architekturze komputerowej i opracowywaniu różnych systemów AI. Kilku odwiedzających z USA i Europy (zwłaszcza ekspertów PROLOG) uczestniczyło w projekcie jako goście ICOT. Rzeczywiście, Japończycy zaprosili międzynarodowy udział w projekcie. Międzynarodowe konferencje odbyły się w Tokio w 1984, 1988 i 1992.ICOT zbudował wiele "równoległych maszyn wnioskowania "(PIM). Największa z nich, o nazwie PIM / p, miała 512 jednostek przetwarzających. Opracowano kilka systemów AI do pracy na tych maszynach. MGTP (akronim od Model Generation Theorem Prover), równoległy do twierdzenia o twierdzeniach; MENDELS ZONE, system do automatycznego generowania programów; i HELIC-II, system ekspercki do rozumowania prawnego. Wielu obserwatorów uważa, że większość wyników projektu FGCS są teraz tylko przedmiotem historycznym. Opracowane oprogramowanie nie zawierało znaczących aplikacji. Ulepszenia szybkości i mocy komercyjnych stacji roboczych (a nawet osobistych użytkowników) sprawiły, że były one lepsze niż PIM. W pełni wykorzystując zalety przetwarzania równoległego okazało się trudne, z wyjątkiem szczególnych problemów podatnych na ten styl obliczeń. Opracowanie graficznych interfejsów użytkownika (GUI) pod koniec lat 80. i 90. XX wieku zapewniło akceptowalne metody interakcji człowieka z komputerem { przynajmniej na jakiś czas) potrzeba zależnych od AI systemów rozumienia języka i mowy. Jednym z dziedzictwa projektu jest czasopismo New Generation Computing, którego Koichi Furukawa był kiedyś redaktorem naczelnym.

Te podstawowe badania doprowadziły również do powstania silnego zestawu udanych aplikacji w dziedzinach tak różnorodnych, jak dowodzenie twierdzeń i obliczenia biologiczne. W szerszym zakresie projekt odniósł sukces pod względem badań, które przeprowadził w podobnych projektach międzynarodowych, takich jak ALVEY, ECRC, ESPRIT, INRIA i MCC. Organizacje te uczyły się od siebie nawzajem, a ich konkurencyjność akademicka w badaniach podstawowych popchnęła je do osiągnięcia szerszego zakresu sukcesów. W tym sensie społeczność informatyczna jest bardzo wdzięczna za wysiłek "piątej generacji. Oddzielnie od tego, co można było osiągnąć podczas projektu, ogłoszenia o tym w 1980 i 1981 r. Wywołały podobne projekty w Stanach Zjednoczonych i w Europie Wiadomości na temat projektu zostały rozpowszechnione we wczesnym dokumencie zatytułowanym "Raport wstępny na temat piątej generacji komputerów", który został rozpowszechniony wśród kilku badaczy informatyki jesienią 1980 r. Również międzynarodowa konferencja na temat projektu FGCS odbyło się w Tokio w październiku 1981 r.

Niektóre skutki japońskiego projektu

The Microelectronics and Computer Technology Corporation

Zapowiedzi MITI dotyczące planów systemu komputerowego piątej generacji i powstania ICOT wywołały alarm w Stanach Zjednoczonych i Europie. Amerykański przemysł komputerowy, zbyt świadomy rosnącej japońskiej dominacji w elektronice użytkowej i produkcji, martwił się, że jego obecne światowe przywództwo w dziedzinie technologii komputerowej może ulec erozji. William Norris, założyciel Control Data Corporation, zorganizował w lutym 1982 r. spotkanie dyrektorów branży komputerowej w Orlando na Florydzie, aby omówić utworzenie konsorcjum badawczo-rozwojowego. Jego celem byłoby opracowanie technologii, które firmy członkowskie mogłyby ostatecznie wykorzystać w swoich produktach. Spotkanie to doprowadziło pod koniec 1982 r. i na początku 1983 r. Do powstania non-profit Microelectronics and Computer Technology Corporation (MCC) w Austin w Teksasie. Admirał Bobby Ray Inman, były dyrektor Narodowej Agencji Bezpieczeństwa i zastępca dyrektora Centralnej Agencji Wywiadowczej, został wybrany na pierwszego prezydenta, przewodniczącego i dyrektora naczelnego. Wśród pierwszych członków konsorcjum były: Digital Equipment Corporation, Harris, Control Data, Sperry-Univac, RCA, NCR, Honeywell, National Semiconductor, Advanced Micro Devices oraz Motorola. Później dołączyło do nich kilka innych, w tym Microsoft, Boeing, GE, Lockheed, Martin Marietta, Westinghouse, 3M, Rockwell i Kodak. Roczny budżet miał wynosić od 50 do 100 milionów USD - w zależności od liczby firm członkowskich wnoszących fundusze i personelu badawczego. Na początku MCC koncentrowało się na czterech głównych obszarach badawczych, a mianowicie na zaawansowanych architekturach komputerowych, technologii oprogramowania, opakowaniach mikroelektronicznych i wspomaganym komputerowo projektowaniu obwodów VLSI. Badania AI miały zostać przeprowadzone (pod ewentualnym kierownictwem Woodrowa Bledsoe) w ramach badań architektury. Chociaż firmy członkowskie korzystały z niektórych innowacji sponsorowanych przez MCC, samo MCC zaczęło podupadać po odejściu z Inman w 1987 roku. W tym czasie FGCS było postrzegane jako mniej groźne, a wiele firm członkowskich miało własne trudności finansowe. Internet i gwałtowny rozwój i moc komputerów osobistych zaczęły przyćmić to, co działo się w MCK. Liczba pracowników spadła ze szczytowego poziomu około 400 w 1985 r. Do 58 w czerwcu 2000 r., Kiedy zarząd głosował za rozwiązaniem konsorcjum.

Program Alvey

W marcu 1982 r. Rząd brytyjski powołał komitet, który ma doradzać w sprawie zakresu wspólnego programu badawczego w dziedzinie technologii informatycznych (IT) i wydawać zalecenia. Przewodniczył mu John Alvey, starszy dyrektor British Telecommunications. W swoim raporcie, wydanym później tego samego roku, zatytułowanym "Program dla zaawansowanych technologii informatycznych", "Komitet zauważył, że japoński projekt FGCS był postrzegany jako "poważne zagrożenie dla konkurencji " i że oczekiwane reakcje Stanów Zjednoczonych na nie wywołałyby" równy, jeśli nie większy stopień konkurencji dla przemysłu brytyjskiego." W raporcie zalecono "program pięcioletni mający na celu zmobilizowanie brytyjskich sił technicznych w dziedzinie IT, poprzez wspierany przez rząd wysiłek współpracy między przemysłem, sektorem akademickim i innymi organizacjami badawczymi. Celem [było rozwinięcie] silnych zdolności Zjednoczonego Królestwa w podstawowe technologie wspomagające, niezbędne dla przyszłej konkurencyjności Wielkiej Brytanii na światowym rynku IT ". Cztery główne obszary techniczne wskazane do wsparcia to "Inżynieria oprogramowania, Interfejsy człowiek-maszyna (MMI), Inteligentne systemy oparte na wiedzy (IKBS) i Integracja bardzo dużej skali (VLSI)". Zalecany budżet wynosił 350 milionów dolarów, a rząd wnosi dwie trzecie kosztów, a resztę przemysłu. W 1983 r. Rząd Zjednoczonego Królestwa przyjął raport komitetu i zainicjował program "Alvey" w celu realizacji zaleceń komitetu. W celu powołania nowej dyrekcji pod przewodnictwem Briana Oakleya, sekretarza Rady ds. Badań Naukowych i Inżynieryjnych (SERC) Departament Handlu i Przemysłu (DTI) do koordynowania programu. DTI, Ministerstwo Obrony (MoD), SERC i przemysł zapewniły sponsoring i fundusze. Oprócz innych osiągnięć program Alvey pomógł ożywić badania nad AI w Wielkiej Brytanii. dla Oakleya: "Jeśli raport Lighthill z początku lat 70. był rajem dla społeczności AI, raport Alvey z początku lat 80. XX wieku został odzyskany w raju." Program osiągnął szczytowy poziom finansowania wynoszący około 45 milionów dolarów w 1987 r. i trwał do 1991. Uważa się, że zasila brytyjską społeczność naukowa poprzez zwiększenie wysiłków badawczych i rozwojowych zarówno w środowisku akademickim, jak i przemysłowym. W doskonałym podsumowaniu programu, opublikowanym w 1990 r., Brian Oakley i Kenneth Owen opisują wkład Alvey w sztuczną inteligencję, architekturę równoległą, VLSI, układ scalony CAD, inżynierię oprogramowania i technologię mowy.

ESPRIT

W 1983 r. Europejska Wspólnota Gospodarcza (poprzedniczka Unii Europejskiej) rozpoczęła program ESPRIT. (ESPRIT jest akronimem europejskiego strategicznego programu badań w dziedzinie technologii informatycznych). Według Luca Steelsa i Brice Lepape, który napisał artykuł koncentrujący się na aspektach AI ESPRIT, jego celem było "wspieranie ponadnarodowych badań współpracy między branżami, organizacjami badawczymi oraz instytucje akademickie we Wspólnocie Europejskiej (WE). " Była to także odpowiedź europejska na japoński program FGCS. ESPRIT został utworzony w celu wspierania badań w trzech głównych kategoriach, a mianowicie w mikroelektronice, systemach przetwarzania informacji (w tym oprogramowania i zaawansowanego przetwarzania informacji) oraz aplikacjach (w tym zintegrowanych komputerowo systemach produkcyjnych i biurowych). Przetwarzanie informacji, w ramach którego wspierano większość badań nad sztuczną inteligencją, zostało dalej podzielone na inżynierię wiedzy, zaawansowane architektury (w tym architektury komputerowe do przetwarzania symbolicznego) i zaawansowane interfejsy systemowe (aplikacje mowy, obrazu i multisensorowe). Przewidywano, że projekt ESPRIT będzie trwał 10 lat i będzie podzielony na dwie fazy: ESPRIT I i ESPRIT II. (Później dodano trzecią fazę.) Początkowy budżet ESPRIT I wynosił 1,5 miliarda ECU. (Euro zastąpiło ECU w styczniu 1999 r. Przy jednym ECU = 1 euro.) Środki byłyby zapewnione w równym stopniu między WE a uczestnikami projektu. Budżet ESPRIT II był ponad dwukrotnie większy niż ESPRIT I. Według Luca Steelsa i Brice Lepape do 1993 r. W programie było "ponad 6000 naukowców i inżynierów z około 1500 organizacji pracujących nad projektami ESPRIT w całej WE i Europejskiej umowie o wolnym handlu kraje." Zamiast być kierowanym odgórnie przez kierowników programu, projekty finansowane przez ESPRIT wynikały z propozycji złożonych przez indywidualnych badaczy i organizacje. Propozycje zostały przeanalizowane przez rozproszony zespół ekspertów. Program promował propozycje podkreślające "ponadnarodowe sieci współpracy", działalność przemysłową i korzyści krótkoterminowe. ESPRIT współpracował z Alvey przy wspieraniu niektórych badań w Wielkiej Brytanii. ESPRIT wspierał kilka projektów związanych z AI. Wśród nich były takie, które opracowały różne systemy oparte na wiedzy, środowiska programowania logiki, systemy analizy języka naturalnego oraz systemy akwizycji wiedzy i uczenia maszynowego. Jako przykład mogę wspomnieć o "Machine Learning Toolbox" (MLT). Był to pakiet technik uczenia maszynowego, z którego programiści mogli wybierać i montować algorytmy odpowiednie do określonych rodzajów zadań. Partnerami w jego rozwoju były zespoły z Francji, Wielkiej Brytanii, Niemiec, Grecji i Portugalii. Artykuł Steels and Lepape zawiera dokładne podsumowanie wysiłków AI wspieranych przez ESPRIT.18 Osiągnięcia ESPRIT pomogły przezwyciężyć niechęć branży do AI. Mówiąc o krajowych wysiłkach w AI, wspomnę o Niemieckim Centrum Badań nad Inteligencją Sztuczną (DFKI, które oznacza Deutsches Forschungszentrum fur K unstliche Intelligenz). Został założony w 1988 roku i kontynuuje badania we wszystkich obszarach AI. W Stanach Zjednoczonych program DARPA analogiczny do Alvey i ESPRIT rozpoczął się na początku lat osiemdziesiątych. Było to częściowo odpowiedzią na japoński projekt FGCS, ale zawdzięczał także spostrzeżenie, że nadszedł czas na duży program, który wykorzysta ciągły rozwój techniczny w dziedzinie technologii komunikacyjnej oraz sprzętu i oprogramowania komputerowego.