I.Historia

Wprowadzimy tu dziedzinę sztucznej inteligencji (AI) poprzez przegląd jej głównych tematów, historii, głównych obszarów badawczych i aktualnych trendów. Celem jest dostarczenie czytelnikowi wystarczającego kontekstu tła, aby zrozumieć i docenić kolejne części.

Przegląd głównych tematów

Historię sztucznej inteligencji można najlepiej zrozumieć w kontekście jej podstawowych zagadnień i kontrowersji. Poniżej znajduje się krótki wykaz takich różnic, zagadnień, tematów i kontrowersji AI. Byłoby dobrze o tym pamiętać podczas lektura reszty materiałów. Każdy z tematów zostanie rozwinięty i wyjaśniony w miarę rozwoju. Wiele z nich wynika z tego, że do dnia dzisiejszego nie ma uzgodnionej definicji inteligencji w społeczności badaczy AI.

Inteligentne oprogramowanie a modelowanie kognitywne. Sztuczna inteligencja zawsze była częścią informatyki, dyscypliny inżynierskiej mającej na celu tworzenie inteligentnych programów komputerowych - to znaczy inteligentnych produktów programowych zaspokajających ludzkie potrzeby. Zobaczymy kilka przykładów takiego inteligentnego oprogramowania. AI ma również swoją stronę naukową, która ma pomóc nam zrozumieć ludzką inteligencję. To przedsięwzięcie obejmuje budowanie systemów oprogramowania, które "myślą" w sposób podobny do człowieka, a także produkują modele obliczeniowe aspektów ludzkiego poznania. Te modele obliczeniowe dostarczają hipotezy dla kognitywistów.

Symboliczne AI w porównaniu do sieci neuronowych. Od samego początku sztuczna inteligencja została podzielona na dwa odrębne strumienie badawcze: symboliczną sztuczną inteligencję i sieci neuronowe. Symboliczna AI przyjęła pogląd, że inteligencję można osiągnąć poprzez manipulowanie symbolami w komputerze zgodnie z zasadami. Sieci neuronowe, czyli połączenie, jak to nazywali naukowcy kognitywni, zamiast tego próbowali tworzyć inteligentne systemy jako sieci węzłów, z których każdy zawiera uproszczony model neuronu. Zasadniczo różnica była między analogią komputerową a analogią mózgu, między wdrażaniem systemów sztucznej inteligencji jako tradycyjnych programów komputerowych i modelowaniem ich po systemach nerwowych.

Rozumowanie a percepcja. W tym przypadku rozróżnienie między inteligencją a rozumowaniem o wysokim poziomie podejmowania decyzji, np. w maszynie szachowej lub diagnostyce medycznej, a przetwarzaniem percepcyjnym na niższym poziomie, związanym np.z wizją maszynową - rozumieniem obrazów poprzez identyfikację obiektów i ich związków.

Rozumowanie a wiedza. Wcześni badacze symbolicznej sztucznej inteligencji skupili się na zrozumienie mechanizmów (algorytmów) używanych do wnioskowania w procesie podejmowania decyzji. Założono, że zrozumienie, w jaki sposób takie rozumowanie można osiągnąć w komputerze, byłoby wystarczające do zbudowania użytecznego inteligentnego oprogramowania. Później naukowcy zdali sobie sprawę, że aby zwiększyć skalę problemów związanych ze światem rzeczywistym, musieli zbudować znaczną ilość wiedzy w swoich systemach. System diagnozy medycznej musiał wiedzieć wiele na temat medycyny, aby móc to zrobić wyciągnąć cenne wnioski.

Reprezentowania lub nie. Ta wiedza musiała być w jakiś sposób reprezentowana w systemie; to znaczy, system musiał jakoś modelować swój świat. Taka reprezentacja może przybierać różne formy, w tym zasady. Później pojawiły się kontrowersje co do tego, jak wiele z takich modelowań faktycznie trzeba wykonać. Niektórzy twierdzili, że wiele można osiągnąć bez rozległego modelowania wewnętrznego.

Mózg w kadzi kontra ucieleśniona sztuczna inteligencja. Wczesne systemy AI wprowadzały ludzi wprowadzenie do systemów i działanie na wyjściu systemów. Podobnie jak "mózg w kadzi", systemy te nie wyczuwały świata ani nie działały na nim. Później badacze AI stworzyli wcielone lub usytuowane systemy AI, które bezpośrednio wyczuwały ich światy i działały bezpośrednio na nich. Roboty w świecie rzeczywistym są przykładami wcielone systemy AI.

Wąska sztuczna inteligencja w porównaniu z inteligencją na poziomie człowieka. W początkowej fazie badań nad sztuczną inteligencją wielu badaczy miało na celu stworzenie inteligencji na poziomie ludzkim w swoich maszynach, tak zwanya "silna sztuczna inteligencja". Później, gdy niezwykła trudność takiego przedsięwzięcia stała się bardziej oczywista, prawie wszyscy badacze AI zbudowali systemy, które działały inteligentnie w pewnej stosunkowo wąskiej dziedzinie, takiej jak szachy czy medycyna. Dopiero od niedawna nastąpił powrót w kierunku systemów zdolnych do tego bardziej ogólna inteligencja na poziomie ludzkim, która może być szeroko stosowana w różnych dziedzinach.

Niektóre kluczowe momenty w sztucznej inteligencji

McCulloch i Pitt

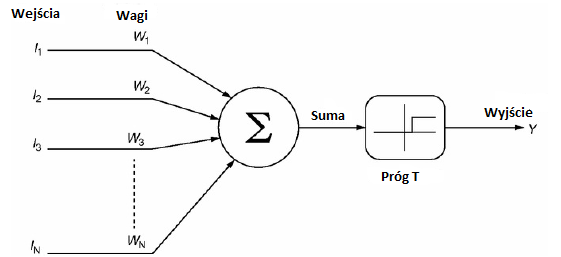

Sieć neuronowa AI rozpoczęła się bardzo wczesnym opracowaniem Warrena McCullocha i Waltera Pittsa (1943). McCulloch, profesor na Uniwersytecie w Chicago i Pitts, student studiów licencjackich, opracowali znacznie uproszczony model funkcjonującego neuronu, jednostki McCullocha-Pittsa. Pokazali, że sieci takich jednostek mogą wykonywać dowolne operacje logiczne (i, lub, nie), a zatem wszelkie możliwe obliczenia. Każda z tych jednostek porównywała ważoną sumę swoich wejść do wartości progowej, aby wytworzyć wyjście binarne. W ten sposób narodziła się sieć neuronowa AI, a także neuronauka obliczeniowa.

Alan Turing

Alan Turing, matematyk z Cambridge z pierwszej połowy XX wieku, można go uznać za ojca komputerów (jego dziadkiem był Charles Babbage z połowy XIX wieku) i dziadka AI. Podczas II wojny światowej w latach 1939-1944 Turing kierował opracowaniem brytyjskiego Bombe, wczesnej maszyny obliczeniowej, która była wielokrotnie używana do dekodowania wiadomości zakodowanych za pomocą Enigmy. Na początku XX wieku Turing i inni interesowali się kwestiami obliczalności. Chcieli sformalizować odpowiedź na pytanie, które problemy można rozwiązać obliczeniowo, a kilka osób wypracowało w rezultacie różne formalizmy. Turing zaoferował maszynę Turinga (1936), Alonzo Church the Lambda Calculus (1936) a Emil Post the Production System (1943). Te trzy pozornie zupełnie różne systemy formalne wkrótce okazały się być logicznie równoważnymi w definiowaniu obliczalności, to znaczy określania tych problemów, które mogą być rozwiązane przez program działający na komputerze. Maszyna Turinga okazała się być najbardziej użyteczną

formalizacją i jest to najczęściej stosowana w teoretycznej informatyce. W 1950 r. Turing opublikował pierwszy artykuł sugerujący możliwość sztucznej inteligencji (1950 r.). W pierwszej kolejności opisał to, co teraz nazywamy testem Turinga, i zaproponował go jako wystarczający warunek istnienia sztucznej inteligencji. W teście Turinga testerzy rozmawiają w języku naturalnym bez ograniczeń przez terminale z ludzkim lub sztucznym językowym programem sztucznej inteligencji, ukrytym przed wzrokiem. Jeśli testerzy nie są w stanie w sposób niezawodny odróżnić człowieka od programu, inteligencja jest przypisana do programu. W roku 1991 Hugh Loebner ustanowił Nagrodę Loebnera, która przyznawała 100 000 $ na pierwszy program AI, który zaliczył test Turinga.

Warsztaty w Dartmouth

Warsztaty w Dartmouth posłużyły naukowcom w nowo powstającym polu do współpracy i wymiany pomysłów. Odbywające się w sierpniu 1956 roku warsztaty oznaczają narodziny sztucznej inteligencji. AI wydaje się być sama wśród dyscyplin, jeśli chodzi o urodziny. Jej rodzicami byli John McCarthy, Marvin Minsky, Herbert Simon i Allen Newell. Innymi znanymi uczestnikami byli Claude Shannon z teorii informacji, Oliver Selfridge, twórca teorii Pandemonium i Nathaniel Rochester, główny projektant bardzo wczesnego komputera IBM 701. John McCarthy, jest uznany za twórcę nazwy Sztuczna inteligencja. Był także wynalazcą LISP-a, dominującego języka programowania AI przez pół wieku. McCarthy następnie dołączył do wydziału MIT, a następnie przeniósł się do Stanford, gdzie założył swoje AI Lab. Pozostał aktywnym badaczem AI aż do swojej śmierci w 2011 roku. Marvin Minsky pomógł założyć MIT AI Lab, gdzie pozostał aktywnym i wpływowym badaczem sztucznej inteligencji. Herbert Simon i Allen Newell wprowadzili jedyny działający program AI, teoretykę logiki, do Warsztatu Dartmouth. Operacja ta odbywała się za pomocą analizy środków, algorytmu planowania AI. Na każdym etapie próbował wybrać operację (środki), która przesunęła system bliżej celu (końca). Simon i Newell założyli laboratorium badawcze AI na Uniwersytecie Carnegie Mellon. Newell zmarł w 1992 r., A Simon w 2001 r

Warcaby Samuela

Każdy informatyk komputerowy wie, że komputer wykonuje tylko algorytm zaprogramowany do działania. Dlatego można by pomyśleć, że może robić tylko to, co polecił jej programista. Nie wie nic o tym, czego jej programista nie zrobił, ani nic, czego jego programista nie mógłby. Ten pozornie logiczny wniosek jest po prostu błędny, ponieważ ignoruje możliwość zaprogramowania komputera do nauki. Takie uczenie maszynowe, które później stało się głównym poddziedziną sztucznej inteligencji, zaczęło się od programu wacabów Arthura Samuela (1959). Chociaż Samuel początkowo mógł pokonać swój program, po kilku miesiącach nauki mówi się, że nigdy nie wygrał z nim kolejnej gry. Narodziło się uczenie maszynowe

Rozprawa Minsky′ego

W 1951 roku Marvin Minsky i Dean Edmonds zbudowali SNARC, pierwszą sztuczną sieć neuronową, która symulowała szczura z labiryntem. Praca ta była podstawą rozprawy Minsky′ego z Princeton (1954). Tak więc jeden z założycieli i głównych graczy w symbolicznej sztucznej inteligencji był początkowo bardziej zainteresowany sieciami neuronowymi i przygotował scenę do ich implementacji obliczeniowej

Perceptrony i sieć neuronowa

Perceptron Franka Rosenblatta (1958) należał do najwcześniejszych sztucznych sieci neuronowych. Dwuwarstwowa sieć neuronowa najlepiej postrzegana jako binarny system klasyfikacyjny, perceptron odwzorowuje swój wektor wejściowy na sumę ważoną podlegającą progowi, dając odpowiedź tak lub nie. Atrakcyjność perceptronu wynikała z nadzorowanego algorytmu uczenia, za pomocą którego można nauczyć perceptron poprawnie klasyfikować. W ten sposób sieci neuronowe przyczyniły się do uczenia maszynowego. Badania nad perceptronami zakończyły się niesławnym zakończeniem publikacji książki Minsky i Papert Perceptrons (1969), w której pokazali, że perceptron nie jest w stanie nauczyć się klasyfikować jako prawdziwych lub fałszywych danych wejściowych do tak prostych systemów, jak wyłączne "lub" (XOR - albo A albo B, ale nie oba) .Minsky i Papert również przypuszczali, że nawet wielowarstwowe perceptrony mają podobne ograniczenia. Choć to przypuszczenie okazało się w większości fałszywe, agencje rządowe finansujące badania nad sztuczną inteligencją potraktowały to poważnie. Finansowanie badań sieci neuronowej wyschło, co doprowadziło do powstania sieci neuronowej, która nie zmniejszyła się do czasu opublikowania równoległego przetwarzania w połowie lat 80.

Geneza głównych obszarów badawczych

Na początku swojej historii nacisk na badania nad sztuczną inteligencją polegał w dużej mierze na tworzeniu systemów, które mogłyby prowadzić do wysokich, stosunkowo abstrakcyjnych, ale sztucznych problemów - problemów, które wymagałyby inteligencji, gdyby były podejmowane przez człowieka. Jednym z pierwszych takich systemów był ogólny problem Simona i Newella, który podobnie jak jego poprzednik, teoretyk logiki, użył analizy środków do rozwiązania różnych zagadek. Jeszcze innym wczesnym systemem rozumowania było twierdzenie Gelerntera o geometrii. Innym ważnym poddziedztwem sztucznej inteligencji jest przetwarzanie języka naturalnego, związane z systemami, które rozumieją język. Jednym z pierwszych takich był SHRDLU (Winograd 1972), nazwany na podstawie kolejności kluczy na maszynie linotypowej. SHRDLU może zrozumieć i wykonać polecenia w języku angielskim, nakazując mu manipulowanie drewnianymi klockami, stożkami, kulami itp. Za pomocą ramienia robota w świecie znanym jako "świat bloków". SHRDLU był wystarczająco wyrafinowany, aby móc korzystać z zapamiętanych kontekstów rozmowy w celu ujednoznacznienia odniesień. Nie trwało to jednak długo, zanim naukowcy z AI zdali sobie sprawę, że rozumowanie nie było wszystkim w inteligencji. Próbując skalować swoje systemy, aby poradzić sobie z problemami świata rzeczywistego, popadli prosto w ścianę braku wiedzy. Prawdziwe problemy wymagały, aby solver coś wiedział. Tak narodziły się systemy oparte na wiedzy (często nazywane systemami eksperckimi). Nazwa pochodzi od procesu inżynierii wiedzy: inżynierowie wiedzy pracowicie wyciągają informacje od ludzkich ekspertów, a następnie kodują tę wiedzę w swoich systemach ekspertowych. Prowadzony przez chemika Joshua Lederberga i badaczy AI Edwarda Feigenbauma i Bruce'a Buchanana, pierwszy taki system ekspercki, zwany DENDRAL, był ekspertem w dziedzinie chemii organicznej. Projekt DENDRAL pomógł zidentyfikować strukturę molekularną cząsteczek organicznych, analizując dane ze spektrometru mas i wykorzystując jego znajomość chemii . Projektanci DENDRAL dodali wiedzę do mechanizmu leżącego u podstaw mechanizmu wnioskowania, aby stworzyć system ekspercki zdolny poradzić sobie ze złożonym, realnym problemem. Drugi taki system ekspercki, zwany Mycin, pomógł lekarzom zdiagnozować i leczyć zakaźne choroby krwi i zapalenie opon mózgowych. Podobnie jak DENDRAL, Mycin opierał się zarówno na ręcznej wiedzy eksperckiej, jak i opartym na regułach mechanizmie wnioskowania. System odniósł sukces, ponieważ mógł diagnozować trudne przypadki, jak również najbardziej doświadczonych lekarzy, ale nie powiodło się, ponieważ nigdy nie było obsadzone. Wprowadzanie informacji do Mycina wymagało około dwudziestu minut. Lekarz spędziłby co najwyżej pięć minut na postawienie diagnozy.

Badanie podczas zimy dla sieci neuronowej

Jak już zauważono, Perceptrons Minsky'ego i Paperta (1969) błędnie przekonali rządowe agencje finansujące, że podejście sieci neuronowej było mało obiecujące, prowadząc do zimy dla sieci neuronowej, która trwała prawie dwadzieścia lat. Pomimo tego zatrważającego braku funduszy nadal prowadzono znaczące badania na całym świecie. Nieustraszeni badacze, którzy w jakiś sposób zdołali utrzymać te ważne badania, dołączyli Shun-ichi Amari i Satoru Fukushima w Japonii, Stephen Grossberg i John Hopfield w Stanach Zjednoczonych, Teuvo Kohonen w Finlandii i Christoph von der Malsburg w Niemczech. Znaczna część tej pracy dotyczyło samoorganizacji sieci neuronowych i uczenia się w nich. Wiele motywowało również pochodzenie tych badaczy z neuronauki.

Powstanie związku

Koniec zimy dla sieci neuronowej został przerwany przez opublikowanie dwóch tomów Równoległe Przetwarzanie Rozproszone. Były to dwa masowo zmontowane tomy z rozdziałami autorstwa członków grupy badawczej PDP, a następnie na Uniwersytecie Kalifornijskim w San Diego. Tomy te dały początek stosowaniu sztucznych neuronowych sieci, które wkrótce zostaną nazwane połączeniami, w kognitywistyce. Czy połączenie było do wykonania w wyjaśnieniu umysłu szybko stało się gorącym tematem debaty wśród filozofów, psychologów i badaczy AI. Debata wygasła bez deklarowanego zwycięzcy, ale ze sztucznymi sieciami neuronowymi staje się ugruntowanym graczem w obecnej SI. Oprócz ich sukcesu (pod postacią połączenia) do modelowania kognitywnego sztuczne sieci neuronowe znalazły wiele praktycznych zastosowań. Większość z nich obejmuje rozpoznawanie wzorców. Obejmują one inwestowanie w fundusze inwestycyjne, wykrywanie oszustw, punktację kredytową, wycenę nieruchomości i wiele innych. Ta szeroka możliwość zastosowania była przede wszystkim wynikiem szeroko stosowanego algorytmu szkoleniowego o nazwie backpropagation. Choć później prześledzono wiele wcześniejszych prac, backpropagacja została ponownie odkryta przez grupę badawczą PDP i stanowiła główne narzędzie do badań zgłoszonych w dwóch tomach PDP

Zima A.I.

Z powodu tego, co okazało się przesadą potencjału i czasu sztucznej inteligencji, symboliczna SI doznała własnej zimy. Dla przykładu, w 1965 roku Herbert Simon przewidział, że "maszyny będą zdolne, w ciągu dwudziestu lat, wykonywać jakąkolwiek pracę, którą człowiek może wykonać." Ta i inne tego typu przewidywania nie spełniły się. W rezultacie do połowy lat osiemdziesiątych fundusze rządowe na AI zaczęły wysychać, a inwestycje komercyjne prawie nie istniały. Sztuczna inteligencja stała się słowem tabu w branży komputerowej przez dekadę lub dłużej, pomimo ogromnego sukcesu systemów eksperckich. Wiosna AI nie dotarła aż do nadejścia następnej aplikacji "killer", gier wideo.

Przetwarzanie miękkie

Termin "soft computing" odnosi się do pstrokatego zestawu technik obliczeniowych zaprojektowanych do radzenia sobie z niedokładnością, niepewnością, aproksymacją, częściowymi prawdami itd. Metody te mają raczej charakter indukcyjny niż dedukcyjny. Oprócz sieci neuronowych, o których już mówiliśmy, soft computing obejmuje obliczenia ewolucyjne, logikę rozmytą i sieci bayesowskie. Rozpatrzymy każdy z nich po kolei.

Obliczenia ewolucyjne rozpoczęły się od komputerowego odwzorowania naturalnej selekcjizwana algorytmem genetycznym. Algorytm wyszukiwania populacji, proces ten zazwyczaj rozpoczyna się od populacji sztucznych genotypów reprezentujących możliwe rozwiązania danego problemu. Członkowie tej populacji są poddawani mutacjom (zmiany losowe) i krzyżowaniu (ang. crossover, mieszanie dwóch genotypów). Powstałe nowe genotypy są wprowadzane do funkcji fitness, która mierzy jakość genotypu. Najbardziej udane z tych genotypów stanowią następną populację, a proces powtarza się. Jeśli są dobrze zaprojektowane, genotypy w populacji z biegiem czasu stają się podobne, zbliżając się do pożądanego rozwiązania i uzupełniając algorytm genetyczny. Ponadto obliczenia ewolucyjne obejmują również systemy klasyfikacyjne, które łączą koncepcje oparte na regułach i wzmocnieniu z algorytmami genetycznymi. Obliczenia ewolucyjne obejmują również programowanie genetyczne, metodę wykorzystywania algorytmów genetycznych do wyszukiwania programów komputerowych, zazwyczaj w LISP-ie, które rozwiążą dany problem. Opierając się na teorii zbiorów rozmytych Zadeha, w której przypisywane są stopnie przydziału od 0 do 1 (1965), logika rozmyta stała się ostoją miękkiego przetwarzania. Używając reguł if-then ze zmiennymi rozmytymi, logika rozmyta została zastosowana w wielu aplikacjach kontrolnych, w tym w sprzęcie gospodarstwa domowego, windach, oknach samochodowych, kamerach i grach wideo. (Referencje nie są podawane, ponieważ te komercyjne aplikacje są prawie zawsze zastrzeżone).

Sieć bayesowska, z węzłami reprezentującymi sytuacje, używa twierdzenia Bayesa o prawdopodobieństwie warunkowym do powiązania prawdopodobieństwa z każdym z jego łączy. Sieci bayesowskie były szeroko stosowane w modelowaniu kognitywnym, sieciach regulacji genów, systemach wspomagania decyzji i tak dalej. Stanowią integralną część soft computingu.

Ostatnie główne osiągnięcia

Zakończymy naszą krótką historię sztucznej inteligencji, przedstawiając niektóre z jej stosunkowo niedawnych głównych osiągnięć. Należą do nich systemy eksperckie, szachiści, dowcipy twierdzeń, przetwarzanie języka naturalnego i nowa aplikacja zabójcy. Każda z nich zostanie opisana po kolei

Systemy eksperckie oparte na wiedzy

Choć systemy eksperckie oparte na wiedzy pojawiły się stosunkowo wcześnie w historii sztucznej inteligencji, stały się ważną, ekonomicznie istotną aplikacją AI nieco później. Być może najwcześniejszym takim komercyjnie skutecznym systemem eksperckim był R1, później przemianowany na XCON (McDermott 1980). XCON zaoszczędził miliony DEC (Digitial Equipment Corporation), efektywnie konfigurując swoje komputery VAX przed dostawą, a nie po tym, jak inżynierowie DEC rozwiązali problemy po ich dostarczeniu. Inne podobne aplikacje, w tym systemy diagnostyczne i konserwacyjne dla kuchenek Campbell Soups i lokomotyw GE. Reklama Ford Motor Company dotycząca części maszyn produkcyjnych przewidywała, że taki system ekspercki w zakresie diagnostyki i konserwacji będzie częścią każdej propozycji. Jedna książka wyszczególniła 2500 systemów eksperckich. Systemy eksperckie stanowiła pierwszą aplikację zabójcy AI. To nie miało być ostatnie.

Deep Blue pokonująca Kasparova

Wczesne badania nad sztuczną inteligencją zwykle pracowały nad problemami, które wymagałyby inteligencji, gdyby były podejmowane przez człowieka. Jednym z takich problemów było granie w szachy. Gracze w szachy AI pojawili się niedługo po warcabach Samuela. Jednym z najbardziej udanych systemów szachowych był Deep Blue firmy IBM, który w 1997 roku pokonał mistrza świata, Gary&primle;ego Kasparowa, w sześciu meczach, spóźniając się z wcześniejszymi przewidywaniami Herberta Simona. Choć działa na specjalnie zbudowanym komputerze i ma dużo wiedzy o szachach, Deep Blue zależało ostatecznie od tradycyjnych algorytmów gier AI. Mecz z Kasparowem był triumfem AI.

Rozwiązanie przypuszczenia Robbinsa

Kolejny, jeszcze większy, triumf AI miał wkrótce nadejść. W artykule z 1933 roku E. V. Huntington przedstawił nowy zestaw trzech aksjomatów charakteryzujących algebrę Boole′a, formalny system matematyczny ważny dla teoretycznej informatyki. Trzeci z tych aksjomatów był tak złożony, że zasadniczo nie nadawał się do użytku. Dlatego motywowany Herbert Robbins wkrótce zastąpił ten trzeci aksjomat prostszym i domyślał się, że ten nowy zestaw trzech aksjomatów charakteryzuje również algebrę Boole′a. Ten domysł Robbinsa pozostał jednym z wielu takich w literaturze matematycznej, dopóki znaczący logik i matematyk Alfred Tarski nie zwrócił na to uwagi, zmieniając go w słynny nierozwiązany problem. Po ponad stuleciu sprzeciwu wobec wysiłków ludzkich matematyków, domysły Robbinsa ostatecznie poddały się twierdzeniu ogólnego przeznaczenia o automatycznym twierdzeniu AI o nazwie EQP (EQuational Prover ). Tam, gdzie ludzie zawiedli, EQP udowodniło, że hipoteza Robbinsa jest prawdziwa

Watson pokonuje ludzkich czempionów w grze Jeopardy

Jeopardy jest popularnym i długo działającym teleturniejem telewizyjnym, w którym uczestnicy otrzymują wskazówki w postaci odpowiedzi na rozległe pytania dotyczące ciekawostek i muszą odpowiedzieć na odpowiednie pytania tak szybko, jak to możliwe. Dwudziesty szósty sezon rozpoczął się w 2011 roku. W tym samym roku wyemitowano trzy wyjątkowe odcinki Jeopardy, w których dwaj najbardziej utytułowani mistrzowie i rekordziści zostali pokonani przeciwko sobie i przeciwko systemowi AI o nazwie Watson. (na cześć założyciela IBM). Korzystając z algorytmów przetwarzania języka naturalnego AI do zapytania około 200 milionów stron treści i odpowiadając w konwersacyjnym języku angielskim, Watson konsekwentnie osiągał lepsze wyniki niż jego dwaj przeciwnic

Gry - zabójcy aplikacji

Zatrudniając więcej praktyków sztucznej inteligencji niż jakakolwiek inna, przemysł gier komputerowych i wideo cieszy się pełną sukcesów sławą. Według jednego wiarygodnego źródła, Entertainment Software Association, całkowite wydatki USA na przemysł gier w 2012 r. przekroczyła 20 miliardów dolarów, a 188 milionów sprzedanych gier2. Rola AI w tym zdumiewającym sukcesie jest krytyczna; jego użycie jest niezbędne do wytworzenia potrzebnego inteligentnego zachowania ze strony wirtualnych postaci, które zapełniają gry. Wikipedia posiada wpis zatytułowany "sztuczna inteligencja gry", który zawiera historię coraz bardziej zaawansowanych technik sztucznej inteligencji wykorzystywanych w takich grach, a także odniesienia do kilkunastu książek na temat stosowania sztucznej inteligencji w grach. W tym piśmie wydaje się, że istnieje nieograniczone zapotrzebowanie na pracowników sztucznej inteligencji w branży gier. Ta bardzo popularna komercyjna aplikacja jest kolejnym triumfem dla sztucznej inteligencj

Główne obszary badawcze A.I.

Istnieje prawie tuzin różnych poddziedzin badań nad sztuczną inteligencją, z których każda ma własne specjalistyczne czasopisma, konferencje, warsztaty i tak dalej. Ta sekcja zawiera zwięzłe sprawozdanie z zainteresowań badawczych w każdym z tych subpól.

Reprezentacja wiedzy

Każdy system sztucznej inteligencji, czy to klasyczny system sztucznej inteligencji z ludźmi dostarczający dane wejściowe i wykorzystujący dane wyjściowe, czy też autonomiczny agent, musi w jakiś sposób przetłumaczyć wejście (bodźce) na informację lub wiedzę, które zostaną użyte do wyboru wyjścia (działania). Te informacje lub wiedza muszą być w jakiś sposób reprezentowane w systemie, aby można je było przetworzyć w celu ustalenia wyjście lub działanie. Problemy wywołane przez takie reprezentacje stanowią przedmiot badań w subdyscyplinie sztucznej inteligencji, zwanej powszechnie reprezentacją wiedzy. W systemach sztucznej inteligencji napotykamy wiedzę reprezentowaną za pomocą formalizmów logicznych, takich jak logika zdaniowa i rachunek predykatów pierwszego rzędu. Można również znaleźć reprezentacje sieci, takie jak sieci semantyczne, których węzły i łącza mają etykiety dostarczające treść semantyczną. Podstawową ideą jest to, że pojęcie reprezentowane przez węzeł zyskuje znaczenie poprzez swoje relacje (łącza) z innymi pojęciami. Stosowane są również bardziej złożone struktury danych, takie jak reguły produkcji, ramki i zbiory rozmyte. Każda z tych struktur danych ma własny typ rozumowania lub aparatu decyzyjnego, jego mechanizm wnioskowania. Wydaje się, że kwestia, czy reprezentować, czy nie, została domyślnie rozstrzygnięta, ponieważ argumenty ustały. Wydaje się, że Rodney Brooks z MIT AI Lab zdał sobie sprawę, że więcej znosili ten dzień, w którym reprezentacje są nadal szeroko stosowane. Wydaje się, że reprezentacje mają kluczowe znaczenie dla procesu decydowania, jakie działania podjąć, a tym bardziej dla procesu realizacji działania. To wydaje się być istotą problemu.

Wyszukiwanie heurystyczne

Problemy z wyszukiwaniem były badane w informatyce prawie od samego początku. Na przykład w problemie komiwojażera zadanie polega na znalezieniu najskuteczniejszej trasy, jaką powinien przejść sprzedawca, aby odwiedzić każde z N miast dokładnie jeden raz. Wszystkie znane algorytmy znalezienia optymalnych rozwiązań takiego problemu wzrastają wykładniczo z N, co oznacza, że w przypadku dużej liczby miast nie można znaleźć optymalnego rozwiązania. Jednak wystarczająco dobre rozwiązania można znaleźć za pomocą heurystycznych algorytmów wyszukiwania z AI. Takie algorytmy wykorzystują znajomość języka konkretna domena w postaci heurystyki, reguły, które nie gwarantują znalezienia najlepszego rozwiązania, ale które najczęściej znajdują wystarczająco dobre rozwiązanie. Takie heurystyczne algorytmy wyszukiwania są szeroko stosowane do planowania, eksploracji danych (odnajdywania wzorców w danych), problemów z ograniczeniem więzów, gier, wyszukiwania w Internecie i wielu innych podobnych aplikacji.

Planowanie

Planista AI to system, który automatycznie określa kolejność działań prowadzących od początkowego stanu rzeczywistego do pożądanego stanu celu. Planiści mogą być wykorzystywani na przykład do planowania pracy w hali produkcyjnej, aby znaleźć trasy do pakietu dostarczenie lub przypisać użycie teleskopu Hubble'a. Badania nad takimi programami planowania to główne poddziedzinie sztucznej inteligencji. Aplikacje polowe są zaangażowane w eksplorację kosmosu, logistykę wojskową oraz operacje i sterowanie zakład

Systemy eksperckie

Oparte na wiedzy systemy eksperckie omówiono w poprzednich sekcjach. Jako poddziedzina sztucznej inteligencji, badacze systemów eksperckich zajmują się rozumowaniem (ulepszaniem mechanizmów wnioskowania dla ich systemów), reprezentacją wiedzy (jak przedstawiać potrzebne fakty w swoich systemach) i inżynierią wiedzy (jak pozyskiwać wiedzę od ekspertów, która czasami jest niejawna) . Jak widzieliśmy, ich aplikacje są legionem

Widzenie maszynowe

Widzenie maszynowe lub komputera jest subpolem sztucznej inteligencji, poświęconym automatycznemu zrozumieniu obrazów wizualnych, zwykle fotografii cyfrowych. Wśród wielu jego zastosowań są inspekcja produktów, nadzór ruchu i wywiad wojskowy. Przy obrazach mnożących się co kilka sekund od satelitów, wysokolatających samolotów szpiegowskich i autonomicznych dronów, nie ma wystarczającej liczby ludzi, aby interpretować i indeksować obiekty na obrazach, aby można je było zrozumieć i zlokalizować. Badania nad automatyzacją tego procesu dopiero się rozpoczynają. Badania nad sztuczną inteligencją w zakresie widzenia maszynowego również zaczynają być stosowane w kamerach bezpieczeństwa, aby zrozumieć sceny i ostrzegać ludzi w razie potrzeby.

Uczenie maszynowe

Poddziedzina sztucznej inteligencji ,uczenie maszynowe zajmują się algorytmy, które umożliwiają uczenie się systemów A. Chociaż uczenie maszynowe jest tak stare, jak sama sztuczna inteligencja, jego znaczenie wzrosło, ponieważ coraz więcej systemów sztucznej inteligencji, szczególnie autonomiczne, działa w coraz bardziej złożonych i dynamicznie zmieniających się domenach. Znaczna część uczenia maszynowego to nadzorowane uczenie się, w którym system jest instruowany za pomocą danych treningowych. Systemy nieobsługiwane lub samoorganizujące się, jak wspomniano powyżej, stają się powszechne. Uczenie się wzmacniania, osiągane dzięki sztucznym nagrodom, jest typowe dla uczenia się nowych zadań. Istnieje nawet nowe poddziedzinie uczenia maszynowego poświęcone rozwojowej robotyki, robotom, które przechodzą szybką fazę wczesnego uczenia się, podobnie jak ludzkie dzieci.

Przetwarzanie języka naturalnego

Poddziedzina sztucznej inteligencji języka naturalnego obejmuje zarówno generowanie, jak i rozumienie języka naturalnego, zazwyczaj tekstu. Jego historia sięga wcześniej omówionego Testu Turinga. Dziś jest kwitnącą dziedziną badań nad tłumaczeniem maszynowym, udzielaniem odpowiedzi na pytania, automatycznym podsumowaniem, rozpoznawaniem mowy i innymi obszarami. Tłumaczenia maszynowe, choć zwykle tylko około 90 procent dokładne, mogą czterokrotnie zwiększyć produktywność tłumaczy. Opracowywane są systemy rozpoznawania tekstu do automatycznego wprowadzania historii medycznych. Rozpoznawanie głosu umożliwia wypowiadanie poleceń głosowych na komputerze, a nawet dyktowanie.

Agenci oprogramowania

Czynnik autonomiczny definiuje się jako system umiejscowiony w środowisku, które wyczuwa otoczenie i działa zgodnie z własnym planem, w taki sposób, że jego działania mogą wpływać na to, co później wyczuwa. Sztuczne środki autonomiczne obejmują oprogramowanie i niektóre roboty. Autonomicznie agenci oprogramowania występują w kilku odmianach. Niektórzy lubią autorską IDA "na żywo" w środowisku, w tym w bazach danych i Internecie, i autonomicznie wykonują określone zadanie, takie jak przydzielanie marynarzom nowych miejsc pracy po zakończeniu obowiązków służbowych. Inne, czasami nazywane awatarami, mają wirtualne twarze lub ciała wyświetlane na monitorach, które umożliwiają im bardziej naturalną interakcję z ludźmi, często dostarczając informacji. Jeszcze inni, zwani konwersacyjnymi wirtualnymi agentami, symulują ludzi i wchodzą w interakcję z nimi na czatach, niektórzy tak realistycznie, że są myleni z ludźmi. Wreszcie istnieją wirtualni agenci jako postacie w grach komputerowych i wideo

Inteligentne systemy nauczania

Inteligentne systemy nauczania to systemy sztucznej inteligencji, zazwyczaj agenci oprogramowania, których zadaniem jest interaktywne nauczanie uczniów, tak samo jak ludzki nauczyciel. Wyniki wczesnych starań w tym kierunku były rozczarowujące. Późniejsze systemy odniosły większy sukces w dziedzinach takich jak matematyka, które nadają się do krótkich odpowiedzi od ucznia. Ostatnio opracowano inteligentne systemy nauczania, takie jak AutoTutor, które mogą odpowiednio radzić sobie z pełnymi akapitami napisanymi przez ucznia. Dziś główne wąskie gardło w tym badania doprowadzają wiedzę dziedzinową do systemów nauczania. W rezultacie rozkwitły badania w różnych narzędziach do authoringu.

Robotyka

We wczesnych latach robotyka była poddziedziną inżynierii mechanicznej, a większość badań poświęcono rozwojowi robotów zdolnych do wykonywania określonych czynności, takich jak chwytanie, chodzenie i tak dalej. Ich systemy kontroli były czysto algorytmiczne, bez komponentów sztucznej inteligencji. Gdy roboty stały się bardziej zdolne, pojawiła się potrzeba stworzenia bardziej inteligentnych struktur kontrolnych i narodziły się badania z zakresu robotyki kognitywnej oparte na strukturach kontrolnych opartych na sztucznej inteligencji. Dzisiaj robotyka i sztuczna inteligencja badania mają istotne i ważne pokrywanie się

Najnowsze trendy i kierunki

Kiedy zaczęła się druga dekada XXI wieku, sztuczna inteligencja nie tylko wynurzyła się ze swojej zimy w sztuczną inteligencję na wiosnę AI, ale ta wiosna przekształciła się w pełnoprawne lato AI z bujnym wzrostem owoców. Najnowsze trendy obejmują najnowsze technologie komputerowe, sztuczną inteligencję do eksploracji danych, sztuczną inteligencję opartą na agentach, obliczenia kognitywne (w tym robotykę rozwojową i sztuczną inteligencję ogólną) oraz zastosowanie sztucznej inteligencji w kognitywistyce. Spójrzmy na każdy z nich po kolei.

Przetwarzanie miękkie

Poza komponentami opisanymi wcześniej (mianowicie sieci neuronowe, obliczenia ewolucyjne i logika rozmyta), soft computing rozszerza się na systemy hybrydowe łączące symboliczną i łączącą sztuczną inteligencję. Pierwszymi przykładami takich systemów hybrydowych są ACT-R, CLARION czy LIDA. Większość takich systemów hybrydowych, w tym trzy przykłady, miała być modelami poznawczymi. Niektóre z nich leżą u podstaw architektury obliczeniowej praktycznych programów sztucznej inteligencji. Technologia "soft computing" obejmuje teraz także sztuczne układy odpornościowe, które mają znaczący wkład w bezpieczeństwo komputerów, a także aplikacje optymalizacja i prognozowanie struktury białka.

AI dla eksploracji danych

Oprócz statystyk, sztuczna inteligencja zapewnia niezbędne narzędzia do eksploracji danych, proces wyszukiwania dużych baz danych na użyteczne wzorce danych. Wiele z tych narzędzi pochodzi z badań nad uczeniem maszynowym. Ponieważ bazy danych szybko się zwiększają, systemy wyszukiwania danych stają się coraz bardziej użyteczne, co prowadzi do trendu w poszukiwaniu narzędzi AI do eksploracji danych.

AI oparte na agentach

Umiejscowiony lub ucieleśniony ruch poznawczy, w postaci sztucznej inteligencji opartej na agentach, wyraźnie przeszedł ten dzień w badaniach nad sztuczną inteligencją. Obecnie większość nowych systemów sztucznej inteligencji jest pewnego rodzaju autonomicznymi agentami. Dominującym podręcznikiem AI, używanym na ponad 1000 uniwersytetach w ponad 100 krajach, jest tekst wiodący, częściowo dlatego, że jego pierwsza edycja była pierwszym podręcznikiem AI opartym na agentach. Zastosowania agentów AI są liczne. Niektóre z nich zostały wymienione w sekcji dotyczącej agentów oprogramowania powyżej.

Obliczenia kognitywne

Być może najnowszy, a na pewno jeden z najbardziej uporczywych, aktualnych trendów w badaniach nad sztuczną inteligencją, nazwano komputerami kognitywnymi. Obliczenia kognitywne obejmują robotykę kognitywną, robotykę rozwojową, samoświadome systemy komputerowe, autonomiczne systemy komputerowe i sztuczną inteligencję ogólną. Opiszemy je po kolei. Jak wspomniano powyżej, robotyka początkowo zajmowała się przede wszystkim sposobem wykonywania czynności i była to głównie dyscyplina inżynierii mechanicznej. Niedawno nacisk ten przenosi się na wybór działań, czyli decydowanie o tym, jakie działania należy wykonać. Robotyka kognitywna, udostępnianie robotów z większymi zdolnościami poznawczymi, narodziło się i staje się aktywną poddziedziną sztucznej inteligencji. Kolejna ściśle powiązana nowa dziedzina badań nad sztuczną inteligencją, robotyka rozwojowa, łączy robotykę, uczenie maszynowe i psychologię rozwojową. Pomysł polega na umożliwieniu robotom ciągłego uczenia się. tak jak ludzie. Takie nauczanie powinno pozwolić robotom kognitywnym działać w środowiskach zbyt skomplikowanych i zbyt dynamicznych, aby wszystkie zdarzenia mogły zostać ręcznie wykonane w robocie. Ta nowa dyscyplina jest wspierana przez Komitet Techniczny IEEE ds. Autonomicznego rozwoju mentalnego, a także własny dziennik "Transakcje autonomicznego rozwoju mentalnego". Agencje rządowe inwestują w kognitywne przetwarzanie danych w postaci systemów samoprzylepnych systemów komputerowych. DARPA, Agencja Zaawansowanych Programów Badawczych Obrony, sponsorowała warsztaty na temat samoświadomych systemów komputerowych. Ron Brachman, ówczesny dyrektor biura programowego DARPA IPTO, a od kiedy prezes AAAI, Stowarzyszenie Postępu Sztucznej Inteligencji, określił to następująco:

System prawdziwie poznawczy byłby w stanie ... wyjaśnić, co robi i dlaczego to robi. Byłoby wystarczająco refleksyjne, aby wiedzieć, kiedy zmierzało w dół ślepym zaułkiem, lub kiedy trzeba było prosić o informacje, których po prostu nie można było uzyskać poprzez dalsze rozumowanie. Wykorzystując te możliwości, system kognitywny byłby solidny w obliczu niespodzianek. Byłby w stanie poradzić sobie znacznie bardziej dojrzale z nieprzewidzianymi okolicznościami, niż jakikolwiek inny DARPA obecnie wspiera badania nad takimi systemami kognitywnymi inspirowanymi biologią. IBM Research oferuje ukierunkowane na komercjalizację wsparcie obliczeń kognitywnych poprzez tzw. Komputer autonomiczny. Główne zainteresowanie polega tutaj na samokonfigurujących się, samokontrolujących się i samoleczących się systemach. Bardzo aktualnym i nie w pełni rozwiniętym trendem w badaniach nad sztuczną inteligencją jest przejście do systemów wykazujących bardziej ludzką inteligencję ogólną, często nazywaną obecnie sztuczną inteligencją ogólną (AGI). Rozwój tego trendu AGI można prześledzić sekwencję specjalnych ścieżek, sesji specjalnych, sympozjów i warsztatów. Aktualnie opracowywane systemy AGI to LIDA, Joshua Blue i Novamente.

AI i nauki kognitywne

Strona naukowa sztucznej inteligencji jest poświęcona przede wszystkim modelowaniu ludzkiego poznania. Jej zastosowanie polega na dostarczeniu miejmy nadzieję testowalnych hipotez dla kognitywistów i neuronauk kognitywnych. Oprócz modeli kognitywnych o bardziej ograniczonych ambicjach teoretycznych opracowano zintegrowane modele dużych części poznania. Należą do nich: SOAR, ACT-R, CLARION i LIDA. Niektóre z nich zostały zaimplementowane obliczeniowo jako agenci oprogramowania, stając się częścią ucieleśnionego poznania. Jeden z nich, LIDA, wdraża kilka różnych teorii psychologicznych, w tym globalną teorię przestrzeni roboczej, pamięć roboczą, percepcję przez afordancję i przejściową pamięć epizodyczną. Znaczenie tego subpopulacji modelowania poznawczego w AI zostało uznane przez kilka wydziałów informatyki, które zaczęły oferować programy studiów w kognitywistyce

Główne tematy - gdzie teraz się znajdują?

Inteligentne oprogramowanie a modelowanie kognitywne. Tak jak w całej historii AI, oba zajęcia nadal są aktywne w badaniach nad sztuczną inteligencją, po stronie inżynieryjnej i naukowej. Obecnie obie strony zmierzają ku bardziej ogólnemu podejściu. Inteligentne oprogramowanie to zaczynając od AGI. Modelowanie kognitywne zmierza w kierunku bardziej zintegrowanych modeli hybrydowych, takich jak ACT-R, CLARION i LIDA, oprócz tradycyjnego zainteresowania bardziej wyspecjalizowanymi modelami. Kolejnym ważnym krokiem w stronę inteligentnego oprogramowania jest bardziej niezależny system agentów oprogramowania.

Symboliczne AI w porównaniu do sieci neuronowych. Zarówno symboliczna sztuczna inteligencja, jak i sieci neuronowe przetrwały zimę i teraz kwitną. Żadna strona kontrowersji nie wygrała. Oba są nadal bardzo przydatne. Łączą się nawet w takich systemach hybrydowych jak ACT-R, CLARION i LIDA. ACT-R układa się symbolicznie i funkcje sieci neuronowej, CLARION składa się z modułu sieci neuronowej połączonego z modułem symbolicznym, a LIDA zawiera aktywację przechodzącą przez system, który w przeciwnym razie symboliczny, co czyni go również dość neutralnym.

Rozumowanie a percepcja. Badania nad rozumowaniem sztucznej inteligencji są kontynuowane w takich poddziedzinach, jak wyszukiwanie, planowanie i systemy eksperckie. Zastosowania praktyczne w terenie są liczne. Percepcja weszła w posiadanie w wizji maszynowej, komputerach opartych na agentach i robotyce kognitywnej. Należy zauważyć, że rozumowanie i percepcja łączą się w dwóch ostatnich, a także w zintegrowanym modelowaniu poznawczym i AGI.

Rozumowanie a wiedza. Oprócz rozumowania, wiedza odgrywa kluczową rolę w systemach eksperckich, a także w komputerach opartych na agentach, komputerach świadomych i komputerach autonomicznych. Ponownie oba są żywe i kwitnące, a znaczenie dodawania wiedzy do praktycznych systemów staje się coraz bardziej oczywiste. Eksploracja danych stała się kolejnym sposobem zdobywania takiej wiedzy.

Do reprezentowania lub nie. Bez reprezentacji ,architektura subsumcji Brooksa dopasowuje każdą warstwę do własnych zmysłów i zdolności do wybierania i wykonywania pojedynczego działania. Wyższy poziom może, w razie potrzeby, podważyć działanie następnego niższego poziom. Dzięki tej architekturze podskórnej kontrolującej roboty, Brooks z powodzeniem stwierdził, że wiele można i należy zrobić z małą lub żadną reprezentacją. Mimo to reprezentacja jest niemal wszechobecna w systemach sztucznej inteligencji potrafią radzić sobie bardziej inteligentnie z coraz bardziej złożonymi, dynamicznymi środowiskami. Wydawać by się mogło, że reprezentacja ma kluczowe znaczenie dla procesu selekcji działań w systemach sztucznej inteligencji, a tym bardziej dla realizacji tych działań. Argument, czy reprezentować, wydaje się po prostu wygasł.

Mózg w kadzi kontra ucieleśniona sztuczna inteligencja. Po raz pierwszy wydaje się, że mamy zwycięzcę. Ucieleśniona lub usytuowana AI po prostu przejęła kontrolę, ponieważ większość nowych badań nad systemami sztucznej inteligencji opiera się na agentach. Przeglądanie tytułów z konferencji ogólnych AI, takich jak AAAI lub IJCAI (Międzynarodowa Wspólna Konferencja Sztucznej Inteligencji), wyjaśnia to doskonale.

Wąska sztuczna inteligencja w porównaniu z inteligencją na poziomie człowieka. Wąskie AI rozwija się nieprzerwanie, a dążenie do inteligencji na poziomie ludzkim w maszynach nabiera tempa poprzez AGI.

Z wyjątkiem silnego ruchu badań nad sztuczną inteligencją w kierunku ucieleśnienia, każda strona każdego problemu nadal jest silnie reprezentowana we współczesnych badaniach nad sztuczną inteligencją. Badania nad sztuczną inteligencją rozwijają się tak, jak nigdy przedtem, i obiecują stały wkład, zarówno praktyczny, jak i teoretyczny w naukę.