Net Logo : Zachowania

Zachowanie

1. Kwestia perspektywy: musimy odróżnić perspektywę obserwatora od perspektywy samego agenta. Perspektywa obserwatora musi być traktowana jako wewnętrzny mechanizm leżący u podstaw opisanego zachowania.

2. Problem zachowania w stosunku do mechanizmu: zachowanie agenta zawsze jest wynikiem interakcji system-środowisko. Nie można tego wyjaśnić tylko na podstawie mechanizmów wewnętrznych

3. Problem złożoności: złożoność, którą obserwujemy w danym zachowaniu, nie zawsze wskazuje na złożoność mechanizmów leżących u podstaw. -

(Rolf Pfeifer i Christian Scheier)

Co to jest zachowanie?

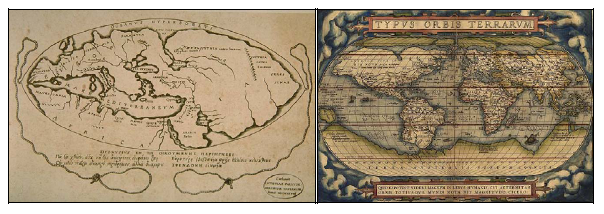

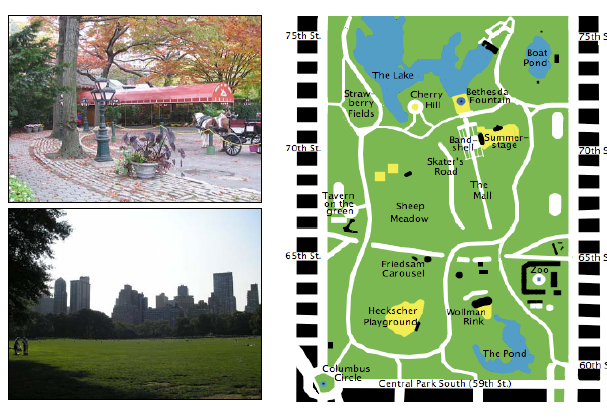

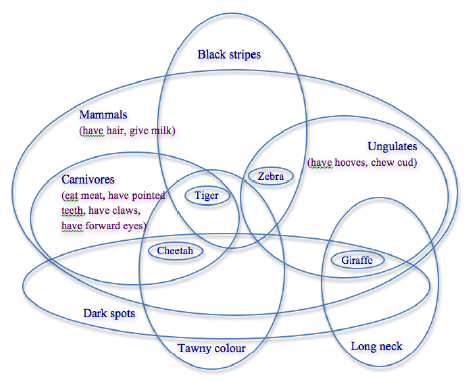

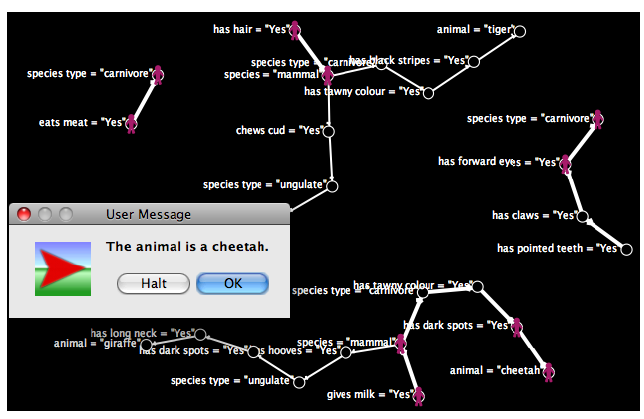

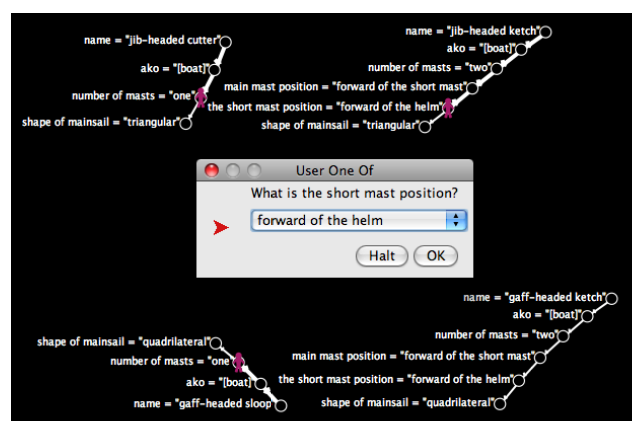

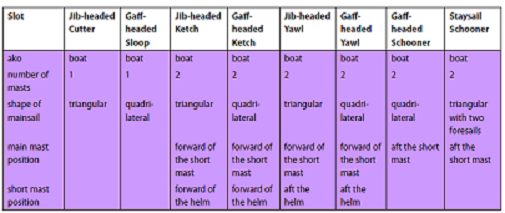

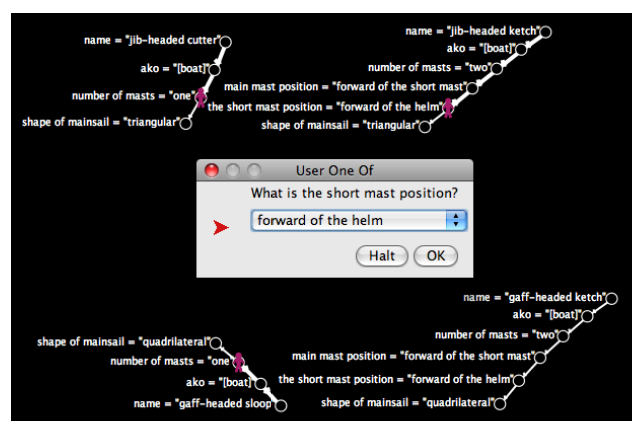

Sposób, w jaki zachowuje się agent, jest często używany do odróżnienia ich i odróżnienia tego, kim i czm są, zarówno od zwierząt, ludzi, jak i od sztucznych. Zachowanie można również powiązać z grupami agentów, a nie tylko z jednym agentem. Na przykład ludzkie zachowania kulturowe odnoszą się do zachowania, które jest związane z określonym narodem, ludem lub grupą społeczną, i różni się od zachowania indywidualnego człowieka lub ludzkiego ciała. Zachowanie ma również ważną rolę do odegrania w przetrwaniu różnych gatunków i podgatunków. Sugerowano na przykład, że muzyka i sztuka stanowiły część zestawu zachowań prezentowanych przez nasz własny gatunek, który zapewnił nam ewolucyjną przewagę nad neandertalczykami. Wcześniej rozmawialiśmy o różnych aspektach dotyczących zachowań ucieleśnionych, usytuowanych agentów, takich jak to, jak można scharakteryzować zachowanie agenta z perspektywy projektu pod kątem jego ruchu w otoczeniu i jak agenci wykazują zakres zachowań od reaktywnych do poznawczych. Nie dostarczyliśmy jednak bardziej konkretnej definicji tego, czym jest zachowanie. Z perspektywy projektowania ucieleśnionych, usytuowanych agentów, zachowanie można zdefiniować w następujący sposób. Szczególnym zachowaniem ucieleśnionego, usytuowanego agenta jest seria działań wykonywanych podczas interakcji ze środowiskiem. Określona kolejność lub sposób wykonywania ruchów akcji i ogólny wynik, który pojawia się w wyniku działań, określa rodzaj zachowania. Możemy zdefiniować działanie jako serię ruchów wykonywanych przez agenta w odniesieniu do konkretnego wyniku, albo przez wolę (dla działań poznawczych), albo przez instynkt (dla działań opartych na reaktywności). W tej definicji ruch jest traktowany jako podstawowa część komponentów, które charakteryzują każdy typ zachowania - innymi słowy, działania i reakcje, które agent wykonuje, gdy wykonuje zachowanie. Rozróżnienie między ruchem a działaniem polega na tym, że działanie obejmuje jeden lub więcej ruchów wykonywanych przez agenta, a także, że istnieje określony wynik, który pojawia się w wyniku działania. Na przykład, czynnik ludzki może chcieć wykonać działanie włączania światła. Efektem działania jest włączenie światła. Ta czynność wymaga wykonania szeregu ruchów, takich jak podniesienie ręki do przełącznika świateł, przesunięcie określonego palca z ręki, a następnie użycie tego palca do dotknięcia górnej części przełącznika, a następnie naciśnięcie przycisku w dół, aż do przełączenia porusza się. Rozróżnienie między działaniem a określonym zachowaniem polega na tym, że zachowanie obejmuje jedną lub więcej czynności wykonywanych przez agenta w określonej kolejności lub sposobie. Na przykład, agent może preferować zachowanie oszczędzające energię poprzez włączanie świateł tylko wtedy, gdy jest to konieczne (jest to przykład zachowania poznawczego, ponieważ wymaga świadomego wyboru). Inny agent zawsze może włączyć światło poprzez przyzwyczajenie, gdy wchodzi do pokoju (jest to przykład zachowania głównie reaktywnego). Sposób zachowania jest sposobem, w jaki agent działa w danej sytuacji lub zestawie sytuacji. Sytuacja jest określona przez warunki środowiskowe, własne okoliczności i wiedzę, którą agent obecnie ma do dyspozycji. Jeśli agent ma niewystarczającą wiedzę do danej sytuacji, może zdecydować się na poszukiwanie dalszej wiedzy na temat sytuacji. Zachowania mogą składać się z sub-zachowań. Poszukiwanie dalszej wiedzy samo w sobie jest zachowaniem, na przykład, i może być składową pierwotnego zachowania. Istnieją również różne aspekty zachowania, w tym następujące: wykrywanie i ruch (koordynacja sensomotoryczna); rozpoznanie obecnej sytuacji (klasyfikacja); podejmowanie decyzji (wybór odpowiedniej odpowiedzi); wydajność (wykonanie odpowiedzi). Zachowania sięgają od w pełni świadomego (poznawczego) do nieświadomego (reaktywnego), od jawnego (zrobione w otwarty sposób) do ukrycia (zrobione w tajemnicy) i od dobrowolnego (agent działa zgodnie z własną wolną wolą) do mimowolnego (zrobionego bez świadomej kontroli lub zrobionego wbrew woli agenta). Termin "zachowanie" ma również różne znaczenia w zależności od kontekstu. Powyższa definicja ma zastosowanie, gdy termin jest używany w odniesieniu do działań człowieka lub zwierzęcia, ale ma również zastosowanie w opisywaniu działań systemu mechanicznego lub złożonych działań chaotycznego systemu, jeśli zorientowany na agenta rozpatrywana jest perspektywa (tutaj są ludzie, zwierzęta, systemy mechaniczne lub złożone systemy). Jednak w rzeczywistości wirtualnej i aplikacjach multimedialnych termin ten może być czasem używany jako synonim animacji komputerowej. W wiarygodnych czynnikach i sztucznych polach życia, zachowanie jest używane "w odniesieniu do improwizacji i życie-podobne działania o charakterze autonomicznym". Często antropomorficznie przypisujemy ludzkie cechy behawioralne za pomocą działania komputera, gdy mówimy, że system komputerowy lub program komputerowy zachowuje się w określony sposób w oparciu o reakcje na naszą interakcję z systemem lub programem. Podobnie często (zazwyczaj błędnie) przypisujemy ludzkie zachowanie behawioralne zwierzętom i obiektom nieożywionym, takim jak samochody.

Środki reaktywne a czynniki poznawcze

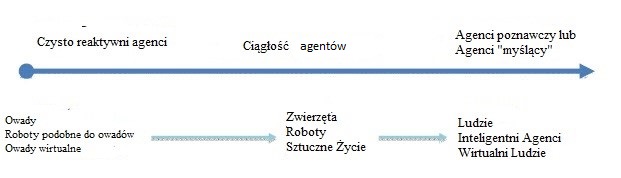

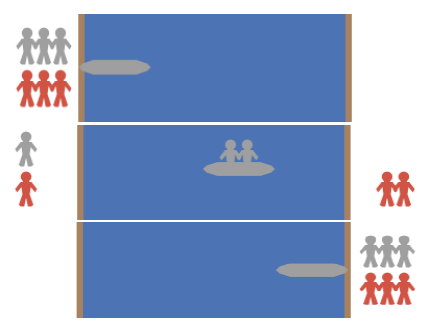

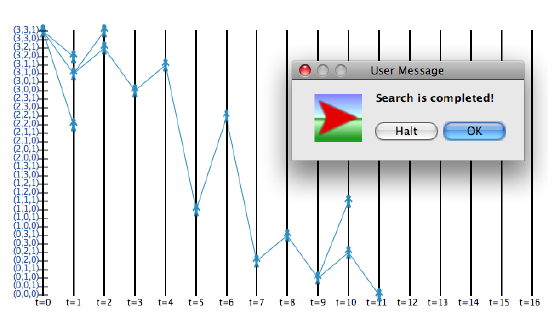

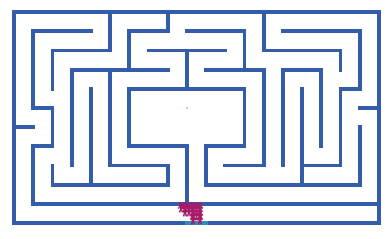

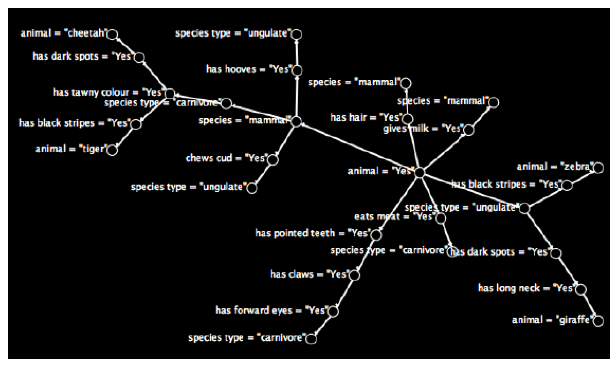

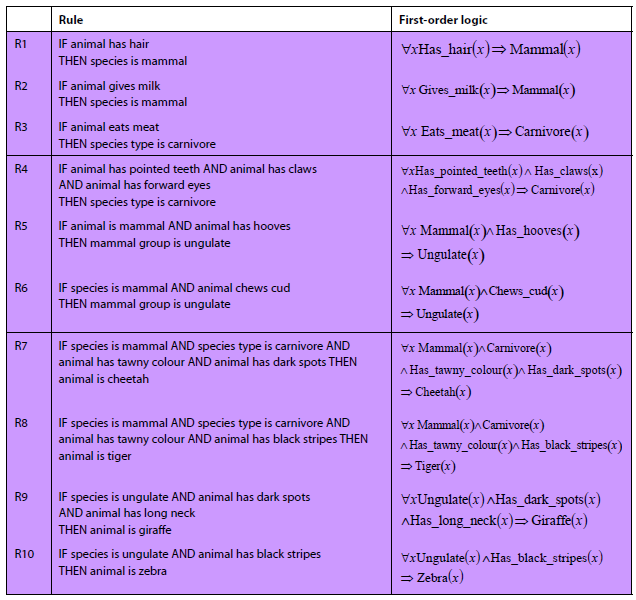

W tej części będziemy dalej badać ważne rozróżnienie pomiędzy zachowaniami reaktywnymi i poznawczymi, które po raz pierwszy zostały podkreślone w poprzednim rozdziale. Czynniki można scharakteryzować, gdy znajdują się na kontinuum, jak pokazano na rysunku.

Kontinuum to sięga od czysto reaktywnych środków, które nie wykazują zdolności poznawczych (takich jak mrówki i termity), do czynników, które wykazują zachowania poznawcze lub mają zdolność myślenia. Tabela przedstawia różnice między dwoma typami agentów.

Agenci Reaktywni : Agenci Poznawczy

• Użyj prostych zachowań. : • Używaj złożonych zachowań.

• Mają małą złożoność : • Mieć dużą złożoność.

• Nie są w stanie przewidzieć przyszłości. : • Przewiduj, co się wydarzy

• Nie ma celów : • Mieć określone cele.

• Nie planuj ani nie koordynuj między sobą. : • Twórz plany i koordynuj ze sobą.

• Nie reprezentuj środowiska. : • Mapuj swoje środowisko (tzn. Buduj wewnętrznie reprezentacje ich środowiska).

• Nie adaptuj się i nie ucz się.: • Pokazuj wyuczone zachowanie.

• Może współpracować w celu rozwiązania złożonych problemów. : • Potrafi rozwiązywać złożone problemy zarówno poprzez pracę razem i działając indywidualnie.

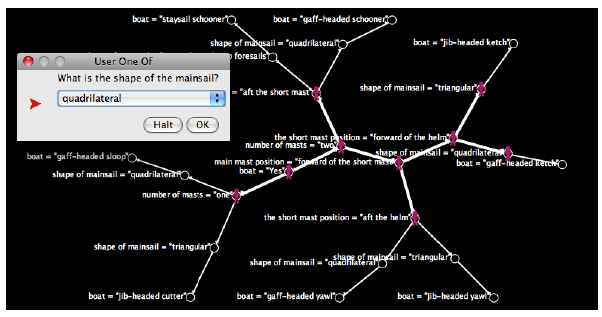

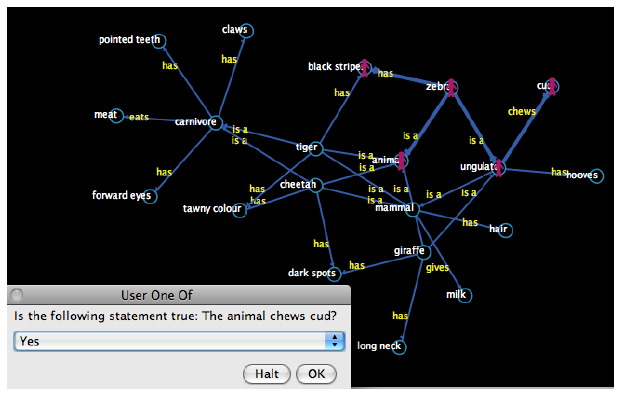

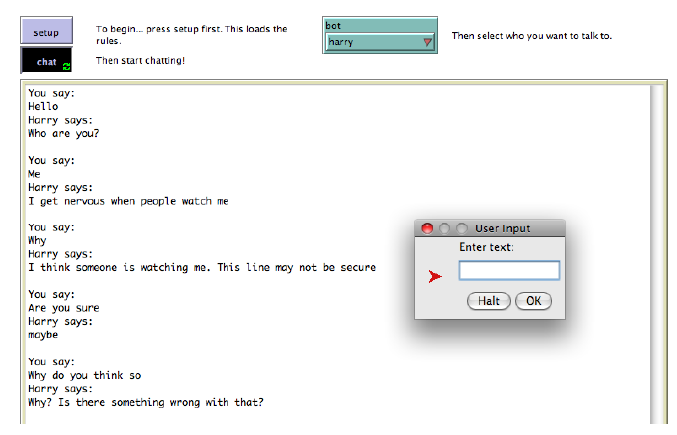

W rzeczywistości, wiele czynników przejawia zarówno zachowania reaktywne, jak i poznawcze w różnym stopniu, a rozróżnienie między reaktywnym a poznawczym może być arbitralne. Porównując zdolności czynników reaktywnych z czynnikami poznawczymi wymienionymi w Tabeli 1, jasne jest, że czynniki reaktywne są bardzo ograniczone w tym, co mogą zrobić, ponieważ nie mają zdolności planowania, koordynacji między sobą lub ustalania i zrozumienia konkretnych celów; po prostu reagują na zdarzenia, kiedy się pojawią. Nie wyklucza to ich roli w tworzeniu inteligentnego zachowania. Reaktywna szkoła myśli polega na tym, że agenci nie muszą być indywidualnie inteligentni. Mogą jednak wspólnie współpracować w celu rozwiązania złożonych problemów. Ich moc pochodzi z potęgi wielu - na przykład owady oparte na koloniach, takie jak mrówki i termity, mają zdolność wykonywania złożonych zadań, takich jak znajdowanie i komunikowanie miejsca pobytu żywności, walka z najeźdźcami i budowanie złożonych struktur. Ale robią to na poziomie populacji, a nie na poziomie indywidualnym, używając bardzo sztywnych powtarzalnych zachowań. W przeciwieństwie do tego, poznawcza szkoła myśli dąży do zbudowania agentów, które w pewien sposób wykazują inteligencję. W tym podejściu poszczególni agenci mają cele i mogą opracować plany, jak je osiągnąć. Korzystają z bardziej wyrafinowanych mechanizmów komunikacji i celowo koordynują swoje działania. Mapują także swoje środowisko w pewien sposób, korzystając z wewnętrznej reprezentacji lub bazy wiedzy, którą mogą odnosić i aktualizować poprzez mechanizmy uczenia się, aby pomóc w kierowaniu ich decyzjami i działaniami. W rezultacie są znacznie bardziej elastyczne w zachowaniu w porównaniu z czynnikami reaktywnymi. W Sztucznej Inteligencji podejście behawioralne do budowania inteligentnych systemów nazywa się sztuczną inteligencją behawioralną (BBAI). W tym podejściu, po raz pierwszy zaproponowanym przez Rodneya Brooksa, inteligencja zostaje rozłożona na zbiór niezależnych, pół-autonomicznych modułów. Moduły te były początkowo pomyślane jako działające na oddzielnym urządzeniu z własnymi wątkami przetwarzania i mogą być uważane za oddzielne czynniki. Brooks zalecał reaktywne podejście do sztucznej inteligencji i używał skończonych maszyn stanów do implementacji modułów zachowania. Te skończone maszyny stanu nie mają konwencjonalnej pamięci i nie zapewniają bezpośrednio wyższych funkcji poznawczych, takich jak uczenie się i planowanie. Określają zachowanie w sposób reaktywny, przy czym agent reaguje bezpośrednio na środowisko, zamiast budować jego reprezentację w pewien sposób, taki jak mapa. Oparte na zachowaniu podejście do sztucznej inteligencji stało się popularne w robotyce, ale znajduje również inne zastosowania w dziedzinie animacji komputerowej i inteligentnych agentów wirtualnych.

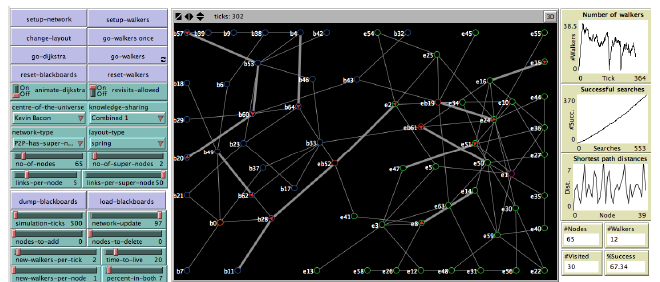

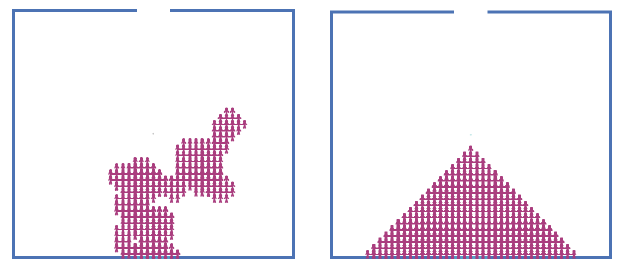

Powstanie, samoorganizacja, adaptacja i ewolucja

W tej sekcji omówiono kilka cech autonomicznych czynników ważnych z punktu widzenia behawioralnego - emergentne, samoorganizujące się, adaptacyjne i ewoluujące zachowania. Złożony system to system składający się z wielu komponentów, które, gdy wchodzą ze sobą w interakcje, wytwarzają aktywność, która jest większa niż to, co jest możliwe w przypadku pojedynczych komponentów. System wieloagentowy to złożony system, jeśli agenci wykazują zachowawcze zachowania. Pojawienie się w złożonym systemie jest pojawieniem się nowej właściwości wyższego poziomu, która nie jest prostym liniowym agregatem istniejących właściwości. Na przykład masa samolotu nie jest wyłaniającą się własnością, ponieważ jest to po prostu suma masy poszczególnych elementów samolotu. Z drugiej strony umiejętność latania jest wyłaniającą się własnością, ponieważ właściwość ta znika, gdy części samolotu zostają zdemontowane. Wschodzące właściwości są również powszechne w życiu codziennym - na przykład zachowanie kulturowe u ludzi, żerowanie pokarmu u mrówek i budowanie kopców w termitach. Wrażliwe zachowanie to pojawienie się zachowania systemu wieloagentowego, którego wcześniej nie zaobserwowano i które nie jest wynikiem prostej liniowej kombinacji istniejących zachowań agentów. Niektórzy uważają, że inteligencja jest wyłaniającą się własnością, wynikiem interakcji agent-agent i agent-środowisko reaktywnych, ucieleśnionych, usytuowanych agentów. Jeśli tak jest, to zapewnia alternatywną ścieżkę do tworzenia inteligentnych zachowań - zamiast budować czynniki poznawcze poprzez jawne programowanie wyższych zdolności poznawczych, takich jak rozumowanie i podejmowanie decyzji, alternatywą jest zbudowanie agenta o zdolnościach reaktywnych, takich jak rozpoznawanie wzorców i uczenie się, a to prowadzi do inteligentnego zachowania. Podejście to jednak nie przyniosło jeszcze efektów, ponieważ mechanizmy stojące za rozpoznawaniem wzorców i zdolnościami uczenia się przez ludzi nie zostały jeszcze w pełni zrozumiane i nie dysponujemy wystarczająco zaawansowanymi algorytmami w tym obszarze, aby agent mógł poznać sposób, w jaki ludzie to robią, na przykład takie jak zdolność małego dziecka do nabycia języka. Jednak bardziej tradycyjna droga do sztucznej inteligencji - do projektowania agentów o wyraźnych zdolnościach poznawczych wyższego poziomu - również nie przyniosła efektów. Mówi się, że system samoorganizuje się, gdy wzorzec lub struktura w systemie pojawiają się spontanicznie, a nie w wyniku zewnętrznych nacisków. System wieloagentowy wyświetla samoorganizujące zachowanie w wyniku zastosowania reguł lokalnych, gdy wzór lub struktura powstaje w wyniku interakcji, której nie spowodował zewnętrzny agent. Systemy samoorganizujące się zazwyczaj wyświetlają nowe właściwości. Wiele naturalnych systemów wykazuje zachowania zapobiegawcze. Oto kilka przykładów: roje ptaków i ryb oraz stada zwierząt, takich jak bydło, owce, bawoły i zebry (biologia); tworzenie i struktura planet, gwiazd i galaktyk (z dziedziny astrofizyki); formacje chmurowe i cyklony (meteorologia); struktura powierzchni ziemi (geofizyka); reakcje chemiczne (chemia); autonomiczne ruchy robotów (robotyka); sieci społecznościowe (Internet); sieci komputerowe i ruchome (technologia); naturalnie występujące fraktalne wzory, takie jak paprocie, płatki śniegu, struktury krystaliczne, krajobrazy, fiordy (świat naturalny); wzory występujące na futrze, skrzydłach motyla, skórze owadów i naczyniach krwionośnych w ciele (biologia); wzrost populacji (biologia); kolektywne zachowanie kolonii owadów, takich jak termity i mrówki (biologia); mutacja i selekcja (ewolucja); i konkurencja, giełdy i rynki finansowe (ekonomia). Biblioteka modeli NetLogo zawiera wiele modeli symulujących samoorganizację. Na przykład model Flocking naśladuje zachowanie stada u ptaków - po uruchomieniu modelu przez jakiś czas, żółwie będą się samoorganizować w kilka stad, w których ptaki kierują się w podobnym kierunku. Dzieje się tak pomimo zachowania poszczególnych agentów składającego się tylko z kilku lokalnych reguł. W modelu Fireflies, agenci żółwia są w stanie zsynchronizować miganie przy użyciu tylko interakcji między sąsiednimi agentami; ponownie tylko lokalne reguły określają zachowanie poszczególnych agentów. Model termitów i model maszyny stanowej symulują zachowanie termitów. Po uruchomieniu tych modeli przez pewien czas łatki "zrębków drewnianych" zostaną umieszczone w kilku stosach. Trzy zrzuty ekranu modelu przykładowego maszyny stanu są pokazane na rysunku poniżeh.

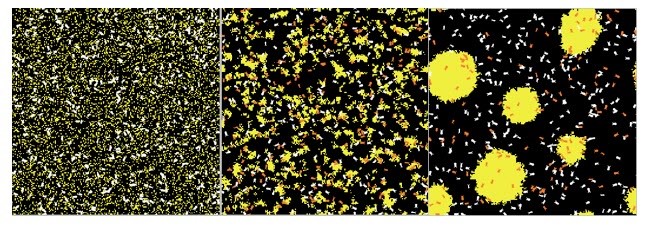

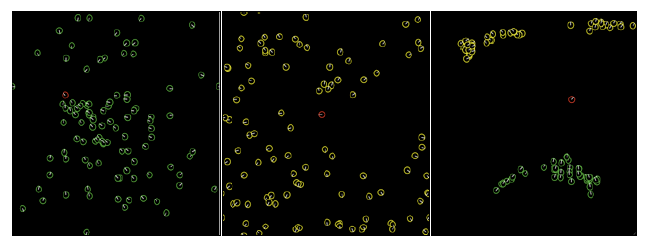

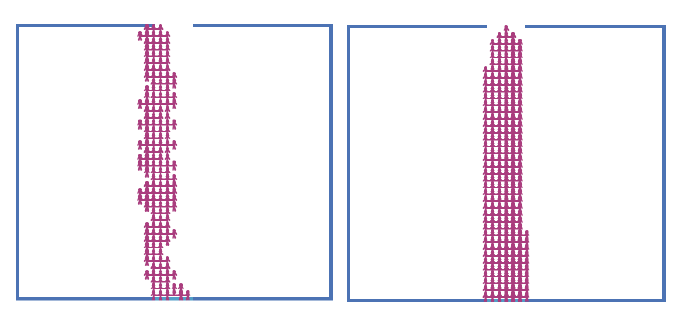

Lewy obraz pokazuje środowisko na początku symulacji (liczba tyknięć = 0). Pokazuje agentów umieszczonych losowo w całym środowisku, z żółtymi plamami przedstawiającymi zrębki i białe kształty reprezentujące termity. Środkowe i prawe obrazy pokazują otoczenie po 5000 i 50 000 tyknięć. Pomarańczowe kształty przedstawiają termity, które niosą drewniane wióry, a białe kształtują te, które nie są. Te dwa obrazy pokazują system środków termitów, wiórów drzewnych i środowiska, które stopniowo samoorganizują się, dzięki czemu zrębki kończą się w kilku stosach. Kod dla przykładowego modelu jest pokazany poniżej:

turtles-own [

task ;;nazwa procedury (ciąg) żółw będzie biegał podczas tego tiku

steps ;; …chyba że liczba ta jest większa od zera, w którym

;; w przypadku tego tyknięcia żółw porusza się do przodu 1

]

to setup

clear-all

set-default-shape turtles "bug"

;; losowo rozprowadzać zrębki

ask patches [

if random-float 100 < density

[ set pcolor yellow ]

]

;; losowo rozprowadzaj termity

crt number [

set color white

setxy random-xcor random-ycor

set task "search-for-chip"

set size 5 ;; easier to see

]

end

to go

ask turtles

[ ifelse steps > 0

[ set steps steps - 1 ]

[ run task

wiggle ]

fd 1 ]

tick

end

to wiggle ;; procedura żółwia

rt random 50

lt random 50

end

to search-for-chip ;; procedura żółwia - "podnosi chi", zmieniając kolor na pomarańczowy

if pcolor = yellow

[ set pcolor black

set color orange

set steps 20

set task "find-new-pile" ]

end

to find-new-pile ;; procedura żółwia - poszukaj żółtej łatki

if pcolor = yellow

[ set task "put-down-chip" ]

end

to put-down-chip ;; procedura żółwia - wyszukuje puste miejsce i upuszcza chip

if pcolor = black

[ set pcolor yellow

set color white

set steps 20

set task "get-away" ]

end

to get-away ;; procedura żółwia - wyjdź z żółtego stosu

if pcolor = black

[ set task "search-for-chip" ]

end

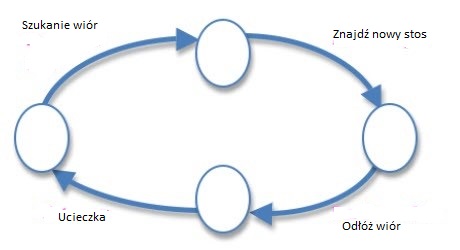

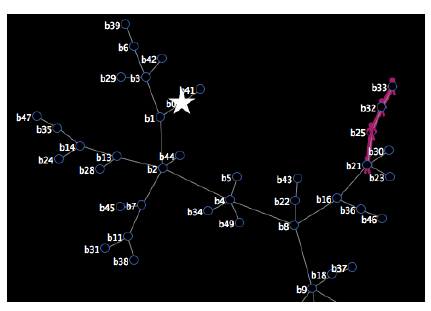

Procedura setup losowo rozprowadza żółte środki płatkowe i środki termitów w całym środowisku. Polecenie ask w procedurze go określa zachowanie agentów termitów. Zastosowane podejście polega na reprezentowaniu zachowania jako skończonej maszyny stanu składającej się z czterech stanów z inną akcją lub zadaniem wykonywanym przez agenta, zapewniającym przejście do następnego stanu. Te zadania to: poszukiwanie wiórów drewnianych; znalezienie nowego stosu; odkładanie kawałka drewna; i wydostanie się ze stosu. Uproszczona skończona maszyna stanów dla tego modelu została przedstawiona na rysunku

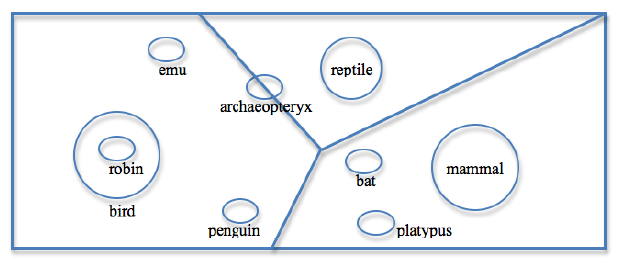

Mówi się, że system w ogólnym sensie ewoluuje, jeśli dostosowuje się lub zmienia w czasie, zwykle od prostej do bardziej złożonej postaci. Termin "ewolucja" ma różne znaczenia w różnych kontekstach, co może powodować pewne zamieszanie. Bardziej szczegółowe znaczenie odnosi się do terminu ewolucji do teorii ewolucji Darwina - mówi się, że gatunek ewoluuje, gdy następuje zmiana w DNA jego populacji z pokolenia na pokolenie. Zmiana jest przekazywana potomstwu poprzez reprodukcję. Zmiany te mogą być niewielkie, ale po wielu pokoleniach połączone efekty mogą prowadzić do istotnych zmian w organizmach. Aby odróżnić różne znaczenia terminu "ewolucja", możemy zdefiniować zachowanie adaptacyjne i ewoluujące osobno w następujący sposób. Agent wykazuje zachowania adaptacyjne, gdy ma zdolność zmiany swojego zachowania w jakiś sposób w odpowiedzi na zmiany w środowisku. Jeśli zmienia się środowisko, zachowanie dobrze dostosowane do poprzedniego środowiska może już nie być tak dobrze dostosowane; Na przykład, bardziej przejrzyste, pokazano, że niektóre zachowania dostosowane do warunków labiryntu Hampton Court Palace nie są tak dobrze dopasowane do środowiska labiryntu Chevening House i na odwrót. Z drugiej strony ewolucja zachowań występuje w populacji, gdy jej geneza zmieniła się z pokolenia na pokolenie. Ewolucja w populacji jest napędzana przez dwa główne mechanizmy - selekcję naturalną i dryf genetyczny. Selekcja naturalna to proces, w którym osoby z dziedzicznymi cechami, które są pomocne w rozmnażaniu i przetrwaniu w środowisku, staną się bardziej powszechne w populacji, podczas gdy szkodliwe cechy staną się rzadsze. Dryf genetyczny jest zmianą względnej częstotliwości dziedzicznych cech ze względu na rolę przypadku w określeniu, które osobniki przeżywają i rozmnażają się. Ewolucja człowieka i gatunków zwierząt ma miejsce przez setki tysięcy lat, a czasem miliony. Aby przedstawić te skale czasowe w perspektywie i aby pokazać, jak małe zmiany mogą mieć epokowe efekty, możemy posłużyć się przykładem Góry Himalajskiej. Linia uskoków rozciąga się od jednego końca Himalajów do drugiego, ponieważ znajduje się na granicy między tektonicznymi płytami euroazjatyckimi i indoeurlandzkimi, a w konsekwencji jest jednym z najbardziej aktywnych sejsmicznie regionów na świecie. Badania wykazały, że Himalaje wciąż rosną w tempie około 1 cm rocznie. Chociaż wzrost o 1 cm rocznie może wydawać się nieistotny, jeśli zaplanujemy tak daleko w przyszłości, efekt akumulacyjny może być niezwykły. Po 100 latach wzrośnie tylko o metr; po 1000 latach, 10 m; po 10000 latach, zaledwie 100 m, nadal nie jest szczególnie znaczący w porównaniu do ogólnej średniej wysokości gór. Jednak po 100 000 lat wzrośnie o 1 km - to ponad 10% obecnej wysokości Mt. Everest, który wynosi 8 848 metrów. Po milionie lat wzrost wyniesie 10 km, co więcej niż podwaja obecną wysokość Mt. Everest. Proces, który powoduje niewielkie zmiany z roku na rok, o ile jest stały, spowoduje dramatyczne zmiany w ciągu miliona lat. Mt. Everest stale rośnie od miliona lat, jest oczywiście hipotetyczną sytuacją, ponieważ istnieją inne siły działające, takie jak erozja i ruch płyt tektonicznych. W przeciwieństwie do tego wzrost mórz, nawet tak niewielkiej jak 1 cm na rok, może spowodować dramatyczne zmiany w znacznie krótszym czasie. Dryf kontynentalny spowodował również znaczącą zmianę w krajobrazie świata. Odległość lotu między Sydney, Australia i Wellington w Nowej Zelandii wynosi na przykład 2220 km. Jeśli Nowa Zelandia oddalała się od Australii w tempie 1 cm rocznie, to miało to miejsce w okresie 222 milionów lat. Bez względu na to, jak dobrze nadaje się dany gatunek do przetrwania w obecnym środowisku, będzie potrzebować dostosować się do zmian na poziomie epoki, jeśli ma przetrwać bardzo długo.

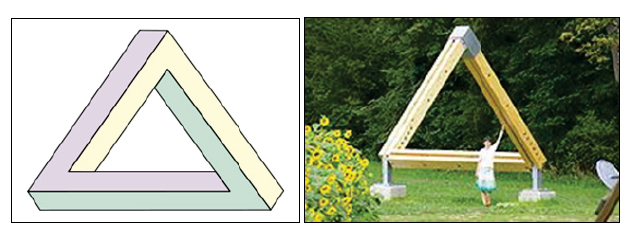

Problem z odniesieniem

Ważne jest, aby nie przypisywać błędnych wyjaśnień z obserwacji mechanizmom stojącym za zachowaniem ucieleśnionego przedstawiciela znajdującego się w otoczeniu. Ramy odniesienia wskazują na różnicę między perspektywą obserwatora a perspektywą obserwowanego ze względu na ich różne przykłady wykonania. Każdy prawdziwy agent jest wyjątkowy ze swoim ciałem i mózgiem, z unikalnym zestawem możliwości wykrywania i ma wyjątkową lokalizację w środowisku (ponieważ w prawdziwych środowiskach żadne dwa ciała nie mogą zajmować tej samej przestrzeni w tym samym czasie) . Dlatego każdy agent ma unikalną perspektywę swojego otoczenia; w związku z tym perspektywa czynnika wykonującego obserwację będzie bardzo odmienna od perspektywy obserwowanego czynnika. Rozbieżności w ramach odniesienia będą najbardziej wyraźne między gatunkami o znacznie różnych przykładach wykonania, na przykład między ludźmi a owadami. Często ludzie jako obserwatorzy popełniają błąd przypisywania zdolności podobnych do ludzkich przy opisywaniu mechanizmów stojących za zachowaniem, które jest obserwowane. Na przykład magnetyczne kopce termitów w północnej Australii wszystkie stoją na północ i z daleka wyglądają jak nagrobki na cmentarzu. W tym przypadku łatwo jest popełnić błąd, że zostały one stworzone zgodnie z pewnym centralnym planem, ale kopce termitów są wynikiem wielu pojedynczych czynników stosujących proste zachowanie reaktywne. Rolf Pfeifer i Christian Scheier twierdzą, że istnieją trzy główne aspekty ram odniesienia: kwestia perspektywy; kwestia zachowania w stosunku do mechanizmu; i problem złożoności. Kwestia perspektywy dotyczy potrzeby rozróżnienia perspektyw obserwatora od obserwowanego, a nie przypisywania opisów mechanizmów z punktu widzenia obserwatora. Problem zachowania względem mechanizmu stwierdza, że zachowanie agenta nie jest tylko wynikiem samych mechanizmów wewnętrznych; interakcja między agentem a środowiskiem również ma ważną rolę do odegrania. Problem złożoności wskazuje, że złożone zachowania niekoniecznie są wynikiem złożonych mechanizmów leżących u podstaw. Rolf Pfeifer i Christian Scheier używają eksperymentu myślowego mrówki na plaży, zaproponowanej przez Simona po raz pierwszy, aby zilustrować te problemy. Podobny scenariusz przedstawiono w Eksperymencie Myślowym 1.

Eksperyment Myślowy 1 : Mrówka na plaży

Wyobraź sobie mrówkę powracającą do gniazda na skraju plaży w pobliżu lasu. Napotyka przeszkody po drodze w lesie, takie jak długa trawa, opadłe liście i gałęzie, a następnie przyspiesza po dotarciu do plaży, która jest blisko gniazda. Podąża specyficznym szlakiem wzdłuż plaży i napotyka kolejne przeszkody, takie jak małe skały, drewno, suszone wodorosty i różne śmieci, takie jak odrzucone plastikowe butelki i dżety wysypane z morza. Mrówka zdaje się podążać określoną ścieżką i reagować na obecność przeszkód, obracając się w pewnych kierunkach, jakby prowadzona przez mentalną mapę terenu. Większość mrówek podążających za oryginalną mrówką również podróżuje w ten sam sposób. W końcu wszystkie mrówki wracają do gniazda, nawet te, które wydawały się zagubione po drodze. Chłopiec idący po plaży zauważa szlak mrówek. Decyduje się zablokować ich szlak, budując na ich drodze niewielki stos piasku. Pierwsza mrówka, która dociera do nowej przeszkody, zdaje się od razu rozpoznawać, że na jej drodze jest coś nowego, czego wcześniej nie było. Powoli skręca w prawo, a potem w lewo, jakby szukał ścieżki wokół przeszkody. Pojawiają się również inne mrówki i razem wydają się koordynować polowanie na ścieżkę wokół przeszkody. W końcu mrówki są w stanie znaleźć ścieżkę wokół przeszkody i wrócić do gniazda. Po pewnym czasie wybierana jest jedna konkretna ścieżka bliska najkrótszej drodze powrotnej do gniazda. Z punktu widzenia obserwatora mrówki zdają się wykazywać inteligentne zachowanie. Po pierwsze, wydają się podążać konkretną złożoną ścieżką i zdają się mieć zdolność rozpoznawania punktów orientacyjnych po drodze. Po drugie, wydają się mieć zdolność do przekazywania informacji między sobą. Na przykład szybko przesyłają lokalizację nowego źródła pożywienia, dzięki czemu mogą śledzić inne mrówki. Po trzecie, mogą znaleźć najkrótszą ścieżkę między dwoma punktami. Po czwarte, radzą sobie ze zmieniającym się środowiskiem. Jednak błędem byłoby przypisywanie inteligencji zachowaniom mrówek. Badania wykazały, że mrówki po prostu wykonują mały zestaw reguł w sposób reaktywny. Nie mają możliwości stworzenia mapy swojego środowiska, którą inne mrówki mogą śledzić w późniejszym czasie. Nie są świadomi kontekstu swojej sytuacji, tak jak przeszli długą drogę, ale są teraz blisko gniazda, więc mogą przyspieszyć, aby szybciej wrócić. Nie mogą przekazywać informacji bezpośrednio, z wyjątkiem zapachu chemicznego ustanowionego w środowisku. Nie mogą omawiać i realizować nowego planu ataku, gdy sprawy nie idą zgodnie z planem, a nie ma centralnego koordynatora. Należy to porównać z umiejętnościami ludzkimi, takimi jak orientator używający mapy do zlokalizowania flag kontrolnych umieszczonych przez kogoś innego las lub plaża lub biegacz przyśpieszający po długim biegu, ponieważ wie, że zbliża się koniec, lub myśliwy z plemienia powracającego do obozu, by powiedzieć innym myśliwym, gdzie jest więcej zwierząt, lub szefowi plemię polecające grupie myśliwych, aby wyszli i szukali więcej jedzenia. Teraz wyobraź sobie, że mrówka ma olbrzymie ciało, takie same jak ludzkie. Najprawdopodobniej zachowanie gigantycznej mrówki będzie zupełnie inne niż w przypadku normalnej wielkości mrówki. Małe obiekty, które były przeszkodami dla mrówki z normalnym rozmiarem ciała, nie stanowiłyby problemu. W rzeczywistości byłyby one zignorowane najprawdopodobniej, a gigantyczna mrówka powróciłaby bardziej bezpośrednio z powrotem do gniazda. Inne obiekty, których normalnej wielkości mrówka nie byłaby świadoma, że są odrębne, takie jak drzewo, teraz stanowiłyby inny problem dla gigantycznej mrówki w stosunku do jej postępu przez teren. A teraz gigantyczna mrówka może mieć trudności z wyczuwaniem chemicznego zapachu leżącego na ziemi. Podsumowując, zmiana w ciele mrówki radykalnie zmienia perspektywę jego otoczenia.

Stygmatyzacja i inteligencja rozproszona

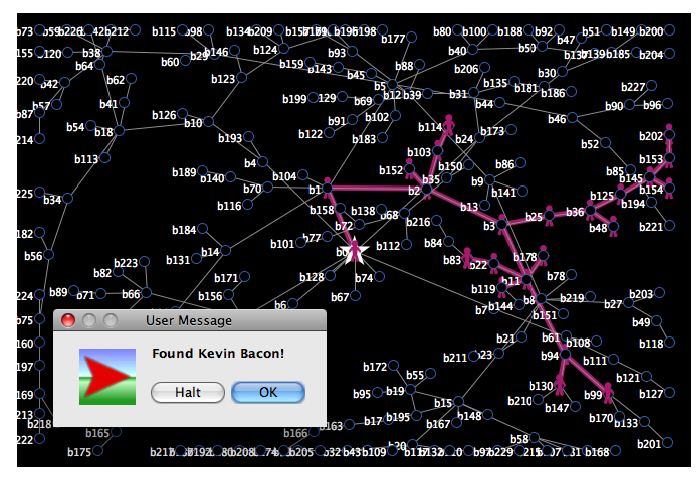

W opisanych wcześniej modelach Termity i Mrówki widzieliśmy już kilka przykładów tego, jak zbiór agentów reaktywnych może wykonywać złożone zadania, które przekraczają możliwości któregokolwiek z agentów działających pojedynczo. Z naszego własnego układu odniesienia agenci wydają się zbiorowo wykazywać inteligentne zachowanie, chociaż jak wyjaśniono w poprzedniej sekcji, byłoby to niepoprawne. Modele NetLogo ilustrują, w jaki sposób mechanizmy stojące za takimi zachowaniami są bardzo proste - wystarczy kilka zasad określających, w jaki sposób agenci powinni wchodzić w interakcję ze środowiskiem. Ta sekcja definiuje dwie ważne koncepcje związane z inteligencją zbioru agentów: stygmatyzacją i inteligencją roju. Zbiór agentów przejawia stigmergię, gdy w jakiś sposób korzystają ze środowiska, a dzięki temu są w stanie koordynować swoje działania, aby tworzyć złożone struktury poprzez samoorganizację. Kluczową ideą stigmergii jest to, że środowisko może mieć istotny wpływ na zachowanie agenta i na odwrót. Innymi słowy, wpływ między środowiskiem a agentem jest dwukierunkowy. W prawdziwym życiu stygmatyzacja występuje wśród owadów społecznych, takich jak termity, mrówki, pszczoły i osy. Jak widzieliśmy w modelach Termites i Ants, stygmergia może występować pomiędzy bardzo prostymi agentami reaktywnymi, którzy mają jedynie zdolność reagowania w sposób lokalny na informacje lokalne. Te środki nie mają inteligencji i wzajemnej świadomości w tradycyjnym sensie, nie używają pamięci i nie mają zdolności planowania, kontroli lub bezpośredniej komunikacji ze sobą. Mają jednak zdolność wykonywania zadań na wyższym poziomie w wyniku połączonych działań. Stygmatyzacja nie ogranicza się do przykładów życia naturalnego - Internet jest oczywistym przykładem. Wiele systemów komputerowych również wykorzystuje stygmergię - na przykład algorytm optymalizacji kolonii mrówek jest metodą znajdowania optymalnych ścieżek jako rozwiązań problemów. Niektóre systemy komputerowe korzystają ze współużytkowanych struktur danych, które są zarządzane przez rozproszoną społeczność klientów, która obsługuje nową organizację. Jednym z przykładów jest architektura tablicy używana w systemach AI opracowanych po raz pierwszy w latach 80. XX wieku. Tablica korzysta z komunikacji za pośrednictwem pamięci współdzielonej, która może zostać napisana niezależnie przez agenta, który badani są przez innych agentów tak, jak w prawdziwym życiu tablica w pokoju wykładowym. Tablice są obecnie używane w grach wideo dla strzelanek FPS i jako środek komunikacji między agentami w sieci komputerowej. Zbiór agentów wykazuje inteligencję roju, kiedy wykorzystuje wiedzę lokologiczną stygmergiczną do koordynowania swoich działań i tworzenia złożonych struktur poprzez samoorganizację. Mechanizmy stojące za inteligencją roju wykazywaną przez owady społeczne są solidne, ponieważ nie ma scentralizowanej kontroli. Są również bardzo skuteczne - co pokazuje wielkość populacji światowej i odzwierciedlenie rozwiązań dla różnych gatunków. Kilka liczb podkreśla ten punkt. Naukowcy szacują, że w dzisiejszym świecie żyje około 9000 gatunków mrówek i jedna czworonożna (1015) mrówek. Ponadto oszacowano, że na przykład kolonie mrówek harwester mają podobną liczbę neuronów co ludzki mózg. Ludzie również wykorzystują inteligencję roju na wiele sposobów. Internetowa encyklopedia, Wikipedia, to tylko jeden przykład, który wynika ze zbiorowej inteligencji ludzi działających indywidualnie przy minimalnej scentralizowanej kontroli. Serwisy społecznościowe za pośrednictwem stron internetowych to kolejne. Obydwa korzystają ze stygmergicznych informacji lokalnych umieszczonych w chmurze.

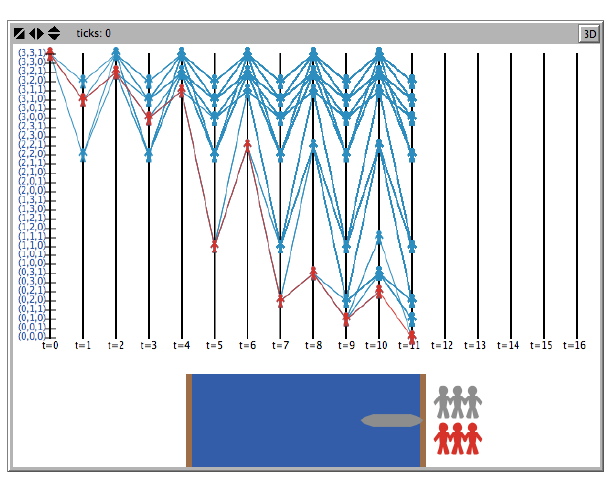

Implementowanie zachowania agentów Turtle w NetLogo

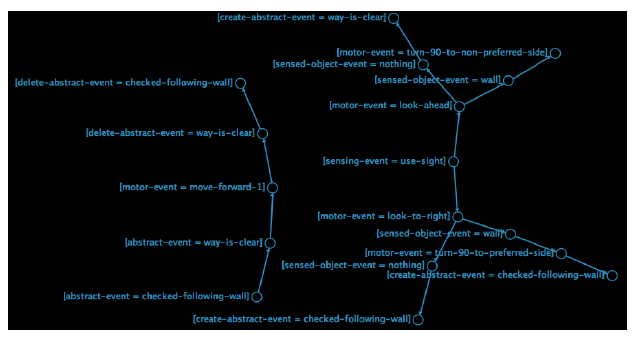

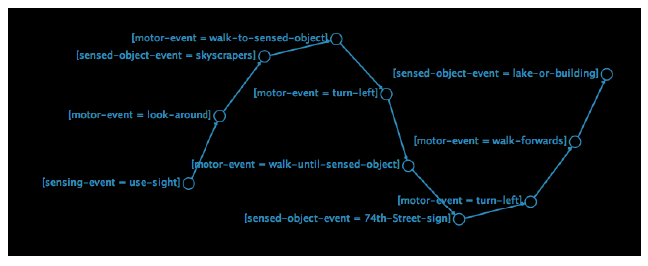

W NetLogo zachowanie agenta jest jawnie określone przez polecenie ask. Definiuje to serię poleceń wykonywanych przez agenta lub zestaw agentów, czyli procedurę, którą ma wykonać agent. Procedura w programie komputerowym to specyficzna seria poleceń wykonywanych w precyzyjny sposób w celu wygenerowania pożądany wynik. Musimy jednak zachować ostrożność, aby odróżnić faktyczne zachowanie agenta od mechaniki procedury NetLogo, która służy do definiowania zachowania. Celem większości poleceń proceduralnych jest manipulowanie zmiennymi wewnętrznymi, w tym zmiennymi globalnymi i własnymi zmiennymi agenta. Ta ostatnia odzwierciedla stan agenta i może być przedstawiona jako punkty w przestrzeni n-wymiarowej. Jednak ten stan jest niewystarczający, aby opisać zachowanie agenta. Jego zachowanie jest reprezentowane przez działania wykonywane przez agenta, które powodują pewne zmiany w jego własnym stanie, w stan innych agentów lub w stan środowiska. Rodzaj zmiany, która pojawia się, jest wynikiem zachowania. Niektóre przykłady zachowań, które już widzieliśmy, prezentowane przez agentów w modelach Netlogo, to: poszukiwanie żerowania pożywienia przez czynniki mrówkowe w modelu Mrówki, co skutkuje efektywnym zwrotem żywności do zagnieżdżać się jako wynik; zachowanie budujące gniazda czynników termitów w modelach termitów i modeli maszynowych, w wyniku czego zrębki drewniane są umieszczane w stosach jako wynik; oraz zachowanie ściany żółwia w modelu Wall Po Przykład, który powoduje, że wszystkie żółwie działają na wszystkie ściany w określonym kierunku jako rezultat. Biblioteka modeli w NetLogo zawiera wiele innych przykładów, w których agenci wykazują bardzo różne zachowania. W większości tych modeli podstawowe mechanizmy są spowodowane mechanicznym zastosowaniem kilku lokalnych reguł, które definiują zachowanie. Na przykład model Fireflies symuluje zdolność populacji świetlików używających tylko lokalnych interakcji do synchronizowania ich flashowania jako wyniku. Model Heatbugs pokazuje, w jaki sposób może powstać kilka rodzajów zachowań wynikających z zastosowania przez agentów prostych reguł w celu utrzymania optymalnej temperatury wokół siebie. Model flokowania naśladuje zachowanie stada ptaków, co jest również podobne do zachowania szkolnego ryb i zachowań stadnych bydła i owiec. Wynik ten osiąga się bez lidera, przy czym każdy agent wykonuje ten sam zestaw zasad. Zwartość kodu NetLogo w tych modelach potwierdza, że złożoność zachowania niekoniecznie koreluje ze złożonością mechanizmów leżących u podstaw. Zachowanie można określić za pomocą różnych alternatyw, na przykład za pomocą procedur i poleceń NetLogo oraz automatów stanu skończonego. Ten ostatni jest abstrakcyjnym modelem zachowania z ograniczoną pamięcią wewnętrzną. W tym formacie zachowanie można uznać za wynik przejścia agenta z jednego stanu do drugiego - lub punktu w przestrzeni n-wymiarowej - ponieważ może on być reprezentowany jako skierowany wykres ze stanami, przejściami i działaniami. Aby utworzyć powiązanie między procedurą zaimplementowaną w języku programowania, takim jak NetLogo i skończone automaty stanów (a tym samym ponownie podkreślić analogię między zachowaniem a ruchem agenta znajdującego się w środowisku), ściana śledząca zachowanie NetLogo Code powtórzony poniżej został przekształcony na równoważny skończony automat stanów na rysunku

to behaviour-wall-following

; klasyczne zachowanie "na ścianie"

if not wall? (90 * direction) 1 and wall? (135 * direction) (sqrt 2)

[ rt 90 * direction ]

;;ściana prosto: w razie potrzeby skręć w lewo (czasami więcej niż raz)

while [wall? 0 1] [ lt 90 * direction]

;; pójść naprzód

fd 1

end

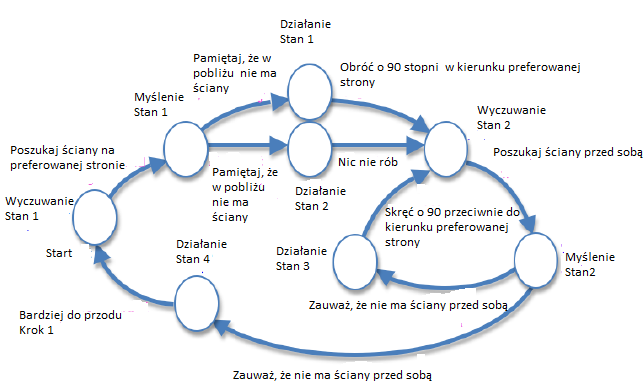

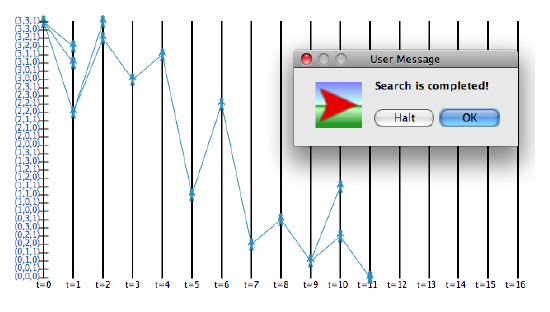

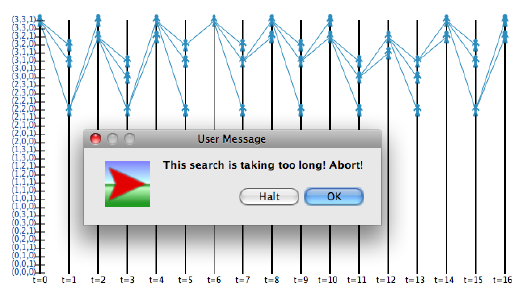

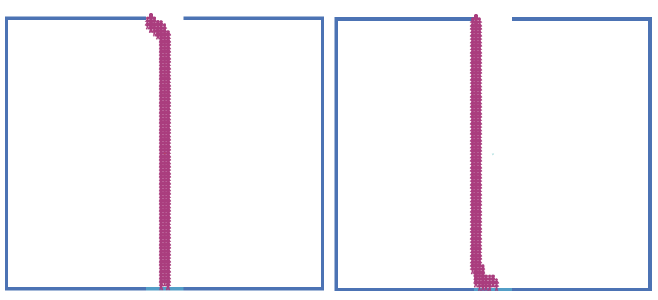

Kod został przekonwertowany na skończony automat stanów poprzez uporządkowanie stanów w trybie działania "zmysłów - myśl-działanie" zgodnie z opisem. Zwróć uwagę, że nie jesteśmy ograniczeni do dokonywania konwersji w ten szczególny sposób - możemy dowolnie organizować państwa i przejścia w dowolny sposób. W tym przykładzie stany i przejścia, jak pokazano na rysunku, zostały zorganizowane w celu odzwierciedlenia rodzaju działania (wykrywanie, myślenie lub działanie), które agent ma wykonać podczas następnego przejścia ze stanu. Ponadto, niezależnie od wybranej ścieżki, kolejność przechodzenia stanów jest zawsze stanem odczuwającym, po którym następuje stan myślenia, a następnie stan działania. Następnie następuje kolejny stan odczuwania i tak dalej. Na przykład zachowanie agenta rozpoczyna się od stanu wyczuwania (oznaczonego jako "Stan czuwania 1") na lewym środku rysunku. Jest tylko na przejściu poza tym stanem i używany jest określony sens jest widzeniem,

ponieważ wykonywana czynność polega na szukaniu ściany po korzystnej stronie (to znaczy prawej stronie, gdy podążają za prawymi ściankami, a lewej strony, jeśli podążają za ścianami po lewej ręce). Następnie agent przechodzi do stanu myślenia (Thinking State 1), który uwzględnia informacje, które otrzymał z tego, co wyczuł. Myśląca czynność wykonywana przez agenta polega na odnotowaniu, czy w pobliżu znajduje się ściana. Jeśli nie było, to agent przechodzi do stanu działania (Stan działania 1), który polega na wykonaniu działania obracania o 90 ° w kierunku preferowanej strony. Jeśli była ściana, nie wykonuje się żadnej akcji (Stan działania 2). Zauważ, że robienie niczego nie jest uważane za działanie, ponieważ jest ruchem o zerowej długości. Agent przejdzie następnie do nowego stanu odczuwania (Sensing State 2), który obejmuje wyczuwalne działanie polegające na szukaniu ściany przed sobą. Będzie on wielokrotnie przechodzić przez stan roboczy (Stan działania 3), obracając się o 90 ° w kierunku przeciwnym do preferowanej strony i z powrotem do Czuły 2, dopóki nie będzie ściany naprzód. Następnie przejdzie do stanu działania (Stan działania 4) przesunięcia o 1 stopień do przodu i do początku. Jak wskazano, metoda działania "Rozważaj - myśl - działaj" ma ograniczenia w stosowaniu do modelowania prawdziwych, inteligentnych lub poznawczych zachowań, i zasugerowano alternatywne podejście obejmujące ucieleśnione, usytuowane poznanie. Pozostaje jednak pytanie o to, jak wdrożyć takie podejście, ponieważ skutecznie obejmuje ono wykrywanie, myślenie i działanie, wszystkie występujące jednocześnie, tj. Jednocześnie, a nie sekwencyjnie. Opracowano dwa modele NetLogo, aby zilustrować jeden sposób, w jaki można to symulować. Pierwszy model (nazywany Wall Following Example 2) jest modyfikacją modelu Wall Po Example opisanego w poprzednim rozdziale. Zmodyfikowany interfejs udostępnia selektor, który pozwala użytkownikowi wybrać standardowe zachowanie po ścianie lub zmodyfikowany wariant. Zmodyfikowany kod jest wyświetlany w kodzie NetLogo

turtles-own

[direction ;; 1 podąża za prawą ścianą, -1 podąża za lewą ścianą

way-is-clear? ;; reporter - prawda, jeśli nie ma przed sobą ściany

checked-following-wall?] ;; reporter - prawda, jeśli zaznaczona po ścianie

to go

if-else (behaviour = "Standard")

[ ask turtles [ walk-standard ]]

[ ask-concurrent turtles

[ walk-modified shuffle [1 2 3]]

]

tick

end

to walk-standard ;; standardowe zachowanie żółwia

;; w razie potrzeby skręć w prawo

if not wall? (90 * direction) and wall? (135 * direction)

[ rt 90 * direction ]

;; w razie potrzeby skręć w lewo (czasami więcej niż raz)

while [wall? 0] [ lt 90 * direction ]

;; pójść do przodu

fd 1

end

to walk-modified [order] ;; zmodyfikowane zachowanie podczas chodzenia żółwia

ifelse (choose-sub-behaviours = "Choose-all-in-random-order")

[

foreach order

[ if (? = 1) [ walk-modified-1 ]

if (? = 2) [ walk-modified-2 ]

if (? = 3) [ walk-modified-3 ]]

][

let ord one-of order

if (ord = 1) [ walk-modified-1 ]

if (ord = 2) [ walk-modified-2 ]

if (ord = 3) [ walk-modified-3 ]

]

end

to walk-modified-1 ;; zmodyfikowane zachowanie podchodzące do żółwia 1

;; w razie potrzeby skręć w prawo

if not wall? (90 * direction) and wall? (135 * direction)

[ rt 90 * direction ]

set checked-following-wall? true

end

to walk-modified-2 ;; zmodyfikowane zachowanie podchodzące do żółwia 2

;; w razie potrzeby skręć w lewo (czasami więcej niż raz)

ifelse (wall? 0)

[ lt 90 * direction

set way-is-clear? false ]

[ set way-is-clear? true ]

end

to walk-modified-3 ;; zmodyfikowane poddziałanie chodzenia żółwia 3

;; pójść do przodu

if way-is-clear? and checked-following-wall?

[ fd 1

set way-is-clear? false

set checked-following-wall? false ]

end

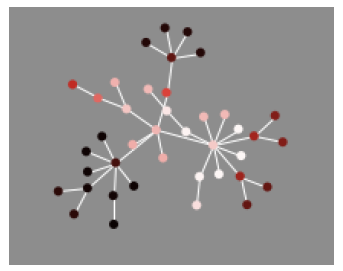

Aby zasymulować równoległy charakter zmodyfikowanego zachowania, oryginalne zachowania związane z zachowaniem ściany zostały podzielone na trzy pod-zachowania - są one określone w procedurach walk-modified-1, walk-modified-2 i walk-modified-3 powyższego kodu. Pierwsza procedura sprawdza, czy agent nadal podąża za ścianą i w razie potrzeby zmienia się na preferowaną stronę. Następnie ustawia zmienną agenta, checked-following-wall na prawdę, aby wskazać, że to zrobiło. Druga procedura sprawdza, czy ściana jest przed nami, skręca w przeciwnym kierunku do preferowanej strony, jeśli istnieje, a następnie ustawia nową zmienną agenta way-is-clear aby wskazać, czy ściana jest przed nami, czy nie. Trzecia procedura przesuwa się o 1 krok do przodu, ale tylko wtedy, gdy obie drogi są wyraźnie przed sobą i wykonano sprawdzenie podążania za ścianą. Zasadniczo ogólne zachowanie jest takie samo jak poprzednio, ponieważ wszystko, co zrobiliśmy, to podzielenie pierwotnego zachowania na trzy pod-zachowania - innymi słowy, samo zrobienie tego samo nie przynosi niczego nowego. Powodem tego jest umożliwienie nam wykonywania sub-zachowań w sposób niesekwencyjny, niezależnie od siebie, w celu symulowania zachowania "odczuwanie i myślenie i działanie", gdzie "i" wskazuje, że każdy jest wykonywany jednocześnie, w bez szczególnej kolejności. Można to zrobić w NetLogo za pomocą polecenia ask-concurrent, jak pokazano w procedurze go w kodzie. Zapewnia to, że każdy agent na zmianę wykonuje komendy procedury walk-modified. Główna różnica w porównaniu ze standardowym zachowaniem jest widoczna w tej procedurze. Interfejs do modelu zapewnia inny wybierak, który pozwala użytkownikowi ustawić zmienną choose-sub-behaviours, która kontroluje sposób wykonywania czynności podrzędnych. Jeśli ta zmienna jest ustawiona na " Choose-all-in-random order", wtedy wszystkie trzy sub-zachowania będą wykonywane jak przy standardowym zachowaniu, ale tym razem w losowej kolejności; w przeciwnym razie zmienna jest ustawiona na Choose-one-at-random" i wybierane jest tylko jedno zachowanie podrzędne. Oczywiście sposób, w jaki modyfikowane zachowanie jest wykonywane, jest teraz wyraźnie różny od standardowego zachowania - mimo że pierwszy wykonuje te same pod-zachowania tego drugiego, to jest to wykonywane w określonej kolejności, lub wybierane jest tylko jedno z trzech pod-zachowań. każdy tyk. A jednak podczas pracy z modelem uzyskuje się takie same ogólne wyniki, niezależnie od tego, który wariant modelu zostanie wybrany - każdy agent z powodzeniem udaje się podążać za ścianami, które znajdują się w środowisku. Występują niewielkie różnice między poszczególnymi wariantami, takie jak wielokrotne przechodzenie w tył i w dół w dół po krótkich ślepiach za zmodyfikowane warianty. Zdolność zmodyfikowanych wariantów do osiągnięcia podobnego rezultatu co oryginał jest interesująca, ponieważ zmodyfikowana metoda jest zarówno skuteczna, jak i niezawodna - niezależnie od tego, kiedy iw jakiej kolejności wykonywane są subkwarki, ogólny wynik jest nadal podobnie. Drugi model NetLogo, model Wall Following Events, został stworzony w celu konceptualizacji i wizualizacji zmodyfikowanego zachowania. Model ten uważa, że agent jednocześnie rozpoznaje i przetwarza wiele strumieni "zdarzeń", które odzwierciedlają to, co dzieje się z nim samym i w środowisku (w sposób podobny do tego przyjętego w procesie przetwarzania strumienia zdarzeń (ESP). mają różne typy, ale są traktowane jako równoważne sobie nawzajem pod względem sposobu ich przetwarzania. Zachowanie definiuje się poprzez łączenie szeregu zdarzeń w las drzew (jeden lub więcej acyklicznych kierowanych wykresów), jak pokazano na rysunku.

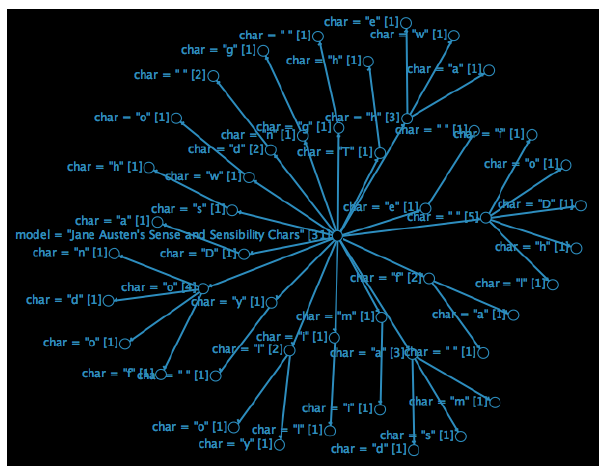

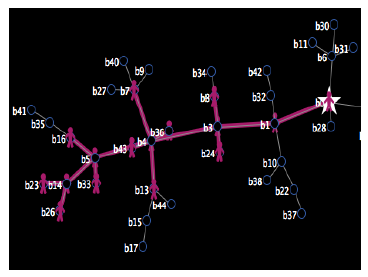

Drzewa łączą ze sobą serie zdarzeń (reprezentowane jako węzły na wykresie), które muszą występować w połączeniu ze sobą. Jeśli określone zdarzenie nie jest zarejestrowane w drzewie, to zdarzenie nie jest rozpoznawane przez agenta (tj. jest ignorowane i nie ma wpływu na zachowanie agenta). Przetwarzanie zdarzeń odbywa się w sposób reaktywny - to znaczy, że określona ścieżka w drzewie jest przesuwana przez sukcesywne dopasowywanie zdarzeń, które obecnie występują do agenta, w stosunku do wychodzących przejść z każdego węzła. Jeśli nie ma żadnych przejść wychodzących lub żadne nie pasują, ścieżka jest ślepym zaułkiem, w którym to momencie traversal się zatrzyma. Odbywa się to jednocześnie dla każdego zdarzenia; innymi słowy, istnieje wiele punktów początkowych, a zatem jednoczesne aktywacje w sieci leśnej. Na rysunku, drzewa zdarzeń zostały zdefiniowane w celu reprezentowania zmodyfikowanej ściany po zachowaniu określonym powyżej. Każdy węzeł na wykresie reprezentuje zdarzenie, które jest oznaczone przez identyfikator strumienia, oddzielone znakiem "=", po którym następuje identyfikator zdarzenia. Na przykład węzeł oznaczony [motor-event = moveforward-1] identyfikuje zdarzenie motoryczne dotyczące przesuwania do przodu o 1 stopień. W przypadku tego modelu zachowania istnieją cztery typy zdarzeń - wykrywanie zdarzeń, w których agent rozpoczyna aktywne wykrywanie konkretnego strumienia danych czuciowych (takiego jak widok, jak na rysunku); zdarzenia ruchowe, w których agent wykonuje pewien ruch lub działanie, zdarzenia określone przez obiekt, które występują, gdy dany obiekt jest rozpoznawany przez agenta; i zdarzenia abstrakcyjne, które są abstrakcyjnymi sytuacjami, które są wynikiem jednego lub więcej zdarzeń zmysłowych, motorycznych i abstrakcyjnych, i które mogą być również tworzone lub usuwane przez agenta z jego wewnętrznej pamięci (która rejestruje, które abstrakcyjne zdarzenia są obecnie aktywne). Jeśli w pamięci znajduje się określone abstrakcyjne zdarzenie, można go użyć do późniejszego dopasowywania przez agenta wzdłuż ścieżki drzewa. Na przykład węzeł oznaczony [sensing event = use-sight] w środkowym prawym rogu rysunku reprezentuje zdarzenie, w którym agent używa zmysłu wzroku. Na tym czuciowym kanale wejściowym może wystąpić wiele zdarzeń, ale tylko dwa zdarzenia są szczególnie istotne dla zdefiniowania zachowania na ścianie - są to zarówno zdarzenia ruchowe, z których jedno jest działaniem polegającym na patrzeniu w przyszłość, a drugim jest działaniem polegającym na patrzeniu w prawo. . Następnie, w zależności od tego, która ścieżka jest śledzona, w drzewku napotykane są różne zdarzenia sensed-object, albo obiekt ściany jest wykrywany, albo nic nie jest wykrywane. Ścieżki te są kontynuowane, dopóki nie zostanie wykonane ostatnie zdarzenie motoryczne (takie jak obrót o 90 ° w stronę preferowaną w prawym górnym rogu figury) lub zostanie utworzone zdarzenie abstrakcyjne (np. czy śledzenie ściany zostało sprawdzone w dole rysunku). Należy zauważyć, że w przeciwieństwie do modelu Sense - Think - Act, ten model zachowania nie ogranicza się do określonej kolejności zdarzeń. Każdy rodzaj zdarzenia może "podążać" za innym, a dwa tego samego typu są również możliwe - na przykład w ścieżce, która rozpoczyna się po lewej stronie rysunku, po sobie następują dwa abstrakcyjne zdarzenia. Należy również zauważyć, że użycie słowa "follow" jest mylące w tym kontekście. Chociaż odpowiednio opisuje, że jedno łącze przychodzi po drugim na określonej ścieżce w modelu drzewa, zdarzenie może faktycznie wystąpić jednocześnie, a kolejność określona przez ścieżkę drzewa jest dowolna i po prostu opisuje kolejność, w której agent rozpozna obecność wielokrotnie występujących zdarzeń. Na przykład, nie ma powodu, dla którego przeciwna kolejność nie może być obecna w drzewie; lub kolejność alternatywna, która doprowadzi do takiego samego zachowania (np. zamiana dwóch abstrakcyjnych zdarzeń na dole ścieżki lewej ręki na rysunku nie będzie miała wpływu na wynikowe zachowanie agenta). Kod służący do utworzenia zrzutu jest wyświetlany w kodzie NetLogo

breed [states state]

directed-link-breed [paths path]

states-own

[ depth ;; głębokość w drzewie

stream ;; nazwa strumienia zdarzeń sensorycznych lub motorycznych

event ;; zdarzenie sensoryczne lub motoryczne

]

globals

[ root-colour node-colour link-colour ]

;; określa sposób wizualizacji drzewa zdarzeń

to setup

clear-all ;; wyczyść wszystko

set-default-shape states "circle 2"

set root-colour sky

set node-colour sky

set link-colour sky

add-events (list ["sensing-event" "use-sight"]

(list "motor-event" "look-to-right")

(list "sensed-object-event" "wall")

(list "motor-event" "turn-90-to-preferred-side")

(list "create-abstract-event" "checked-following-wall"))

add-events (list ["sensing-event" "use-sight"]

(list "motor-event" "look-to-right")

(list "sensed-object-event" "nothing")

(list "create-abstract-event" "checked-following-wall"))

add-events (list ["sensing-event" "use-sight"]

(list "motor-event" "look-ahead")

(list "sensed-object-event" "wall")

(list "motor-event" "turn-90-to-non-preferred-side"))

add-events (list ["sensing-event" "use-sight"]

(list "motor-event" "look-ahead")

(list "sensed-object-event" "nothing")

(list "create-abstract-event" "way-is-clear"))

add-events (list ["abstract-event" "checked-following-wall"]

(list "abstract-event" "way-is-clear")

(list "motor-event" "move-forward-1")

(list "delete-abstract-event" "way-is-clear")

(list "delete-abstract-event" "checked-following-wall"))

reset-layout

end

to reset-layout

repeat 500

[ layout-spring states paths spring-constant spring-length

repulsion-constant ]

;; zostaw miejsce wokół krawędzi

ask states [ setxy 0.95 * xcor 0.95 * ycor ]

end

to change-layout

reset-layout

display

end

to set-state-label

;; ustawia etykietę dla stanu

set label (word "[" stream " = " event "] ")

end

to add-events [list-of-events]

;; dodaj zdarzenia z listy wydarzeń do drzewa wydarzeń.

;; każda pozycja listy wydarzeń musi składać się z dwóch pozycji.

;; na przykład [[odcień 0,9] [jasność 0,8]]

let this-depth 0

let this-stream ""

let this-event ""

let this-state nobody

let next-state nobody

let these-states states

let matching-states []

let matched-all-so-far true

foreach list-of-events

[ set this-stream first ?

set this-event last ?

;; sprawdź, czy stan już istnieje

set matching-states these-states with

[stream = this-stream and event = this-event]

ifelse (matched-all-so-far = true) and (count matching-states > 0)

[

set next-state one-of matching-states

ask next-state [ set-state-label ]

set these-states [out-path-neighbors] of next-state ]

[ ;; stan nie istnieje - utwórz got

set matched-all-so-far false

create-states 1

[

set size 8

set depth this-depth

set stream this-stream

set event this-event

set-state-label

ifelse (depth = 0)

[ set label-color root-colour ]

[ set label-color node-colour ]

ifelse (depth = 0)

[ set color root-colour ]

[ set color node-colour ]

set next-state self

]]

if (this-state != nobody)

[ ask this-state

[ create-path-to next-state [ set color link-colour ]]]

;; zejść z drzewa

set this-state next-state

set this-depth this-depth + 1

]

ask links [ set thickness 1.3 ]

end

Kod najpierw określa dwa typy, stany i ścieżki, które reprezentują przejścia między stanami. Każdy agent państwowy ma powiązane trzy zmienne - depth, która jest odległością od stanu głównego drzewa; stream, który identyfikuje nazwę określonego typu zdarzenia; i wydarzenie, które jest nazwą wydarzenia. Typ zdarzenia nazywany jest "strumieniem", ponieważ używamy analogii wyglądu zdarzeń jako podobnych do przepływu obiektów w strumieniu. Wiele wydarzeń może "przepływać" przeszłością, niektóre pojawiają się jednocześnie, ale jest też określona kolejność nadejścia wydarzeń, ponieważ jeśli zignorujemy konkretne wydarzenie, zostanie ono utracone - musimy sobie z nim w jakiś sposób poradzić. Procedura setup inicjalizuje drzewa zdarzeń, wywołując procedurę add-events dla każdej ścieżki. Ta procedura pobiera pojedynczy parametr jako dane wejściowe, które jest listą zdarzeń określonych jako pary nazw strumieni i nazw zdarzeń. Na przykład dla pierwszego wywołania add-events lista zawiera pięć zdarzeń: pierwsza to zdarzenie typu "use-sight" w strumieniu sensing-event ; drugie jest zdarzeniem look-to-right w strumieniu motor-event; i tak dalej. Kierowana ścieżka zawierająca wszystkie zdarzenia z listy zdarzeń jest dodawana do drzew zdarzeń. Jeśli pierwsze zdarzenie na liście nie występuje w katalogu głównym żadnego istniejącego drzewa, tworzony jest katalog główny nowego drzewa, a ścieżka bez rozgałęzień z katalogu głównego jest dodawana w celu uwzględnienia pozostałych zdarzeń na liście. W przeciwnym razie pierwsze zdarzenia na liście są porównywane z istniejącą ścieżką, z nowymi stanami dodanymi na końcu, gdy zdarzenia nie są już zgodne.

Algorytm stada

v

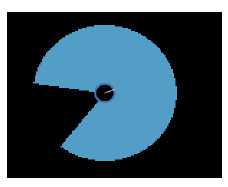

W 1986 r. Craig Reynolds opracował rozproszony model do symulacji zachowań zwierząt, który obejmuje skoordynowany ruch, taki jak uciekanie się do ptaków, uczenie ryb i pasterstwo dla ssaków. Reynolds obserwował flockowe zachowanie kosów i zastanawiał się, czy możliwe jest przyciągnięcie wirtualnych stworów w ten sam sposób w symulacji komputerowej w czasie rzeczywistym. Jego hipoteza była taka, że istniały proste reguły odpowiedzialne za to zachowanie. Model, który opracował, wykorzystuje wirtualne agenty zwane boids, które mają ograniczoną formę przykładu wykonania podobną do tej stosowanej przez agentów w modelu Vision Cone. Zachowanie boidów jest podzielone na trzy warstwy - wybór akcji, sterowanie i lokomocja - jak pokazano na rysunku.

Wybór Akcji : Strategia, wyznaczanie celów, planowanie

Sterowanie : Określenie ścieżki

Lokomocja : Ruch, animacja, artykulacja

Najwyższa warstwa dotyczy selekcji działań, która kontroluje zachowania, takie jak strategia, ustalanie celów i planowanie. Te składają się z zachowań sterujących na kolejnym poziomie, które dotyczą bardziej podstawowych zadań wyznaczania ścieżki, takich jak podążanie ścieżką, poszukiwanie i ucieczka. Te z kolei składają się z zachowań lokomocyjnych związanych z ruchem, animacją i artykulacją wirtualnych stworzeń. Aby opisać swój model, Reynolds używa analogii kowbojów, którzy opiekują się stadem bydła, gdy krowa odlatuje od stada. . Szef szlaku odgrywa rolę selekcji działań - mówi kowbojowi, by sprowadził bezpańskie z powrotem do stada. Kowboj odgrywa rolę sterowania, rozkładając cel na serię pod-celów, które odnoszą się do indywidualnych zachowań sterujących wykonywanych przez zespół kowbojów i koni. Kowboj steruje swoim koniem za pomocą sygnałów sterujących, takich jak polecenia głosowe i użycie ostróg i stew, które powodują, że zespół porusza się szybciej lub wolniej lub skręca w lewo lub w prawo. Koń wykonuje lokomocję, która jest wynikiem złożonej interakcji między wizualnymi percepcjami konia, ruchami jego mięśni i stawów oraz poczuciem równowagi. Należy zauważyć, że warstwy wybrane przez Reynoldsa są arbitralne, a bardziej kwestią projektowania odzwierciedlającą naturę problem modelowania. Sam Reynolds zwraca uwagę, że alternatywne struktury są możliwe, a ten wybrany do modelowania prostych istot flokujących nie byłby odpowiedni dla innego problemu, takiego jak projektowanie agenta konwersacyjnego lub chatbota. Tak jak w przypadku prawdziwych stworzeń, to, co te boidy widzą w dowolnym jednym punkcie w czasie jest wyznaczany przez kierunek, w którym są skierowane i zakres ich widzenia peryferyjnego, jak określono przez stożek o określonym kącie i odległości. Kąt stożka określa, jak duży jest "ślepy" punkt - to znaczy część, która znajduje się poza ich zasięgiem widzenia bezpośrednio za ich głową przeciwną do kierunku, w którym się znajdują. Jeśli kąt stożka wynosi 360 °, wtedy będą mogli zobaczyć wszystko dookoła; jeśli jest mniejsza, to wielkość martwego punktu jest różnicą między kątem stożka a 360 °. Algorytm może być łatwo zaimplementowany w NetLogo za pomocą polecenia in-cone, jak w przypadku modelu Vision Cone. Rysunek jest zrzutem ekranu boidu zaimplementowanego w NetLogo

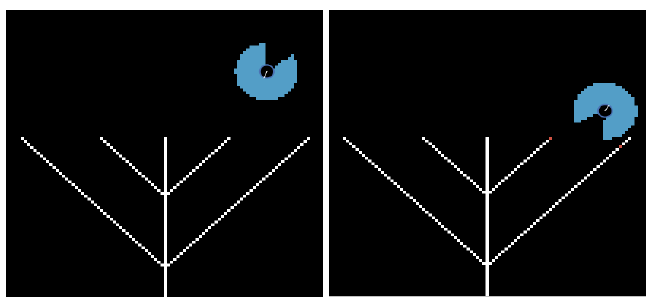

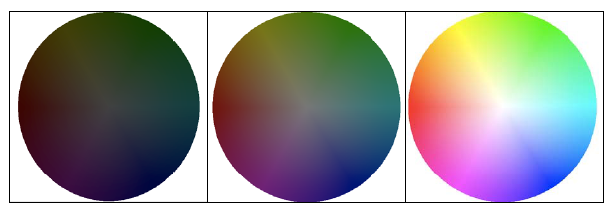

Zdjęcie przedstawia stożek widzenia w kolorze niebieskiego nieba o kącie 300 ° (rozmiar martwego pola wynosi 60 °). Żółw jest rysowany za pomocą kształtu "directional-circle" w środku obrazu i koloru niebieskiego, z białą linią promienia skierowaną w tym samym kierunku, co aktualny kurs żółwia. Szerokość stożka zależy od parametru długości przekazywanego do polecenia in-cone i rozmiaru patch dla środowiska. Zobaczymy teraz, jak niektóre z tych zachowań można wdrożyć w NetLogo. Zauważ, że tak jak w przypadku wszystkich implementacji, istnieją różne sposoby tworzenia każdego z tych zachowań. Na przykład, obserwowaliśmy już zachowanie się ściany, co zostało przedstawione w modelu "Ściana po przykładzie" opisanym w poprzedniej części oraz w modelu "Ściana po przykładzie 2" opisanym tu. Chociaż zachowanie nie jest dokładnie takie samo dla obu modeli, wynik jest faktycznie taki sam. Oba modele mają środki, które wykorzystują metodę stożka widzenia z przykładu wykonania z figury powyżej, która jest w sercu modelu behawioralnego boids. Opracowano dwa modele w celu wykazania unikania przeszkód. Niektóre zrzuty ekranu pierwszego modelu, o nazwie Unikanie przeszkód 1, przedstawiono na rysunku

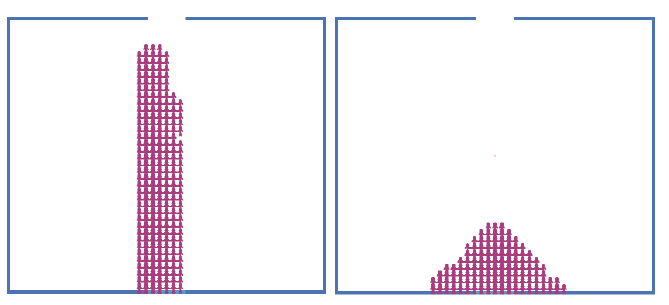

Pokazują one pojedynczy boid poruszający się po otoczeniu, próbując uniknąć białych rzędów przeszkód - analogią byłaby ćma, starająca się uniknąć wpadnięcia na ściany podczas lotu. Zakres widzenia boidów jest pokazany przez halo w kolorze nieba otaczając boid - został ustawiony na długości 8 w modelu o kącie 300 °. Obraz po lewej pokazuje boid tuż po naciśnięciu przycisku setup w interfejsie w kierunku rzędów przeszkód. Po kilku kleszczach krawędź stożka wizji boida wpada na koniec środka północno-wschodniego, wskazujący przekątną rząd przeszkód (przedstawiony przez zmianę koloru przeszkody na czubku od białego do czerwonego), następnie obraca się w lewo o około 80 ° i kieruje się w stronę zewnętrznej przekątnej. Jego stożek widzenia również trafi w pobliżu końca tej przekątnej, a następnie w końcu boid ponownie się obraca i odsuwa się od przeszkód w kierunku północno-wschodnim, jak pokazano na drugim obrazku po prawej. Kod do tego jest pokazany w kodzie NetLogo

breed [wanderers wanderer] ; name of the breed of boids

to setup

clear-all

set-default-shape wanderers "directional-circle"; ustawia kształty boid

; stworzyć kolor, rozmiar i losową lokalizację pojedynczego wędrowca

create-wanderers 1 [default blue ]

draw-obstacles

end

to default [colour] ; worzy domyślne ustawienia boid

print "Got here"

set color colour ; ustawia kolor za pomocą przekazanego parametru

setxy random-xcor random-ycor ; ustawia początkową losową pozycję

set size 5 ; domyślny rozmiar żółwia

end

to draw-obstacles

ask patches with [pxcor = 0 and pycor <= 15 or

abs pxcor = (pycor + 40) and pycor < 40 or

abs pxcor = (pycor + 15) and pycor < 6]

[ set pcolor white ]

end

to make-obstacle

if mouse-down?

[ ask patches

[ if ((abs (pxcor - mouse-xcor)) < 1) and

((abs (pycor - mouse-ycor)) < 1)

[ set pcolor white ]

]

]

end

to go

ask wanderers ; nstrukcje wędrowców

[

rt random-float rate-of-random-turn

lt (rate-of-random-turn / 2)

; losowo obraca się w górę w lewo lub w prawo, zgodnie z definicją

; zmienna losowa stopa zwrotu w interfejsie

fd boid-speed

avoid-patches

]

end

to avoid-patches

ask patches with [pcolor = sky]

[ set pcolor black ]

ask patches in-cone radius-length radius-angle

[ if pcolor = black

[ set pcolor sky ]

if pcolor = white

[ set pcolor red ]]

if count patches in-cone radius-length radius-angle with

[pcolor = white or pcolor = red] > 0

[

ask wanderer 0

[

bk boid-speed

lt 90

]

]

end

Procedura setup umieszcza boid w losowym miejscu w otoczeniu i wywołuje procedurę draw-obstacles, aby narysować białe przeszkody w dolnej połowie środowiska. Polecenie ask-wanderers w procedurze go określa zachowanie boid. Boid wykona obrót w prawo i lewo o losową liczbę, a następnie przesunie do przodu o określoną wartość określoną przez zmienną boid-speed zdefiniowaną w interfejsie. Następnie boid wywołuje procedurę avoid-patches w celu uniknięcia kolizji. W tej procedurze najpierw zabarwiony na niebie halo otaczający boid zostaje skasowany poprzez ustawienie kolorowych plam na niebie na czarny. Następnie halo wzroku jest przerysowywane wokół boidu w oparciu o jego bieżące położenie - szybkie wymazanie, a następnie przerysowanie powoduje, że boid migocze jak motyl szybko macha skrzydłami. Boid następnie wykonuje unikanie kolizji, cofając dystans równy boid-speeed i wykonuje skręt w lewo. Ostatnia część procedury powoduje, że łatki, które zostały zderzone z kolorem czerwonym. Model Unikania Przeszkód 2 ilustruje unikanie przeszkód w tym samym środowisku, co model przewidywany z biblioteki modeli. Zrzut ekranu modelu pokazano na rysunku

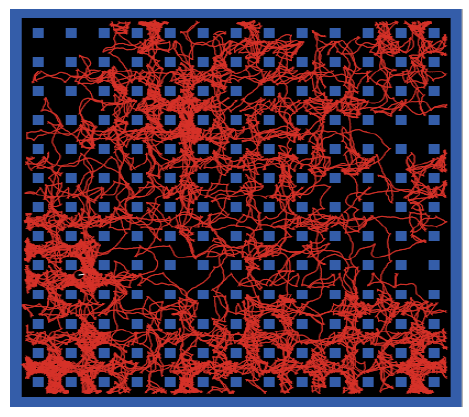

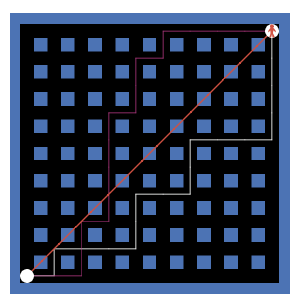

Wężyk można zobaczyć w środkowym lewym rogu otoczenia. Ścieżka, którą podjął boid, jest wykreślona na czerwono. To wyraźnie pokazuje, że boid udało się uniknąć kolizji ze ścianami i przeszkodami. Długość stożka widzenia boida ustawiono na 1, a kąt 300 °. Kod jest podobny do modelu Unikania Przeszkód 1. Model "Podążaj za i unikaj" wdraża poszukiwania i ucieka przed zachowaniami. Trzy zrzuty ekranu tego modelu pokazano na rysunku

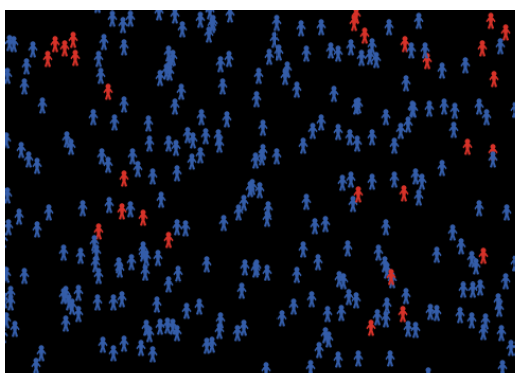

Lewy obraz pokazuje, kiedy jeden środek wędrowiec jest w kolorze czerwonym, a 100 osób naśladowców ma kolor zielony. Pokazuje większość agentów skierowanych w stronę agenta wędrownego. Podczas symulacji agenci naśladowcy aktywnie ścigają agenta wędrownego, gdy wędruje on wokół. Środkowy obraz pokazuje 100 środków zapobiegających powstawaniu koloru, które zabarwiają się na żółto, próbując uniknąć środka wędrownego. W tym przypadku większość czynników unikających jest odsunięta od środka wędrownego i aktywnie odsunie się od niego podczas symulacji. Odpowiedni obraz pokazuje sytuację, w której 50 agentów obserwujących i 50 agentów unikowych znajduje się w środowisku wraz z agentem wędrownym. Obraz pokazuje większość agentów obserwujących na zielono, wskazując na wędrowca, a większość środków zapobiegawczych na żółto wskazuje z niego. Na początku wszyscy agenci są losowo rozmieszczeni w całym środowisku, ale po przeprowadzeniu symulacji dla krótkiej liczby kleszczy, zwykle pojawia się, że zarówno zwolennicy, jak i czynniki unikające zaczną zbijać się razem, jak pokazano na obrazku. Kod modelu jest pokazany w kodzie NetLogo

breed [wanderers wanderer] ; wanders around

breed [followers follower] ;próbuje podążać za wędrowcem

breed [avoiders avoider] ; próbuje uniknąć wędrowca

to setup

clear-all

; ustawić kształty dla ras

set-default-shape wanderers "directional-circle"

set-default-shape followers "directional-circle"

set-default-shape avoiders "directional-circle"

; stwórz wędrowca, wyznawcę i unikającego w losowych miejscach

create-wanderers 1 [ default red ]

create-followers number-of-followers [ default green ]

create-avoiders number-of-avoiders [ default yellow ]

end

to-report number-of-agents

; używane, aby pokazać, że liczba żółwi jest stała, nawet gdy

; wszyscy obserwujący zbijają się jedna na drugiej

report count turtles

end

to default [colour] ; creates default settings for boid

set color colour ; sets colour using passed parameter

setxy random-xcor random-ycor ; sets an initial random position

set size 3 ; default turtle size

end

to go

ask wanderers ; instrukcje wędrowca

[

lt random 30 ; losowo skręć w lewo

rt 15

fd boid-speed ; zmienna prędkość zdefiniowana przez użytkownika

]

ask followers ;instrukcje obserwującego

[

fd boid-speed / speed-scale ; porusza się do przodu ze zdefiniowaną przez użytkownika prędkością

; obserwujący szuka wędrowca w promieniu

if any? wanderers in-radius radius-detection

[ set heading (towards wanderer 0) - random boid-random-heading

+ random boid-random-heading

; dostosowuje kurs do punktu wędrowca]

]

ask avoiders ; avoiders' instructions

[

fd boid-speed / speed-scale ; moves forward at user defined speed

; unikaj poszukiwań wędrowca w jego promieniu

if any? wanderers in-radius radius-detection

[ set heading (towards wanderer 0) + 180 - random boid-random-heading

+ random boid-random-heading ]

; dostosowuje kurs, aby wskazywał z dala od wędrowca

]

end

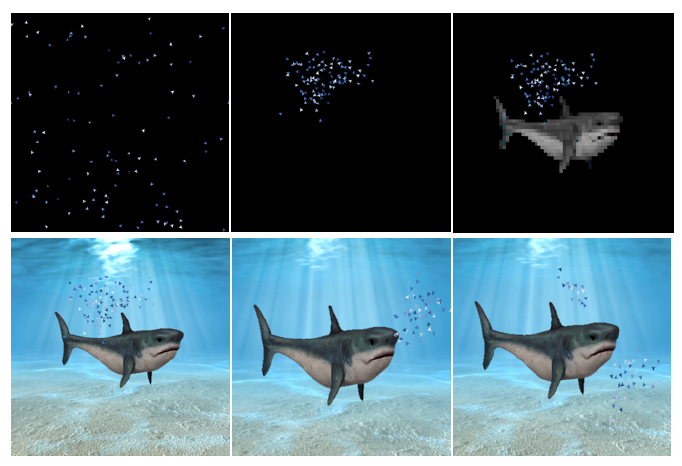

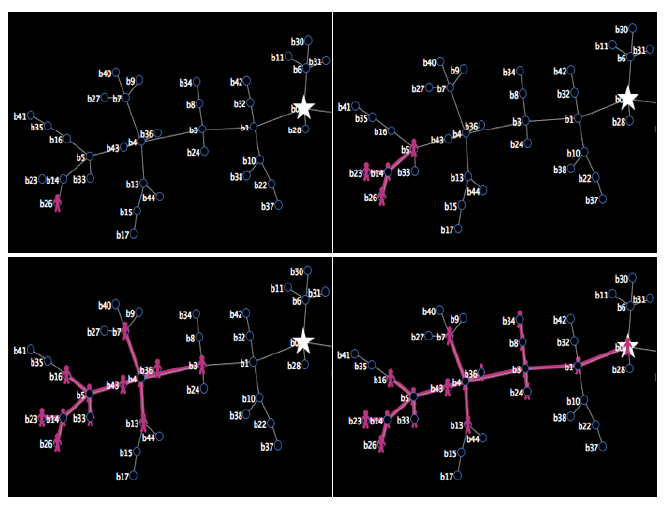

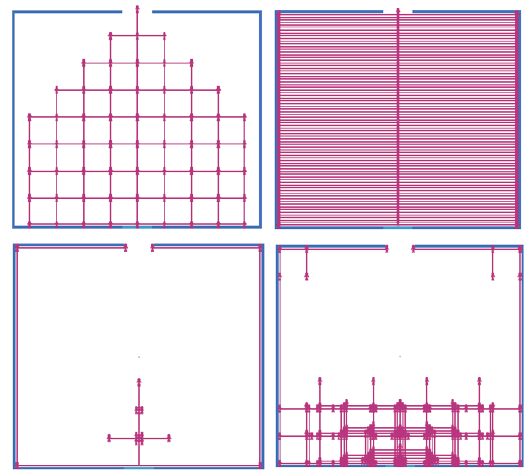

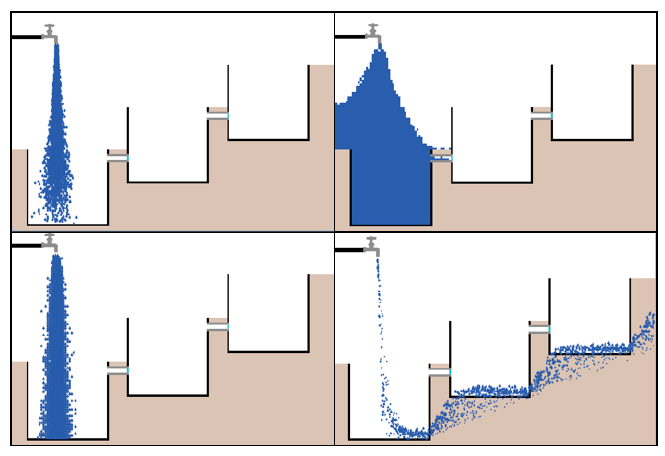

Zachowanie trzech typów agentów określają procedury wanderers, followers i avoiders. Pierwszy określa zachowanie agenta wędrownego, aby błąkał się w sposób półlosowy. Drugi definiuje zachowanie dla agenta obserwującego, który polega na tym, że agent najpierw przesuwa się do przodu o określoną przez użytkownika liczbę zgodnie ze zmiennymi boid-speed i speed -scale. Następnie używa reportera in-radius NetLogo, aby wykryć, czy wędrowiec jest w jego okrągłym polu widzenia, którego wielkość jest określona przez zmienną Interface radius-detection. Jeśli tak, to ruszy w jego kierunku. Zachowanie agenta unikającego definiuje się w podobny sposób, z tą różnicą, że kieruje się w przeciwnym kierunku (180 °) od wędrownego zamiast do niego. Model Flocking With Obstacles jest modyfikacją modelu Flocking dostępnego w bibliotece modeli NetLogo. Model biblioteki wykorzystuje standardową metodę implementacji zachowania flokowania opracowaną przez Craiga Reynoldsa. W tym podejściu flokowanie wyłania się z zastosowania trzech podstawowych zachowań sterujących. Są to: separacja, gdzie boid próbuje uniknąć zbytniego zbliżania się do innych boidów; wyrównanie, gdzie boid próbuje poruszać się w tym samym kierunku, co pobliskie boidy; i spójności, gdzie boid próbuje przejść w kierunku innych boidów, chyba że są zbyt blisko. Dzięki zmodyfikowanemu modelowi użytkownik ma dodatkową opcję dodawania różnych obiektów do otoczenia, takich jak rafa koralowa, trawa morska i rekin. Ma to na celu symulację tego, co dzieje się, gdy stado napotka jeden lub więcej obiektów i lepiej symuluje środowisko dla szkoły ryb. Niektóre zrzuty ekranu zmodyfikowanego modelu są pokazane na rysunku

Górny lewy obraz pokazuje model na początku po naciśnięciu przycisku konfiguracji w interfejsie. Środkowy górny obrazek pokazuje model po jego uruchomieniu na krótką chwilę i powstała szkoła agentów żółwi. Prawy górny obrazek pokazuje model z łatami kolizji dodanymi w środku w kształcie rekina załadowanego natychmiast po wykonaniu poprzedniego zdjęcia. Te plastry powodują oderwanie się agentów żółwia, gdy zderzają się z nimi. Lewy dolny obraz pokazuje obraz tła nałożony na ten sam obraz. Środkowe dolne zdjęcie pokazuje szkołę zbliżającą się do obiektu z innego kierunku. Obraz w prawym dolnym rogu pokazuje scenę niedługo po tym, jak szkoła podzieliła się na dwie podkategorie po kolizji i odchodzą od obiektu. Łatki zderzeniowe działają zgodnie z modelem, który zakłada, że należy unikać jakiejkolwiek łaty, która nie jest czarna; to znaczy, że wszystkie kolory, z wyjątkiem czarnego, zmuszają boidy do obrócenia się o 180 °, aby uniknąć kolizji. Inną zmianą w modelu jest to, że prędkość przenośnych boidów może być teraz kontrolowana z interfejsu, aby umożliwić większe testowanie poszczególnych ruchów, a także zapewnia możliwość analizowania reakcji boidów. Kod odpowiednich części zmodyfikowanego modelu, które definiują zachowanie agentów, znajduje się w kodzie NetLogo

turtles-own [

flockmates ;; zestaw agentów pobliskich żółwi

nearest-neighbor ;; najbliższy jeden z naszych stad

]

to setup

clear-all

crt population

[ set color blue - 2 + random 7

set size 1.5

setxy random-xcor random-ycor ]

end

to go

ask turtles [ flock ]

repeat 5 [ ask turtles [ fd set-speed / 200 ] display ]

tick

end

to flock

find-flockmates

if any? flockmates

[ find-nearest-neighbor

ifelse distance nearest-neighbor < minimum-separation

[ separate ]

[ align

cohere ] ]

avoid-obstacles

end

to avoid-obstacles

; unikaj w pobliżu wszystkiego, co nie jest czarne

if (any? patches in-cone 2 300 with [pcolor != black])

[ rt 180 ] ; skieruj się w przeciwnym kierunku

end

to find-flockmates

set flockmates other turtles in-radius vision

end

to find-nearest-neighbor

set nearest-neighbor min-one-of flockmates [distance myself]

end

to separate

turn-away ([heading] of nearest-neighbor) max-separate-turn

end

to align

turn-towards average-flockmate-heading max-align-turn

end

to-report average-flockmate-heading

report atan sum [sin heading] of flockmates

sum [cos heading] of flockmates

end

to cohere

turn-towards average-heading-towards-flockmates max-cohere-turn

end

to-report average-heading-towards-flockmates

report atan mean [sin (towards myself + 180)] of flockmates

mean [cos (towards myself + 180)] of flockmates

end

to turn-towards [new-heading max-turn]

turn-at-most (subtract-headings new-heading heading) max-turn

end

to turn-away [new-heading max-turn]

turn-at-most (subtract-headings heading new-heading) max-turn

end

to turn-at-most [turn max-turn]

ifelse abs turn > max-turn

[ ifelse turn > 0

[ rt max-turn ]

[ lt max-turn ] ]

[ rt turn ]

end

Procedura setup tworzy losową populację środków żółwia. Polecenie ask w procedurze go określa zachowanie agentów - po prostu wywołuje procedurę flock. W tym miejscu agent najpierw sprawdza, czy w jego polu widzenia znajdują się inne czynniki, a następnie, jeśli istnieją, szuka najbliższego sąsiada, a następnie stosuje kierowanie separacją określone w procedurze, separate jeśli jest zbyt blisko . W przeciwnym razie stosuje się zachowanie kierowania wyrównaniem, jak określono w procedurze dopasowywania, po której następuje kierowanie kohezją zgodnie z definicją procedury cohere. Te trzy procedury korzystają z procedur turn-away lub turn-towards, które powodują, że boid się odwraca lub w kierunku konkretnej pozycji odniesienia, biorąc pod uwagę aktualną pozycję boid's. Nagłówkiem odniesienia dla zachowania kierowania separacją jest nagłówek najbliższego sąsiada boida, dla zachowanie kierowania wyrównaniem to średnia pozycja wiązań stada boidów, a dla zachowania sterowności kohezji jest to średni kurs w kierunku węzłów stada boidów. W symulacji można zaobserwować wiele pojawiających się zjawisk. Stado szybko formuje się na początku, gdy nie ma żadnych przeszkód. Zauważalny efekt wirowania można również zaobserwować dla boidów w stadzie, jeśli początkowe parametry interfejsu są ustawione jako minimum-separation = 1,25 łaty, max-align-turn = 15,00 stopni, max-cohere-turn = 15,00 stopni i max-separate-turn = 4,00 stopni. Kiedy szkoła napotyka przeszkodę, zmienia kierunek jako grupa z indywidualnymi boidami, które bardzo szybko przejmują stado, jeśli się rozdzielą. Kiedy wystarczająca ilość boidów zmieniła kurs, reszta szkoły podąża za nią bez żadnego kolizji z przeszkodą. Czasami szkoła dzieli się na dwie odrębne szkoły kierując się w różnych kierunkach, jak pokazano w prawym dolnym obrazie na rysunku powyżej .Model śledzenia ścieżki tłumu implementuje zachowanie boidów w tłumie podążającym ścieżką. Zachowanie boidów w modelu może mieć dwie odmiany - podstawowe zachowanie po ścieżce tłumu i jedno z unikaniem kolizji (jest to ustawione za pomocą suwaka behaviour w interfejsie).

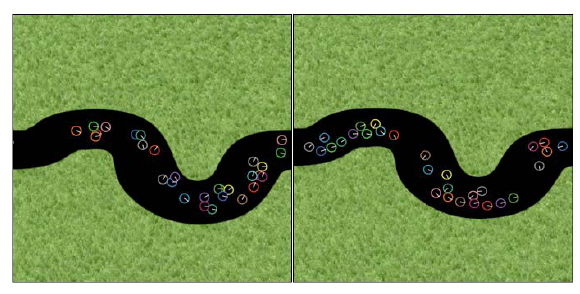

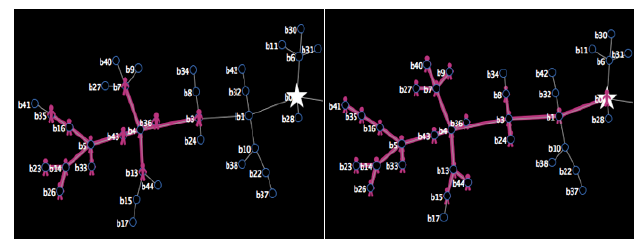

zawiera dwa zrzuty ekranu modelu dla dwóch różnych zachowań. Lewy obraz pokazuje "tłum" boidów zmierzających w dół w przybliżeniu w tym samym kierunku od lewej do prawej. Nastąpiło to po krótkiej chwili symulacji. Zauważ, że niektóre z agentów są bardzo blisko siebie - dzieje się tak, ponieważ nie ma unikania kolizji, w przeciwieństwie do drugiego pokazanego zachowania po prawej. Chociaż podstawowy kod dla tych zachowań jest podobny (dla kodu, odnośnik do odnośnika znajdujący się w dolnej części tego rozdziału) jest oparty na użyciu polecenia in-cone, tak jak w przypadku innych implementacji agentów boid, co jest widoczne, zachowanie wynikające z unikania przeszkód jest zauważalnie różne. Na przykład, więcej podgrup agentów próbuje teraz iść wbrew przepływowi, jak pokazano na prawym obrazie Wierne wdrożenie bojlerów Reynoldsa powinno uwzględniać pewną formę siły sterującej zaimplementowanej za pomocą aproksymacji masy punktowej, gdzie każdy boid ma masę i działa w stosunku do sił. Jednak te wdrożenia NetLogo pokazały, że przybliżenie podejścia Reynoldsa można osiągnąć stosunkowo łatwo, aw wielu przypadkach wynikowe zachowanie boidów jest zgodne z oczekiwaniami.

Podsumowanie

Sztuczna inteligencja oparta na zachowaniu (BBAI) przyjmuje behawioralne podejście do budowania inteligentnych systemów. To podejście rozkłada inteligencję na odrębne niezależne pół-autonomiczne moduły, które opisują różne zachowania. Zachowanie agenta to seria działań wykonywanych podczas interakcji ze środowiskiem. Określona kolejność lub sposób przeprowadzania ruchów i ogólny wynik, który pojawia się w wyniku działań, określają szczególny rodzaj zachowania. Różne perspektywy prowadzą do różnych wyjaśnień i różnych sposobów, w jakie rzeczy są tworzone. Ramy odniesienia dotyczą trudności w zrozumieniu zachowania różnych gatunków. Punkty widzenia różnią się nie tylko dla każdego agenta, lecz także dźwięk, odczucie, zapach i smak, z powodu odmiennej postaci wykonania czynnika obserwującego w porównaniu z obserwowanym czynnikiem. (Na przykład spróbuj wyobrazić sobie bycie mrówką.) Ważne jest, aby nie przypisywać błędnych wyjaśnień z obserwacji mechanizmom stojącym za zachowaniem ucieleśnionego czynnika znajdującego się w otoczeniu, a szczególnie ważne, aby uniknąć przypisywania skomplikowanych mechanizmów (np. "inteligencji") do zachowania obserwowanego agenta, gdy ma on inną ramę odniesienia, tj. inny przykład wykonania.

Podsumowanie ważnych pojęć, które należy wyciągnąć z tego rozdziału, znajduje się poniżej:

o Proste zasady mogą leżeć u podstaw złożonych systemów.

o Proste reakcje reaktywne mogą być przyczyną złożonych zjawisk.

o Zachowanie adaptacyjne to zachowanie, w którym agent zmienił swoje zachowanie w odpowiedzi na zmianę środowiska.

o Zmieniające się zachowanie to zachowanie, które powstało w wyniku ewolucji genetycznej (to znaczy wymaga więcej niż jednego pokolenia, w którym cechy genetyczne są przekazywane potomstwu).

o Zachowanie wschodzące to pewna właściwość, która wyłania się z interakcji agent-agent lub interakcji między agentem a środowiskiem, które nie mogły powstać bez tych interakcji i nie jest wynikiem prostej liniowej kombinacji tych interakcji.

o Zachowanie samoorganizujące się w systemie z wieloma agentami występuje, gdy agenci stosujący reguły lokalne tworzą pewien wzorzec lub strukturę jako wschodząca właściwość.

o Stygmatyka występuje wtedy, gdy agenci wykorzystują środowisko do komunikowania się i interakcji. Na przykład używają mrówki i pszczoły

środowiska, aby powiedzieć sobie, gdzie znaleźć źródła żywności. Ludzie używają go do budowania złożonych systemów informacyjnych i dzielenia się wiedzą, gdzie znaleźć źródła informacji.

o Inteligencja roju jest zbiorem agentów, które wykorzystują stigmergiczną lokalną wiedzę do samoorganizacji i koordynacji ich zachowania.

Komunikacja

Biorąc pod uwagę historię ludzkości, społeczność językowa jest bardzo naturalną jednostką. Języki, ze względu na swój charakter jako środek komunikacji, dzielą ludzkość na grupy; tylko przez wspólny język może grupa ludzi działać wspólnie, a zatem mają wspólną historię. Ponadto język, którym posługuje się grupa, jest właśnie medium, w którym można dzielić wspomnienia z ich wspólnej historii. języki umożliwiają zarówno życie wspólnej historii, jak i jej opowiadanie. - Nicholas Ostler,

Nowa metoda szacowania entropii wykorzystuje fakt, że każdy, kto mówi językiem, posiada, nieodwołalnie, ogromną znajomość statystyk tego języka. Znajomość słów, idiomów, stereotypów i gramatyki pozwala mu uzupełnić brakujące lub niepoprawne litery w korekcie lub zakończyć niedokończone wyrażenie w rozmowie. - C.E. Shannon

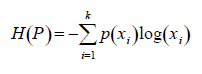

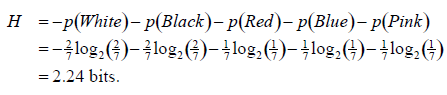

Komunikacja, informacja i język

Komunikacja może być zdefiniowana jako proces wymiany informacji między agentami. Agent wykazuje zachowanie komunikacyjne, gdy próbuje przekazać informacje innemu agentowi. Agent lub agenci wysyłają wiadomość za pośrednictwem medium do agenta lub agentów odbiorcy. Termin komunikacja w powszechnym użyciu w języku angielskim może również odnosić się do interakcji między ludźmi, które obejmują dzielenie się informacjami, pomysłami i uczuciami. Komunikacja nie jest jednak wyjątkowa dla ludzi, ponieważ zwierzęta, a nawet rośliny, również mają zdolność komunikowania się ze sobą. Język można zdefiniować jako zestaw symboli, z którymi agenci komunikują się w celu przekazywania informacji. W Sztucznej Inteligencji język ludzki jest często nazywany "językiem naturalnym" w celu odróżnienia go od języków programowania komputerowego. Komunikacja za pomocą języka jest często uważana za unikalną cechę behawioralną człowieka. Język ludzki, taki jak mówiony, pisany lub znak, odróżnia się od zwierzęcych systemów komunikacyjnych tym, że jest uczony, a nie dziedziczony biologicznie. Chociaż różne zwierzęta wykazują zdolność komunikowania się, a niektóre zwierzęta, takie jak orangutany i szympansy, mają nawet zdolność posługiwania się pewnymi cechami ludzkiego języka, to stopień zaawansowania i złożoności w ludzkim języku odróżnia go od systemów komunikacji zwierzęcej. Język ludzki opiera się na wyjątkowej zdolności ludzi do abstrakcyjnego myślenia za pomocą symboli do reprezentowania koncepcji i pomysłów. Język definiowany jest przez zestaw reguł wspólnie określających powszechnie akceptowane symbole, ich znaczenie oraz ich związki strukturalne określone przez zasady gramatyki. Reguły te opisują sposób manipulowania symbolami w celu utworzenia potencjalnie nieskończonej liczby gramatycznie poprawnych sekwencji symboli. Wybrane symbole są arbitralne i mogą być związane z dowolnym konkretnym fonemem, grafemem lub znakiem. Lingwistyka jest naukowym badaniem języka, które można podzielić na odrębne obszary nauki: gramatyka jest nauką o strukturze języka; morfologia jest nauką o tym, jak słowa są formowane i łączone; fonologia to nauka o systemach dźwięków; Składnia dotyczy reguł rządzących tym, jak słowa łączą frazy i zdania; semantyka to badanie znaczenia; i pragmatyka dotyczy nauki języka i użytkowania oraz kontekstów, w których jest używany.

Różnorodność ludzkiego języka

We wszystkich językach naturalnych istnieje duża różnorodność zastosowań, a także często brak porozumienia między użytkownikami języka. Na przykład tabela zawiera przykłady dopuszczalnych zdań "angielskich" z różnych regionów świata. Każde z tych zdań jest uważane za "normalny" angielski dla regionu pokazanego po prawej stronie, a jednak większość ludzi spoza tych regionów argumentowałaby inaczej, a wiele spraw ma trudności w zrozumieniu ich znaczenia.

Let's buy some food home! : Singapur

Don't smoke without causing an explosion! : Południowa Walia