II.Wskazówki

Wskazówki dotyczące tego, co może być potrzebne, aby maszyny były inteligentne, są rozproszone obficie w filozofii, logice, biologii, psychologii, statystyce i inżynierii. Wraz ze wzrostem intensywności, ludzie zaczęli wykorzystywać wskazówki z tych obszarów w swoich oddzielnych zadaniach, aby zautomatyzować niektóre aspekty inteligencji. Zaczynam swoją historię od opisania niektórych z tych wskazówek i tego, w jaki sposób zainspirowali niektóre z pierwszych osiągnięć w sztucznej inteligencji.

Od filozofii i logiki

Chociaż ludzie rozumowali logicznie przez tysiąclecia, był Grek ,filozof Arystoteles, który najpierw próbował przeanalizować i skodyfikować ten proces.

Arystoteles zidentyfikował rodzaj rozumowania, które nazwał sylogizmem. . . w którym pewne rzeczy są określone, coś innego niż to, co wynika z konieczności z ich istnienia. "Oto słynny przykład jednego rodzaju sylogizmu:

1. Wszyscy ludzie są śmiertelni. (podano)

2. Wszyscy Grecy są ludźmi. (podano)

3. Wszyscy Grecy są śmiertelni. (wynik)

Piękno (i znaczenie AI) wkładu Arystotelesa ma związek z formą sylogizmu. Nie jesteśmy ograniczeni do mówienia o ludziach, Grekach czy śmiertelności. Równie dobrze moglibyśmy mówić o czymś innym {wynik, który stał się oczywisty, jeśli przepiszemy sylogizm za pomocą dowolnych symboli zamiast ludzi, Greków i śmiertelników. Przepisanie w ten sposób przyniesie.

1. Wszystkie B są A. (podane)

2. Wszystkie litery C są literami B. (podano)

3. Wszystkie litery C to A. (wynik)

Można zastąpić wszystko, co się lubi, A, B i C. Na przykład wszyscy sportowcy są zdrowi, a wszyscy piłkarze są sportowcami, dlatego wszyscy piłkarze są zdrowi i tak dalej. (Oczywiście, wynik "niekoniecznie będzie prawdą, chyba że rzeczy określone" są. Śmieci w śmieciach!) Logika Arystotelesa dostarcza dwóch wskazówek, jak można zautomatyzować rozumowanie. Po pierwsze, wzorce rozumowania, takie jak sylogizmy, można ekonomicznie przedstawić jako formy lub szablony. Wykorzystują one ogólne symbole, które mogą oznaczać wiele różnych konkretnych przypadków. Ponieważ są w stanie cokolwiek reprezentować, same symbole są nieistotne. Po drugie, po zastąpieniu ogólnych symboli tymi, które dotyczą konkretnego problemu, wystarczy tylko przekręcić korbę, aby uzyskać odpowiedź. Użycie ogólnych symboli i podobnych rodzajów toczenia korbowego jest sercem wszystkich nowoczesnych programów rozumowania sztucznej inteligencji W dzisiejszych czasach Gottfried Wilhelm Leibniz (1646 {1716) był jednym z pierwszych, którzy myśleli o logicznym rozumowaniu. Leibniz był niemieckim filozofem, matematykiem i logikiem, który między innymi współtworzył rachunek różniczkowy. (Miał przy tym wiele sporów z Izaakiem Newtonem). Ale co ważniejsze dla naszej historii, chciał zmechanizować rozumowanie. Leibniz wymyślił i próbował zaprojektować język, w którym cała ludzka wiedza mogłaby być sformułowana (nawet wiedza filozoficzna i metafizyczna. Spekulował, że twierdzenia składające się na wiedzę można budować z mniejszej liczby prymitywnych {tak jak wszystkie słowa można budować z liter w języku alfabetycznym. Jego lingua characteristica lub uniwersalny język składałby się z tych prymitywnych propozycji, które zawierałyby alfabet ludzkich myśli. Alfabet posłużyłby za podstawę automatycznego rozumowania. Jego pomysł polegał na tym, że jeśli elementy w alfabecie były reprezentowane przez liczby, to złożoną propozycję można by uzyskać z jej prymitywnych składników, mnożąc odpowiednie liczby razem. Dalsze operacje arytmetyczne mogą być następnie użyte do ustalenia, czy złożone twierdzenie było prawdziwe czy fałszywe. Cały ten proces miał być dokonany przez ratiocinator rachunku różniczkowego (rachunek rozumowania). Wtedy, gdy filozofowie nie zgodzili się na jakiś problem, mogliby powiedzieć, rachunek różniczkowy ("obliczmy"). Najpierw postawiliby problem w lingua characteristica, a następnie rozwiązali go przez przekręcenie korby na ratiocinator rachunku różniczkowego. Głównym problemem przy stosowaniu tego pomysłu było odkrycie elementów alfabetu pierwotnego. Jednak praca Leibniza dostarczyła ważnych dodatkowych wskazówek, w jaki sposób można zmechanizować rozumowanie: wymyśl alfabet prostych symboli i sposoby łączenia ich w bardziej złożone wyrażenia.

Pod koniec XVIII wieku i na początku XIX wieku brytyjski naukowiec i polityk Charles Stanhope (trzeci hrabia Stanhope) zbudował i eksperymentował z urządzeniami do rozwiązywania prostych problemów logiki i prawdopodobieństwa. Jedna wersja jego pudełka "miała gniazda po bokach, do których osoba mogłaby wcisnąć kolorowe slajdy. Z okna na górze można było zobaczyć slajdy, które były odpowiednio ustawione, aby reprezentować specyficzny problem. Dzisiaj powiedzielibyśmy, że Stanhope's box był rodzajem komputera analogowego, a książka Computing Before Computers podaje przykład jego działania:

Aby rozwiązać sylogizm numeryczny, na przykład:

Osiem z dziesięciu A to B; Cztery z dziesięciu A to C;

Dlatego przynajmniej dwie litery B to litery C.

Stanhope popchnąłby czerwony slajd (oznaczający B) osiem jednostek w poprzek okna (reprezentujących A), a szary slajd (reprezentujący C) cztery jednostki z przeciwnego kierunku. Dwie jednostki, które nakładały się na slajdy, reprezentowały minimalną liczbę B, które były również literami C.

…

W podobny sposób Demonstrator mógłby zostać użyty do rozwiązania tradycyjnego sylogizmu, takiego jak:

Nie M to A; Wszystko B to M; Dlatego też, B nie jest A.

Stanhope był skryty w stosunku do swojego urządzenia i nie chciał, żeby ktokolwiek wiedział, co zamierza zrobić. Jak wspomniano w Computing Before Computers, "niewielu przyjaciołom i krewnym, którzy otrzymali jego prywatne konto Demonstratora, The Science of Reasoning wyraźnie wyjaśnione na nowych zasadach (1800), poradzono, aby milczeli, aby" jakiś bękart "nie poprzedzał zamierzonego publikacja na ten temat. "

Ale publikacja pojawiła się dopiero sześćdziesiąt lat po śmierci Stanhope'a. Następnie wielebny Robert Harley uzyskał dostęp do notatek Stanhope'a i jednego ze swoich pudeł i opublikował artykuł o tym, co nazwał "The Stanhope Demonstrator". W przeciwieństwie do schematów Llulla i nadziei Leibniza, Stanhope zbudował pierwszą maszynę logiczną, która rzeczywiście działała, choć na małe problemy. Być może jego praca wzbudziła przekonanie, że logiczne rozumowanie może być rzeczywiście zmechanizowane. W 1854 r. Anglik George Boole (1815-1864) opublikował książkę pod tytułem Badanie praw myśli, na których opierają się matematyczne teorie logiki i prawdopodobieństw. Celem Boole było (między innymi) zbieranie. . . kilka prawdopodobnych wskazówek dotyczących natury i konstytucji ludzkiego umysłu. "Boole rozważał różne logiczne zasady ludzkiego rozumowania i przedstawiał je w formie matematycznej. Na przykład jego" Propozycja IV "stany". . . zasada sprzeczności. . . potwierdza, że żadna istota nie jest w stanie

posiadać jakości, a jednocześnie nie posiadać jej. . . "Boole napisał tę zasadę jako równanie algebraiczne,

x (1-x) = 0;

w którym x reprezentuje "dowolną klasę obiektów" (1-x) reprezentuje "przeciwną lub uzupełniającą klasę obiektów", a 0 oznacza klasę, która "nie istnieje". W algebrze Boole'a, będącej wynikiem pracy Boole'a, powiedzielibyśmy, że 0 reprezentuje fałsz, a 1 oznacza prawdę. Dwie podstawowe operacje w logice, mianowicie OR i AND, są reprezentowane w algebrze Boole'a odpowiednio przez operacje + i -. Zatem, na przykład, aby reprezentować wyrażenie "albo p, albo q, albo oba", piszemy p + q. Aby przedstawić wyrażenie "p i q", napisalibyśmy p x q. Każdy z p i q może być prawdziwy lub fałszywy, więc ocenilibyśmy wartość (prawda lub fałsz) p + q i p x q przez używanie definicji, w jaki sposób używane są + i x, a mianowicie,

1 + 0 = 1;

1 x 0 = 0;

1 + 1 = 1;

1 x 1 = 1;

0 + 0 = 0;

i

0 x 0 = 0:

Algebra Boole′a odgrywa ważną rolę w projektowaniu obwodów przełączania telefonicznego i komputerów. Chociaż Boole prawdopodobnie nie mógł sobie wyobrazić komputerów, zdał sobie sprawę ze znaczenia swojej pracy. W liście z 2 stycznia 1851 roku do George'a Thomsona (późniejszego Lorda Kelvina) napisał:

"Teraz zamierzam poważnie pracować nad przygotowaniem dla prasy relacji z mojej teorii logiki i prawdopodobieństw, które w obecnym stanie uważam za najcenniejszy, jeśli nie jedyny cenny wkład, jaki złożyłem lub prawdopodobnie uczynię naukę i to, czego pragnęłbym w przyszłości zapamiętać ... " Praca Boole'a wykazała, że niektóre rodzaje logicznego rozumowania mogą być wykonywane przez manipulowanie równaniami reprezentującymi logiczne propozycje - bardzo ważną wskazówkę dotyczącą mechanizacji rozumowania. Zasadniczo równoważny, ale nie algebraiczny, system manipulowania i oceny twierdzeń nazywany jest "rachunkiem propozycyjnym" (często nazywanym "logiką zdaniową"), który, jak zobaczymy, odgrywa bardzo ważną rolę w sztucznej inteligencji. [Niektórzy twierdzą, że grecki filozof stoicki Chrysippus (280-209 pne) wynalazł wczesną formę rachunku zdań.]. Jedną z wad logicznego systemu Boole'a było to, że jego zdania p, q itd. były "atomowe".

Nie ujawniają żadnych wewnętrznych elementów propozycji. Na przykład, jeśli wyraziliśmy propozycję "Jack jest człowiekiem" przez p, a "Jack jest śmiertelny" przez q, nic w p lub q nie wskazuje, że Jack, który jest człowiekiem, jest tym samym Jackiem, który jest śmiertelny. W tym celu potrzebujemy, by tak rzec, "wyrażeń molekularnych", które mają wewnętrzne elementy. Pod koniec XIX wieku niemiecki

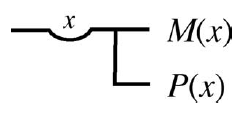

matematyk, logik i filozof Friedrich Ludwig Gottlob Frege (1848-1925) wynalazł system, w którym propozycje, wraz z ich wewnętrznymi komponentami, można zapisać w formie graficznej. Nazwał swój język Begriffsschrift, co można przetłumaczyć jako "pisanie pojęć". Na przykład stwierdzenie "Wszystkie osoby są śmiertelne" zostałyby napisane w Begriffsschrift w podobny sposób

Zauważ, że ilustracja wyraźnie reprezentuje x, który jest predysponowany do bycia osobą i to jest ten sam x, który jest następnie uważany za śmiertelnika. Obecnie wygodniej jest reprezentować to stwierdzenie w formie liniowej  którego odpowiednikiem jest ,że dla wszystkich x, jeśli x jest osobą, wtedy x jest śmiertelny. "System Frege'a był prekursorem tego, co nazywamy teraz "rachunkiem predykatów ", innym ważnym systemem sztucznej inteligencji, a także zapowiada inny reprezentacyjny forma wykorzystywana we współczesnej inteligencji artystycznej: sieci semantyczne Praca Frege dostarczyła jeszcze więcej wskazówek na temat mechanizacji procesów wnioskowania, wreszcie zdania wyrażające informacje, które należy rozumować, można napisać w jednoznacznej, symbolicznej formie.

którego odpowiednikiem jest ,że dla wszystkich x, jeśli x jest osobą, wtedy x jest śmiertelny. "System Frege'a był prekursorem tego, co nazywamy teraz "rachunkiem predykatów ", innym ważnym systemem sztucznej inteligencji, a także zapowiada inny reprezentacyjny forma wykorzystywana we współczesnej inteligencji artystycznej: sieci semantyczne Praca Frege dostarczyła jeszcze więcej wskazówek na temat mechanizacji procesów wnioskowania, wreszcie zdania wyrażające informacje, które należy rozumować, można napisać w jednoznacznej, symbolicznej formie.

Od samego życia

W Księdze Przysłów 6: 6-8 Król Salomon mówi: "Idź do mrówki, leniwcze; przyjrzyj się jej drogom i stań się mądry". Chociaż jego rada miała ostrzegać przed lenistwem, może równie dobrze nakazać nam, byśmy poszukali wskazówek z biologii, jak budować lub ulepszać artefakty. Kilka aspektów "życia" w rzeczywistości dostarczyło ważnych wskazówek dotyczących inteligencji. Ponieważ to mózg zwierzęcia jest odpowiedzialny za przekształcanie informacji zmysłowych w działanie, należy oczekiwać, że kilka dobrych pomysłów można znaleźć w pracy neurofizjologów i neuroanatomów, którzy badają mózgi i ich podstawowe składniki, neurony. Inne pomysły są dostarczane przez pracę psychologów, którzy badają (na różne sposoby) inteligentne zachowanie w rzeczywistości. A ponieważ przecież to procesy ewolucyjne stworzyły inteligentne życie, procesy te również dostarczają ważnych wskazówek, jak postępować.

Neurony i mózg

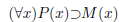

Pod koniec XIX i na początku XX wieku "doktryna neuronowa" wskazywała, że żywe komórki zwane "neuronami" wraz z ich połączeniami są fundamentalne dla tego, co robi mózg. Jedną z osób odpowiedzialnych za tę sugestię był hiszpański neuroanatomist Santiago Ramon y Cajal (1852-1934). Cajal i Camillo Golgi otrzymali Nagrodę Nobla w dziedzinie fizjologii lub medycyny w 1906 r. Za pracę nad strukturą układu nerwowego. Neuron jest żywą komórką, a ludzki mózg ma około dziesięciu miliardów (1010) z nich. Chociaż występują w różnych formach, zazwyczaj składają się z centralnej części zwaneja soma lub ciałem komórki, przychodzącymi włóknami zwane dendrytami i jeden lub więcej odchodzących zwanych aksonami. Akson jednego neuronu ma projekcje zwane przyciskami końcowymi, które są bardzo zbliżone do jednego lub więcej dendrytów innych neuronów. Przerwa między końcowym przyciskiem jednego neuronu a dendrytem innego nazywa się synapsą. Wielkość szczeliny wynosi około 20 nanometrów. Dwa neurony są zilustrowane schematycznie tu

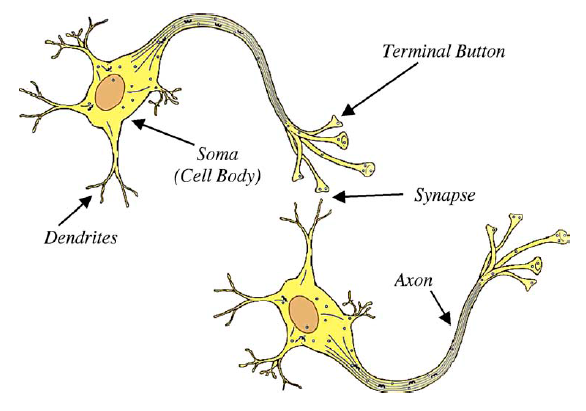

Poprzez działanie elektrochemiczne neuron może wysyłać strumień impulsów w dół jego aksonu. Gdy impuls dociera do synapsy sąsiadującej z dendrytem innego neuronu, może działać pobudzająco lub hamować aktywność elektrochemiczną drugiego neuronu w całej synapsie. To, czy ten drugi neuron następnie "res" i wyśle własne impulsy, zależy od tego, ile i jakiego rodzaju pulsów (pobudzających lub hamujących) dociera do synaps różnych przybywających dendrytów i od wydajności tych synaps w przekazywaniu elektrochemicznym czynność. Szacuje się, że w ludzkim mózgu znajduje się ponad pół biliona bilionów synaps. Doktryna neuronowa twierdzi, że różne czynności mózgu, w tym percepcja i myślenie, są wynikiem całej tej aktywności neuronowej. W 1943 r. Amerykański neurofizjolog Warren McCulloch (1899-1969) i logik Walter Pitts (1923-1969) twierdzili, że neuron był w istocie "jednostką logiczną". W słynnym i ważnym artykule zaproponowali proste modele neuronów i wykazali, że sieci tych modeli mogą wykonywać wszystkie możliwe operacje obliczeniowe. "Neuron" McCulloch-Pittsa był matematyczną abstrakcją z wejściami i wyjściami (odpowiada, dendrytom i aksonom, odpowiednio). Każde wyjście może mieć wartość 1 lub 0. (Aby uniknąć mylenia neuronu McCullocha-Pittsa z prawdziwym neuronem, nazywam wersją McCullocha-Pittsa i inne podobne, "element neuronowy".) Elementy neuronowe mogą być połączone razem intonetworks tak, że wyjście jednego elementu neuronowego jest wejściem dla innych i tak dalej. Niektóre elementy neuronowe są pobudzające (ich wyjścia przyczyniają się do "pierścienia" wszelkich elementów neuronowych, z którymi są połączone). Inne są hamujące (ich produkty przyczyniają się do hamowania pierścienia elementów nerwowych, z którymi są połączone). Jeśli suma wejść pobudzających pomniejszona o sumę wejść hamujących uderzających w element neuronowy jest większa niż pewien "próg", to ten element neuronowy res, wysyłając swoje wyjście 1 do wszystkich elementów neuronowych, z którymi jest połączony. Niektóre przykłady sieci zaproponowane przez McCullougha i Pittsa pokazano tu

Kanadyjski neuropsycholog Donald O. Hebb (1904-1985) również uważał, że neurony w mózgu są podstawowymi jednostkami myślenia. Książka Hebba sugeruje, że gdy akson komórki A jest wystarczająco blisko, aby wzbudzić B i wielokrotnie lub uporczywie bierze udział w tym pierścieniu, w jednym lub obu komórkach zachodzi pewien proces wzrostu lub przemiana metaboliczna, tak że wydajność A, jak jeden z komórek pierścienia B, jest zwiększona. "Później, ta tak zwana reguła Hebba zmiany neuronalnej "siły synaptycznej"została faktycznie zaobserwowana w eksperymentach z żywymi zwierzętami (w 1965 r. neurofizjolog Eric Kandel opublikował wyniki pokazujące, że to proste formy uczenia się były związane ze zmianami synaptycznymi w mięczaku morskim Aplysia californica .W 2000 r. Kandel odebrał Nagrodę Nobla w dziedzinie fizjologii lub medycyny "za odkrycia dotyczące transdukcji sygnału w układzie nerwowym"). Hebb postulował również, że grupy neuronów, które mają tendencję aby ponownie utworzyć to, co nazwał zespołami komórkowymi, Hebb pomyślał, że zjawisko "pierścienia razem" ma tendencję do utrzymywania się w mózgu i jest mózgowym sposobem reprezentowania nawet percepcyjnego t, które doprowadziły do powstania komórki. Hebb powiedział, że "myślenie" było sekwencyjną aktywacją zestawów zespołów komórkowych

Psychologia i kognitywistyka

Psychologia to nauka badająca procesy i zachowania psychiczne. Słowo wywodzi się od greckich słów psyche, oznaczających oddech, ducha lub duszę, i logos, oznaczających słowo. Można by się spodziewać, że taka nauka powinna mieć wiele do powiedzenia, co byłoby interesujące dla tych, którzy chcą tworzyć inteligentne artefakty. Jednak do końca dziewiętnastego wieku większość psychologicznego teoretyzowania zależała od spostrzeżeń filozofów, pisarzy i innych bystrych obserwatorów ludzkiej sceny. (Szekspir, Tołstoj i inni autorzy nie mieli nic do powiedzenia, jeśli chodzi o zrozumienie ludzkich zachowań.) Większość ludzi uważa poważne badania naukowe za rozpoczęte od niemieckiego Wilhelma Wundta (1832 {1920) i Amerykanina Williama Jamesa (1842-1910) . Obaj

założyli laboratoria psychologiczne w 1875 roku -Wundt w Lipsku i James na Harvardzie. Według C. George'a Boeree, który uczy historii psychologii na Uniwersytecie Shippensburg w Pensylwanii, "Metoda opracowana przez Wundta jest rodzajem eksperymentalnej introspekcji: badacz miał dokładnie obserwować jakieś proste zdarzenie - takie, które można zmierzyć pod względem jakości , intensywność lub czas trwania - i nagraj jego odpowiedzi na wariacje tych wydarzeń. " Chociaż James jest obecnie uważany głównie za filozofa, jest znany ze swojej dwutomowej książki The Principles of Psychology, opublikowanej w latach 1873 i 1874. Zarówno Wundt, jak i James próbowali powiedzieć coś o tym, jak mózg pracował, zamiast jedynie katalogować jego wkład w zachowanie wyjściowe. Psychiatra Zygmunt Freud (1856-1939) poszedł dalej, postulując wewnętrzne elementy mózgu, a mianowicie id, ego i superego oraz sposób, w jaki oddziaływały, aby wpływać na zachowanie. Myślał, że można dowiedzieć się o tych składnikach poprzez swój unikalny styl kierowanej introspekcji zwanej psychoanalizą. Próbując uczynić psychologię bardziej naukową i mniej zależną od subiektywnej introspekcji, wielu psychologów, najbardziej znanego BF Skinnera (1904-1990), zaczęło koncentrować się wyłącznie na tym, co można obiektywnie zmierzyć, mianowicie na specyficznym zachowaniu w reakcji na specyficzne bodźce. Behawioryści twierdzili, że psychologia powinna być nauką o zachowaniu, a nie o umyśle. Odrzucili ideę próby identyfikacji wewnętrznych stanów mentalnych, takich jak przekonania, intencje, pragnienia i cele. Ten rozwój może być początkowo uważany za krok wstecz dla ludzi chcąc uzyskać przydatne wskazówki na temat wewnętrznego funkcjonowania mózgu. Krytykując statystycznie zorientowane teorie wynikające z "behawioryzmu", napisał Marvin Minsky, "pierwotnie miał na celu uniknięcie potrzeby" znaczenia ", [te teorie] radzą sobie nade wszystko, aby uniknąć możliwości jego wyjaśnienia". Prace Skinnera dały jednak wyobrażenie o bodźcu wzmacniającym - takim, który nagradza ostatnie zachowania i ma tendencję do zwiększania prawdopodobieństwa wystąpienia (w podobnych okolicznościach) w przyszłości. Uczenie się o wzmocnieniu stało się popularną strategią wśród badaczy AI, choć zależy to od stanów wewnętrznych. Russell Kirsch (ok. 1930-), informatyk z amerykańskiego Krajowego Biura Norm (obecnie National Institute for Standards and Technology, NIST), był jednym z pierwszych, którzy go użyli. Zaproponował, w jaki sposób "sztuczne zwierzę" może użyć wzmocnienia, aby nauczyć się dobrych ruchów w grze. W niektórych notatkach z seminarium z 1954 r. Napisał: "Model zwierzęcy zauważa, dla każdego bodźca, co porusza przeciwnika w następnej kolejności,

Następnie, następnym razem, gdy ten sam bodziec się pojawi, zwierzę powiela ruch przeciwnika, który nastąpił ten sam bodziec poprzednio. Im bardziej przeciwnik powtarza ten sam ruch po danym bodźcu, tym bardziej model zwierzęcy staje się "uwarunkowany" do tego ruchu. "Skinner wierzył, że uczenie się wzmacniania może być nawet używane do wyjaśnienia zachowania werbalnego u ludzi. 1957 książka Verbal Behavior, 16 twierdząc, że laboratoryjne zasady selekcji przez konsekwencje można rozszerzyć, aby uwzględnić to, co ludzie mówią, piszą, gestują i myślą.

Chomsky , w recenzji książki Skinnera, napisał to

"… uważne przestudiowanie tej książki (i badań, na których się opiera) ujawnia jednak, że zdumiewające twierdzenia [Skinnera] są dalekie od uzasadnienia. . . . spostrzeżenia, które zostały osiągnięte w laboratoriach teoretyka wzmacniania, choć całkiem autentyczne, mogą być zastosowane do złożonych zachowań ludzkich tylko w najbardziej rażący i nadzwyczajny sposób, a spekulatywne próby omawiania zachowań językowych w tych kategoriach same pomijają rozważania czynniki o fundamentalnym znaczeniu…"

Jak, jak się wydaje, pyta Chomsky, czy dana osoba może wytwarzać potencjalnie nieskończoną różnorodność wcześniej niespotykanych i niewypowiedzianych zdań o arbitralnie złożonej strukturze (jak rzeczywiście może to zrobić) dzięki samemu doświadczeniu? Te "czynniki o fundamentalnym znaczeniu", które Skinner pomija, są według Chomsky'ego zdolnościami językowymi, które muszą być

wrodzone. Zasugerował, że "ludzie są w jakiś sposób specjalnie stworzeni, aby to zrobić, z obsługą danych lub" formułowaniem-hipotezą "zdolności o nieznanym jeszcze charakterze i złożoności. Chomsky twierdził, że wszyscy ludzie narodzili "uniwersalną gramatykę" (lub mechanizmy rozwojowe do jej tworzenia), która odpowiada za znaczną część ich umiejętności uczenia się i używania języków.

Kontynuując koncentrację na wewnętrznych procesach umysłowych i ich ograniczeniach, psycholog George A. Miller (1920 -) przeanalizował pracę kilku eksperymentatorów i doszedł do wniosku, że pojemność pamięci "ludzi" wynosi w przybliżeniu siedem części informacji. We wstępie do jego artykułu o tej magicznej liczbie - zauważa Miller z humorem - moim problemem jest to, że byłem prześladowany przez liczbę całkowitą. Przez siedem lat liczba ta podążała za mną, wtargnęła w moje najbardziej prywatne dane i zaatakowała ja ze stron naszych najbardziej publicznych czasopism. Ten numer zakłada różne przebrania, czasami trochę większe i czasami trochę mniejsze niż zwykle, ale nigdy nie zmieniające się tak bardzo, że są nierozpoznawalne. o wiele więcej niż przypadkowy wypadek. Co ważne, twierdził również, że "rozpiętość pamięci bezpośredniej wydaje się być niemal niezależna od liczby bitów na porcję". Oznacza to, że nie ma znaczenia, co reprezentuje fragment, czy to pojedyncza cyfra w numerze telefonu, nazwisko osoby wymienionej właśnie, czy tytuł piosenki; możemy najwyraźniej posiadać tylko siedem z nich (plus lub minus dwa) w naszej bezpośredniej pamięci. Artykuł Millera na temat "Magicznej liczby siódmej" został wydany na Sympozjum Teorii Informacji, które odbyło się w dniach 10-12 września 1956 r. Na MIT.20. Chomsky przedstawił tam również ważny dokument. Był on zatytułowany "Trzy modele opisu języka", a w nim zaproponował rodzinę reguł składni, które nazwał gramatycznymi strukturami frazowymi. Zdarza się, że dwóch pionierów w badaniach nad sztuczną inteligencją (o których dużo więcej usłyszymy później), Allen Newell (1927-1992), wówczas naukowiec w Rand Corporation i Herbert Simon (1916-2001), profesor w Carnegie Institute of Technology (obecnie Carnegie Mellon University), wydał tam również referat na temat program komputerowy, który mógłby udowodnić twierdzenia w logice zdaniowej. Uważa się, że to sympozjum, które zgromadziło naukowców z tego rodzaju nakładającymi się interesami, przyczyniło się do narodzin kognitywistyki, nowej dyscypliny poświęconej badaniu umysłu. Rzeczywiście, napisał George Miller:

"Odszedłem od Sympozjum z silnym przekonaniem, więcej intuicyjny niż racjonalny, że ludzka psychologia eksperymentalna ,lingwistyka teoretyczna i symulacja komputerowa funkcji poznawczych wszystkie procesy były kawałkami większej całości i przyszłością dostrzegłby postępujące opracowanie i koordynację ich wspólnych obawy"

W 1960 roku Miller i jego współpracownicy napisali książkę proponującą specyficzny wewnętrzny mechanizm odpowiedzialny za zachowanie, które nazwali jednostką TOTE (Test-Operat-{Test-Exit) . Istnieje jednostka TOTE odpowiadająca każdemu celowi, który może mieć agent . Używając swoich zdolności percepcyjnych, jednostka najpierw testuje, czy jej cel jest zadowalający. Jeśli tak, jednostka odpoczywa (wychodzi). Jeśli nie, wykonywana jest pewna operacja specyficzna dla osiągnięcia tego celu, a test osiągania celu jest przeprowadzany ponownie, i tak dalej, powtarzalnie, aż do osiągnięcia celu. Jako prosty przykład, rozważ urządzenie TOTE do prowadzenia gwoździa młotkiem. Dopóki gwóźdź nie zostanie całkowicie wbity (cel), młotek jest używany do uderzenia w niego (operacja). Walenie zatrzymuje się (wyjście), gdy cel zostanie osiągnięty. Trudno powiedzieć, czy ta książka zainspirowała podobne prace naukowców zajmujących się sztuczną inteligencją. Pomysł był najwyraźniej "w powietrzu", ponieważ mniej więcej w tym

samym czasie, jak zobaczymy później, niektóre wczesne prace nad sztuczną inteligencją wykorzystywały bardzo podobne pomysły. [Mogę powiedzieć, że moja praca w SRI z programami zachowań (średniozaawansowanych) dla robota,

Shakey′a i moją późniejszą pracą nad programami nazywanymi przeze mnie "reaktywnymi" była pod wpływem pomysłów Millera.]

Nauki kognitywne próbowały wyjaśnić wewnętrzne procesy umysłowe, wykorzystując takie pomysły, jak cele, pamięć, kolejki zadań i strategie bez (przynajmniej w początkowych latach) koniecznie próbowania ugruntować te procesy w neurofizjologii. Nauki kognitywne i sztuczna inteligencja są ściśle powiązane od początku. Nauki kognitywne dostarczyły wskazówek badaczom sztucznej inteligencji, a sztuczna inteligencja pomogła nauce kognitywnej dzięki nowo opracowanym koncepcjom przydatnym do zrozumienia funkcjonowania umysłu.

Ewolucja

Że żywe istoty ewoluują, dają nam jeszcze dwie wskazówki, jak zbudować inteligentne artefakty. Po pierwsze, i najbardziej ambitnie, procesy ewolucji, a mianowicie losowe generowanie i selektywne przeżycie, mogą być symulowane na komputerach w celu stworzenia maszyn, o których marzymy. Po drugie, te ścieżki, które ewoluowały w produkcji coraz bardziej inteligentnych zwierząt, można wykorzystać jako wskazówki do tworzenia coraz bardziej inteligentnych artefaktów. Zacznij od symulowania zwierząt za pomocą prostych tropizmów i podążaj tymi ścieżkami do symulowania bardziej złożonych. Obie te strategie zostały pogłębione z radością przez badaczy AI, jak zobaczymy wkrótce. Tutaj wystarczy wymienić tylko kilka początkowych wysiłków. Wczesne próby symulacji ewolucji na komputerze zostały podjęte w Princeton's Institute for Advanced Study przez wirusowego genetyka Nilsa Aall Barricelliego (1912 {1993). Jego artykuł z 1954 roku opisywał eksperymenty, w których liczby migrowały i odtwarzały się w siatce. Motywowani sukcesem ewolucji biologicznej w wytwarzaniu złożonych organizmów, niektórzy badacze zaczęli zastanawiać się, w jaki sposób programy mogłyby ewoluować, a nie być pisane. R. N. Friedberg i jego koledzy z IBM przeprowadzili eksperymenty, w których, poczynając od populacji losowych programów komputerowych, próbowali rozwijać te, które były bardziej skuteczne w wykonywaniu prostego zadania logicznego. W podsumowaniu swojej pracy z 1958 r. Friedberg napisał, że "maszyny byłyby bardziej przydatne, gdyby mogły nauczyć się wykonywać zadania, dla których nie otrzymały precyzyjnych metod ... Proponuje się, aby program programu przechowywanego komputer jest stopniowo ulepszany przez procedurę uczenia się, która próbuje wielu programów i wybiera, z instrukcji, które mogą zajmować daną lokalizację, tę najczęściej kojarzoną z udanym wynikiem." Oznacza to, że Friedberg zainstalował instrukcje z "udanych" programów w programach następnej "generacji", podobnie jak geny jednostek, którym udało się uzyskać potomstwo, są zainstalowane u tych potomków. Niestety próby Friedberga dotyczące rozwoju programów nie były zbyt udane. Jak zauważył Marvin Minsky.

"Maszyna [opisana w pierwszej pracy] nauczyła się rozwiązywać niektóre niezwykle proste problemy. Ale trwało to 1000 razy dłużej niż spodziewał się czysty przypadek. . . .

Drugi artykuł omawia kolejność modyfikacji. . . Dzięki temu i przy pewnym "zalewaniu" (uruchamianie maszyny na właściwym torze za pomocą kilku użytecznych instrukcji) system stał się tylko trochę gorszy niż przypadek."

Minsky przypisuje słabe działanie metod Friedberga faktowi, że każda potomna maszyna bardzo różniła się od swojej rodzicielskiej, podczas gdy każda pomocna poprawa wymagałaby znacznie większego kroku w "przestrzeni" możliwych maszyn. Inne wczesne prace nad ewolucją artystyczną były bardziej udane. Lawrence Fogel (1928-2007) i jego koledzy byli w stanie rozwijać maszyny, które mogą przewidywać następny element w sekwencji. Woodrow W. Bledsoe (1921-1995) w Panoramic Research i Hans J. Bremermann (1926-1969) na Uniwersytecie Kalifornijskim w Berkeley wykorzystali symulowaną ewolucję odpowiednio do rozwiązywania optymalizacji i problemów matematycznych. A Ingo Rechenberg (według jednego z badaczy sztucznej inteligencji) zapoczątkował metodę sztucznej ewolucji w celu rozwiązania złożonych zadań optymalizacyjnych, takich jak projektowanie optymalnych skrzydeł samolotu lub komór spalania dysz rakietowych.

Pierwszym znaczącym dziełem zainspirowanym ewolucją biologiczną był rozwój "algorytmów genetycznych" Johna Hollanda na początku lat sześćdziesiątych. Holland (1929), profesor na Uniwersytecie Michigan, używał ciągów symboli binarnych (0 i 1), które nazwał "chromosomami" analogicznie do materiału genetycznego organizmów biologicznych. (Holland mówi, że najpierw wpadł na pomysł, przeglądając otwarte stosy biblioteki matematycznej Michigan we wczesnych latach 50.). Kodowanie 0 i 1 w chromosomie można interpretować jako rozwiązanie pewnego problemu. Chodziło o to, aby ewoluować chromosomy, które byłyby lepsze i lepsze w rozwiązywaniu problemu. Populacje chromosomów poddano procesowi ewolucyjnemu, w którym poszczególne chromosomy uległy mutacjom "(zmiana składnika 1 na 0 i odwrotnie), a pary najbardziej udanych chromosomów na każdym etapie ewolucji połączono, tworząc nowy chromosom. Ostatecznie proces wytworzyłby populację zawierającą chromosom (lub chromosomy), które rozwiązały problem. Naukowcy ostatecznie zdadzą sobie sprawę, że wszystkie te ewolucyjne metody były opracowaniem bardzo przydatnej matematycznej strategii wyszukiwania zwanej gradientem wznoszenia lub wspinania się po górach. W tych metodach poszukuje się lokalnego maksimum niektórych funkcji, wykonując najostrzejsze możliwe kroki pod górę. (Szukając lokalnego minimum, analogiczną metodę nazywa się "gradientem zniżania".) Zamiast próbować powielać samą ewolucję, niektórzy badacze woleli budować maszyny, które podążały ścieżkami ewolucji w kierunku inteligentnego życia. Pod koniec lat 40. i na początku 50. W. Grey Walter (1910 - 1977) brytyjski neurofizjolog (urodzony w Kansas City, Missouri) zbudował kilka maszyn, które zachowywały się jak niektóre z najbardziej prymitywnych stworzeń życia. Były to pojazdy kołowe, którym nadał nazwę taksonomiczną Machina speculatrix. Te maszyny podobne do żółwi były kontrolowane przez "mózgi" składające się z bardzo prostych obwodów lamp próżniowych, które wykrywały ich otoczenie za pomocą fotokomórek i które sterowały silnikami kół. Obwody mogą być rozmieszczone w taki sposób, że maszyna albo porusza się w kierunku światła od maszyny siostrzanej, albo od niej. Ich zachowania wydawały się celowe i często złożone i nieprzewidywalne, tak bardzo, że Walter powiedział, że "mogą być akceptowane jako dowód pewnego stopnia samoświadomości". Machina speculatrix była początkiem długiej linii coraz bardziej wyrafinowanych "maszyn zachowawczych" opracowanych przez kolejnych badaczy.

Rozwój i dojrzewanie

Być może istnieją alternatywy dla powtórzenia samej ewolucji lub podążania jej ścieżkami w kierunku rosnącej złożoności najbardziej prymitywnych zwierząt. Poprzez staranne badanie zachowań małych dzieci szwajcarski psycholog Jean Piaget zaproponował zestaw etapów w dojrzewaniu ich zdolności myślenia od niemowlęctwa do okresu dojrzewania. Czy te etapy mogą dostarczyć zestaw kroków, które mogłyby pomóc projektantom inteligentnych artefaktów? Zacznij od maszyny, która jest w stanie zrobić to, co dziecko może zrobić, a następnie zaprojektować maszyny, które mogą naśladować zdolności dzieci na każdym szczeblu drabiny. Tę strategię można nazwać "ontogenetyczną", aby kontrastować z filogenetyczną "strategią użycia symulowanej ewolucjji. Oczywiście może być tak, że umysł niemowlęcia jest zbyt skomplikowany, aby go symulować, a procesy jego dojrzewania zbyt trudne do naśladowania. W każdym razie ta szczególna wskazówka pozostaje do wykorzystania.

Bionika

Na sympozjum w 1960 r. Major Jack E. Steele z Wydziału Lotnictwa Stanów Zjednoczonych Sił Powietrznych użył terminu "bionika", aby opisać dziedzinę, która uczy się nauk przyrodniczych, aby zastosować ją do technologii. Kilka spotkań związanych z bioniką i bioniką odbyły się w latach 60. Na sympozjum Bionics z 1963 r. Leonard Butsch i Hans Oestreicher napisali: "Bionika ma na celu wykorzystanie milionów lat ewolucji żywych systemów, podczas których przystosowali się do optymalnego przetrwania. Jednym z wybitnych sukcesów ewolucji jest zdolność przetwarzania informacji systemów żywych [których badanie jest] jednym z głównych obszarów badań Bioniki. "

Dzisiaj słowo "bionika" dotyczy głównie ortezy i protezy, takie jak sztuczne ślimaki, siatkówki i kończyny. Niemniej jednak, ponieważ badacze sztucznej inteligencji kontynuują swoje poszukiwania, badanie żywych istot, ich ewolucja i ich rozwój mogą nadal dostarczać przydatnych wskazówek do budowania inteligentnych artefaktów.

Z inżynierii

Automaty, wykrywanie i informacje zwrotne

Maszyny, które poruszają się same, a nawet same wykonują użyteczne rzeczy, istnieją od wieków. Prawdopodobnie najpowszechniejszymi wczesnymi przykładami są zegary sterowane wagą typu "verge-and-foliot". Te pojawiły się po raz pierwszy w późnym średniowieczu w wieżach wielkich włoskich miast. Mechanizm krawędziowy i foliowy przekształcił energię spadającej masy w stopniowy ruch obrotowy, który można wykorzystać do poruszania wskazówkami zegara. Podobne mechanizmy opracowano w celu kontrolowania działań automatów, takich jak te z Monachium Glockenspiel. Jedną z pierwszych automatycznych maszyn do produkcji towarów było krosno tkackie Josepha-Marie Jacquarda, zbudowane w 1804 r. Było to następstwem długiej historii krosien i ulepszania projektu "dziurkowanej karty" krosna Jacquesa de Vaucansona z 1745 r. (Vaucanson zrobił więcej niż budowa mechanicznej kaczki.) Dziurkowane karty krosna Jacquard kontrolowały działania krosien, pozwalając na automatyczną produkcję wzorów tkanin. Zaledwie kilka lat po jego wynalezieniu było około 10 000 tkackich żakardowych krosien daleko we Francji. Pomysł wykorzystania dziur w papierze lub kartach został później przyjęty przez Hermana Holleritha w celu zestawienia 1890 amerykańskich danych spisowych i fortepianów dla graczy (z użyciem perforowanych rolek zamiast kart). Pierwsze "roboty" fabryczne tak zwanej odmiany pick-and-place wykorzystywały tylko skromne opracowania tego pomysłu. Konieczne było jedynie zapewnienie tym wczesnym maszynom zewnętrznego źródła energii (spadająca masa, zraniona sprężyna lub ludzie pompujący pedały). Ich zachowanie było poza tym w pełni automatyczne, nie wymagało od ludzi żadnych wskazówek. Ale mieli ważne ograniczenie -nie dostrzegali niczego o swoich środowiskach. (Karty dziurkowane, które zostały "przeczytane" przez krosno żakardowe są uważane za część maszyny (nie są częścią środowiska). Wyczuwanie środowiska, a następnie pozwalanie na to, co jest wyczuwane przez to, co robi maszyna, ma kluczowe znaczenie dla inteligentnego zachowania. Żółwie Waltersa, na przykład, miały fotokomórki, które potrafiły wykryć obecność lub nieobecność światła w ich otoczeniu i działać zgodnie z nimi. W związku z tym wydają się bardziej inteligentne niż krosna żakardowe lub automaty zegarowe. Jeden z najprostszych sposobów na to, co jest dozwolone wyczuwalny wpływ zachowań wiąże się z tzw. sprzężeniem zwrotnym. Słowo to wywodzi się z podawania pewnego aspektu zachowania maszyny, powiedzmy jej szybkości działania, z powrotem do wejścia urządzenia. Jeśli aspekt zachowania, który jest sprzężony zwrotnie, ma na celu zmniejszenie lub odwrócenie tego aspektu, proces ten nazywa się "negatywnym sprzężeniem zwrotnym". "Z drugiej strony, jeśli ma on na celu zwiększenie lub zaakcentowanie tego aspektu zachowania, nazywa się to" pozytywnym sprzężeniem zwrotnym " . "Oba typy sprzężenia zwrotnego odgrywają niezwykle ważną rolę w inżynierii. Techniki negatywne sprzężenia zwrotnego były stosowane od wieków

Angielski psychiatra W. Ross Ashby (1903 - 1972) przyczynił się do rozwoju cybernetyki poprzez swoje badania nad "ultrastabilnością" i "homeostazą". Według Ashby'ego, ultrastabilność to zdolność systemu do osiągnięcia stabilnego stanu w różnych warunkach środowiskowych. Aby zilustrować ten pomysł, zbudował urządzenie elektromechaniczne o nazwie "homeostat. " Składał się z czterech obrotowych magnesów, których położenia uczyniono współzależnymi za pomocą mechanizmów sprzężenia zwrotnego. Jeśli pozycja któregokolwiek z nich zostanie zakłócona, oddziaływanie na inne, a następnie na siebie, spowoduje powrót wszystkich do stanu równowagi. Ashby opisał to urządzenie w rozdziale 8 swojej wpływowej książki Design For a Brain z 1952 r. Jego pomysły wywarły wpływ na kilku badaczy AI. Kolejne źródło pomysłów, luźno związanych z cybernetyką i bioniką, pochodzi z badań " samoorganizujących się systemów. "Wiele niezorganizowanych kombinacji prostych części, w tym kombinacji atomów i cząsteczek, reaguje na energiczny" szarpnięcie "wpadając w stabilne stany, w których części są zorganizowane w bardziej złożone zespoły. Słownik online poświęcony cybernetyki i teorii systemów ma dobry przykład: "Łańcuch zrobiony z spinaczy papierowych sugeruje, że ktoś zadał sobie trud, aby połączyć spinacze ze sobą, aby utworzyć łańcuch. się w łańcuch. Ale jeśli weźmiesz kilka spinaczy do papieru, otwórz je lekko, a następnie potrząśnij nimi razem w shakerze koktajlowym, na końcu zobaczysz, że klipsy zorganizowały się w krótkie lub długie łańcuchy. Łańcuchy nie są tak schludne jak łańcuchy złożone ręcznie, ale, niemniej są to łańcuchy. "Termin" samoorganizacja "wydaje się być wprowadzony po raz pierwszy przez Ashby'ego w 1947 r.42 Ashby podkreślił, że samoorganizacja nie jest własnością samego organizmu w odpowiedzi na jego środowisko i doświadczenie, ale właściwością całego organizmu i jego środowiska. Chociaż samoorganizacja wydaje się ważna w ideach dotyczących powstania życia, nie jest jasne, czy zapewnia wskazówki do budowy inteligentnych maszyn

Statystyki i prawdopodobieństwo

Ponieważ prawie wszystkie rozumowania i podejmowania decyzji odbywają się w obecności niepewności, radzenie sobie z niepewnością odgrywa ważną rolę w automatyzacji inteligencji. Próby ilościowego określenia niepewności i praw przypadku "dały początek statystyce i teorii prawdopodobieństwa. Tym, co okazałoby się jednym z najważniejszych wyników w teorii prawdopodobieństwa, przynajmniej dla sztucznej inteligencji, jest reguła Bayesa, którą będę definiowane obecnie w kontekście przykładu Reguła nosi imię Reverend Thomas Bayes (1702 - 1761), angielskiego duchownego. Jednym z ważnych zastosowań reguły Bayesa jest wykrywanie sygnału. Załóżmy, że odbiornik radiowy jest dostrojony do stacja, która po północy nadaje (losowo) jeden z dwóch tonów, albo ton A, albo ton B, a konkretnej nocy chcemy zdecydować, który z nich jest nadawany. W danym dniu nie wiemy z góry, który ton jest być transmitowanym tej nocy, ale przypuśćmy, że znamy ich prawdopodobieństwo (na przykład może tak być ,że oba dźwięki są równie prawdopodobne.) Czy możemy dowiedzieć się, który ton jest nadawany przez słuchanie sygnału przychodzącego do odbiornika? Cóż, słuchanie nie może całkowicie rozwiązać sprawy, ponieważ stacja jest daleko, a przypadkowy hałas częściowo zasłania ton. Jednakże, w zależności od natury zasłaniającego hałasu, często możemy obliczyć prawdopodobieństwo, że rzeczywisty ton tej nocy to A (lub że jest to B). Nazwijmy sygnał y i rzeczywisty ton x (który może być A lub B). Prawdopodobieństwo, że x = A, biorąc pod uwagę dowody na to, że zawarte w przychodzącym sygnale, y, jest zapisane jako p (x = A jy) i odczytane jako prawdopodobieństwo, że x jest A, biorąc pod uwagę, że sygnał jest y. prawdopodobieństwo, że x = B, przy takim samym dowodzie, wynosi p (x = B jy). Rozsądną zasadą decyzji "byłoby podjęcie decyzji na korzyść tonu A, jeśli p (x = A jy) jest większe niż p (x = B jy). W przeciwnym razie zdecyduj się na ton B. (Istnieje prosta regulacja tej reguły, która uwzględnia różnice w kosztach "dwóch możliwych błędów.) Problemem w stosowaniu tej reguły jest to, że te dwa prawdopodobieństwa nie są łatwo obliczalne i właśnie tam pojawia się reguła Bayesa. Pozwala nam obliczyć te prawdopodobieństwa w kategoriach innych prawdopodobieństw, które są łatwiejsze do odgadnięcia lub w inny sposób możliwe do uzyskania.

p (x j y) = p (y j x) p (x) = p (y):

Korzystając z reguły Bayesa, naszą regułę decyzji można teraz przeformułować jako

Zdecyduj na korzyść tonu A, jeśli p (y j x = A) p (x = A) = p (y) jest większe niż p (y j x = B) p (x = B) = p (y). W przeciwnym razie zdecyduj się na ton B.

Ponieważ p (y) występuje w obu wyrażeniach i dlatego nie wpływa na to, który z nich jest większy, zasada upraszcza decyzję na korzyść tonu A, jeśli p (yjx = A) p (x = A) jest większe niż p (yjx = B) p (x = B). W przeciwnym razie zdecyduj na korzyść tonu B. Zakładamy, że znamy prawdopodobieństwa a priori tonów, a mianowicie p (x = A) i p (x = B), więc pozostaje nam tylko obliczyć p (yjx) dla x = A i x = B. To wyrażenie jest nazywane prawdopodobieństwem y podanym x. Gdy dwa prawdopodobieństwa, p (x = A) ip (x = B), są równe (to znaczy, gdy oba tony są równie prawdopodobne a priori), możemy zdecydować, które prawdopodobieństwo jest większe. Wiele decyzji podejmowanych w obecności niepewności wykorzystuje tę metodę maksymalnego prawdopodobieństwa. Obliczenie tych prawdopodobieństw zależy od tego, jak reprezentujemy odbierany sygnał, y, oraz od statystyki zakłócającego hałasu. W moim przykładzie y to sygnał radiowy, czyli napięcie zmieniające się w czasie. Dla celów obliczeniowych, to zmienne w czasie napięcie może być reprezentowane przez sekwencję próbek jego wartości w odpowiednio wybranych, równomiernie rozmieszczonych punktach czasowych, powiedzmy y (t1), y (t2),. . . y (ti),. . . , y (N). Gdy szum zmienia te wartości z tego, co byłyby bez szumu, prawdopodobieństwo ich sekwencji (biorąc pod uwagę przypadki, gdy tonem jest A, a tonem B), można obliczyć przy użyciu znanych statystycznych właściwości szumu. Nie będę tu omawiać

może być reprezentowane przez sekwencję próbek jego wartości w odpowiednio wybranych, równomiernie rozmieszczonych punktach czasowych, powiedzmy y (t1), y (t2),. . . y (ti),. . . , y (N). Gdy szum zmienia te wartości z tego, co byłyby bez szumu, prawdopodobieństwo ich sekwencji (biorąc pod uwagę przypadki, gdy tonem jest A, a tonem B), można obliczyć przy użyciu znanych statystycznych właściwości szumu. Nie będę tu omawiać

szczegółów, z wyjątkiem stwierdzenia, że dla wielu rodzajów statystyk hałasu obliczenia te są dość proste. W XX wieku naukowcy i statystycy, tacy jak Karl Pearson (1857 - 1936), Sir Ronald A. Fisher (1890 - 1962), Abraham Wald (1902 - 1950) i Jerzey Neyman (1894 - 1981) byli wśród tych, którzy tworzyli ważny wkład w wykorzystanie metod statystycznych i probabilistycznych w szacowaniu parametrów i podejmowaniu decyzji. Ich praca położyła podwaliny pod niektóre z pierwszych zastosowań inżynierskich reguły Bayesa, takich jak ten, który właśnie zilustrowałem, a mianowicie, decydując, który z dwóch lub więcej sygnałów elektrycznych jest obecny w sytuacjach, w których hałas przesłania sygnały . Opracowanie amerykańskich inżynierów Davida Van Metera i Davida Middletona, które czytałem jako początkujący student w 1955 r., Było moim wstępem do tych aplikacji. W przypadku sztucznej inteligencji zastosowanie reguł Bayesa dostarczyło wskazówek, jak zmechanizować. W przypadku sztucznej inteligencji zastosowanie reguł Bayesa dostarczyło wskazówek, jak zmechanizować percepcję zarówno dźwięków mowy, jak i obrazów. Poza percepcją rządy Bayesa leżą w centrum wielu innych współczesnych prac w dziedzinie sztucznej inteligencji.

Komputer

A. Wczesne urządzenia obliczeniowe

Propozycje takie jak Leibniza, Boole'a i Frege można uznać za wczesne próby stworzenia podstaw dla tego, co stanie się "oprogramowaniem" sztucznej inteligencji. Ale rozumowanie i wszystkie inne aspekty inteligentnego zachowania wymagają oprócz oprogramowania jakiegoś fizycznego silnika. U ludzi i innych zwierząt ten silnik jest mózgiem. Proste urządzenia Greya Waltera i Rossa Ashby'ego były oczywiście fizycznymi manifestacjami ich pomysłów. I, jak zobaczymy, wczesne sieci jednostek podobnych do neuronów zostały zrealizowane w formie fizycznej. Jednak, aby zbadać idee tkwiące w większości wskazówek z logiki, z neurofizjologii i nauk kognitywnych potrzebne byłyby silniejsze silniki. Podczas gdy McCulloch, Wiener, Walter, Ashby i inni spekulowali na temat maszynerii inteligencji, powstała bardzo potężna i niezbędna maszyna - {komputer cyfrowy ogólnego przeznaczenia. Ta pojedyncza maszyna zapewniała silnik dla wszystkich tych pomysłów i nie tylko. Jest to zdecydowanie dominujący silnik sprzętowy do automatyzacji inteligencji. Budowanie urządzeń do obliczeń ma długą historię. William Aspray zredagował znakomitą książkę "Computing Before Computers" na temat wczesnych dni obliczeniowych45. Pierwsze maszyny były w stanie wykonywać obliczenia arytmetyczne, ale nie były one programowalne. Wilhelm Schickard (1592 - 1635; zbudował jeden z pierwszych w 1623 r. Mówi się, że był w stanie dodawać i odejmować liczby sześciocyfrowe do wykorzystania w obliczaniu tablic astronomicznych. Maszyna mogła przenosić "z jednej cyfry na drugą. W 1642 r. Blaise Pascal (1623 -1662) stworzył pierwszą z około pięćdziesięciu swoich maszyn obliczeniowych. Była to maszyna dodająca, która mogła wykonywać automatyczne przenoszenie z jednej pozycji do drugiej. "Urządzenie znajdowało się w pudełku, które było wystarczająco małe, aby łatwo było je umieścić na biurku lub małym stoliku. Górna powierzchnia pudełka

składała się z wielu kół zębatych, powyżej których znajdowało się kilka małych okien do W celu dodania liczby, powiedzmy 3, do rejestru wyników, konieczne było jedynie włożenie małego rysika do koła zębatego w miejscu oznaczonym 3 i obrócenie koła zgodnie z ruchem wskazówek zegara, aż rysik napotkał zatrzymanie. "Zainspirowany maszynami Pascala, Gottfried Leibniz zbudował w 1674 r. Mechaniczny mnożnik o nazwie Step Reckoner. Mogła dodawać, odejmować i dokonywać mnożenia (przez wielokrotne dodawanie). "Aby pomnożyć liczbę przez 5, wystarczy obrócić korbą pięć razy". W następnych stuleciach zbudowano kilka innych kalkulatorów. Szczególnie interesujący, który był zbyt skomplikowany do zbudowania w swoim czasie, zaprojektował w 1822 roku Charles Babbage (1791 -1871), angielski matematyk i wynalazca. Nazywany silnikiem różnicowym, "miał obliczyć tabele matematyczne (na przykład używane w nawigacji na morzu) przy użyciu metody różnic skończonych. Silnik różnicowy Babbage'a nr 2 został faktycznie skonstruowany w 1991 r. (Przy użyciu projektu Babbage'a i dziewiętnastowiecznej tolerancjie mechanicznej), a teraz jest prezentowane w London Science Museum. Muzeum zorganizowało kolejną kopię dla Nathana Myhrvolda, byłego dyrektora ds. technologii Microsoft.

Maszyny dodające mogą jednak tylko dodawać i odejmować (i, powtarzając te operacje, również pomnażać i dzielić). Są to ważne operacje, ale nie jedyne potrzebne. W latach 1834-1837 Babbage pracował nad konstrukcją maszyny o nazwie Analytical Engine, "która zawierała większość pomysłów potrzebnych do ogólnych obliczeń. Mogła przechowywać wyniki pośrednie w" młynie "i mogła być zaprogramowana. Jednak proponowana realizacja jako kolekcja napędzanych parą, oddziałujących na siebie mosiężnych kół zębatych i krzywek spotkała się z trudnościami finansowymi i nigdy nie została skonstruowana. Ada Lovelace (1815 - 1852), córka Lorda Byrona, została nazwana pierwszym programistą "za jej rzekomą rolę w opracowywaniu programów dla silnika analitycznego. Jednak w książce Computing Before Computers pojawia się następujące twierdzenie: Ten romantycznie atrakcyjny obraz nie ma podstaw. Wszystkie programy z wyjątkiem jednego cytowanego w jej notatkach [do tłumaczenia relacji z wykładu Babbage'a w Turynie, Włochy] zostały

przygotowane przez Babbage'a od trzech do siedmiu lat wcześniej. Wyjątek przygotował dla niej Babbage, chociaż wykryła w nim błąd. Nie tylko nie ma dowodów na to, że Ada Lovelace kiedykolwiek przygotowała program dla silnika analitycznego, ale jej korespondencja z Babbage'em pokazuje, że nie miała wiedzy aby zrobić to. Praktyczne komputery musiały czekać na wynalazek urządzeń elektrycznych, a nie mosiężnych. Pierwsze komputery na początku lat 40. wykorzystywały przekaźniki elektromechaniczne. Lampy próżniowe (zawory termiczne, jak mówią w Wielkiej Brytanii) wkrótce wygrały, ponieważ pozwoliły na szybsze i bardziej niezawodne obliczenia. Obecnie komputery wykorzystują miliardy maleńkich tranzystorów rozmieszczonych na płytkach krzemowych. Kto wie, co kiedyś może je zastąpić?

B. Teoria obliczeń

Nawet zanim ludzie faktycznie zaczęli budować komputery, kilku logików i matematyków w latach trzydziestych rozważało problem tego, co można obliczyć. Alonzo Church wymyślił klasę funkcji, które można obliczyć, te, które nazwał "rekurencyjnymi". Angielski logik i matematyk, Alan Turing (1912 -1954), zaproponował coś, co jest obecnie uważane za równoważną klasę -te, które mogą być obliczone przez wyobrażoną maszynę, którą nazwał "maszyną obliczeniową logiczną (LCM)," obecnie nazywaną "Maszyą Turinga". Twierdzenie, że te dwa pojęcia są równoważne, nazywa się "tezą Churcha". (Oświadczenie nie zostało udowodnione, ale jest silnie wspierane przez logików i nigdy nie znaleziono żadnego kontrprzykładu). Maszyna Turinga jest hipotetycznym urządzeniem obliczeniowym, które jest całkiem proste do zrozumienia. Składa się z zaledwie kilku części. Istnieje skończona taśma (co jest jednym z powodów, dla których urządzenie jest po prostu wyobrażone i nie zostało zbudowane) podzielone na komórki i napęd taśmowy. Każda komórka wypisała na niej 1 lub 0. Maszyna ma również głowicę zapisującą {umieszczoną nad jedną komórką taśmy. Funkcja odczytu odczytuje zawartość taśmy. Istnieje również jednostka logiczna, która może decydować, zależnie od tego, co jest odczytywane i stan maszyny logicznej, o zmianę własnego stanu, aby polecić funkcji zapisu zapisanie 1 lub 0 na czytanej komórce (ewentualnie zastąpienie co już tam jest), aby przesunąć taśmę o jedną komórkę w lewo lub w prawo (w tym czasie nowa komórka jest odczytywana itd.) lub zakończyć działanie w ogóle. Wejście (problem "do obliczenia") jest początkowo zapisywane na taśmie (okazuje się, że każde takie wejście może być zakodowane w 1 i 0). Kiedy i jeśli maszyna zakończy działanie, wyjście (zakodowane) odpowiedź "na problem wejściowy" kończy się wydrukowaniem na taśmie Turing udowodnił, że zawsze można określić konkretną jednostkę logiczną (część, która decyduje o działaniach maszyny) dla swojej maszyny, tak aby maszyna obliczyła dowolną funkcję obliczeniową. co

ważne, pokazał, że na samej taśmie można zakodować receptę na dowolną jednostkę logiczną specjalizującą się w konkretnym problemie, a następnie użyć jednostki logicznej ogólnego przeznaczenia do wszystkich problemów Kodowanie jednostki logicznej specjalnego przeznaczenia może być traktowane jako "program" dla maszyny, który jest przechowywany na taśmie (a zatem może ulec zmianie w wyniku działania samego urządzenia!) wraz z opisem problemu do rozwiązania. W słowach Turinga można wykazać, że pojedyncza specjalna maszyna tego typu może być ma de, aby wykonać wszystko. W rzeczywistości można by go wykorzystać jako model dowolnej innej maszyny. Specjalna maszyna może być nazywana maszyną uniwersalną.

C. Komputery cyfrowe

Nieco niezależnie od Turinga inżynierowie zaczęli myśleć o tym, jak zbudować rzeczywiste urządzenia komputerowe składające się z programów i obwodów logicznych do wykonywania instrukcji zawartych w programach. Niektóre z kluczowych pomysłów dotyczących projektowania obwodów logicznych komputerów zostały opracowane przez amerykańskiego matematyka i wynalazcę Claude'a Shannona (1916-2001). W swojej pracy magisterskiej Yale University z 1937 r. Shannon wykazał, że algebra Boole'a i arytmetyka binarna mogą być wykorzystane do uproszczenia obwodów przełączania telefonicznego. Pokazał również, że obwody przełączające (które można zrealizować przez wykorzystanie kombinacji przekaźników, lamp próżniowych lub cokolwiek innego , implementując operacje w logice boolowskiej, wyjaśniając w ten sposób ich znaczenie w projektowaniu komputerów. Trudno powiedzieć, kto pierwszy pomyślał o pomyśle przechowywania programu komputerowego wraz z jego danymi w bankach pamięci komputera. Przechowywanie programu pozwala na łatwe wprowadzanie zmian w programie, ale co ważniejsze, pozwala na zmianę programu poprzez zmianę odpowiednich części pamięci, w których program jest przechowywany. Wśród tych, którzy mogli pomyśleć o tym pomyśle, są niemiecki inżynier Konrad Zuse (1910 {1995) i pionier amerykańskiego komputera J. Presper Eckert (1919 - 1995) i John W. Mauchly (1907 - 1980). (Oczywiście Turing zaproponował już przechowywanie tego, co stanowiło program na taśmie uniwersalnej maszyny Turinga). Jeden z nich wspomina, że bezsporne jest, że Z3 Konrada Zuse był pierwszym w pełni funkcjonalnym, sterowanym programowo komputerem na świecie.

… Z3 został zaprezentowany 12 maja 1941 r. Publiczności naukowców w Berlinie. "Zamiast lamp próżniowych użył 2400 przekaźników elektromechanicznych. Pierwotny Z3 został zniszczony przez nalot aliancki 21 grudnia 1943 r. zrekonstruowana wersja została zbudowana na początku lat sześćdziesiątych i jest obecnie prezentowana w Deutsche Museum w Monachium. Mówi się również, że Zuse stworzył pierwszy język programowania o nazwie Plankalk? Amerykański matematyk John von Neumann (1903-1957) napisał projekt raportu "o EDVAC, komputerze z wczesnym przechowywaniem programu. Być może z powodu tego raportu mówimy teraz, że tego rodzaju komputery używają "architektury von Neumanna". Idealna architektura von Neumanna oddziela przechowywany program (specyficzny dla zadania) od obwodów sprzętowych (ogólnego przeznaczenia), które mogą wykonywać (sekwencyjnie) instrukcje dowolnego programu. (Zwykle nazywamy program "oprogramowanie", aby odróżnić go od "sprzętowej" części komputera, jednak rozróżnienie jest niewyraźne w większości nowoczesnych komputerów, ponieważ często niektóre z nich są zbudowane prawidłowo w ich obwodach.) Inne komputery z zapisanymi programami zostały zaprojektowane i zbudowane w latach 40. XX w. w Niemczech, Wielkiej Brytanii i Stanach Zjednoczonych. Były to duże, masywne maszyny. W Wielkiej Brytanii i Stanach Zjednoczonych używano ich głównie do celów wojskowych. Nazywamy te maszyny "komputerami", mimo że dziś można je stworzyć całkowicie elektryczniee bez żadnych ruchomych części. Co więcej, kiedy mówimy o komputerach, zazwyczaj mamy na myśli połączenie komputera i programu, który jest uruchomiony. Czasami nazywamy nawet program maszyną. (Jako przykład takiego zastosowania powiem później o "maszynie do gry w warcaby" i oznacza program, który odtwarza warcaby). Zdecydowane znaczenie komputera cyfrowego z zapisanym programem wynika z faktu, że może być on używany do jakikolwiek cel - to jest oczywiście dowolny cel obliczeniowy. Nowoczesny komputer cyfrowy jest praktycznie uniwersalny. Niezbędne są wszystkie praktyczne cele, ponieważ nawet nowoczesne komputery nie mają tak dużej pojemności pamięciowej, jak sugeruje taśma Turinga. Jednak mają one ogromne ilości pamięci, co czyni je praktycznie uniwersalnymi.

D. Komputery "Thinking"

Po zbudowaniu pierwszych komputerów Turing uznał, że gdyby były praktycznie uniwersalne, powinny być w stanie zrobić wszystko. W 1948 roku napisał: Znaczenie uniwersalnej maszyny jest jasne. Nie musimy mieć różnych maszyn wykonujących różne zadania. Wystarczy jeden. Problem inżynieryjny związany z produkcją różnych maszyn do różnych zadań zostaje zastąpiony pracą biurową polegającą na "programowaniu" uniwersalnej maszyny do wykonywania tych zadań. "Wśród rzeczy, które komputery Turinga mogły zrobić, było naśladowanie ludzkiej inteligencji. Jeden z biografów Turinga, Andrew Hodges, twierdzi, "uznał, że zakres obliczeniowy obejmuje znacznie więcej, niż można by uzyskać dzięki wyraźnym instrukcjom instruktażowym, i wystarczająco, aby uwzględnić wszystko, co zrobił ludzki mózg, niezależnie od tego, czy był twórczy czy oryginalny. Maszyny o dostatecznej złożoności miałyby zdolność ewoluowania do zachowania, które nigdy nie zostało wyraźnie zaprogramowane. "Pierwszy nowoczesny artykuł dotyczący możliwości zmechanizowania całej inteligencji w stylu ludzkim został opublikowany przez Turinga w 1950 roku. Po pierwsze, Turing myślał, że pytanie "Czy maszyna może myśleć?" było zbyt niejednoznaczne, a zamiast tego zaproponował, aby kwestia inteligencji maszynowej została rozstrzygnięta przez to, co nazwano "testem Turinga". (głównie uproszczeń) testu, oto jak sam Turing to opisał:

Nowa forma problemu [Czy maszyny mogą myśleć?] Można opisać w kategoriach gry, którą nazywamy grą naśladowczą. "Gra się z trzema osobami, mężczyzną (A), kobietą (B) i przesłuchującym (C), który może być obojga płci, przesłuchujący pozostaje w pokoju poza dwoma pozostałymi Celem gry dla przesłuchującego jest ustalenie, który z pozostałych dwóch jest mężczyzną, a który kobietą. według etykiet X i Y, a na końcu gry mówi, że X to A, a Y to B "lub X to B, a Y to A." Śledczy może zadawać pytania A i B w ten sposób: C: Czy X powie mi, ile ma włosów? Teraz załóżmy, że X jest w rzeczywistości A, a A musi odpowiedzieć. Jest to obiekt A w grze, który próbuje spowodować, że C zrobi błędną identyfikację. bądź "Moje włosy są gontowane, a najdłuższe mają około dziewięciu cali długości". Aby tony głosu nie pomogły przesłuchującemu, odpowiedzi powinny być napisane, lub jeszcze lepiej, na maszynie. Idealnym rozwiązaniem jest komunikowanie się teleprintera między dwoma pokojami. Alternatywnie pytanie i odpowiedzi mogą zostać powtórzone przez pośrednika. Celem gry dla trzeciego gracza (B) jest pomoc śledczemu. Najlepszą strategią dla niej jest zapewnianie prawdziwych odpowiedzi. Może dodawać takie rzeczy jak "Jestem kobietą, nie słuchaj go!" do jej odpowiedzi, ale nic nie pomoże, ponieważ człowiek może poczynić podobne uwagi. Teraz zadajemy pytanie: Co się stanie, gdy maszyna zajmie część A w tej grze? "Czy przesłuchujący będzie błędnie decydował tak często, gdy gra jest rozgrywana w ten sposób, jak gra, gdy gra jest rozgrywana między mężczyzną a Te pytania zastępują nasze oryginalne "Czy maszyny mogą myśleć?

Większość uproszczeń testu Turinga polega na próbie posiadania komputera w drugim pokoju "oszukuj śledczego, aby uwierzył, że komputer jest człowiekiem. Aby pobudzić postęp w kierunku tego celu, została ustanowiona nagroda -faktycznie nagrody roczne. Zgodnie ze słowami strony internetowej ogłaszającej nagrody, w 1990 r. Hugh Loebner zgodził się z The Cambridge Centre for Behavioral Studies, aby zagwarantować konkurs mający na celu wdrożenie testu Turinga, dr Loebner obiecał nagrodę główną w wysokości 100 000 $ oraz złoty medal za pierwszy komputer, którego odpowiedzi były nie do odróżnienia od człowieka. O takim komputerze możemy powiedzieć ,że możę "myśleć". Co roku coroczna nagroda w wysokości 2000 USD i brązowy medal przyznawane są komputerowi najbardziej przypominającemu człowieka. Zwycięzca corocznego konkursu jest najlepszym wpisem w stosunku do innych zgłoszeń w tym roku, niezależnie od tego, jak dobry jest w absolutnym sensie. " Jednak kilka osób wskazało na niedoskonałości zarówno uproszczeń, jak i pierwotnego testu. W rzeczywistości twierdzono, że nawet nieinteligentny program konwersacyjny z 1966 r. Josepha Weizenbauma, ELIZA, ogłupił ludzi, którzy myślą, że jest to człowiek. Na przykład, oto część transkrypcji rozmowy z ELIZĄ:

ELIZA: Jak się masz? Podaj swój problem.

> Spędzam zbyt wiele czasu z komputerami.

ELIZA: Dlaczego wspominasz o komputerach?

> Jesteś jednym z nich.

ELIZA: Czy to ci się podoba, że wierzysz, że jestem jednym z nich?

> Tak.

ELIZA: Wydajesz się być całkiem pozytywna.

> Przypuszczam, że jestem.

ELIZA: Jak długo jesteś?

> 31 lat.

ELIZA: Nie jestem pewien, czy rozumiem cię w pełni.

> Dołącz do klubu.

ELIZA: Proszę, kontynuuj.

> Sam nie czujesz się zbytnio.

ELIZA: Rozmawialiśmy o tobie - nie o mnie.

Pierwsza część rozmowy wydaje się rozsądna, ale ELIZA pogrąża się w środku, ponieważ program oczekiwał, że po "mam nadzieję" nastąpi słowo "szczęśliwy". (W sieci jest kilka symulacji ELIZA. Jedna z nich, która mówi, że wiernie odtwarza oryginalny program ELIZA, znajduje się na stronie http://www.chayden.net/eliza/Eliza.html. Wypróbuj jedną z nich!)

Drugą ważną cechą pracy Turinga z 1950 r. Było postępowanie z argumentami, które ludzie mogą podnieść przeciwko możliwości osiągnięcia inteligentnych komputerów. Przytoczę te, o których wspomina Turing:

(1) Zastrzeżenie teologiczne: Myślenie jest funkcją nieśmiertelnej duszy człowieka. Bóg dał nieśmiertelną duszę każdemu człowiekowi i kobiecie, ale nie do żadnego innego zwierzęcia ani do maszyn. Dlatego żadne zwierzę ani maszyna nie może myśleć.

(2) Zastrzeżenie "Głowy w piasek": Konsekwencje myślenia maszyn byłyby zbyt straszne. Miejmy nadzieję i uwierzmy że nie mogą tego zrobić. "

(3) Sprzeciw matematyczny: Istnieje wiele wyników logiki matematycznej, które można wykorzystać do wykazania, że istnieją ograniczenia mocy maszyn dyskretnych.

(4) Argument ze świadomości: Ten argument jest bardzo dobrze wyrażone w Lister Oration profesora Jeonsona z 1949 r., z którego cytuję: "Dopóki maszyna nie będzie w stanie napisać sonetu lub skomponować koncertu z powodu odczuć i emocji, a nie przypadkowego upadku symboli, czy zgodzimy się, że maszyna równa się mózgowi - to znaczy, nie tylko pisz to, ale wiedz, że je napisał, żaden mechanizm nie może odczuwać (a nie tylko sztuczny sygnał, łatwego rozwiązania) przyjemności z jego sukcesów, żal, gdy jego zawory łączą się, ogrzewa się pochlebstwem, być nieszczęśliwym z powodu swoich błędów, być oczarowanym seksem, być rozgniewanym lub przygnębionym, gdy nie może dostać tego, czego chce.

(5) Argumenty z różnych niepełnosprawności: Te argumenty przybierają formę: "Wierzę ci, że możesz zrobić maszyny, aby zrobiły wszystko, o czym wspomniałeś, ale nigdy nie będziesz w stanie zrobić X."

(6) Sprzeciw Lady Lovelace: Nasze najbardziej szczegółowe informacje o silniku analitycznym Babbage'a pochodzą z pamiętnika Lady Lovelace. W nim stwierdza: "Silnik analityczny nie ma żadnych pretensji do tworzenia czegokolwiek. Może robić wszystko, co wiemy, jak wykonać".

(7) Argument z ciągłości w układzie nerwowym: Układ nerwowy z pewnością nie jest maszyną o stanie dyskretnym. Niewielki błąd w informacjach o wielkości impulsu nerwowego uderzającego w neuron może znacznie zmienić rozmiar impulsu wychodzącego. Można argumentować, że w takiej sytuacji nie można oczekiwać, że uda się naśladować zachowanie układu nerwowego za pomocą systemu stanów dyskretnych.

(8) Argument z nieformalnego zachowania: Nie jest możliwe stworzenie zestawu reguł rzekomo opisujących, co powinien robić w każdym możliwym zestawie okoliczności.

(9) Argument z percepcji pozazmysłowej

W swojej pracy Turing ładnie (moim zdaniem) zajmuje się wszystkimi tymi punktami, z możliwym wyjątkiem ostatniego (ponieważ najwyraźniej uważał, że postrzeganie pozazmysłowe jest wiarygodne). Zostawię to tobie, żebyś przeczytał artykuł Turinga z 1950 roku, aby zobaczyć jego kontrargumenty. Trzecią ważną cechą pracy Turinga z 1950 r. Jest jego sugestia, w jaki sposób możemy opracować programy o zdolnościach intelektualnych na poziomie człowieka. Pod koniec pracy sugeruje: "Zamiast próbować stworzyć program do symulacji umysłu dorosłego, dlaczego nie spróbować stworzyć takiego, który symuluje dziecko? Gdyby następnie poddano go odpowiedniemu kursowi edukacyjnemu, można by uzyskać mózg dorosłego. " Ta sugestia jest naprawdę źródłem wspomnianego wcześniej pomysłu na wykorzystanie strategii ontogenetycznej do opracowania inteligentnych maszyn. Allen Newell i Herb Simon byli wśród tych, którzy nie mieli problemu z przekonaniem, że uniwersalność cyfrowego komputera oznacza, że można go wykorzystać do mechanizacji inteligencji we wszystkich jej przejawach (pod warunkiem, że ma odpowiednie oprogramowanie). W wykładzie ACM Turing Award z 1975 r. Opisali hipotezę, że niewątpliwie uwierzyli dużo wcześniej, w "hipotezę fizycznego systemu symboli". Stwierdza, że "fizyczny system symboli ma niezbędne i wystarczające środki do inteligentnego działania". Dlatego zgodnie z hipotezą odpowiednio zaprogramowane komputery cyfrowe będą zdolne do inteligentnego działania. I odwrotnie, ponieważ ludzie są zdolni do inteligentnego działania, muszą być, zgodnie z hipotezą, systemami symboli fizycznych. Są to bardzo silne twierdzenia, które nadal są dyskutowane. Zarówno wyobrażona maszyna Turinga, jak i bardzo prawdziwy komputer cyfrowy to systemy symboli w znaczeniu, jakie Newell i Simon mieli na myśli. Jak maszyna Turinga, która używa taśmy z nadrukiem 0 i 1, może być symbolem "system "? Cóż, 0 i 1 wydrukowane na taśmie można traktować jako symbole stojące za przypisanymi im numerami. Inne symbole, takie jak "A" i "M", mogą być kodowane jako sekwencje pierwotnych symboli, takich jak 0 i 1. Słowa mogą być kodowane jako sekwencje liter i tak dalej. Fakt, że powszechnie uważa się komputer cyfrowy za maszynę działającą na 0 i 1, nie musi nam przeszkadzać w myśleniu o tym, że działa również na bardziej złożonych symbolach. W końcu wszyscy jesteśmy przyzwyczajeni do używania komputerów do "przetwarzania tekstu" i wysyłania wiadomości e-mail. Newell i Simon przyznali, że ich hipoteza może rzeczywiście być fałszywa: "Inteligentne zachowanie nie jest tak łatwe do wytworzenia, że jakikolwiek system pokaże go chcąc nie chcąc. Rzeczywiście, są ludzie, których analizy prowadzą ich do konkluzji na gruncie filozoficznym lub naukowym że ta hipoteza jest fałszywa, a naukowcy mogą ją atakować lub bronić tylko poprzez dostarczanie empirycznych dowodów na temat świata przyrody. " Podsumowują, co następuje: Hipoteza systemu symboli zakłada, że symboliczne zachowanie człowieka powstaje, ponieważ ma on cechy fizycznego systemu symboli. Stąd wyniki prób modelowania ludzkiego zachowania za pomocą systemów symboli stają się ważną częścią dowodów na hipotezę, a badania w dziedzinie sztucznej inteligencji toczą się w ścisłej współpracy z badaniami nad psychologią przetwarzania informacji, jak to się zwykle nazywa. Chociaż hipoteza ta nie została formalnie opisana, dopóki nie pojawiła się w artykule z 1976 r., Była z pewnością ukryta w tym, w co wierzyli Turing i inni badacze w latach pięćdziesiątych. Po śmierci Allena Newella Herb Simon napisał: "Od samego początku w badaniu osadzono coś w rodzaju hipotezy fizycznego systemu symboli." Zainspirowani wskazówkami, o których wspominaliśmy i uzbrojeni w komputer cyfrowy ogólnego przeznaczenia, naukowcy rozpoczęli w trakcie Lata pięćdziesiąte, w celu zbadania różnych ścieżek ku mechanizacji inteligencji Z głęboką wiarą w hipotezę systemu symboli, niektórzy ludzie zaczęli programować komputery, próbując nakłonić je do wykonania niektórych zadań intelektualnych, które ludzie mogli wykonać. badając podejścia, które nie zależą bezpośrednio od przetwarzania symboli, czerpią inspirację głównie z pracy McCullocha i Pittsa nad sieciami jednostek podobnych do neuronów i ze statystycznych podejść do podejmowania decyzji. nazywane "mózgowymi" i niesymbolicznymi "metodami przetrwały do dziś