Progi Zwalniające

Od najwcześniejszych dni sztucznej inteligencji istnieli pesymiści. Alan Turing przewidział (i zajął się) niektórymi z nich w swoim artykule z 1950 r. Tu opiszey niektóre z kontrowersji wokół AI - w tym niektóre nieprzewidziane przez Turinga. Opiszę także kilka poważnych trudności technicznych napotykanych w tej dziedzinie. Mniej więcej w połowie lat osiemdziesiątych trudności te sprawiły, że niektórzy byli raczej lekceważący co do postępy do tego czasu i pesymistyczni co do możliwości dalszego postępu. Na przykład zastanawiając się nad potrzebą specjalnego wydania czasopisma poświęconego Deadalus AI w 1988 r. filozof Hilary Putnam napisał: "O co teraz tyle zamieszania? Dlaczego cały problem z Deadalus? Dlaczego nie czekamy, aż AI coś osiągnie, a potem pojawią się jakieś problemy?" .Ataki i wyrazy rozczarowania spoza pola pomogły wytrącić to, co niektórzy nazywają "zimą AI".

Opinie różnych obserwatorów

Umysł nie jest maszyną

We wprowadzeniu do swojego zredagowanego tomu esejów zatytułowanego "Umysły i maszyny" filozof Alan Ross Anderson wymienia następujące dwie skrajne opinie dotyczące tego, czy umysł jest maszyną, czy nie:

(1) Można powiedzieć, że istoty ludzkie są jedynie bardzo skomplikowanymi częściami mechanizmu zegarowego i że nasze "umysły" są po prostu konsekwencją faktu, że mechanizm zegarowy jest bardzo skomplikowany, lub

(2) moglibyśmy powiedzieć, że każda maszyna jest jedynie wytworem ludzkiej pomysłowości (w zasadzie tylko łopatą) i że chociaż mamy umysły, nie możemy przekazać tej naszej szczególnej cechy czegokolwiek poza naszym potomstwem: żadna maszyna nie może nabyć tę wyjątkową ludzką cechę.

Większość badaczy AI prawdopodobnie zgadza się z pierwszą z tych dwóch wypowiedzi. Z pewnością tak (choć nie użyłbym słowa "tylko"). Marvin Minsky postawił tę pozycję najsilniej, gdy rzekomo powiedział: "Umysł jest maszyną mięsną". Jednak niektórzy filozofowie trzymają się drugiego poglądu. Najbardziej znanym z nich jest prawdopodobnie brytyjski filozof John R. Lucas. W eseju zatytułowanym "Umysły, maszyny i Godel". Lucas oparł swój argument na dowodzie Kurta Godela, że istnieją pewne prawdziwe stwierdzenia, których nie można udowodnić żadnym systemem mechanicznym, który jest zarówno spójny, jak i zdolny (przynajmniej) do wykonywania arytmetyki. Lucas zakłada, że ludzie (a przynajmniej niektórzy ludzie) mogą "zobaczyć" te stwierdzenia jako prawdziwe, nawet jeśli maszyny nie mogą ich udowodnić. Kilka osób wskazało wady argumentu Lucasa, a Lucas twierdzi, że odpowiedział na przynajmniej niektóre z nich w swojej książce "The Freedom of the Will". W artykule z 1990 r. odczytanym na konferencji w Turing w Brighton Lucas zdaje się osłabiać nieco swoją argumentację.

Zdarza mi się wierzyć, że ludzie podlegają wszystkim ograniczeniom Godelian dotyczącym maszyn, ale to dlatego, że wierzę, że ludzie są maszynami. Lucas nadal kłóci się ze swoim argumentem, ponieważ (sądzę) chciałby wierzyć, że tak nie jest. W każdym razie argument jest dość sterylny, ponieważ tak naprawdę nie ogranicza tego, co AI może potencjalnie zrobić w praktyce. Nawet Lucas przyznał w swoim oryginalnym artykule, że możemy być w stanie "konstruować bardzo, bardzo skomplikowane układy, powiedzmy, zaworów i przekaźników", "który byłby" zdolny do "robienia rzeczy, które uznaliśmy za inteligentne, a nie tylko błędów lub losowych ujęć , ale których nie zaprogramowaliśmy. Ale wtedy przestanie być maszyną. " (Wydaje się, że tutaj próbuje wygrać swój argument, posługując się "maszyną"). Inżynier Mortimer Taube również uważał, że ludzie nie są maszynami. W swojej książce "Computers and Common Sense: The Mit of Thinking Macines" z 1961 r. [rzeciwstawił się wysiłkom zmierzającym do przekonania komputerów, przetłumaczenia języków ludzkich i nauki. Wiele rzeczy, które powiedział, że komputery nie byłyby w stanie zrobić, zostały już zrobione.

Umysł nie jest komputerem

A. Potrzebna jest nowa fizyka

Kilka osób wysunęło argument, że chociaż ludzie mogą być maszynami, inteligencja nie może być wykazywana przez komputery - a przynajmniej nie przez współczesne komputery wykonane z tranzystorów i innych zwykłych komponentów elektromagnetycznych i działające w taki sposób. Brytyjskiego fizyka Sir Roger Penrose′a przekonują Godeliańskie argumenty Lucasa dotyczące ograniczeń komputerów. (Penrose słynie z pracy w fizyce kwantowej, teorii względności, struktury wszechświata i "przechyleń Penrose′a"). On, podobnie jak Lucas, uważa, że komputery nigdy nie byłyby świadome, ani nie miałyby pełnego zakresu ludzkiej inteligencji. Ale Penrose wyobraża sobie, że ograniczenia te dotyczą tylko maszyn opartych na obecnie znanych prawach fizyki. Aby uciec przed ograniczeniami Godela (jak uważa Penrose, że robią to mózgi), twierdzi, że należy się odwołać do nowego rodzaju fizyki - takiej, który obejmuje coś, co nazywa "poprawną grawitacją kwantową". Niestety, prawidłowa grawitacja kwantowa, cokolwiek to jest, pozostaje do odkrycia (lub raczej, wynalezienia). Penrose przedstawia te idee (wraz z bardzo angażującym materiałem na temat fizyka) w dwóch książkach: "Nowy umysł cesarza" i "Shadows of the Mind: A Poszukiwanie brakującej nauki o świadomości". Ja, podobnie jak wielu innych, jestem sceptyczny, że nowa fizyka jest potrzebna do zrealizowania wszystkich ambicji sztucznej inteligencji . (Ale oczywiście jeszcze nie zdawaliśmy sobie z tego sprawy.) Penrose próbuje odpowiedzieć na niektóre krytyki swoich poglądów w swoim artykule "Beyond the Doubting of a Shadow: A Reply to Comments on Shadows of the Mind".

B. Potrzebna jest celowość

Argumentuje to amerykański filozof John Searle ,że procesy obliczeniowe, jakie znamy, nie mają czegoś, co ludzie mają - coś, co on i niektórzy inni filozofowie nazywają "celowością". Celowość ma związek z przypisywaniem "znaczenia" przedmiotom i ich właściwościom. Definicja Searle jest następująca: "Intencjonalność to cecha niektórych stanów mentalnych, poprzez które są one skierowane na lub o przedmiotach i stanach rzeczy na świecie". Na przykład według Searle "przekonania, pragnienia i intencje są stanami umyślnymi". Twierdziłby więc, że jest możliwe do przedstawienia w komputerze wyrażenie "John jest wysoki", powiedzmy jako logiczne wyrażenie, takie jak "G33 (K077)", komputer nie może wiedzieć, że G33 odnosi się do własności "w świecie" "wysokości" ani też, że K077 odnosi się do faktycznego Jana "na świecie". Krótko mówiąc, procesom obliczeniowym brakuje "około"; nie wiedzą, o co chodzi w ich symbolach. Przeciwnie, kiedy ludzie używają słów, wiedzą, o co chodzi w tych słowach. Searle jest znany wśród badaczy i filozofów AI dzięki eksperymentowi myślowemu, który zaproponował na temat "zrozumienia". Nazwano go eksperymentem "Pokój chiński". Searle pisze eksperyment myślowy pisząc : Załóżmy, że jestem zamknięty w pokoju i otrzymałem dużą porcję chińskiego pisma. Przypuśćmy ponadto (jak to jest w istocie), że nie znam chińskiego, ani w mowie, ani w piśmie, i że nawet nie jestem przekonany, że mógłbym rozpoznać chińskie pismo jako chińskie pismo inne niż, powiedzmy, japońskie pismo lub bezsensowne kłótnie. Aby uczynić swój eksperyment istotnym dla sztucznej inteligencji w zakresie "rozumienia historii", Searle wyobraża sobie, że jego pokój zawiera dwie partie chińskich symboli, które nieznane Searle stanowią historię i ogólne informacje o takich historiach. Pokój zawiera również zasady napisane w języku angielskim, dotyczące manipulowania zestawami chińskich znaków i generowania chińskich znaków w wyniku takich manipulacji. Do takiego pokoju przybywa trzecia partia chińskich symboli. Tak jak Searle to ujął, ma w pokoju zasady (napisane po angielsku), które instruują mnie, jak oddawać niektóre chińskie symbole z pewnymi rodzajami kształtów w odpowiedzi na pewne rodzaje kształtów podane mi w trzeciej partii. Nieznani mi ludzie, którzy dają mi wszystkie te symbole, nazywają [pierwsze dwie partie historią i jej podstawowymi informacjami], a trzecią partię nazywają "pytaniami". Co więcej, nazywają symbole, które im oddaję w odpowiedzi na trzecią partię, "odpowiedzi na pytania" oraz zestaw reguł w języku angielskim, które mi dali, nazywają "program". Załóżmy, że po podczas gdy ja tak dobrze postępuję zgodnie z instrukcjami manipulowania chińskimi symbolami, a programiści potrafią tak dobrze pisać programy, że z zewnętrznego punktu widzenia - z punktu widzenia osoby spoza pokoju, w którym jestem zamknięty -moje odpowiedzi na pytania są absolutnie nie do odróżnienia od odpowiedzi rodzimych użytkowników języka chińskiego, nikt, kto patrzy na moje odpowiedzi, nie może powiedzieć, że nie mówię po chińsku.

Pytanie Searle w istocie brzmi: "Czy można powiedzieć, że pokój (zawierający Searle, zasady i serie chińskich symboli)" "rozumie" chiński? Searle twierdzi, że odpowiedź brzmi "nie", ponieważ wszystko, co się dzieje, to "formalna manipulacja symbolami" bez zrozumienia, co oznaczają symbole. Innymi słowy:

"Ponieważ formalne manipulacje symbolami same w sobie nie mają jakakolwiek celowość; są zupełnie bez znaczenia; nie są nawet manipulacjami symbolami, ponieważ symbole niczego nie symbolizują. W żargonie językowym mają tylko składnię, ale nie semantykę. Taka intencjonalność, jaką wydają się mieć komputery, leży wyłącznie w głowach tych, którzy je programują i tych, którzy ich używają, tych, którzy wysyłają dane wejściowe i tych, którzy interpretują dane wyjściowe."

Przyznając, że chiński pokój "symuluje" zrozumienie, rozróżnia symulacje od "prawdziwej". Napisał:

"Nikt nie przypuszcza, że symulacje komputerowe alarmów spowodują spalenie dzielnicy lub że komputerowa symulacja burzy mózgów nas opuści. Dlaczego, u licha, ktoś miałby przypuszczać, że komputerowa symulacja zrozumienia faktycznie coś rozumie? …Do symulacji wszystko czego potrzebujesz to odpowiednie wejście i wyjście oraz program w środku, który przekształca to pierwsze w drugie. To wszystko, co komputer ma do robieniai. Pomylenie symulacji z powielaniem jest tym samym błędem, niezależnie od tego, czy jest to ból, miłość, poznanie, ogień czy burze."

Searle's Chinese Room przypomina mi eksperyment Herba Simona w symulowaniu wykonania programu Logic Theorist (LT). LT zaczęło się od ręcznej symulacji, wykorzystując dzieci Simona jako elementy komputerowe, jednocześnie pisząc i trzymając karty notatek jako rejestry zawierające zmienne stanu programu. Przypuszczalnie dzieci nie wiedziały nic o logice zdań, ale cały zbiór, Simon, dzieci i kartki z notatkami, okazały się twierdzeniem. Najwyraźniej "symulowanie" dowodu twierdzenia jest w zasadzie takie samo jak dowodzenie twierdzenia - tak jak symulowanie dodawania jest tym samym co dodawanie. Czy to możliwe, że symulowanie zrozumienia jest tak samo jak prawdziwe zrozumienie? Istnieje kilka możliwych odpowiedzi na argumenty Searle i nie brakuje odpowiedzi! W swoim artykule Searle przewiduje wiele potencjalnych odpowiedzi, a dwadzieścia osiem faktycznych odpowiedzi zostało opublikowanych wraz z oryginalną pracą Searle. Oto, co myślę: wyobraźmy sobie, że możemy zajrzeć do mózgu Searle′a, gdy jest on w stanie zrozumieć pytanie zadane mu po angielsku. Są przypuszczalnie tryliony synaps zaangażowanych w pierścienie i hamujących miliardy neuronów w skoordynowanym wysiłku, aby zrozumieć sens pytania oraz skomponować i udzielić odpowiedzi. Nie twierdzilibyśmy, że jakakolwiek pojedyncza synapsa ani połączone przez nią neurony rozumieją angielski. Proces "zrozumienia" nie jest pojęciem mającym znaczenie na poziomie szczegółowości odpowiednim do analizy działania neuronów. Analogicznie proces dowodzenia twierdzenia przez komputer (lub przez dzieci Simona) nie jest pojęciem znaczącym na poziomie pojedynczych tranzystorów (lub dzieci posiadających karty do notatek). Wyjaśniając zjawiska, mózgu lub komputerów (lub czegokolwiek innego), używamy pojęć dopasowanych do poziomu wyjaśnienia. Pojęcie "zrozumienia" jest pojęciem, które przydałoby się zastosować do działań mentalnych oglądanych na poziomie "całej osoby", a nie na poziomie komórek nerwowych. Podobnie, moim zdaniem, użyteczne byłoby stwierdzenie, że zestawienie pokoju, Searle, zasad i chińskich znaków rozumie chiński. Ale co z sensem i celowością? Jeśli piszemy G33 (K077) w pamięci komputera, czy to "coś" znaczy? Zależy to od tego, co jeszcze jest w pamięci komputera - szczególnie co jeszcze w pamięci jest powiązane z symbolami G33 i K077. Symbole i powiązania między nimi tworzą sieć, a cała sieć zawiera znaczenia. Przypomnij sobie pytanie, na które M. Ross Quillian próbował odpowiedzieć w swojej rozprawie z 1966 r., A mianowicie: "Jakiego rodzaju format reprezentacji może pozwolić na przechowywane znaczenie słów , aby możliwe było ludzkie użycie tych znaczeń? ".

Według Quillian znaczenie terminu jest reprezentowane przez jego miejsce w sieci i sposób połączenia z innymi warunkami. To ten sam pomysł stosuje się w słownikach, w których znaczenie słowa jest podane przez odniesienie do związku tego słowa z innymi słowami. Znaczenie tych innych słów jest z kolei nadawane przez ich relacje z innymi słowami. Możemy więc myśleć o słowniku jako o dużej sieci semantycznej słów powiązanych z innymi słowami. W niektórych przypadkach konieczne jest także połączenie symboli sieci z rzeczywistymi obiektami na świecie za pośrednictwem urządzeń sensorycznych i motorycznych komputera. Newell i Simon przewidzieli tę potrzebę w swoim artykule na temat hipotezy o fizycznym systemie symboli (PSSH). Hipoteza ta głosi, że fizyczny system symboli (taki jak komputer) ma niezbędne i wystarczające warunki dla inteligentnego zachowania. Newell i Simon napisali: "Fizyczny system symboli to maszyna, która z czasem wytwarza ewoluujący zbiór struktur symboli. Taki system istnieje w świecie przedmiotów szerszych niż same symboliczne wyrażenia."

Oto definicja Newella i Simona: "Wyrażenie [złożone z symboli] oznacza obiekt, jeśli biorąc pod uwagę wyrażenie, system może albo wpływać na sam obiekt, albo zachowywać się w sposób zależny od obiektu". Uważam więc, że Searle jest po prostu zdezorientowany kilkoma podstawowymi ideami w informatyce. Chociaż nie zostało jeszcze ustalone empirycznie, że komputer (manipulujący symbolami i dołączany w razie potrzeby do jego środowiska) może być wykonany w taki sposób, aby wykazywał wszystkie aspekty inteligentnego zachowania, do których zdolni są ludzie, nie wierzę, że eksperyment myślowy Searle wątpić w możliwość. Searle sam uważa, że niektóre systemy fizyczne mogą być inteligentne i rozumieć różne rzeczy. Uważa, że ludzie są jednym z takich systemów. Napisał następująco:

"Czy maszyna może myśleć?"

Odpowiedź brzmi: tak. Jesteśmy właśnie takimi maszynami.

"Tak, ale czy artefakt, sztuczna maszyna mogła myśleć?"

Zakładając, że możliwe jest sztuczne wyprodukowanie maszyny z układem nerwowym, neurony z aksonami i dendrytami i całą reszt z tego, tak jak nasza mózg. ponownie wydaje się, że odpowiedź na to pytanie brzmi oczywiście, tak.

Searle nie daje nam jednak pojęcia, co składa się na neurony mózgu , to jest inne niż komputery, złożone z tranzystorów, które nadają temu pierwszemu, ale nie drugiemu, celowość. Twierdzi, że aby maszyna mogła myśleć, że musiałaby mieć "wewnętrzne moce przyczynowe" równoważne z mocami mózgu. Nie mówi tylko, czym mogą być te wewnętrzne siły przyczynowe.

C. Silna i słaba AI

W pracy Searle′a zdefiniowano definicje "silnej AI "i "słabej AI", które są przydatne do rozróżnienia dwóch rodzajów działań AI. Silna sztuczna inteligencja wiąże się z twierdzeniem, że odpowiednio zaprogramowany komputer może być umysłem i może myśleć tak samo dobrze jak ludzie. Osiągnięcie silnej AI jest ostatecznym celem wielu badaczy sztucznej inteligencji. Artykuł Searle próbuje pokazać, że silna sztuczna inteligencja (przy użyciu komputerów) jest niemożliwa. Jednak praktykujący słabą (lub ostrożną) sztuczną inteligencję używają programów jako narzędzia do badania umysłu poprzez formułowanie i testowanie hipotez na jego temat. Słaba sztuczna inteligencja wiąże się również z próbami tworzenia programów, które pomagają, a nie duplikaty ludzkich działań umysłowych. Słaba sztuczna inteligencja była już (i nadal odnosi) sukcesy, podczas gdy poszukiwanie silnej sztucznej inteligencji będzie bez wątpienia trwało dość długo.

D. Potrzebne są "procesy globalne"

Hubert L. Dreyfus profesor filozofii na Uniwersytecie Kalifornijskim w Berkeley, rozpoczął karierę nauczyciela filozofii na MIT. Najpierw spotkał się tam z przedsięwzięciem AI, a na początku lat 60. wraz z bratem Stuartem wziął udział w rozmowie z autorem Herbem Simonem. Kilka rzeczy na temat sztucznej inteligencji i tego, co usłyszeli podczas rozmowy, potęgowało braci Dreyfus. Mniej więcej w tym czasie RAND Corporation w Santa Monica w Kalifornii pomyślała, że posiadanie na pokładzie filozofa wraz z komputerowcami byłoby dobrym pomysłem. Stuart, specjalista od badań operacyjnych, który pracował w RAND, polecił Huberta. Tak więc Hubert spędził lato 1961 r. w RAND jako konsultant badający badania nad sztuczną inteligencją. Krótko po lecie Hubert napisał artykuł zatytułowany "Alchemia i sztuczna inteligencja", w którym między innymi doszedł do wniosku, że ostateczne cele badań nad AI są równie nieosiągalne, jak cele alchemii. W swojej pracy Dreyfus ocenił postęp AI w czterech obszarach, a mianowicie: granie w gry, rozwiązywanie problemów (w tym dowodzenie twierdzeń), tłumaczenie języka i rozpoznawanie wzorców.Napisał:

"Kształtuje się ogólny wzorzec: wczesny, dramatyczny sukces oparty na łatwości wykonywania prostych zadań lub niskiej jakości pracy nad złożonymi zadaniami, a następnie malejące zwroty, rozczarowanie, aw niektórych przypadkach pesymizm. Twierdził, że typowym przypadkiem była maszyna do dowodzenia twierdzeń geometrycznych Gelerntera: Nie ma bardziej uderzającego przykładu "zadziwiającego" wczesnego sukcesu i równie zadziwiającego niepowodzenia w jego realizacji. "I odpowiadając na twierdzenie AI, że poczyniono postępy, napisał . Zgodnie z tą definicją [postępu], pierwszy człowiek, który wspiął się na drzewo, mógł domagać się namacalnego postępu w walce na księżyc ".

Według Dreyfusa jednym z powodów tej stagnacji było to, że badania nad sztuczną inteligencją opierają się na założeniu, że myślenie może być analizowane jako niezliczony zestaw prostych, określonych operacji (takich jak zastosowanie reguł do niezliczonego zestawu danych). Twierdził, że "myślenie obejmuje procesy globalne, których nie można zrozumieć w kategoriach sekwencji lub nawet równoległego zestawu dyskretnych kroków." Te procesy globalne manifestują się na trzy sposoby. Pierwszy to "skrajna świadomość", mózg korzysta z dostępu do nieskończonych "otwartych informacji charakterystycznych dla codziennych doświadczeń". Świadomość poboczna pozwala ludziom jednocześnie rozważać szczegóły i duży obraz. Kolejny globalny proces działa w ludzkim myśleniu, kiedy odróżniamy to, co istotne, od tego, co nieistotne. Trzeci to "kontekst globalny", który pozwala nam zmniejszyć dwuznaczność. Połączenie tych umiejętności pozwala na to, co nazywa "pogrupowanym grupowaniem" - co robi mózg, gdy rozpoznaje złożone wzorce, takie jak na przykład ludzkie twarze. Dreyfus twierdził, że programy komputerowe nie są w stanie zastosować tych globalnych procesów, które są niezbędne dla inteligentnego zachowania. Dreyfus stwierdził, że mózg przetwarza informacje w zupełnie inny sposób. Napisał, że informacje w mózgu są "przetwarzane globalnie, tak jak analog rezystorowy [rodzaj komputera analogowego] rozwiązuje problem minimalnej ścieżki przez sieć". Ponadto powiedział, że "ciało odgrywa kluczową rolę w możliwym inteligentnym zachowaniu. "Kilka innych osób podkreśliło znaczenie "ucieleśnienia" dla postępu w sztucznej inteligencji, a wkrótce będę miał więcej do powiedzenia na ten temat przyszłości (jak sądzono na początku lat 60.), Dreyfus napisał, że tylko eksperymenty mogą określić, w jakim stopniu nowsze i szybsze maszyny, lepsze języki programowania i sprytna heurystyka mogą nadal przesuwać granice. Niemniej jednak dramatyczne spowolnienie w obszarach, które mamy i ogólne niepowodzenie w wypełnianiu wcześniejszych prognoz sugeruje, że granica może być już blisko. Nie należy przyjmować komentarzy Dreyfusa na temat sztucznej inteligencji, które sugerują, że uważał, iż sztuczna inteligencja na poziomie ludzkim jest niemożliwa - po prostu myślał (i wciąż myśli) niemożliwe jest zastosowanie metod, które filozof John Haugeland nazwał "dobrą staroświecką sztuczną inteligencją" (GOFAI), a mianowicie taką, która wykorzystuje wyszukiwanie heurystyczne i dyskrecję e zbiory symbolicznie reprezentowanych faktów i zasad. Przyznał, że w zasadzie "moglibyśmy symulować inteligentne zachowanie, gdybyśmy mogli zbudować lub symulować urządzenie, które funkcjonowało dokładnie tak, jak ludzki mózg. "Ale pomyślał, że takiej symulacji nie da się zrealizować w praktyce." Nie znamy równań opisujących fizyczne procesy w mózgu, a nawet gdybyśmy to zrobili, on równania opisujące najprostszą reakcję zajęłyby zbyt dużo czasu. "Podsumowanie jego pracy zakończyło się" Znaczący rozwój sztucznej inteligencji musi czekać na zupełnie inny rodzaj komputera. Jedynym istniejącym prototypem jest mało zrozumiały ludzki mózg."Główne idee jego artykułu RAND zostały przedstawione i rozwinięte w kilku książkach i artykułach Dreyfusa. Książka Pameli McCorduck, Machines Who Think, ma doskonały rozdział o Dreyfusie, wyszczególniając jego argumenty i dość kontrowersyjne interakcje między nim a naukowcami AI. Ponieważ tak dobrze omawia tę kwestię, skoncentruję się na jego pomysłach na temat potrzeby "ucieleśnienia", jak opisano w kilku jego ostatnich artykułach

E. Potrzebne jest "bycie tam"

Myślę, że główną kwestią Dreyfusa jest to, że inteligencja u ludzi wywodzi się z ich "bycia w świecie", a nie dlatego, że kierują nimi reguły. Stosowanie reguł w programach AI (tak jak u ludzi) może pozwolić na zachowanie właściwe, ale nie zachowanie eksperckie. Oto kilka fragmentów adresu, który Dreyfus podał w 2005 roku:

"…w naszych formalnych instrukcjach zaczynamy od zasad. Zasady, wydaje się jednak, że ustępują miejsca bardziej elastycznym reakcjom, gdy się stajemy wykwalifikowani … Faktyczne zjawisko sugeruje, że aby zostać ekspertami, musimy przejść z oderwania od przestrzegania zasad na więcej zaangażowany i specyficzny dla danej sytuacji sposób radzenia sobie. …Ogólnie rzecz biorąc, zamiast polegać na zasadach i standardach do podjęcia decyzji lub w celu uzasadnienia swoich działań ekspert natychmiast reaguje na aktualną konkretną sytuację…"

.

"Systemy eksperckie" oparte na zasadach, tak zwanych inżynierów wiedzy pozyskiwanych od ekspertów, były w najlepszym wypadku kompetentne. Wydaje się, że zamiast używać reguł, których już nie pamiętali, jak przypuszczali badacze AI, eksperci zostali zmuszeni do zapamiętania reguł, których już nie używali. Rzeczywiście, o ile ktokolwiek mógł powiedzieć, eksperci w ogóle nie przestrzegali żadnych zasad. Według Dreyfusa przejście od zwyczajnie kompetentnego zachowania do zachowania eksperckiego wymaga "bycia w świecie" poprzez posiadanie ciała osadzonego w świecie. Ucieleśnieni agenci, tacy jak ludzie, "mogą mieszkać na świecie w taki sposób, aby uniknąć nieskończonego zadania sformalizowania wszystkiego" (jak bezskutecznie próbują to robić programy AI). Pogląd Dreyfusa na tę potrzebę ucieleśnienia opiera się na filii szkoły filozoficznej zwanej "fenomenologią". Dreyfus napisał, że fenomenologia egzystencjalna Martina Heideggera, która podkreśla "nasze praktyczne zaangażowanie w ludzi i rzeczy jako nasz podstawowy sposób bycia", jest podstawą jego krytyki GOFAI. Twierdzi, że aby AI mogła odnieść sukces, potrzebowałaby modelu naszego szczególnego sposobu bycia osadzonym i wcielonym, tak że to, czego doświadczamy, jest dla nas znaczące w szczególny sposób, w jaki jest. Oznacza to, że musielibyśmy uwzględnić w naszym programie model ciała bardzo podobnego do naszego z naszymi potrzebami, pragnieniami, przyjemnościami, bólami, sposobami poruszania się, pochodzeniem kulturowym itp. Inni opowiadający się za ucieleśnieniem wskazują, że niektóre "obliczenia" potrzebne inteligentnemu agentowi można by osiągnąć dzięki dynamicznym interakcjom między częściami jego ciała a otoczeniem. Na przykład Rolf Pfeifer, Max Lungarella i Fumiya Iida napisali: "Wcielona perspektywa, ponieważ dzieli kontrolę i przetwarzanie na wszystkie aspekty czynnika (jego centralny układ nerwowy, właściwości materiałowe układu mięśniowo-szkieletowego, morfologia czujnika, oraz interakcja ze środowiskiem), stanowi alternatywną drogę do zmierzenia się z wyzwaniami, przed którymi stoi robotyka. Zadania kontrolera w klasycznym podejściu są teraz częściowo przejmowane przez morfologię i materiały w procesie samoorganizacji…" Ale nawet gdyby ciało było potrzebne, jego forma wydaje się zależeć od tego do czego powiązany system AI jest używany. Korpusem HAL 9000 był cały sterowany przez niego statek kosmiczny. Wstrząsający robot miał ciało, które najwyraźniej było odpowiednie do jego potrzeb. Gdyby kiedykolwiek powstał "konwersacyjny Google", który mógłby prowadzić dialog z użytkownikami na temat zawartości wszystkich stron internetowych, jego "ciałem" byłby cały Internet i procedury potrzebne do uzyskania do niego dostępu.

Różnice między mózgami a komputerami

Oprócz Dreyfusa kilku krytyków sztucznej inteligencji zwróciło uwagę, że "mózg nie jest komputerem", a zatem ludzie, którzy próbują zrobić z komputerem to, co potrafi mózg, muszą się koniecznie zawieść. Krytycy ci często podkreślają takie rozróżnienia, jak następujący:

• Komputery mają prawdopodobnie setki jednostek przetwarzających, podczas gdy mózgi mają tryliony.

• Komputery wykonują miliardy operacji na sekundę, podczas gdy mózgi potrzebują tylko tysięcy.

• Komputer ulega awariom, a mózgi są odporne na awarie.

• Komputery używają sygnałów binarnych, podczas gdy mózgi działają z analogowymi.

• Komputery robią tylko to, co nakazują im programiści, a mózgi są kreatywne.

• Komputery wykonują szeregowe operacje, podczas gdy mózgi są masowo równolegle.

• Komputery muszą być logiczne, podczas gdy mózg może być "intuicyjny."

• Komputery są zaprogramowane, a mózg się uczy.

Oprócz tego, że wiele z tych rozróżnień nie jest już aktualnych, porównania zależą od tego, co rozumie się przez "mózg", a co przez "komputer". Jeśli nasze rozumienie mózgu dotyczy neuronów składowych, ich gazillionów aksonów, dendrytów i połączeń synaptycznych, i jeśli rozumiemy komputer w kategoriach szeregowych, operacja "styl von Neumanna" -czytanie, przetwarzanie i pisanie bitów - wszystko to odbywa się za pomocą obwodów tranzystorowych, no cóż, oczywiście mózg nie jest tego rodzaju komputerem. Nie rozumiemy jednak "obliczeń" przez odniesienie tylko do niskiego poziomu, von Neumann - opis stylu. Możemy to zrozumieć na jednym z wielu poziomów opisu. Na przykład obliczenia mogą być rozumiane jako bardzo duża liczba jednocześnie aktywnych "źródeł wiedzy " asynchronicznie odczytujących, przekształcających i zapisujących złożone wyrażenia symboliczne na " Tablicy" lub jako zbiór demonów przetwarzających symbole i sieci neuronowych ułożonych w Sieć w stylu pandemonium. Być może nasze stopniowo rosnące zrozumienie działania mózgu doprowadzi nawet do innych użytecznych modeli obliczeniowych. Pomysły na temat tego, czym może być "obliczanie" stale się rozwijają, więc ci, którzy twierdzą, że mózg nie jest komputerem, będą potrzebować ściślej mówiąc o tym, jakim komputerem nie jest mózg. (W końcu, jeśli niektórzy ludzie, na przykład Lucas, mogą ograniczać to, czym może być maszyna, wydaje się sprawiedliwe, że inni mogą rozszerzyć definicję tego, co komputer może być.)

Ale czy powinniśmy?

Oprócz krytyki sztucznej inteligencji opartej na tym, co ludzie twierdzą, że nie może tego zrobić, istnieją również krytyki oparte na tym, co ludzie twierdzą, że nie powinna tego robić. Niektóre osoby "nie powinny" wspominać o niewłaściwości maszyn próbujących wykonywać zadania, które są z natury skoncentrowane na człowieku, takich jak nauczanie, doradztwo i wydawanie opinii sądowych. Inni, jak wspomniani wcześniej Computer Professionals for Social Responsibility, nie chcą widzieć technologii sztucznej inteligencji (ani żadnej innej technologii w tym zakresie) wykorzystywanej w działaniach wojennych, w inwigilacji lub do zadań wymagających ludzkiej oceny opartej na doświadczeniu. Ponadto są tacy, którzy, podobnie jak luddyści z XIX wieku w Wielkiej Brytanii, martwią się o maszyny zastępujące ludzi, a tym samym powodujące bezrobocie i dyslokacja gospodarcza. Wreszcie, są tacy, którzy obawiają się, że sztuczna inteligencja i inne technologie komputerowe odczłowieczą ludzi, zmniejszą potrzebę kontaktów międzyludzkich i zmienią to, co znaczy być człowiekiem. Joseph Weizenbaum, człowiek, który napisał program ELIZA, pisał i wykładał na temat niebezpieczeństw związanych z powierzeniem komputerom obowiązków, które jego zdaniem powinny zostać pozostawione ludziom. Niektórzy twierdzą, że powodem jego niepokoju był fakt, że był zaskoczony i zszokowany faktem, że niektórzy ludzie mylili rozmowy z ELIZĄ z rozmowami z prawdziwą osobą. W swojej książce "Computer Power and Human Reason: From Judgement to Calculation" Weizenbaum argumentował, że "istnieje różnica między człowiekiem a maszyną, i istnieją pewne zadania, których nie należy wykonywać, niezależnie od tego, czy komputery mogą być W swojej książce Weizenbaum podkreślił znaczenie środowiska kulturowego, w którym człowiek dorasta, żyje i pracuje. Żadna maszyna nie doświadcza (ani nie mogłaby doświadczyć) pochodzenia ludzkiego, dlatego żadna maszyna nie powinna być dozwolona podejmować takie decyzje lub udzielać porad, które wymagają między innymi współczucia i mądrości wywołanej przez takie tło. Podkreśla ten punkt, mówiąc, że brak doświadczenia w tych "domenach myśli i działania" dotyczyłby również "sposobu, w jaki ludzie odnoszą się do siebie nawzajem, a także maszyn i ich relacji z człowiekiem". Tak więc, przypuszczam, że pomyślałby, że podobnie jak niewłaściwe byłoby, aby maszyna podejmowała decyzje sądowe, tak samo byłoby niewłaściwe, gdyby osoba wychowana w Ameryce podejmowała decyzje sądowe w Japonii. Co więcej, wyśmiewa pomysł, że maszyna może uzyskać niezbędne tło, nadając jej ludzkie ciało i aparat sensoryczny. Napisał, że "najgłębsza i najwspanialsza fantazja, która motywuje pracę nad sztuczną inteligencją ... …to nic innego jak zbudowanie maszyny na wzór człowieka, robota, który ma mieć dzieciństwo, uczyć się języka jak dziecko. , aby zdobyć wiedzę o świecie, wykrywając świat za pomocą własnych organów, a ostatecznie kontemplować całą domenę ludzkiej myśli ". Weizenbaum wraz z rodziną uciekł z nazistowskich Niemiec w 1936 roku. Doświadczenie to nie mogło wyostrzyć jego silnego poczucia odpowiedzialności społecznej. Napisał na przykład, że.

"Samo pytanie: "Co sędzia (lub psychiatra) wie, że nie możemy powiedzieć komputerowi?" jest potworną nieprzyzwoitością. To, że w ogóle musi zostać wydrukowane, nawet w celu ujawnienia swojej chorobowości, jest oznaką szaleństwa naszych czasów.

…

[Odpowiednie kwestie] nie mogą zostać rozwiązane poprzez zadawanie pytań zaczynających się od "może". Granice stosowalności komputerów są ostatecznie możliwe do ustalenia tylko w kategoriach. Najbardziej elementarnym wglądem jest to, że skoro nie mamy obecnie sposobów na uczynienie komputerów mądrzejszymi, nie powinniśmy teraz powierzać komputerom zadań wymagających mądrości."

Mimo że Weizenbaum ma trochę wątpliwości co do pytania "może", uważam, że naprawdę wierzył, że maszyny "nie mogą" tak jak "nie powinny". Bo jeśli maszyny naprawdę potrafią osądzać z całym "współczuciem i mądrością", z jaką ludzie mogą, dlaczego nie mieliby tego robić? Oprócz obaw związanych z wykorzystaniem jakiejkolwiek technologii do celów aspołecznych (takich jak wojna), prawdziwym zagrożeniem, jak sądzę, jest przedwczesne użycie maszyn: myślenie, że są w stanie wykonać zadanie, zanim naprawdę będą w stanie to zrobić. Inną osobą, która cofnęła się przed perspektywą "przejęcia" maszyn, jest lekarz, biolog i eseista Lewis Thomas. W jednej z jego słynnych kolumn "Notes of a Biology-Watcher" w The New England Journal of Medicine napisał

Najgłębiej przygnębiające ze wszystkich pomysłów na przyszłość gatunku ludzkegoi jest pojęcie sztucznej inteligencji. Ambicja że ludzie ostatecznie zakończą swój sukces jako ewolucyjny nadzorca produkujący komputery o takiej złożoności i pomysłowości, by być mądrzejszym niż są i że te urządzenia przejmą i poprowadzą miejsce ludzkiej poprawy, a może później, dla ulepszenia maszyny, uderza głęboko w błąd, może nawet zło.

&hellip

O tym mówią ludzie o sztucznej inteligencji: mechaniczny mózg ze zdolnością do spojrzenia w przeszłość i dokonania dokładnych prognoz dotyczących przyszłości, a następnie rozłożenia okropnych planów zmiany tej przyszłości w dowolny sposób i większość przerażająca wszystkich, zdolne do poczucia, że coś robią.

…

Moim zdaniem jest to absolutnie ohydna perspektywa, a gdybym myślał, że to naprawdę coś nieuchronnie czeka przed nami, spędziłbym cały dzień na proteście. "

Chociaż było wielu innych autorów, którzy ostrzegali przed niebezpieczeństwem niewłaściwego korzystania z komputerów w ogóle, a zwłaszcza z inteligentnych maszyn, wspomnę jeszcze o jednym, samozwańczym "neo-luddycie". Theodore Roszak jest wybitnym pisarzem i myślicielem społecznym - w swojej książce The Cult of Information , stwierdził, że rosnący kult, zauroczony "informacją" i "przetwarzaniem informacji", ma wyniszczające skutki kulturowe - "zwłaszcza jeśli chodzi o nauczanie młodzieży". Roszak napisał, że jest "sprzymierzeńcem wszystkich poważnych studentów i użytkowników technologii informatycznych, którzy mają racjonalnie zrównoważony pogląd na to, co komputery mogą, a czego nie powinne", ale twierdzi, że "tworzy tajemnicę informacji [uniemożliwił] podstawowe intelektualne rozróżnienie między danymi, wiedzą, osądem, wyobraźnią, wglądem i mądrością ". Twierdził, że istnieje "istotna różnica" między przetwarzaniem informacji a myśleniem. Ponieważ zdolność [komputera] do przechowywania danych w pewnym stopniu odpowiada temu, co nazywamy pamięcią u ludzi, oraz ponieważ zdolność do przestrzegania logicznych procedur w pewnym stopniu odpowiada temu, co nazywamy rozumowaniem u ludzi, wielu członków kultu [informacji] doszedłem do wniosku, że niektóre komputery działają nieco odpowiadając temu, co nazywamy myśleniem. Roszak konkluduje jednak, że komputery nie mogą tak naprawdę "myśleć". Niebezpieczeństwo polega na tym, że ci, którzy zostaną przekonani (lub oszukani w przekonaniue), że mogą niewłaściwie wykorzystywać komputery w zadaniach wymagających myślenia, a nie tylko "przetwarzania danych". Uważam, że Roszak ma tutaj uzasadnioną troskę - nie jestem jeszcze w stanie wykonać wszystkich zadań, do których moglibyśmy się starać. Ale Roszak również napisał. Nie ma możliwości, aby komputery kiedykolwiek dorównały lub zastąpiły umysł, z wyjątkiem tych ograniczonych funkcjonalnych aplikacji, które wymagają przetwarzania danych i myślenia proceduralnego. Zasadniczo wyklucza się taką możliwość, ponieważ założenia metafizyczne leżące u podstaw wysiłku są fałszywe. Tutaj się nie zgadzam. Nie znam żadnych "metafizycznych założeń" sztucznej inteligencji poza tym, że mózg jest rodzajem maszyny i dlatego powinniśmy być w stanie to zrozumieć i zbudować coś, co działa bardzo podobnie. Ponadto nie znam wiarygodnych dowodów na to, że to metafizyczne założenie jest fałszywe. Chociaż nie uważa, że komputery mogą stać się umysłami, martwi się dodatkowym niebezpieczeństwem, że "możliwe jest odkupienie umysłu i jego zastosowań w sposób, który może być naśladowany przez maszynę. Następnie mamy mechaniczną karykaturę, która wyrównuje aktywność w dół na niższy standard ". Roszak ma co najmniej dwie dobre rzeczy do powiedzenia na temat AI - jedną negatywną, a drugą pozytywną. Jeśli chodzi o wynik ujemny, mówi. Istnieje ironiczna, ale bardzo cenna jakość AI we wszystkich jej postaciach. Wysiłek, aby symulować lub przewyższyć ludzką inteligencję, odkrywa subtelności i paradoksy dotyczące ludzkiego umysłu, których moglibyśmy sobie nie wyobrazić. Poprzez heroiczne niepowodzenia AI uczy nas, jak naprawdę dziwna jest prawdziwa inteligencja. Z jednej strony pozytywnie komentuje, że jedno z AI poczyniło znaczący postęp. Często, pytając specjalistów o ich pracę, programiści mogą wypróbować procedury, założenia, wartości, które następnie można formalnie określić. Rezultatem jest system ekspercki, jedno z niewielu praktycznych zastosowań sztucznej inteligencji. Edward Feigenbaum uważa takie systemy za bramę do następnej ery inteligencji maszynowej; nazywa to "przetwarzaniem wiedzy", a nie zwykłym przetwarzaniem danych. Cokolwiek rozumie przez "wiedzę", z pewnością stanowi bardziej złożone podejście do myślenia niż kiedyś w tej dziedzinie.

Inne opinie

Informatyk Donald Knuth napisał, że jest zaintrygowany, że sztucznej inteligencji udało się do tej pory zrobić zasadniczo wszystko, co wymaga "myślenia", ale nie udało się zrobić większości tego, co ludzie i zwierzęta robią bez myślenia "- że , jakoś jest o wiele trudniejsze! Wierzę, że wiedza zdobyta podczas tworzenia programów AI jest ważniejsza niż korzystanie z programów .John R. Pierce, stwierdził, że w odniesieniu do sztucznej inteligencji, pasuje hasło: "Sztuczna inteligencja to prawdziwa głupota".

…

Nie lubię sztucznej inteligencji, ponieważ uważam, że jest niesprawiedliwa dla komputerów. Ale potem ludzie sztucznej inteligencji opracowali LISP, co jest całkiem dobre. List nie rozwinął się ani w tym sloganie, ani dlaczego AI jest "niesprawiedliwe wobec komputerów" ". Holenderski informatyk Edsger W. Dijkstra słynął z wielu innowacji w informatyce, w tym z algorytmu wyszukiwania najkrótszych (lub najtańszych) ścieżek na wykresach. Popierał także tak zwane "programowanie strukturalne", metodologię, która znacznie poprawiła efektywność pisania (i rozumienia) programów. Napisał do sztucznej inteligencji, która argumentuje: "Ale my jesteśmy tylko maszynami do manipulacji symbolami, prawda?" można tylko odpowiedzieć: "Nie ma tak ślepych jak ci, którzy nie zobaczą!" Analogia jest tak płytka, że można ją opisać jako typowo średniowieczne myślenie.

Oprócz obaw o "zawyżone twierdzenia AI", wielu naukowcyów uważa AI za rodzaj "pobocznej aktywności", która nie była zgodna z rygorystycznymi standardami naukowymi i dziedziną, w której żyli szarlatani. Jeden z badaczy ostrzegł przed przyłączeniem się do badań nad sieciami neuronowymi. Twierdził, że takie badania były przedwczesne. Oawy związane z "szacunkiem" wywarły oszałamiający wpływ na niektórych badaczy AI. Słyszę, jak mówią: być krytykowanym za jego lotność. Teraz, gdy poczyniliśmy znaczne postępy, nie ryzykujmy utraty szacunku ". Jednym z rezultatów tego konserwatyzmu była zwiększona koncentracja na "słabej AI" - odmianie poświęconej dostarczaniu pomocy ludzkiej myśli - i z dala od "silnej AI" - odmianie, która próbuje zmechanizować inteligencję na poziomie ludzkim. To szkoda, ponieważ chociaż uważam, że cele słabej sztucznej inteligencji są ważne i godne, zbudowanie artefaktu naśladującego zdolności ludzkiego mózgu byłoby ogromnym osiągnięciem naukowym - wartym ryzyka, a wcale nie "nieprzyzwoitością" , "zło", "ohydne" ani "co do zasady niemożliwe".

Problemy skali

Wybuch kombinatoryczny

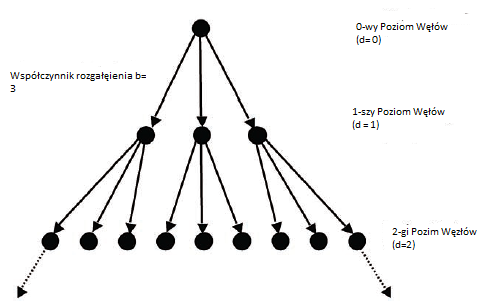

Ponieważ wyszukiwanie odgrywa tak istotną rolę w sztucznej inteligencji, ważne jest, aby powiedzieć coś o tym, jak niezwykle trudne mogą być problemy z wyszukiwaniem. Typowym problemem wyszukiwania jest zwykle rzucanie "drzewa" węzłów, takich jak drzewo gry w warcaby Arthura Samuela lub drzewo wyszukiwania z przesuwanymi kafelkami (osiem puzzli). Na przykład, jeśli każdy węzeł w drzewie wyszukiwania ma trzy możliwe "potomne" węzły (to znaczy "współczynnik rozgałęzienia" wynoszący 3), górna część drzewa wyglądało by to tak

"Pierwszy poziom" drzewa ma trzy węzły, drugi ma dziewięć węzłów i tak dalej. W ogólnym przypadku dla drzewa ze współczynnikiem rozgałęzienia b poziom d-ty miałby węzły bd (to znaczy b pomnożone przez siebie d razy). Całkowita liczba węzłów, które wygenerowałby proces wyszukiwania, gdyby wygenerował całe drzewo ze współczynnikiem rozgałęzienia b aż do wszystkich węzłów na poziomie głębokości d włącznie, można obliczyć na b/ (b-1) (bd - 1). Czytelnicy, którzy przypominają swoją algebrę w szkole średniej rozpozna te wyrażenia jako "wykładnicze" funkcje d. Ponieważ liczba węzłów w drzewie wyszukiwania jest funkcją wykładniczą jego głębokości, wyszukiwanie jest nazywane procesem wykładniczym. Gdyby program musiał przeszukać drzewo ze współczynnikiem rozgałęzienia 3 do poziomu głębokości 10, aby znaleźć cel, musiałby wygenerować 88 572 węzłów. Takie liczby były w zakresie możliwości komputerów z lat 60. i 70., więc były w stanie rozwiązać niektóre z prostszych "problemów z zabawkami" AI. Ale bardziej realistyczne problemy obejmowałyby drzewa wyszukiwania o znacznie wyższych czynnikach rozgałęziających, mające cele na znacznie większych poziomach głębokości. Na przykład przeszukanie drzewa ze współczynnikiem rozgałęzienia od 10 do głębokości 20 (drzewo odpowiadające tylko skromnie trudnemu problemowi wyszukiwania) wymagałoby wygenerowania ponad 1020 węzłów, co jest całkiem niemożliwe. (1020 to jeden, po którym następuje 20 zer, czyli 100 miliardów miliardów). Trudność takich wyszukiwań ma dwa aspekty: czas obliczeniowy i przestrzeń dyskowa. Biorąc pod uwagę tylko chwilę obliczeniową, nawet jeśli moglibyśmy wygenerować miliard węzłów na sekundę (co może być ledwo możliwe do pomyślenia), wygenerowanie drzewa z czynnikiem rozgałęzienia i głębokością zajęłoby 100 miliardów sekund (ponad 3000 lat) właśnie rozważałem. Jeśli chodzi o przestrzeń dyskową, nawet komputery osobiste są obecnie dostępne w dużych ilościach - typowe jest 100 gigabajtów (100 miliardów bajtów). Zakładając, że pojedynczy węzeł wymaga około jednego bajtu, wystarczyłoby odpowiednik około miliarda takich komputerów, nawet dla naszego drzewa wyszukiwania o skromnych rozmiarach. Wykładniczy charakter wyszukiwania oznacza, że wraz ze wzrostem rozmiaru problemu (mierzonego albo przez współczynnik rozgałęzienia, albo głębokość drzew wyszukiwania), trudność obliczeniowa potrzebna do rozwiązania problemu drastycznie wzrasta - tworząc tak zwaną eksplozję kombinatoryczną". Oczywiście, nawet wcześni badacze AI wiedzieli o wybuchach kombinatorycznych. To jest powód ich zainteresowania heurystykami. Niestety heurystyka nie zmienia wykładniczego charakteru poszukiwań - w najlepszym razie redukuje czynnik rozgałęziający. "Eksplozja" wciąż się zdarza {po prostu nie dość szybko. Na przykład zmniejszenie współczynnika rozgałęzienia z 10 do 4 i ponowne przeszukanie do głębokości 20. nadal wymagałoby wygenerowania ponad 420 lub, z grubsza, jednego biliona węzłów. Krytycy AI skupili się na tym problemie w swoich pesymistycznych ocenach AI osiągnięcia i perspektywy. Na przykład Sir James Lighthill (w swoim raporcie, o którym wspomniałem w rozdziale 16), napisał, że "jedna raczej ogólna przyczyna [AI] di spotkania, których doświadczyliśmy [to] brak rozpoznania konsekwencji wybuchu kombinatorycznego."Raport Lighthilla spowodował, jak już wspomniałem, trudności w finansowaniu badań nad AI w Wielkiej Brytanii.

Teoria złożoności

Badacze AI nie są jedynymi ludźmi, którzy są zaniepokojeni obliczeniową trudnością rozwiązywania problemów. Dział informatyki zwany "teorią złożoności" zajmuje się tym, ile czasu i ile miejsca w pamięci mogą zająć różne programy (w najgorszym przypadku), aby rozwiązać różne rodzaje problemów. Pytają między innymi: "Jak rozmiar problemu wpływa na czas i przestrzeń potrzebne do jego rozwiązania?" Spójrzmy na kilka przykładów. Czas, jaki zajęłoby programowi komputerowemu znalezienie największej liczby na liście liczb, jest proporcjonalny do wielkości tego problemu, a mianowicie liczby pozycji na liście. (Najgorszy przypadek miałby miejsce, gdyby największy element był ostatnim elementem na liście; program musiałby wówczas zbadać każdy element na liście.) Mówi się, że taki program zajmuje "czas liniowy". Podobnie program sprawdzający, czy dany element jest członkiem listy elementów, zająłby liniowy czas. (Ponownie najgorsze zdarzenie miałoby miejsce, gdyby element był ostatnim elementem na liście). W obu przypadkach, gdybyśmy podwoili rozmiar, podwoiliśmy wymagany czas. Sortowanie listy nazwisk, na przykład w kolejności alfabetycznej, jest trudniejszym problemem. Programy do sortowania list różnią się pod względem czasu i stopnia skomplikowania w programowaniu. Rozsądnie proste programy sortujące wymagają czasu proporcjonalnego do kwadratu liczby elementów na liście. Oznacza to, że dla tych programów sortowanie listy zawierającej 100 pozycji zajęłoby cztery razy więcej niż lista zawierająca tylko 50 pozycji. (Pomnożenie liczby elementów przez dwa zwiększa czas sortowania o dwa kwadraty lub cztery. Sortowanie może być faktycznie wykonywane szybciej. Istnieją programy, które mogą sortować listę w czasie proporcjonalnym do logarytmu wielkości razy wielkość.) Programy, które może (w najgorszym przypadku) zająć czas proporcjonalny do wielkości problemu, kwadratu, sześcianu lub innych "mocy" wielkości, przebiegać w tak zwanym "czasie wielomianowym". Same problemy można oceniać według złożoności najmniej złożonych programów, które są w stanie je rozwiązać. Na przykład, jeśli istnieje program, który może rozwiązać problem w czasie liniowym, ale żaden nie może go rozwiązać szybciej, wówczas mówi się, że problem ten ma złożoność liniową. "Sprawdzanie, czy lub żaden element nie jest członkiem listy elementów, jest to problem liniowej złożoności. Przez P określamy klasę problemów, które można rozwiązać w czasie wielomianowym. Członkowie tej klasy obejmują obliczanie największego wspólnego dzielnika i ustalanie, czy liczba jest liczbą pierwszą. Niestety, jak już wspomniałem, procedury wyszukiwania stosowane w wielu programach sztucznej inteligencji wymagają czasu działania, który jest wykładniczy pod względem wielkości problemu. Na przykład wyszukiwanie drzewa o współczynniku rozgałęzienia b do głębokości d zajęłoby czas proporcjonalny do bd. Korzystając z mojego poprzedniego przykładu, widzimy, że wyszukiwanie drzewa ze współczynnikiem rozgałęzienia 3 do poziomu głębokości 10 wymaga wygenerowania 88 572 węzłów. Jednak podwojenie głębokości do 20 wymagałoby przeszukania nie czterokrotnie 88 572 węzłów (co miałoby miejsce, gdyby czas wyszukiwania był proporcjonalny do kwadratu głębokości), ale 88 572 x 88 572 lub prawie osiem miliardów węzłów. Złożoność wykładnicza jest znacznie gorsza niż złożoność wielomianowa! Amerykański informatyk Stephen Cook [oraz rosyjski, a teraz amerykański informatyk Leonid Levin] wnieśli znaczący wkład w nasze zrozumienie złożoności problemów i programów zastosowanych do ich rozwiązania. W szczególności Cook (i Levin niezależnie) zdefiniowali klasę zwaną niedeterministycznym wielomianem lub klasą problemów P. Jest to klasa problemów, w przypadku których rozwiązanie potencjalne może zostać sprawdzone (ale niekoniecznie rozwiązane) w czasie wielomianowym. Na przykład proponowaną sekwencję ruchów w celu rozwiązania układanki z przesuwanymi kafelkami można sprawdzić, czy faktycznie rozwiązuje układankę w czasie wielomianowym, ale (o ile wiadomo) znalezienie rozwiązania wymagałoby czasu wykładniczego. Problemy z przesuwanymi płytkami, podobnie jak wiele innych problemów AI, należą do klasy NP. Nie wiadomo, czy mogą istnieć programy wielomianowe do rozwiązywania problemów w klasie NP. Gdyby tak było, NP równałoby się P. Jak dotąd programy rozwiązywania problemów w klasie NP wymagają czasu wykładniczego (w najgorszym przypadku). To, czy NP równa się P, jest jednym z najbardziej znanych nierozwiązanych problemów w informatyce. Wiele osób uważa, że NP nie równa się P, ponieważ w przeciwnym razie doszlibyśmy do tej pory. (Clay Mathematics Institute zaoferował nagrodę w wysokości 1 000 000 $ za rozwiązanie pytania P kontra NP {to znaczy, że są równe lub nie są równe.)

Trzeźwa ocena

Te wyniki w teorii złożoności spowodowały, że niektórzy ludzie mieli poważne wątpliwości co do perspektyw sztucznej inteligencji. Jedną z najbardziej wnikliwych i moim zdaniem inteligentnych ocen napisał matematyk i informatyk Jacob T. Schwartz, o którym wspominałem już w związku ze swoją kadencją w DARPA. W swoim artykule zatytułowanym "Granice sztucznej inteligencji" Schwartz napisał, że niezwykłe moce ludzkiego mózgu wynikają ze sposobu, w jaki wykorzystał swoje ogromne zdolności obliczeniowe i magazynowe "do organizowania informacji prezentowanych w stosunkowo nieuporządkowanej formie w wewnętrznie zorganizowanych strukturach, na których Schwartz twierdził, że wyrafinowane, spójne kierunki symbolicznej i rzeczywistej akcji mogą być oparte. "Aby rywalizować z mózgiem, czego AI potrzebuje i co AI na próżno próbuje osiągnąć, są to" spójne struktury zdolne do bezpośredniego prowadzenia jakiejś formy komputera akcja. . . generowane automatycznie na podstawie stosunkowo niezorganizowanych, rozdrobnionych danych wejściowych. "Zdolność do generowania takich" zorganizowanych struktur "stanowiłaby ogromny przełom, ponieważ komputery są już" niezwykle nadludzkie "w rozwiązywaniu problemów, dla których mogą" zaakceptować, zatrzymać i wykorzystać w pełni ustrukturyzowany materiał. "" Gdyby podstawową przeszkodę wynikającą z konieczności szczegółowego programowania [komputerów] można było pokonać ", napisał," komputery mogłyby spożywać informacje zawarte we wszystkich bibliotekach na świecie i wykorzystywać je z nadludzką skutecznością "(obecnie oczywiście, oprócz bibliotek, w Internecie jest cała informacja i dezinformacja.) Metody, których badacze AI używali do automatycznego tworzenia struktury z fragmentów danych wejściowych, oparte były na wyszukiwaniu heurystycznym - albo na poszukiwaniu logicznych dedukcji, albo na ścieżki w drzewach (i bardziej ogólnie na wykresach). Do odpowiedzi na pytania, w celu dostarczenia exp wykorzystano logiczne dedukcje (między innymi) porady i generowanie programów i planów. Poszukiwania ścieżek na wykresach wykorzystano do udowodnienia twierdzeń w geometrii, do parsowania zdań i do tworzenia planów dla robotów. Wszystko to są przypadki tworzenia struktury (używając terminu Schwartza) z nieustrukturyzowanego

wejścia. Te "sukcesy" zostały jednak osiągnięte albo w przypadku trywialnie małych problemów, albo w przypadku tych, których tematyka była ściśle ograniczona. Niestety, jak słusznie twierdził Schwartz, wszystkie dotychczasowe próby wygenerowania "ogólnie użytecznych struktur symbolicznych z bardziej niezorganizowanych i fragmentarycznych danych wejściowych" niezmiennie zostały pokonane przez kombinatoryczną eksplozję. Podsumował sytuację, powtarzając zarzut Dreyfusa, że "

dotychczasowa historia badań nad sztuczną inteligencją [składała się] zawsze z bardzo ograniczonych sukcesów w poszczególnych obszarach, po czym natychmiast nie udało się osiągnąć szerszych celów, przy których początkowe sukcesy wydają się na początku wskazać… "

Opinie Schwartza na temat AI miały konsekwencje, ponieważ był dyrektorem DARPA ISTO w latach 1987-1998 i przewodniczył pewnym ograniczeniom w badaniach nad AI. Chociaż ogólnie lekceważył pracę AI, Schwartz napisał, że można oczekiwać, że te obszary AI, do których stosuje się klasyczne techniki naukowe i algorytmiczne, będą postępować szybciej niż obszary, które dotyczą głębszych problemów, dla których dostępne są tylko mniej ukierunkowane podejścia "Jako jeden przykład przytoczył problem określania, czy jeden lub więcej obiektów o znanym kształcie poruszających się w środowisku zawierającym przeszkody o innych znanych kształtach może przejść z jednej określonej pozycji do drugiej bez kolizji z przeszkodą lub ze sobą . " Chociaż wyniki teorii złożoności stanowiły jeden z "skoków prędkości" w szybkim postępie AI w przód, badacze AI szybko odzyskali i znaleźli różne sposoby rozwiązania problemu kombinatorycznej eksplozji. Wskazali na przykład, że wyniki złożoności były oparte na wydajności w najgorszym przypadku, a rozwiązania często można znaleźć szybciej niż w najgorszym przypadku. Na przykład wspomnę o pracy Richarda Korfa, badacza AI na University of California w Los Angeles. Korf jest znany ze swojej pracy nad rozwiązywaniem bardzo trudnych problemów wyszukiwania. Często używa przesuwanej płytki i innych łamigłówek jako laboratorium " drosophila" do eksploracji nowych pomysłów w poszukiwaniu. Pamiętasz, że użyłem przykładu układanki z przesuwanymi kafelkami, aby zilustrować heurystyczne procesy wyszukiwania. Ten, którego użyłem, składał się z ośmiu płytek w układzie 3 x 3; klasyczna wersja składa się z piętnastu płytek w układzie 4 x 4. Można sobie wyobrazić większe wersje, takie jak dwadzieścia cztery płytki w układzie 5 x 5. Układanka 4 x 4 stanowi już dość trudny problem dla wyszukiwania heurystycznego. W swoich komentarzach na temat trudności związanych z skalowaniem procesów wyszukiwania Jack Schwartz napisał "wykres stanów [układanki 3 x 3] składa się z 9!, lub 362 880 [węzłów], więc nawet dla tak prostego problemu wyszukiwanie wykresów siłowych zaczyna być obciążające. Dla odpowiednich łamigłówek 4 x 4, których przestrzeń stanu obejmuje 16!, lub więcej niż 10 13 , węzłów, jest to całkowicie niemożliwe do wykonania. "[Właściwie Schwartz był wyłączony przez (nieistotny) czynnik 2 w oba przypadki: od 1879 r. wiadomo, że jeśli zaczniesz od jakiejś konkretnej konfiguracji początkowej, możesz osiągnąć tylko 1/2 wszystkich możliwych konfiguracji. Zatem dla wersji z ośmioma płytkami cały wykres przestrzeni stanów składa się dwóch oddzielnych niepowiązanych wykresów o rozmiarze 9! = 2 = 181; 440.] Jednak Korf nie tylko napisał heurystyczne programy wyszukiwania do rozwiązywania przypadków układanki 4 x 4, ale w streszczeniu artykułu z 1996 roku on i współautor napisał. "Znaleźliśmy pierwsze optymalne rozwiązania dla kompletnego zestawu losowych przykładów Układanki Dwudziestu Czterech, znanej wersji układanki z przesuwanymi kafelkami w wersji 5 x 5. Nasz nowy wkład w rozwiązanie tego problemu to silniejsza dopuszczalna funkcja heurystyczna.

…

[Obserwujemy], że wraz z powiększaniem się problemów wyszukiwania heurystycznego, więcej potężnych funkcji heurystycznych staje się niezbędnych i opłacalnych."

Obszar wyszukiwania dla układanki 5 x 5 jest około biliona razy większy niż dla układanki 4 x 4. Ma około 7,756 x 1024 węzłów. Wyszukiwanie jest również łatwiejsze, jeśli można zadowolić się "dobrymi" lub przybliżonymi rozwiązaniami problemów zamiast nalegać na "najlepsze" rozwiązania. W następnym rozdziale opiszę kilka dość znaczących postępów w radzeniu sobie z dużymi problemami wyszukiwania; postęp ten nieco przyspieszył. Jednak nawet przy tych sposobach rozwiązywania złożoności ludzie AI zaczęli dostrzegać inne niedociągnięcia

Potwierdzone niedociągnięcia

Kiedy badacze AI zaczęli stawiać czoła problemom o znaczeniu praktycznym, sami musieli przyznać się do kilku trudności. Pojawiły się w kilku obszarach zastosowania. Wspomnę tylko o kilku. Na przykład, próbując udowodnić nietrywialne twierdzenia matematyczne, programy dowodzące twierdzeń szybko wyczerpały przestrzeń niezbędną do przechowywania wyników pośrednich. Ale ludzie (przynajmniej niektórzy ludzie) są w stanie udowodnić te twierdzenia. Jakie metody wykorzystują te programy komputerowe? Matematycy prawdopodobnie powiedzieliby, że intuicja, osąd, doświadczenie, matematyczne wyrafinowanie i takie są kluczowe dla ich sukcesów. Jak dotąd dostarczenie komputerom takich możliwości okazało się trudne. W grze, chociaż MAC HACK VI i CHESS 4.6, by wymienić dwa przykłady, grały całkiem niezłe szachy, daleko im było do pokonania mistrzów świata. W rzeczywistości w sierpniu 1978 r. na kanadyjskiej wystawie krajowej w Toronto David Levy pokonał aktualnego mistrza szachów komputerowych CHESS 4.7 z Northwestern University, wygrywając w ten sposób zakład lata wcześniej przeciwko Johnowi McCarthy′emu i Donaldowi Michie. Jak ujął to Levy: "Udało mi się pokonać program dość przekonująco, przez trzy wygrane do jednego z jedną remisową grą (szósta gra nie musiała zostać rozegrana) i tym meczem wygrałem zakład". Co odpowiada zdolności mistrzowskiej? Jest mało prawdopodobne, aby mistrzowie szachowi oglądali więcej pozycji szachowych niż komputery. Prawdopodobnie jednak patrzą dalej w drzewo gry wzdłuż najważniejszych gałęzi. Wydaje się, że ich doświadczenie pozwala im ocenić potencjał kandydujących pozycji, które są warte eksploracji, i zignorować dalszą eksplorację bezwartościowych pozycji. Być może myślą także bardziej strategicznie niż programy szachowe uwzględniające poszczególne ruchy szachowe. Inną grą, być może bardziej wymagającą dla ludzi niż szachy, jest gra Go - gra planszowa, która powstała w Chinach ponad 4000 lat temu i jest dziś bardzo popularna w krajach azjatyckich. W Go dwaj gracze naprzemiennie umieszczają czarne i białe kamienie na przecięciach siatki 19 x 19 dwóch zestawów linii rządzących na planszy. Nie będę tutaj opisywał zasad gry, z wyjątkiem stwierdzenia, że (przynajmniej na wczesnych etapach gry) gracz stoi przed problemem decydowania, na której z prawie 361 (19 x 19) pozycji umieścić kamień. Nawet w przypadku najpotężniejszych procesów wyszukiwania przeszukiwanie drzewa, którego każdy węzeł ma prawie 361 bezpośrednich potomków, nie wchodzi w rachubę. Ludzcy gracze muszą stosować inne strategie i niezależnie od tych strategii, wciąż są nieznani badaczom AI. Wielu badaczy AI uważa, że wydajność w Go jest lepszą miarą zdolności AI niż jest występ w szachach. Mimo, że systemy eksperckie skutecznie (a nawet z korzyścią ekonomiczną) uzasadniają określone problemy w medycynie, geologii, chemii i innych określonych obszarach, uznaje się je za "kruche" (to znaczy rozpadają się w obliczu problemów poza ich obszarem wiedza specjalistyczna, a nawet problemy w obszarze ich wiedzy specjalistycznej, jeśli potrzebna była wiedza, która nie została zapewniona w ich zasadach. Nie wiedzą, czego nie wiedzą i dlatego mogą udzielić błędnych odpowiedzi w przypadkach, w których ludzki ekspert byłby lepszy. Mówi się, że John McCarthy, w interakcji z lekarskim systemem eksperckim MYCIN, wpisał pewne informacje o hipotetycznym pacjencie, mówiąc, że był mężczyzną, a także, że przeszedł amniopunkcję. MYCIN zaakceptował to wszystko bez reklamacji! To, że pacjenci płci męskiej nie zachodzą w ciążę, nie zostało uznane za część "wiedzy eksperckiej", którą należy podać MYCIN. Jednym z powodów, dla których systemy eksperckie są kruche, jest brak zdrowego rozsądku. Oprócz wiedzy eksperckiej, którą ludzie mogą zdobyć dzięki edukacji i doświadczeniu zawodowemu, mają również dużą wiedzę ogólną. Wiedzą na przykład, że tylko kobiety mogą zajść w ciążę, że parasole chronią przed słońcem i deszczem, migrują niektóre ptaki, że żywność można kupić na rynkach i miliony innych faktów. Benjamin Kuipers, badacz AI i profesor na University of Michigan (wcześniej University of Texas at Austin), w ten sposób określili zdrowy rozsądek:

"Wiedza zdrowa to wiedza o strukturze świata zewnętrznego, którą każdy normalny człowiek pozyskuje i stosuje bez skoncentrowanego wysiłku, co pozwala mu sprostać codziennym wymaganiom środowiska fizycznego, przestrzennego, czasowego i społecznego z rozsądnym powodzeniem ."

Wiedzę ogólną nabywa się stopniowo w miarę dorastania dzieci i dojrzewania dorosłych. Na przykład dziecko prawdopodobnie nie wie, że małe tabletki w małych plastikowych butelkach mogą być niebezpieczne w przypadku połknięcia (dlatego butelki te mają zakrętki zabezpieczające przed dostępem dzieci), nastolatki wiedzą wiele rzeczy, których zwykle ośmiolatki zwykle nie wiedzą, i wiedza, która umożliwia czytelnikowi "New Yorkera", powiedzmy, zrozumienie jego recenzji książek i filmów, wykracza poza to, co zwykle wie nastolatek. Oczywiście ludzie w różnych krajach i kulturach będą mieli inny zdrowy rozsądek. Wydaje mi się, że wiedzę o konkretnym człowieku należy uważać za stale rosnące drzewo, którego podstawa i niższe gałęzie stanowią "zdrowy rozsądek", a górne ramię obejmuje "wiedzę specjalistyczną" wyspecjalizowanych dyscyplin, których dana osoba mogłaby się nauczyć . Metafora drzewa jest również przydatna do podkreślenia, że wiedza w górnych gałęziach wykorzystuje pojęcia występujące w pniu i dolnych gałęziach. Widzieliśmy , że pełne zrozumienie zdań w języku naturalnym wydaje się wymagać zdrowego rozsądku informacji, które ludzie mają, ale komputery wciąż tego nie robią. Przerażająca perspektywa wyposażenia komputerów w zdrowy rozsądek doprowadziła do dwóch zupełnie przeciwnych reakcji. Niektórzy postrzegają ten problem jako wykluczający możliwość AI (lub przynajmniej silnej AI) w dającej się przewidzieć przyszłości. Inni jednak mówią: "Dajmy sobie z tym radę". (Będę mówić o pracy jednego z osób, z którymi się zabieramy w następnym rozdziale). Oczywiście nie ma już należy się spodziewać, że jakikolwiek system sztucznej inteligencji zrozumie wszystkie zdania w języku naturalnym, niż można oczekiwać, że każdy konkretny człowiek zrozumie zdania w języku naturalnym na wszystkie tematy. Ludzie mają swoje ograniczenia, a programy AI też je będą. Perspektywa ta nie powinna już ograniczać nasze próby stworzenia inteligentnych programów, a nie edukacji inteligentnych ludzi.

"Zima AI"

We wczesnych latach osiemdziesiątych wielu sponsorów AI, zarówno w rządzie, jak i przemyśle, nie bardzo spełniło oczekiwania co do tego, co AI może dla nich zrobić. Niewątpliwie część winy za ich nieuzasadniony optymizm można obciążyć samych badaczy AI, którzy byli zmotywowani do przesadnych obietnic. Niepowodzenie w dostarczeniu systemów pasujących do tych nierealistycznych nadziei, wraz z kumulującym się krytycznym komentarzem, o którym już wspomniałem, połączyło się w połowie lat 80. pod koniec lat 80. XX wieku, aby stworzyć coś, co nazwano "zimą AI". Rzeczywiście na krajowej konwencji AAAI w 1984 r. kilku wiodących badaczy AI ostrzegło o tej możliwości podczas sesji panelowej zatytułowanej "Ciemne wieki AI" (Czy możemy ich uniknąć, czy przetrwać?) Przewodniczący panelu, Drew McDermott z Yale University, rozpoczął sesję od powiedzenia. "Pomimo wszystkich komercyjnych zgiełków wokół AI, jestem pewien, że wielu z was zna głęboki niepokój wśród badaczy AI, którzy byli już od ponad czterech ostatnich lat. Niepokój spowodowany jest obawą, że być może oczekiwania dotyczące AI są zbyt wysokie i że ostatecznie doprowadzi to do katastrofy.

… Myślę, że ważne jest, abyśmy podjęli kroki w celu zapewnienia że "Zima AInie dzieje się {poprzez dyscyplinowanie siebie i edukację społeczeństwa".

Ale jeśli miały miejsce "dyscyplina" i "edukacja", były one niewystarczające, aby zapobiec niepokojącemu kryzysowi. Pod koniec lat osiemdziesiątych członkostwo w AAAI stopniowo spadało. Do 1996 r. Osiągnęła poziom od 4000 do 5000 członków. Spadła również reklama w magazynie AI - podobnie jak udział rządu i przemysłu w eksponatach konferencji AI. Kilka firm AI zamknęło drzwi, a badania nad AI w niektórych większych firmach z branży sprzętu komputerowego i oprogramowania zostały zakończone. Według Alexa Rolanda, między 1987 a 1989 rokiem, budżet DARPA na podstawowe badania AI i Strategic Computing spadł z 47 milionów do 31 milionów dolarów. (Mimo to, według Alexa Rolanda, budżet CMU został zwiększony na program rozumienia mowy i program pojazdów autonomicznych w tym czasie). Ale zima trwała tylko przez sezon {sezon nie hibernacji, ale wznowione wysiłki, aby kontynuować. Przebadano kilka nowych pomysłów, a starsze wzmocniono dodanymi mocami