Postęp w widzeniu komputerowym

Od około 1970 r. Badania nad widzeniem komputerowym stały się wysoce rozwiniętą specjalnością sztucznej inteligencji, łącząc inne wyspecjalizowane obszary, takie jak przetwarzanie języka naturalnego, robotyka, reprezentacja wiedzy i rozumowanie (by wymienić tylko kilka z nich). Opiszę niektóre ważne postępy w dziedzinie widzenia komputerowego w tym okresie. Niektóre z nich zostały opracowane z myślą o określonych zastosowaniach w kilku dziedzinach, takich jak rozpoznanie lotnicze, kartografia, robotyka, medycyna, analiza dokumentów i nadzór.

Wyszukiwanie poza linią

Wcześniej opisałem niektóre techniki filtrowania w celu poprawy jakości obrazu oraz wyodrębnienia krawędzi i linii w obrazach. Ale można zrobić znacznie więcej, aby wyodrębnić właściwości sceny przy użyciu konkretnych informacji o warunkach, w jakich obrazy są uzyskiwane, oraz ogólnych informacji o właściwościach obiektów, które mogą znajdować się na scenie.

Kształt z cieniowania

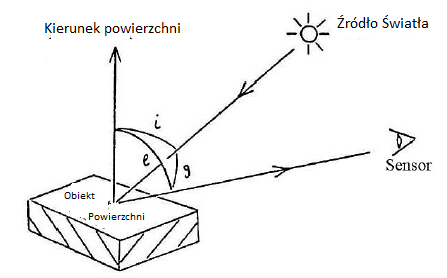

W tak zwanym ruchu "powrót do podstaw" badacze zaczęli badać, w jaki sposób można wykorzystać informacje o fizyce i geometrii odbicia światła od powierzchni do ujawnienia trójwymiarowych właściwości sceny z pojedynczego dwuwymiarowego obrazu. Liderem tego badania był Berthold K. P. Horn . Jego doktorancka rozprawa opracowała matematyczne metody określania kształtu obiektu na podstawie jego cieniowania. Tak jak ludzie postrzegają odpowiednio zacieniowany obraz koła jako kulę, tak można stworzyć komputerowy system wizyjny.Korzystając z informacji o właściwościach odblaskowych powierzchni i geometrii procesu obrazowania, zrobił to Horn. Podstawową ideę techniki Horna można wytłumaczyć, odwołując się do rysunku na którym w najmniejszym kawałku powierzchni światło jest oświetlane źródłem światła pod kątem równym i względem kierunku, który wskazuje prostopadle od powierzchni.

Załóżmy, że czujnik światła (taki jak kamera telewizyjna), pod kątem g względem kierunku źródła światła i pod kątem e względem kierunku powierzchni, zbiera światło odbite od powierzchni. Ilość światła zebranego z tej łatki powierzchniowej zależy od tych trzech kątów, ilości oświetlenia i współczynnika odbicia właściwości powierzchni. (Horn przyjął coś, co nazwalibyśmy "matową" powierzchnią). Ponieważ ilość zebranego światła zmienia się w ten sposób, obraz wydaje się "zacieniony". W pewnych okolicznościach i przy pewnej manipulacji matematycznej kierunek powierzchni można obliczyć, jeśli znane są inne wielkości. Następnie, znając kierunek dla wielu, wielu małych powierzchni, można obliczyć ogólny kształt powierzchni (przy założeniu, że powierzchnia jest względnie gładka bez nagłe nieciągłości). Horn jest obecnie profesorem informatyki i elektrotechniki w MIT i nadal pracuje nad kilkoma tematami związanymi z wizją komputerową. Jego praca dyplomowa wywołała lawinę aktywności w obszarze kształtu z cieniowania. "Kilka osób rozszerzyło pomysł kształtu z cieniowania na próbę obliczenia kształtu na podstawie rzeczy innych niż cieniowanie, na przykład z wielu obrazów (stereo), ruchu, tekstury i kontur. I, jak zobaczymy na następnych kilku stronach, wykonano ważną pracę przy wydobywaniu czegoś więcej niż tylko kształtu obiektów.

Szkic 21/2-D

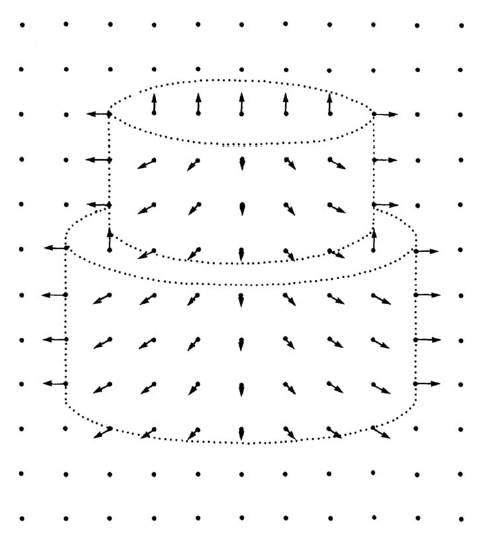

Mimo że widz widzi tylko dwuwymiarowy obraz trójwymiarowej sceny, David Marr zauważył, że mimo to widz jest w stanie wywnioskować (a tym samym postrzegać) na podstawie cieniowania obrazu i innych głębokości trójwymiarowe atrybuty sceny, takie jak kształty powierzchni, kształty zamykające inne kształty, nagłe zmiany między gładkimi powierzchniami i inne informacje o głębokości. Marr nazwał przedstawienie tych atrybutów "szkicem 2 1/2-D" (ponieważ nie był w pełni trójwymiarowy). Zgodnie z teorią widzenia Marra (opisaną w jego książce), następnym krokiem przetwarzania wizualnego, po stworzeniu pierwotnego szkicu plam i krawędzi, jest wykonanie tego szkicu 2 1/2-D. Przykładowy szkic pokazano na rysunku na którym strzałki skierowane prostopadle od powierzchni są nakładane na pierwotny szkic obrazu, z którego są wywnioskowane.

Wreszcie, według Marra, informacje ze szkicu 2 1/2-D, wraz z przechowywanymi informacjami o kształtach obiektów, zostaną wykorzystane do zlokalizowania określonych obiektów na obrazie, a tym samym do stworzenia trójwymiarowego modelu sceny. Niedługo opiszę, co miał do powiedzenia na temat tego procesu.

Obrazy wewnętrzne

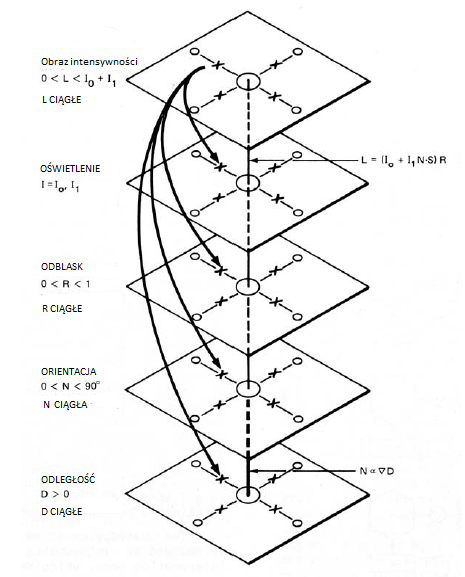

Dwóch naukowców z SRI, Jay Martin Tenenbaum i Harry Barrow (niedawno przeprowadzony z Edynburga), opracowali niektóre techniki przetwarzania obrazu całkiem podobne do tych, które zastosowano przy tworzeniu szkicu 2 1/2-D. Zauważyli, że wartość intensywności na każdym pikselu obrazu wynikała z splątanej kombinacji kilku czynników, w tym właściwości oświetlenia otoczenia oraz właściwości odblaskowych i geometrycznych obiektów na scenie. Uważali, że czynniki te można rozplątać, aby odzyskać ważne trójwymiarowe informacje o scenie. Barrow i Tenenbaum zaproponowali, aby każdy z tych czynników (z których wszystkie w intensywności zależnej) był reprezentowany przez wyimaginowane obrazy, które nazywali "obrazami wewnętrznymi". Obrazy te miały składać się z siatki "pikseli" nakładających się na rzut sceny i zarejestrowanych na obrazie o intensywności. Jednym z wewnętrznych obrazów był na przykład obraz iluminacyjny. Składał się z pikseli, których wartości stanowiły iluminacje padające na piksele wyświetlanej sceny. Wartości te oczywiście nie były znane, ale Barrow i Tenenbaum zaproponowali, że można je oszacować na podstawie obrazu intensywności i na podstawie innych wewnętrznych obrazów. Jako przykłady pokazuję zestaw takich wewnętrznych obrazów poniżej

Rzeczywisty obraz wartości intensywności pokazano na górze. Znana wartość piksela na tym obrazie zależy od nieznanych wartości pikseli na wewnętrznych obrazach poniżej. W rzeczywistości wartości pikseli na wszystkich obrazach, wewnętrzne i rzeczywiste, są od siebie zależne. Strzałki w górę odzwierciedlają ten fakt. (Powinny również pojawić się strzałki w górę.) W oparciu o wartości pikseli na niektórych obrazach, wartości innych można obliczyć przy użyciu znanych zależności fizycznych, ograniczeń między obrazami i innych rozsądnych założeń. Te wartości z kolei pozwalają na obliczenia innych. Dlatego te obliczenia "propagują" wartości pikseli w całym zestawie obrazów wewnętrznych (podobnie jak wpływ poziomów w architekturze tablicy na inne poziomy). Jak później Barrow i Tenenbaum podsumowali swoją metodę: "Przewidywaliśmy ten proces odzyskiwania jako zestaw oddziałujących równoległych obliczeń lokalnych, bardziej jak rozwiązanie układu równań równoczesnych przez relaksację niż jak sekwencję etapów przekazywania danych". Barrow i Tenenbaum wykorzystali również niektóre ze swoich pomysłów na temat obrazów wewnętrznych, aby rozwiązać problem interpretacji rysunków linii jako powierzchni trójwymiarowych. Barrow i Tenenbaum zamierzali, aby ich praca była przydatna nie tylko w widzeniu komputerowym, ale także jako potencjalny model procesów "przedogniskowego" widzenia u ludzi. Jednak w "retrospektywie" z 1993 r. Na temat ich pracy, którą napisali. Pomimo dojrzałości wizji obliczeniowej i szybkiego rozwoju systemów neuronowych, przed nami jeszcze wiele do zrobienia, aby zbliżyć się do celu, jakim jest zrozumienie percepcji wzrokowej. Aby to zrobić, będziemy musieli skorzystać z tego, czego nauczyliśmy się w wielu dziedzinach, w tym neuronauki, sieci neuronowych, psychologii eksperymentalnej i wizji obliczeniowej.

Znajdowanie obiektów w scenach

Rozumowanie scen

Jeszcze przed opracowaniem metod kształtowania z cieniowania i innych metod odzyskiwania informacji o głębokości ze scen wielu badaczy pracowało nad metodami wyszukiwania obiektów w scenach. Na początku lat 70. Thomas Garvey ukończył doktorat Stanforda, jego praca była na temat systemu lokalizacji obiektów, takich jak biurka, krzesła i kosze na śmieci, na zdjęciach scen biurowych. Jak napisał Garvey w swoim streszczeniu:

"System wykorzystuje informacje o wyglądzie obiektów, o ich wzajemnych powiązaniach oraz o dostępnych czujnikach do stworzyć plan lokalizacji określonych obiektów na zdjęciach scen pokoju"

W powiązanych pracach Barrow i Tenenbaum opracowali system o nazwie MSYS, służący do wnioskowania o scenach "w których źródła wiedzy konkurują ze sobą i współpracują, dopóki spójne wyjaśnienie tej sceny nie pojawi się w drodze konsensusu". MSYS przeanalizował obrazy scen biurowych i podjął próbę znalezienia najbardziej prawdopodobnej interpretacji regionów na obrazie (blat biurka, oparcie krzesła, podłoga, drzwi itd.), Biorąc pod uwagę szereg interpretacji kandydatów i ich prawdopodobieństwa. Znając relacje między regionami (takie jak oparcia krzeseł zwykle sąsiadują z siedzeniami krzeseł), MSYS próbował znaleźć najbardziej prawdopodobny ogólny zestaw interpretacji regionów. Niektóre regiony w scenie zostały wykryte i oznaczone możliwymi interpretacjami. Jak napisali Barrow i Tenenbaum, rozumowanie MSYS może przebiegać następująco:

Regiony PIC, WBSKT i CBACK nie mogą mieć WALL albo DOOR,

ponieważ ich jasność jest znacznie mniejsza niż u góry

krawędź obrazu pionowo nad nimi, co narusza [wiedzę

o jasności ścian i drzwi]. W związku z tym region PIC

musi być PICTURE, WBSKTT musi być WASTEBASKET, i

CBACK musi być CHAIRBACK. Region LWALL i RWALL muszą być WALL, ponieważ sąsiadują z regionem PIC, a DRZWI nie mogą przylegać do OBRAZU. Region DR nie może być WALL, ponieważ wszystkie regiony oznaczone WALL muszą mieć tę samą jasność. Dlatego regionem DR musi być DOOR.

Korzystanie z szablonów i modeli

Wiele wczesnych prac nad rozpoznawaniem obiektów opierało się na użyciu "szablonów" obiektów, które można dopasować do obrazów. Martin A. Fischler i Robert A. Elschlager opracowali ten pomysł, wykorzystując "rozciągliwe szablony", które pozwoliły na bardziej zaawansowane techniki dopasowywania. Użyli ich do znalezienia obiektów takich jak twarze lub szczególne cechy terenu na fotografiach zawierających takie obiekty. Proces zależał od ogólnej prezentacji poszukiwanego obiektu, a następnie proces dopasowania tej reprezentacji do fotografii. Ich reprezentacje polegały na rozbiciu obiektu na kilka prymitywnych części i określeniu dopuszczalnego zakresu relacji przestrzennych, które te "prymitywne części" muszą spełnić, aby obiekt był obecny. Aby obiekt był obecny na zdjęciu, "wymagane jest, aby prymitywy wystąpiły (lub przynajmniej wystąpił jakiś znaczny ich podzbiór), a także aby występowały w ramach określonej relacji przestrzennej …" .Jak zauważyli Fischler i Elschlager, zwykle zdarza się, że ustalenie, czy niektóre części występują, zależy od tego, czy cały obiekt występuje, i odwrotnie. Głównym wkładem ich pracy było opracowanie dynamicznej programistyczna metoda radzenia sobie z tą cyrkulacją.

Wcześniej opisałem pracę Davida Marra nad procesami tworzenia pierwotnego szkicu i szkicu 2 1/2-D. Były to pierwsze dwa etapy teorii widzenia Marra. Twierdził, że etapy te mogą odkryć ważne informacje o kształcie bez szczególnej wiedzy o kształtach obiektów, które mogą znajdować się na scenie. Napisał:

"Większość wczesnych procesów wizualnych bezpośrednio wyodrębnia informacje o widocznych powierzchniach, nie zwracając szczególnej uwagi na to, czy są one częścią konia, człowieka czy drzewa. . . . Jeśli chodzi o pytanie, jaką dodatkową wiedzę należy zastosować, wiedza ogólna musi być wystarczająca {wiedza ogólna osadzona we wczesnych procesach wizualnych jako ogólne ograniczenia, wraz z geometrycznymi konsekwencjami faktu, że powierzchnie współistnieją w trójwymiarowym przestrzeń."

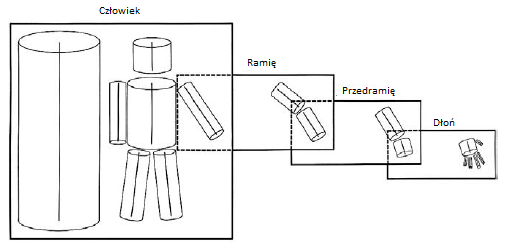

Twierdził, że szczególna wiedza na temat kształtów powinna być wykorzystana w trzecim etapie. Na tym etapie wykorzystuje się trójwymiarowe modele obiektów. Zaproponował zastosowanie hierarchii modeli, w których model brutto jest rozkładany na podsekcje, a te na podelementy i tak dalej. Na przykład kształt człowieka można wymodelować jak poniżej

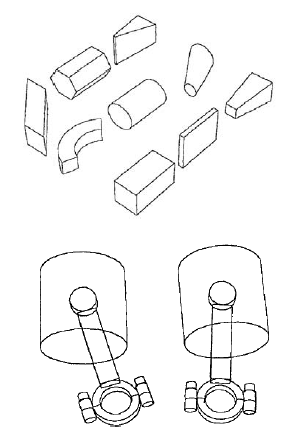

Każde pudełko odpowiada modelowi 3D i jego podmodelowi. Po lewej stronie pudełka znajduje się model zorientowany na oś; po prawej stronie pokazano, jak ten model jest przedstawiany jako podmodele. (Kierunki osi można dopasować do t pasujących części obrazu.) W tym trzecim etapie porównanie modeli tego rodzaju z informacjami o kształcie i innymi informacjami trójwymiarowymi zawartymi w szkicu 2 1/2-D pomaga zidentyfikować i zlokalizować obiekty w scenie. Dla Marra wizja była "procesem odkrywania z obrazów tego, co jest obecne na świecie i gdzie ono jest". Marr nie był pierwszym, który zaproponował użycie walców jako modeli części obiektów. W dokumencie konferencyjnym IEEE z 1971 r. Thomas O. Binford przedstawił ideę "uogólnionych cylindrów" (czasami nazywanych "uogólnionymi stożkami"). W późniejszym artykule zdefiniowano je w następujący sposób: "Uogólniony stożek jest określony przez płaski przekrój, kręgosłup krzywej przestrzennej i zasadę zamiatania. Reprezentuje objętość zmiecioną przez przekrój [niekoniecznie okrągły] jak jest tłumaczony wzdłuż [osi zwanej kręgosłupem], utrzymywany pod pewnym stałym kątem do kręgosłupa i przekształcany zgodnie z zasadą zamiatania. " Binford miał kilka doktorów Stanforda, którzy używali modeli, aby pomóc w identyfikacji obiektów w scenach. Spośród nich mógłbym wymienić Geralda J. Agina, Ramakanta Nevatię i Rodneya A. Brooksa, z których wszyscy przyczynili się do tak zwanego widzenia, opartego na modelu rodzaju obiektów. ACRONYM zastosował te modele, aby pomóc w identyfikacji i lokowaniu obiektów na obrazach. Niektóre przykłady rodzajów uogólnionych stożków, które można wykorzystać jako elementy konstrukcyjne modeli i obiektów modelu, pokazano tu:

Inne poglądy na temat tego, na czym polega wizja, konkurują z tymi Marra i innych, którzy próbowali wykorzystać widzenie do rekonstrukcji całych scen. Niektórzy, szczególnie ci, którzy zajmowali się robotyką, twierdzili, że celem widzenia było dostrzeżenie tego, co jest potrzebne do kierowania działaniem. Wiele procedur widzenia w Shakey zostało wbudowanych w jego programy akcji. Profesor Yiannis Aloimonos z University of Maryland jest jednym z badaczy opowiadających się za "celowym" lub "interaktywnym" podejściem. Twierdzi, że celem widzenia jest działanie. Kiedy widzenie jest "rozpatrywane w połączeniu z działaniem, staje się łatwiejsze". Wyjaśnia, że opisy czasoprzestrzeni, których potrzebuje system, nie mają ogólnego przeznaczenia, ale są celowe. Oznacza to, że te opisy są dobre dla ograniczonych zestawów zadań, takich jak zadania związane z nawigacją, manipulacją i rozpoznawaniem. "W społeczności neuronaukowej, do której Marr chciał się przyczynić, byli Patricia S. Churchland, VS Ramachandran i Terrence J. Sejnowski, który później napisał "Po co jest widzemnie? Czy idealna wewnętrzna rekonstrukcja trójwymiarowego świata jest naprawdę konieczna?" Biologiczne i obliczeniowe odpowiedzi na te pytania prowadzą do koncepcji widzenia zupełnie innej niż wizja czysta [zalecana przez Marr]. Interaktywne widzenie… obejmuje widzenie z innymi układami sensorycznymi jako partnerami w pomaganiu w kierowaniu działaniami ". W każdym razie modele nadal odgrywają ważną rolę w wizji komputerowej. (Jednak jeden wybitny badacz wizji powiedział , że "pozostałość widzenia opartego na modelu jest bliska zeru", a inny powiedział , że "najbardziej aktualne systemy robotyczne używają hacków wizyjnych "zamiast ogólnych, opartych na nauce metod analizy scen.)

Program zrozumienia obrazu DARPA

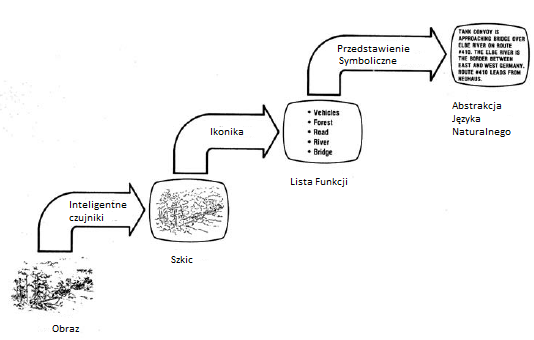

Znaczna część prac związanych z widzeniem komputerowym w Stanach Zjednoczonych była finansowana przez DARPA, a badacze widzenia mieli (jak zawsze) obawy dotyczące dalszego wsparcia. Tenenbaum przypomina, że uczestniczył w spotkaniu DARPA w 1974 r., podczas którego omawiano przyszłość badań nad widzeniem komputerowym. Oficer programu monitorujący prace wzrokowe wspierane przez DARPA, major lotnictwa David L. Carlstrom, był na spotkaniu i był zainteresowany połączeniem różnych wysiłków w tej dziedzinie. Ponieważ DARPA od kilku lat wspiera prace w tej dziedzinie, Carlstrom potrzebował nowej nazwy, która wskazywałaby, że DARPA zaczyna coś nowego. Tenenbaum powiedział, że on zalecił Carlstromowi , aby nową inicjatywę nazwać "programem do rozpoznawania obrazów". (Przypomnijmy, że trwały już prace nad zrozumieniem mowy wspierane przez DARPA, więc fraza brzmiała "przyjazny dla DARPA"). W 1976 roku DARPA uruchomiła program Image Understanding (IU). Stało się to dużym wysiłkiem złożonym z wiodących laboratoriów badawczych wykonujących prace w tym obszarze, a także "zespołów" łączących uniwersytet z firmą. Poszczególne laboratoria uczestniczyły w MIT, Stanford, University of Rochester, SRI i Honeywell. Zespołami uniwersytetów / przemysłu były USC-Hughes Research Laboratories, University of Maryland-Westinghouse, Inc., Purdue University {Honeywell, Inc., i CMU {Control Data Corporation. Odbywały się regularne warsztaty w celu przedstawienia postępów. Postępowanie jednego z nich odbyło się w kwietniu 1977 r. i określiło cele programu: "Program zrozumienia obrazu jest zaplanowany na pięć lat badań w celu opracowania technologii wymaganej do automatycznej i półautomatycznej interpretacji i analizy zdjęć wojskowych i powiązanych obrazów" . Ostateczny cel DARPA dla programu IU został dobrze ujęty w ilustracji na okładce tego postępowania, pokazanej na rysunku

Jak pokazuje schemat, dowódcy wojskowi chcieliby, aby komputerowe systemy wizyjne mogły analizować fotografię i sporządzić pisemny opis jej ważnych elementów i ich relacji. Niektóre z badań wizji komputerowej, które już opisałem, takie jak praca nad szkicem 2 1/2-D, obrazy wewnętrzne, uogólnione cylindry i ACRONYM, były wspierane przez program IU. Ale zawsze istniało pewne napięcie między celami DARPA a celami osób prowadzących badania nad wizją komputerową. DARPA chciał, aby program produkował systemy "polowe". J. C. R. Licklider podkreślił ten punkt na wstępnych warsztatach IU w marcu 1975 r .:

Pod koniec pięcioletniego okresu opracowana technologia musi być w stanie, w którym elementy DoD mogą ją wykorzystać aby rozwiązać ich specyficzne problemy, nie wymagając znacznego wysiłku badawczego, aby dowiedzieć się, jak zastosować technologię do konkretnych problemów. Z tego powodu pod koniec pięcioletniego okresu program musi wykazać, że ważny problem DoD został rozwiązany.

Major lotnictwa Larry Druffel z DARPA objął kierownictwo programu IU w 1978 r. W listopadzie 1978 r. doradził: "Ostrożnym podejściem jest konsolidacja technik, które są wystarczająco dojrzałe, aby przenieść się do agencji DoD". Do 1979 r. cele programu rozszerzyły się o kartografię i mapowanie. "Memorandum of zrozumienia" (MOU) między DARPA a Agencją Definiowania Obrony (DMA) zostało zawarte w celu wsparcia wysiłków w zakresie automatycznego mapowania poprzez opracowanie DARPA / DMA . W listopadzie 1979 r. Druffel napisał :

"Trwają prace nad planem systemu demonstracyjnego w celu oceny dojrzałości technologii IU poprzez automatyzację funkcji mapowania, mapowania i geodezji. Koncentrując się na konkretnej funkcje fotointerpretacji kartografii , system powinien oferować całość społeczność wykorzystująca obrazy możliwość oceny przyszłości zastosowanie metodologii zrozumienia obrazu do ich specyfiki problemu"

Program "pięcioletni" nie zakończył się w 1981 r. Kontynuowano go pod kierownictwem dowódcy marynarki wojennej DARPA Rona Ohlandera, pułkownika sił powietrznych Roberta L. Simpsona Jr. i innych do około 2001 r. W 1985 r. Simpson podsumował niektóre z jego osiągnięć

"Początkowo pomyślany jako program pięcioletni w 1975 r. przez ppłk. Davida Carlstroma, pierwsze kilka lat IU stworzyło silną bazę technik widzenia na niskim poziomie i podsystemów opartych na wiedzy, które zaczęły odróżniać widzenie komputerowe od tego, co zwykle nazywa się " przetwarzanie obrazu." Na przełomie lat siedemdziesiątych i osiemdziesiątych XX wieku, pod kierunkiem ppłk. Larry′ego Druffela, program widział rozwój systemów wizyjnych opartych na modelach, takich jak ACRONYM, oraz demonstrację technik IU w bardziej znaczących demonstracjach koncepcyjnych, takich jak obraz DARPA / DMA zrozumienie testbed. Te demonstracje i ich potencjał do przyszłego użytku wojskowego uzasadniały kontynuację programu IU poza początkową pięcioletnią żywotność. Pod Cmd. Ron Ohlander, technologia IU nadal dojrzewała do tego stopnia, że program komputerowy DARPA mógł uzasadnić duże zastosowanie, autonomiczny pojazd lądowy."

Jak powiedział Ohlander, program IU został przedłużony poza przewidywany okres pięciu lat. Mówi się, że już w 1984 r. DARPA wydała na ten wysiłek ponad 4 miliony dolarów. Jednym z potencjalnych zastosowań była wizja komputerowa sterowanych robotami pojazdów wojskowych {element strategii DARPA Computing ". Jako rosnąca specjalność sztucznej inteligencji, artykuły o widzeniu komputerowym, zaczęły pojawiać się w nowych czasopismach poświęconych temu zagadnieniu, w tym Computer Vision and Image Understanding oraz IEEE Transakcje dotyczące analizy wzorców i inteligencji maszyn W tym czasie podręczniki Fielda zawierały klasyfikację wzorców i analizę scen oraz dwie książki zatytułowane Computer Vision.