Badanie "ręka-oko"

Motywacją do wielu badań w zakresie widzenia komputerowego, było dostarczenie informacji do prowadzenia ramienia robota. Ponieważ obrazy, które można było najlepiej przeanalizować, dotyczyły prostych obiektów, takich jak bloki zabawek, prace koncentrowały się na ustawieniu ramienia robota w stos i rozpakowaniu bloków. Opiszę kilka typowych przykładów tych badań "hand-eye", zaczynając od projektu, który tak naprawdę nie obejmował "oka ".

W MIT

Sterowana komputerowo mechaniczna "ręka" została opracowana przez Heinricha A. Ernsta w 1961 r. W ramach jego Electrical Engineering Sc.D. praca w MIT. (Jego doradcą był Claude Shannon.) Ręka o nazwie MH-1 była "mechanicznym serwomanipulatorem [American Machine and Foundry] przystosowanym do pracy przez komputer TX-0". Wykorzystał czujniki dotykowe zamontowane na ręce, aby go poprowadzić, ponieważ, jak napisał Ernst, narządy wzroku są obecnie zbyt trudne do zbudowania. W streszczeniu tezy Ernsta opisano niektóre z możliwości systemu:

"…program składający się z dziewięciu instrukcji sprawi, że ręka wykona następujące czynności: Przeszukaj stół w poszukiwaniu pola, zapamiętaj jej pozycję, wyszukaj bloków na stole , weź je i umieść w tej ramce. Położenie obiektów nie ma znaczenia, dopóki są na stole. Jeśli w ramach testu wbudowanej inteligencji mechanicznej pudełko powinno zostać zabrane i umieszczone gdzie indziej, podczas gdy ręka szuka bloków, MH-1 zapamięta nową pozycję pudełka i kontynuuje pracę z nim, gdy tylko zdał sobie sprawę ze zmiany sytuacji, to znaczy wpadł na pudełko, szukając bloków. Odbędzie się to automatycznie, bez potrzeby wspominania o tym w specjalnym programie dla tej wydajności blokowej"

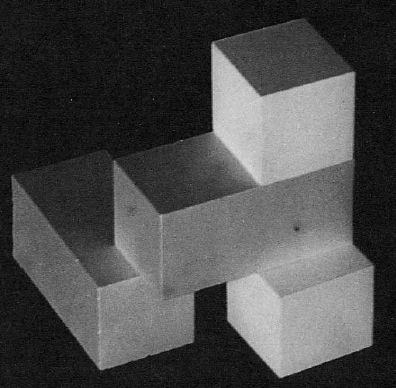

W rzeczywistości MH-1 nie była pierwszą ręką sterowaną komputerowo, chociaż pierwszy wykorzystał czujniki dotykowe do kierowania ruchem. Jeden został opracowany i opatentowany w 1954 roku przez amerykańskiego inżyniera George′a Devola. Opierając się na tym wynalazku, on i inny inżynier, Joseph F. Engelberger, założyli Unimation, Inc. Wkrótce potem zainstalowali prototyp swojego pierwszego robota przemysłowego o nazwie "Unimate" w fabryce General Motors Corporation Ternstedt Division niedaleko Trenton, New Jersey. Wracając do MIT, studenci Patrick Winston (później profesor MIT i dyrektor AI Laboratory), Thomas O. Binford (później profesor Stanford), Berthold KP Horn (później profesor MIT) i Eugene Freuder (później profesor University of New Hampshire) system wykorzystujący ramię robota AMF Versatran do "kopiowania" konfiguracji bloków. Scena składająca się z bloków została zeskanowana w pierwszej kolejności, a linie zostały wyodrębnione z obrazu za pomocą "linijki", która była opracowywana przez Binforda i Horn. Za pomocą tych linii zidentyfikowano obiekty na obrazie i wykonano plan rozłożenia bloków robota na scenie przez ramię robota. Ramię robota wykonało następnie ten plan i ponownie złożyło bloki w ich oryginalnej konfiguracji. System został zademonstrowany w grudniu 1970 r. Dla różnych konfiguracji bloków. Przykładowa konfiguracja bloków, którą pomyślnie obsłużyła ich "kopia demo", pokazano na rysunku

System polegał na precyzyjnym oświetleniu i starannie skonstruowanych blokach. Próby rozszerzenia zakresu widzenia komputerowego na mniej ograniczone sceny doprowadziły do dalszej koncentracji w MIT i innych miejscach na wczesnych etapach przetwarzania obrazu. Bardziej szczegółowo opiszę niektóre z późniejszych prac nad tymi problemami

W Stanford

Tymczasem w SAIL Johna McCarthy′ego zespół kierowany przez profesora Jerome Feldmana kontynuował prace nad projektami ręcznymi przy użyciu PDP-1, a później komputerów PDP-6 i PDP-10.4 McCarthy później powiedział mi, że się zainteresował w robotach ze względu na jego zainteresowanie wizją komputerową. Nie był bardzo podekscytowany pracą w rozpoznawaniu wzorów (była to raczej "dyskryminacja" niż "opis"). "Jeśli chcesz coś podnieść, musisz to opisać, a nie tylko rozpoznać". W 1966 r. SAIL nabył elektromechaniczne ramię protetyczne Rancho Los Amigos Hospital. Wiosną 1967 r. Karl Pingle, Jonathan Singer i Bill Wichman opracowali system dłoni i oczu, który mógł używać kamery telewizyjnej i prymitywnych procedur wizyjnych do lokalizowania bloków rozrzuconych na stole. Korzystając z uzyskanych w ten sposób informacji, może kontrolować ramię w celu sortowania bloków. Według autorów, jedna sekcja systemu skanuje obraz telewizyjny w celu znalezienia zewnętrznej krawędzi obiektu, a następnie śledzi zewnętrzne krawędzie obiektu za pomocą operatora gradientu [wykrywacza krawędzi] w celu znalezienia położenia i kierunku krawędzi. Procedury dopasowywania krzywych dopasowują linie proste do listy punktów znajdujących się na krawędziach i obliczają położenie narożników…Druga sekcja systemu jest poświęcona kontroli ramienia.… Sekcje, które ją kontrolują, składają się z programu rozwiązania, który oblicza pozycję kątową wymaganą dla każdego siłownika oraz programu serwo, który napędza ramię do pożądanych pozycji…

Les Earnest napisał, że był to pierwszy wizualny system sprzężenia zwrotnego z robotyki, "chociaż" zaobserwowano tylko zewnętrzne krawędzie bloków, [i] ręka musiała zostać usunięta z pola widzenia po zakończeniu kontroli wzrokowej…" .Zademonstrowano kilka wersji tego systemu sortowania i układania bloków. W jednym system umieścił kolorowe bloki na stole i umieścił je w osobnych stosach bloków czerwonych i niebieskich. W 1971 roku system układania bloków sterowany wizją rozwiązał ten problem "szaleństwa". W tej układance cztery kostki, z których każda ściana ma jeden z czterech różnych kolorów, muszą być ułożone w wieży tak, aby każda strona wieży miała cztery różne kolory. System działający na komputerze SAIL PDP-10 , użył kamery telewizyjnej wyposażonej w wieżę z czterema soczewkami i kołem kolorów, aby zlokalizować cztery kostki na blacie stołu. Ramię podniosło i obróciło każdą kostkę, aby odsłonić wszystkie twarze przed kamerą. Następnie, znając kolor każdej twarzy i po znalezieniu rozwiązania układanki ramię ułożyło kostki w wieży przedstawiającej rozwiązanie. [Cichy, 16-minutowy kolorowy sześciominutowy lm, zatytułowany "Natychmiastowe Szaleństwo", stworzone przez Richarda Paula i Karla Pingle′a w sierpniu 1971 r. I pokazane na drugiej Międzynarodowej Wspólnej Konferencji na temat Sztucznej Inteligencji (IJCAI) w Londynie.

Dabblal Rajagopal \ Raj "Reddy" był pierwszym doktorantem nowego Wydziału Informatyki Stanforda. Jego praca dyplomowa dotyczyła rozpoznawania mowy. Po uzyskaniu stopnia doktora w 1966 r. Reddy dołączył na Wydział Stanforda i kontynuował badania nad rozpoznawaniem mowy w SAIL. W tym czasie brał udział w projekcie sterowania układem oka za pomocą poleceń głosowych. Jak stwierdzono w przeglądzie projektu, "Polecenia są tak skomplikowane jak:" Podnieś mały blok w dolnej części lewego rogu"są rozpoznawane, a zadania są wykonywane przez ramię sterowane komputerowo." (System został zademonstrowany w 15-minutowym, 16-minutowym kolorze z dźwiękiem 19 mm z 1969 r., pokazującym niektóre wyniki Reddy&primelgo dotyczące rozpoznawania mowy. Jest zatytułowany "Posłuchaj", a wyprodukowali go Raj Reddy, Dave Espar i Art Eisensen. W 1969 r. Reddy przeprowadził się do CMU, gdzie prowadził badania w mowie uznanie, a później został dziekanem CMU's School of Computer Science .We wczesnych latach siedemdziesiątych zespół Stanforda użył systemu wizyjnego i nowej elektromechanicznej ręki zaprojektowanej przez studenta inżynierii mechanicznej, Vica Scheinmana, do montażu wyścigowej pompy wodnej Ford "T". Zastosowano zestaw w stylu przemysłowym z narzędziami w ustalonych miejscach, śrubami w podajniku oraz korpusem pompy i pokrywą na palecie. System dłoni {wykonał obliczony wcześniej złożony zestaw kroków: zlokalizuj podstawę pompy, ustaw ją w pozycji standardowej, określ położenie chwytania za pomocą dotyku, ustaw podstawę pompy w pozycji standardowej, włóż dwa kołki do prowadnicy wyrównanie uszczelki i pokrywy, załóż uszczelkę, wizualnie sprawdź położenie uszczelki, zlokalizuj pokrywę dotykiem, załóż pokrywę na kołki prowadzące, podnieś śrubokręt z łbem sześciokątnym, wybierz śrubę z podajnik, wkręć pierwsze dwie śruby, wyjmij kołki ustalające, wkręć cztery ostatnie śruby i sprawdź siłę wymaganą do obracania wirnika.

W Japonii

Prace ręczne były również prowadzone w centralnym badaniu Hitachi Laboratorium w Tokio. Tam Masakazu Ejiri i współpracownicy opracowali system robota o nazwie HIVIP składający się z trzech podsystemów: EYE, BRAIN i HAND. Jedna z dwóch kamer telewizyjnych EYE spojrzała na rysunek przedstawiający zespół bloków. Drugi aparat spojrzał na kilka bloków na stole. Następnie BRAIN nauczył się, jak podnosić i montować bloki, jak określono na rysunku, a HAND wykonał montaż.

"FREDDY" z Edynburga

Na przełomie lat 60. i 70. XX wieku badacze pod kierunkiem profesora Donalda Michie z Wydziału Inteligencji i Percepcji Maszyn na Uniwersytecie w Edynburgu opracowali systemy robotów zwane ogólnie "FREDDY". Najbardziej znanym z nich był system dłoni - system oczu FREDDY II, który miał duże ramię robota i dwie kamery telewizyjne zawieszone nad ruchomym stołem. Mimo że ramię nie poruszało się względem pokoju, poruszało się względem "świata" stołu. Zadaniem demonstracyjnym gry FREDDY II było zbudowanie kompletnych zestawów takich jak samochodzik lub łódź, z zestawu części zrzuconych na stół. Celem było opracowanie technik sztucznej inteligencji, które mogłyby stanowić podstawę dla lepszych robotów do montażu przemysłowego, tj. robotów, które były bardziej wszechstronne, bardziej niezawodne i łatwiejsze do zaprogramowania niż te, które były w tym czasie używane. Na początku części składowe znajdowały się w niezorganizowanym zbieraniu. FREDDY musiał je znaleźć i zidentyfikować, a następnie uporządkować. Po znalezieniu wszystkich potrzebnych części FREDDY może następnie wykonać sekwencję montażu, używając małej stacji roboczej z imadłem. Wyizolowane części zostały rozpoznane na podstawie cech ich obrysu (narożniki, krzywe itp.), ich otwory i ich ogólne właściwości. Nauczono ich FREDDY, pokazując różne widoki każdej z części na wcześniejszym etapie szkolenia. Aby poradzić sobie ze stertami części, FREDDY zastosował kilka taktyk: może spróbować znaleźć coś wystającego ze stosu, które mógłby uchwycić i wyciągnąć; może próbować podnieść coś (nieznanego) z góry; lub może po prostu przeorać rękę przez stertę, aby spróbować podzielić ją na dwie mniejsze. Konstruowanie zestawu przeprowadzono zgodnie z sekwencją instrukcji, które zostały zaprogramowane interaktywnie podczas fazy szkolenia. Niektóre instrukcje były prostymi ruchami, ale inne były znacznie bardziej wyrafinowane i korzystały z czujników siły w dłoni. Na przykład, w "ograniczonym ruchu" ręka przesuwałaby część, którą trzymała wzdłuż powierzchni, aż uderzy w opór; w "dopasowaniu otworów", ręka wsuwałaby jedną część (np. oś) w otwór w innej (np. koło) przez dotyk, tak jak ludzie. FREDDY mógł zmontować zarówno samochód, jak i łódź, gdy oba zestawy były zmieszane razem i zrzucone na stół. Zajęło to około czterech godzin, głównie z powodu ograniczonej mocy dwóch komputerów FREDDY. Głównym komputerem był Elliot 4130 z 64k 24-bitowymi słowami (później uaktualniony do 128k) i z taktowanie 0,5 MHz Zostało zaprogramowane w języku POP-2. Silniki i kamery robotów były kontrolowane przez Honeywell H316, z 4k 16-bitowymi słowami (później zaktualizowane do 8k słów, kosztem około 8000 $ za dodatkowe 8k bajtów!). Harry Barrow (1943 {), kluczowa osoba zaangażowana w pracę, później opisał działanie FREDDY:

"[A] uzyskanie obrazu z kamery telewizyjnej zajęło kilka sekund a przetwarzanie trwało jeszcze dłużej, i w jednym przebiegu FREDDY wykonał od 100 do 150 zdjęć! Robił zdjęcie za każdym razem, gdy podnosił obiekt, aby sprawdzić, czy z powodzeniem go podniósł i nie upuścił, i robił zdjęcie za każdym razem, gdy kładł obiekt, aby sprawdzić, czy przestrzeń jest pusta. Przeanalizował także cały świat, który wymagał wielu zdjęć) kilka razy, aby zrobić mapę, i spojrzał na każdy obiekt z dwóch różnych kamer, aby dokonać oszacowania pozycji i wielkości w stylu stereo. W rzeczywistości system najintensywniej wykorzystywał dane obrazu z dowolnego systemu robotów na świecie. Systemy Stanford i MIT wykonały tylko niewielką liczbę zdjęć, aby wykonać swoje zadania, i polegały w dużej mierze na martwych rachunkach i na niepowodzeniach. Z drugiej strony założyliśmy, że coś może pójść nie tak (przedmioty upuszczone, toczyły się itp.) I sprawiliśmy, że nasz system jest bardzo niezawodny. Naprawdę wierzę, że pod wieloma względami był to prawdopodobnie najbardziej zaawansowany system oczu w tym czasie"

FREDDY jest teraz na stałej wystawie w Royal Scottish Museum w Edynburgu, z ciągłym filmem o FREDDY składającym mieszane modele samochodów i zestawów łodzi. Badania rąk w Edynburgu zostały zawieszone w połowie lat siedemdziesiątych, częściowo ze względu na niekorzystną ocenę jego perspektyw w badaniu zleconym przez British Science Research Council.